本日の日記 - 今月の(映像クリエーター向け)動画生成AIの講座/動画生成AIはなぜスローモーションばかり生成するのか?/Diary 2024/09/09 - 11

関係者向けのお知らせ投稿だったのが、いつの間にか「本日の日記」に変わってしまったので、このまま続行。

Ce journal est une sorte de mémo sur les activités quotidiennes du projet Generative AI.

この日記は「自分用のメモ」であり、SNSの代替

ライブ配信がある日は更新されない

PCを使っていると「ですます調」、スマホで書いていると「である調」になりやすい

9月8日(日)夜

ネットが繋がりにくい場所なので、移動中。

圏外地域?かもしれない。

本日予定していたライブ配信は無理そう...

やはり、Starlinkが必要か。

8日(日)深夜12時

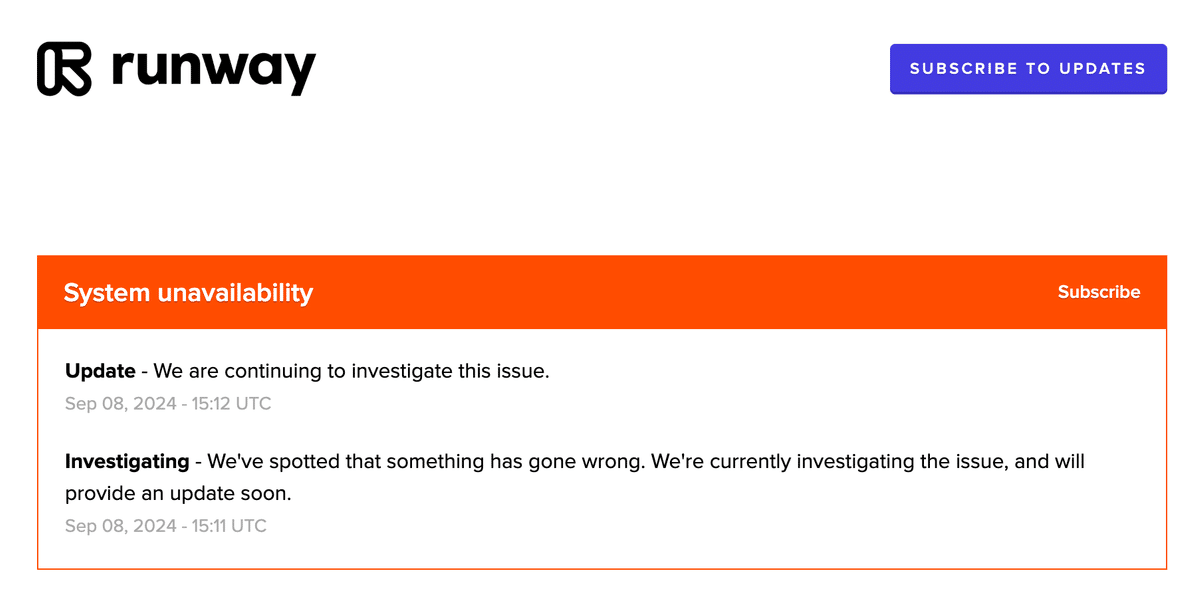

ネットが不安定だから生成エラーが出ると思ったら、Runwayの障害だった。

毎週のことなので、のんびり待つのみ(復旧は早い)。

1時間くらいで復旧。

特に影響なし。

生成エラーが多い場合は、Runway Statusを確認すること。

9日(月)午前5時

研究のための新しい拠点の下見で移動中。

鉄道もバスもないので(交通機関がない)、何時間で到着できるのかわからない。

戻り次第、作業再開する予定(午後)。

移動中にフェイク動画対策の資料を作成。

空港で撮った写真をRunway Gen-3 Alphaでビデオ生成。事故の偽情報を簡単に生成できてしまう。

この問題を扱わないと、新講座「デザインフィクション」は実施できないので、専門家の方々の意見を聞かないと。

本日深夜2時から

新型のiPhone、Apple Watch、AirPodsあたり?

興味の対象は、Apple Intelligence(日本語対応は来年だが…)

動画生成AIのスローモーションリップシンク問題をどう解決するか?

ミュージックビデオの映像表現に「Slow Motion Lip Sync Effect」というテクニックがある。

倍速で音楽を流して口パクしてもらい、収録したビデオの速度を50%落とすことで、スローモーション映像なのに普通に歌っている不思議なシーンが出来上がる。MVでは80年代から多用されているレガシーな技法である。

XGのMV Behindにスローモーションレコーディング収録の場面があったのでご紹介。

Slow Motion Lip Syncのチュートリアル:

動画生成AIは、スローモーションになってしまうことが多いので、リップシンク機能の場合も大半は「Slow Motion Lip Sync」になる。

動画生成AIで作られた海外のMV作品を見ると、ほとんどがスローモーションリップシンクになっている(そもそも動画生成の作品はスローモーションのシーンばかり)。

動画生成MVのワンパターン化として、よく取り上げられているが、効果的な対応策はない。

例えば、Runway Gen-3 Alphaなら、リップシンク機能を適する前の生成ビデオが「スローモーションにならない」ようにプロンプトを工夫する必要がある。

Creative.Edge Liveの第38回目で、現在の試行錯誤をご紹介する予定。

確かに、ストックフォトサービスにあるビデオ素材もスローモーションがかなり多いので、学習データとの関連性も考えられる。

少ないフレームレートのビデオで学習した結果、生じたアーティファクトという説もある。

技術に詳しい方、教えてください…

ちなみに、RunwayはGen-3 AlphaモードよりGen-3 Alpha Turboモードの方が、スローモーションになりやすい。一貫性を保てるが動きがスローになる。

Gen-3 Alphaモードは等倍に近い状態で動かせるが、ハルシネーションがひどい。破綻することが多いので、やはり技術的な問題なのかもしれない。

会話のシーンも激しいアクションも全てスローモーションというのは、明らかに不自然なので、技術進歩を待って、映像表現の幅を広げてくれることを期待したい。

興味深い論文:

9日(月)午後

戻った。

中断していた作業を再開。

歴史から学ぶVFX

2013年のスコット・ロス氏の講演(京都情報大学院大学)。

創立50周年記念講演会「VFXと世界的パラダイムの変化」

KCGグループ公式YouTubeチャンネル

10日(火)午前

新しい拠点の下見に出かける。

買い溜めできる食料は問題ないが、心配なのはネット環境。

ほんとに、Starlinkが必要になりそう。

参考:

10日(火)午後

2025年以降、OSやメジャーなアプリ・サービスに統合された生成AIが主流に

来年度(2025年度)のスケジュール調整など。

今年はあと4か月しかないので、少し急がないといけない。

来年以降、今のような生成AIの使い方はレガシーになっていくと予想。

基本的に、コンシューマー領域では、OSやメジャーなアプリ・サービスに統合された(機能として提供される)生成AIが主流となり、プロフェッショナル領域ではエンタープライズ製品のカスタムモデルが使用される。

国ごとに生成AIに関するルールが異なるので、アメリカ以外は時間はかかるが2025年半ばから年末にかけて定着していくと考えられる。ユーザーは新しいデバイスにしないといけないのでモバイルではさらに遅れる可能性あり。

企業や自治体では、全社員・全職員にプロンプトエンジニアリングを強いるようなリスキリングは減少すると予測。全ての部署で同じ生成AIを使用するのではなく、業務ごとの最適化が進む(用途に応じたUIが劇的に改善される)。

今月、主にエンタープライズ版の開発に携わる方々との意見交換を予定している。

コンシューマー向け生成AIはOSやメジャーアプリ・サービスに統合されることで、ユーザビリティが大幅に向上し、エージェント型にシフトしていくはず。

今月の動画生成AIの講座

9月は3つ講座があります。内容は全て異なります(内容が重複しないように調整されています)。

映像クリエーター向け 生成AI短期講座 (全2回)

主催:Vook

第1回:9月19日(木)20:00-22:00

第2回:9月20日(金)20:00-22:00

プロンプトで生成するVFX映像を学ぶ!

動画生成AIのRunway Gen-3 AlphaとAfter Effectsの連携ワーク

主催:Motion Elements

26日 (木) 13:00 - 14:00

Frame.ioで劇的に効率化した生成画像・動画のアセット管理術

主催:VIDEO SALON

30日(月) 19:00 〜

11日(水)午前

今月のGenAI 報告会は、28日(土)の午前10時。

第18回目の報告会。

まだ、2週間と4日ほどあるので、この間にRunway Gen-3 Alphaに新しい機能(Gen-2には実装されているカメラコントロールやモーションブラシ、アップスケーラーなど)がくるかもしれない。これらの機能がGen-3で利用可能になったら、Runway最強と言ってよい。

そろそろ申し込みページの準備をしないと。

凄いのが出た。

ZBrush およびMaxon One サブスクリプションに含まれているが、スタンドアロンのサブスクリプションとしても利用できる。

もちろん、無料版もある。

ZBrush for iPadがついに登場しました。ZBrushユーザーの皆様から、外出先で修正を行ったり、アートディレクターに進行中のアイデアを見せて即座にフィードバックを受けたり、カフェや自宅のソファなど、インスピレーションが湧いた場所で作業できるバージョンを求める声が長らく寄せられていました。

Substance 3D ModelerもiPad版が欲しい。

更新日:2024年9月11日(水)/公開日:2024年9月9日(月)