本日の日記 - Runway Gen-2のカスタムスタイル再考/Gen-3の新機能「Video to Video」が利用可能に/Diary 2024/09/14

Ce journal est une sorte de mémo sur les activités quotidiennes du projet Generative AI.

この日記は「自分用のメモ」であり、SNSの代替

ライブ配信がある日は更新されない

PCを使っていると「ですます調」、スマホで書いていると「である調」になりやすい

9月14日(土)午前

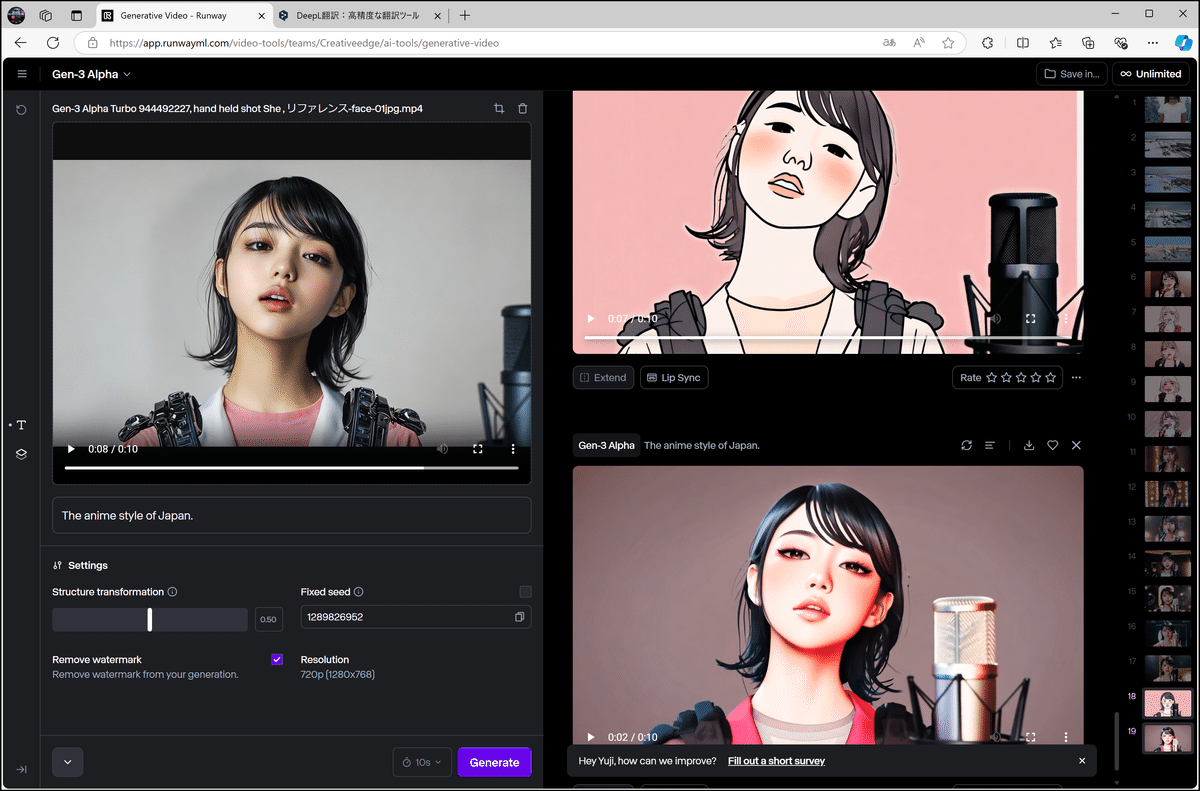

朝6時52分頃、Runwayが「Video to Video」について投稿。

Gen-3 Alphaの新機能(Turboでは使用できない)。

Gen-3 Alpha Video to Video is now available on web for all paid plans. Video to Video represents a new control mechanism for precise movement, expressiveness and intent within generations. To use Video to Video, simply upload your input video, prompt in any aesthetic direction… pic.twitter.com/ZjRwVPyqem

— Runway (@runwayml) September 13, 2024

カメラコントロールやモーションブラシではなく、「Video to Videoだったか!」とRunwayが投げた変化球に不意を突かれる。

確かに、Dream MachineやKLINGにない機能を出した方がニュースになりやすい。

検証-1:

冬景色に変えてみる。

再生成なので、オブジェクト(以下の場合は航空機)は変わってしまうが、プロンプトをそれなりに解釈してくれる。

検証-2:

場所をテレビ番組のスタジオに変えてみる。

これもプロンプトどおりに生成されるが、人物は別人になる(仕様上、これはやむを得ない)。

漫画スタイルや3DCGスタイルなどに変える方が面白い。

フラットなアニメスタイルは難しそう。

Gen-2のカスタムスタイル

Gen-3のVideo to Videoは検証を終えてから評価したい。

個人的には、Gen-2のカスタムスタイルもGen-3に欲しいと思っている。

Gen-2のText to Videoには、スタイル機能が提供されており、さまざまなスタイルを適用することができる。

自分好みのカスタムスタイルを作成することもできる。

(この機能がGen-3に欲しい!)

15~30枚の画像を登録し、トレーニングさせる。

最低でも30枚はあった方がよさそう。

ここでは、エイジングやグリッチが効いたハードコアなビジュアルイメージを登録した(Midjourneyで生成した画像)。

キーワードを決めてトレーニングを開始する。

トレーニングは30分から1時間くらいかかる。

完了すると、スタイル機能の「カスタム」に表示される。

プロンプトを入力。

自分のカスタムスタイルを適用してプレビューを生成。

トレーニングした(エイジングやグリッチが効いたイメージの)スタイルが反映されている。

このイメージをテキストプロンプトで表現するのはかなり難しい。

この機能がGen-3に実装されると、映像のビジュアルイメージづくりが飛躍的に効率化されるので搭載していほしい。

14日(土)午後

今月の報告会、Zoomの上限まで残り20枠。

上限に達すると申込受付が終了する。

YouTubeで浦沢直樹さんと糸井重里さんの対談を観る。

浦沢さんの「3年前に一人でアニメを作った」というエピソードが出てきて、久しぶりにこのMVを観た。

基本、紙のペンだけで、こんな魅力的なMVが作れるという事例。

今月20日の短期講座

新しいMV用の膨大なリファレンスをFrame.ioで管理。リファレンスは全て Midjourney V6.1で生成している。

Frame.ioのバージョン4、ほんとに便利だ。

このMVは、20日のVook主催の短期講座で紹介する。

Midjourney V6.1 キャラクターリファレンス用のモデル。

今のところ、まだAdobe Bridgeの方が高機能だが、Frame.ioはクラウドで管理できるのでユーザービリティは上回る。

Frame.ioの活用法については、30日のVIDEO SALON主催のウェビナーで紹介する。

14日(土)深夜

久しぶりの「深夜ラジオ」を深夜1時15分頃から配信。

リハビリ配信で1時間くらい(アーカイブは残さず)。

更新日:2024年9月14日(土)/公開日:2024年9月14日(土)

この記事が気に入ったらサポートをしてみませんか?