日経コンピュータ2024.10.31

※はブログ筆者のコメントです

日経コンピュータは、2週間に1冊発刊される雑誌です。2010年から全号精読して面白い記事を紹介しています。

特集は<AIデータセンターの真相 計画と条件、本誌調査で判明>です。クラウドファーストと言っていたかと思うと今号はデータセンターの話ですね。技術的には興味深い話が多いですが、企業の基幹システムとは遠い話ですので軽く紹介します。

<セールスフォースが日本でAIエージェント開始、業務効率化や顧客対応の自動化など>

※ceo@salesforce.comがXでMSに対抗発言多数。

例えばこれ(MSのCopilot は不正確で、データ漏洩が発生)

【AIデータセンターの真相 計画と条件、本誌調査で判明】(P.12)

全世界で高性能GPU(画像処理半導体)搭載サーバーを運用出来るデータセンター(DC)が建設されています。従来のデータセンターとの違いが多くあります。

1.18社が32施設を整備 2025年は液冷急増

GPUのシェアを席捲しているNDIVIAは自社のGPUサーバーが稼働出来るDCの仕様を定め「NVIDIA DGX-Ready Data Center」として認定しています。日本のDCは認定を取っていないところもあります。(一覧に書かれてないのが不満)

2025年から、次世代GPUである「Blackwell」を1ラックにつき72個搭載する「ラックスケール」のサーバーである「NVIDIA GB200 NVL72」の量産出荷を開始する予定です。同サーバーは「液冷」が必須です。

2.AIには7要素が必要 冷却能力や床荷重

7要素についての説明

(1)冷却能力 従来型の空冷方式は20kWが限界 AIには35~100kWが必要

(2)床荷重 従来は1平米700kgまで。AIには1000~2000kg必要

(3)電動リフター 従来は足踏リフター AIには電動が必要

(4)バスダクト 施設全体の配電につかっていたバスダクトがルーム内に必要

(5)床防水 液冷の水漏れ対策のために床防水措置が必要

(6)冷却塔(クーリングタワー) 消費電力削減のため必要

温水を冷却する外部施設。日本には少ない。

(7)受電容量

20MWで大規模センター。AIは最低36MW。100MWが必要

→Oracleが建設中の中には受電容量 800MWまで

3.液冷は3方式が競う 要注目はサイドカー

空冷(最大25kW)から液冷に変わっています。サーバー全体を特殊な液体に浸して冷却する「液浸方式」はNDIVIAのGPUが対応していないため、つかrません。

(1)直接液冷(DLC:DirectLiquidCooling)方式(最大170kW)

サーバー内部に冷水パイプを配管して冷水で直接冷やす方式

温まった水をサーバールームの外部で冷やし戻す

(2)サイドカー方式(最大90kW):DCを改造せず使用可能

水をサーバー内部に引き入れ冷やすのはDLCと同じ

温まった水を横に設置したラジエターで空冷する。

(3)リアドア方式(最大50kW):空冷式サーバーが利用可能

ラックの背面扉にパイプを張り巡らし空気を冷やす

温まった水はサーバールームの外部で冷やし戻す

※就職し最初の赴任地の千里中央データセンターで最初に見たACOS6は液冷でした。その後府中や@Tokyoなど多くのDCで仕事しましたが全部空冷でした。歴史は繰り返す。また液冷に戻りそうですね。

【社長の疑問に答える IT専門家の対話術 第278回】(P.86)

<増える「動かないコンピュータ係争」 自社と委託先の開発力を確認しよう>

基幹情報システムの開発を途中で打ち切りIT企業を提訴するという事案が増えています。経営者が新聞やニュースサイトでこれらの情報を眼にし、尋ねられたらどう答えるでしょうか?

係争案件の報告をいくつかよんだところ、システム開発において発注者がすべきことをわかってなかったのではないかと思えてきます。昔であれば発注者と受注者が一枚岩になり最後までやり抜いていました。受注者は発注者の側に踏み込み、言うべきことをいわないといけないのですが、言わなかったのか言ったけど理解されなかったのか、役割分担が曖昧なまま開発が進んでいました。失敗は目に見えています。

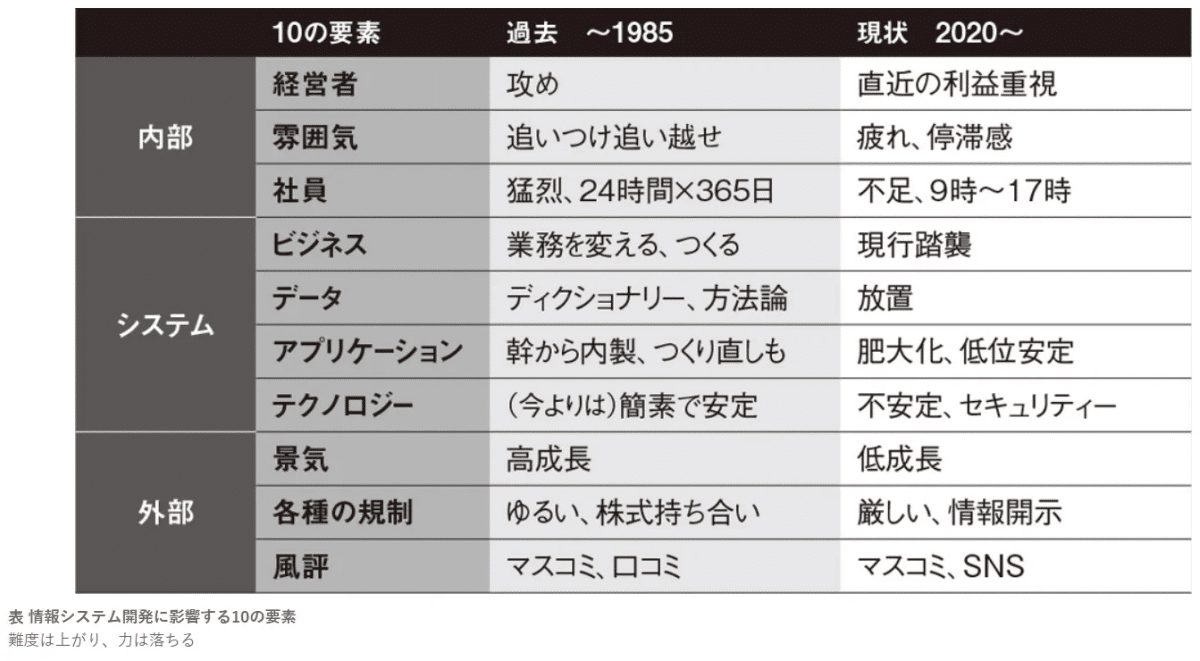

情報システム開発に影響する10の要素をまとめてみました。

「システム」としてエンタープライズアーキテクチャーの枠組みで4つ、社内外の要素を6点選んであります。自社はどうなのか日ごろから考えておきましょう。

以上 ブログ全体はここからお読みください