PonyDiffusionで生成したイラストをSD1.5モデルでi2iしてクオリティアップ

i2iを利用すると、構図と仕上げを別のモデルで行えます。

この手法を利用することで、構図に強いPonyでベースのイラストを出してから、背景やディテールに強いSD1.5モデルや人物描画に定評があるAnimagine系で仕上げることで、イラストの総合的なクオリティアップが可能となります。

WEBUIで行う場合は、1枚目のイラストをt2iで出して、それを別途i2iに掛けます。

少し手間がかかるので、ガチャ生産というよりは、お気に入りの一枚をピンポイントで仕上げるやり方がいいかもしれません。

WEBUIではなく、Comfy UIを使えば、全行程を自動化して1ボタンで処理することも可能です。これにより放置ガチャで大量のイラストを簡単に出力できるようになります。

※ComfyUIの導入は、StabilityMatrixが非常に簡単です。複数UIでモデル併用できるので、ディスク容量を圧迫しないのが最大のメリットです。

i2iによるクオリティアップする手法のカギを握るのはi2iのパラメータ設定です。

パラメータが適当だと、元の絵がそのまま出てきたり、元絵の面影がないほどに改変されたりします。

CFGを6~10、Denoising strengthを0.5~0.7程度にすると、元絵の構図を残しつつ、i2iで使用するモデルのカラーも出せるかと思います。

とくに重要なのはdnoisingで、小さくすると元絵をそのまま残すようになり、大きくすると描き換え比率が増えます。

comfyを使う場合は特殊な処理は不要で、1枚目を普通に生成したら、その絵を次のサンプラーに渡してi2i処理をするだけです。

SDXLからSD1.5モデルにイラストデータを渡す場合は、XLで描いたイラストをXL用のVAEでデコードし、デコードしたデータをSD1.5のVAEを使ってエンコードしてからサンプラーに渡します。

有料部分で、今回使用したcomfyのワークフローの配布と、その簡単な解説を行っています。

興味がある方はぜひご購入、もしくはメンバーシップにご登録ください

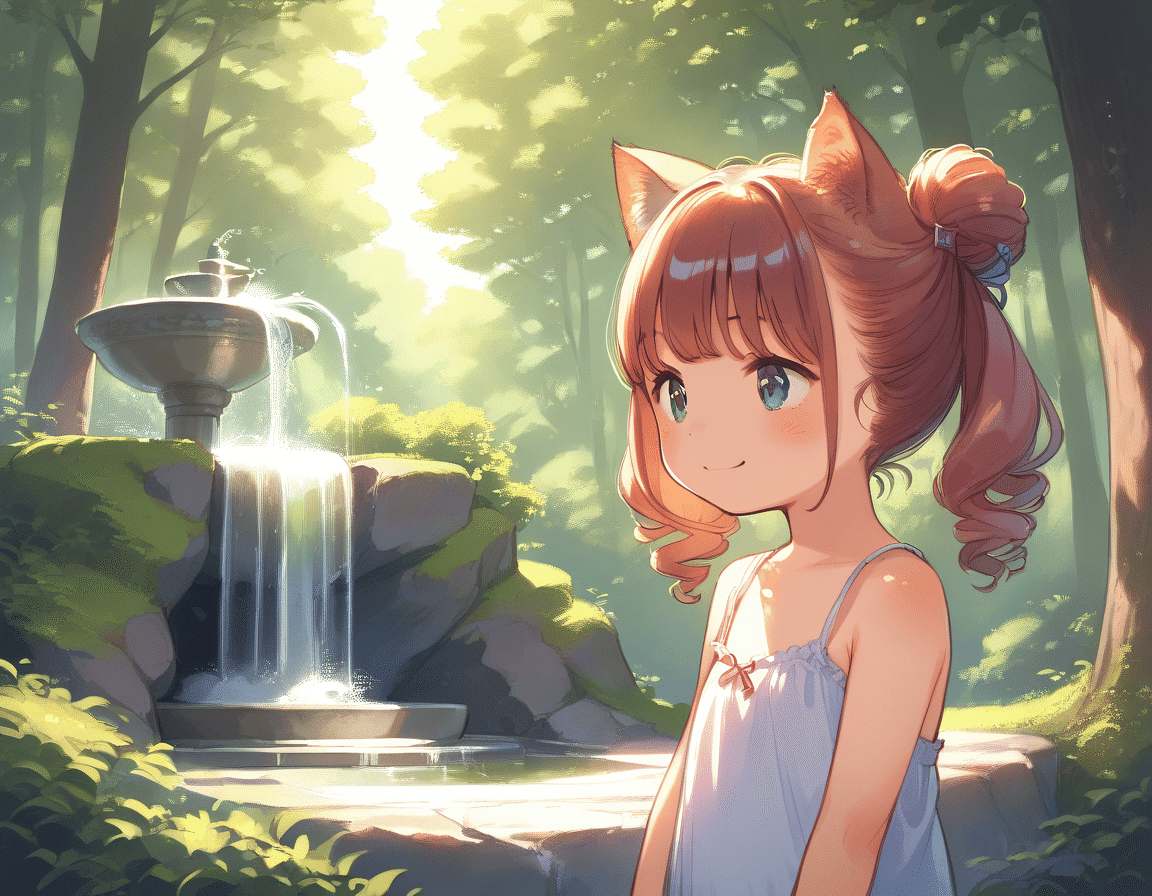

下の方が建物のディテールがかなり向上している。

女の子の肌や服の質感も下の方がより書き込まれている。

水や光の描写など、風景のクオリティはSD1.5の方がかなり高い。

なお上は耳消しLORAを使用している。

LORAはSDXKとSD1.5で互換性がないため、

LORAを使った場合はi2iの精度が下がりがち。

モデルごとの個性も1.5の方が強く、選ぶのが楽しいかも。

今回使用したワークフロー。

最初にXLモデルでイラストを作成し、作成したイラストデータを右の工程に渡してi2i処理を施している。

基本的な流れと処理で作っているので、このワークフローの動きを理解するとComfyの挙動の初歩を覚えられる。

以下、番号ごとに何をしているかの説明。

ここから先は

Amazonギフトカード5,000円分が当たる

この記事が気に入ったらチップで応援してみませんか?