【論文瞬読】LLMの思考革命!Quiet-STaRでAIが「考える」ことを学ぶ!?

こんにちは!株式会社AI Nestです。

今回は、大規模言語モデル(LLM)の世界に激震が走るかもしれない、Quiet-STaRという最新技術について解説します。難しい数式はちょっと...という方もご安心ください。専門用語はしっかり解説しつつ、Quiet-STaRのすごさをわかりやすくお伝えします!

タイトル:Quiet-STaR: Language Models Can Teach Themselves to Think Before Speaking

URL:https://arxiv.org/abs/2403.09629

所属:Stanford University, Notbad AI Inc

著者:Eric Zelikman, Georges Harik, Yijia Shao, Varuna Jayasiri, Nick Haber, Noah D. Goodman

なぜ「考える」LLMが必要なの?

最近、ChatGPTをはじめとするLLMが私たちの生活に浸透してきましたよね。でも、実はこれらのモデル、人間のように「深く考えて」文章を生成しているわけではありません。どちらかというと、膨大なデータからパターンを学んで、それっぽい文章を紡ぎ出しているんです。

例えば、「猫はなぜ可愛いのか?」という質問に対して、LLMは「ふわふわしているから」「甘えるのが上手だから」といった答えを返すかもしれません。しかし、これは「猫が可愛い理由を深く考えた」上での答えではなく、過去のデータに基づいた「統計的に最もらしい答え」に過ぎません。

そこで登場するのが、Quiet-STaRです!Quiet-STaRを使えば、LLMが「本当に考えて」答えを導き出すことができるようになります。これにより、より人間らしい、説得力のある文章が生成できるようになるだけでなく、複雑な問題解決や創造的なタスクにもLLMを活用できるようになるかもしれません。

Quiet-STaRの仕組みをざっくり解説

Quiet-STaRは、LLMに「思考」というプロセスを導入します。この「思考」は、私たち人間が何かを考えたり、推論したりするプロセスに似ています。Quiet-STaRでは、以下の3つのステップでLLMに思考を促します。

think(考える): まず、LLMは与えられたテキストの各トークン(単語や句読点など)に対して、次に続くトークンを予測するための推論を生成します。

talk(話す): 次に、LLMは生成した推論に基づいて、次に続くトークンを予測します。

learn(学ぶ): 最後に、LLMは予測結果と実際のテキストを比較し、より正確な予測ができるように推論プロセスを改善していきます。

この一連の流れを図で表すと以下のようになります。

図1はQuiet-STaRの全体像です。ここでは、ある文章に対して各トークンごとに思考(Think)し、その思考に基づいて文章を生成(Talk)し、そして思考が助けになったかどうかを学習(Learn)しています。

Quiet-STaRのここがすごい!

Quiet-STaRのすごいところは、以下の3点です。

どんなテキストデータでも学習可能: これまでの手法では、特定のタスクに特化したデータセットが必要でしたが、Quiet-STaRはどんなテキストデータでも学習できます。これにより、より広範な知識やタスクに対応できるLLMが実現できます。

高速な並列処理: Quiet-STaRは、並列処理によって高速に推論を生成できます。これにより、大規模なモデルや大量のデータに対しても効率的に学習を進めることができます。

思考の開始と終了を制御: Quiet-STaRは、<|startofthought|>や<|endofthought|>といった特殊なトークンを使って、思考の開始と終了を明示的に制御します。これにより、モデルの推論プロセスがより明確になり、解釈性も向上します。

実験結果もバッチリ!

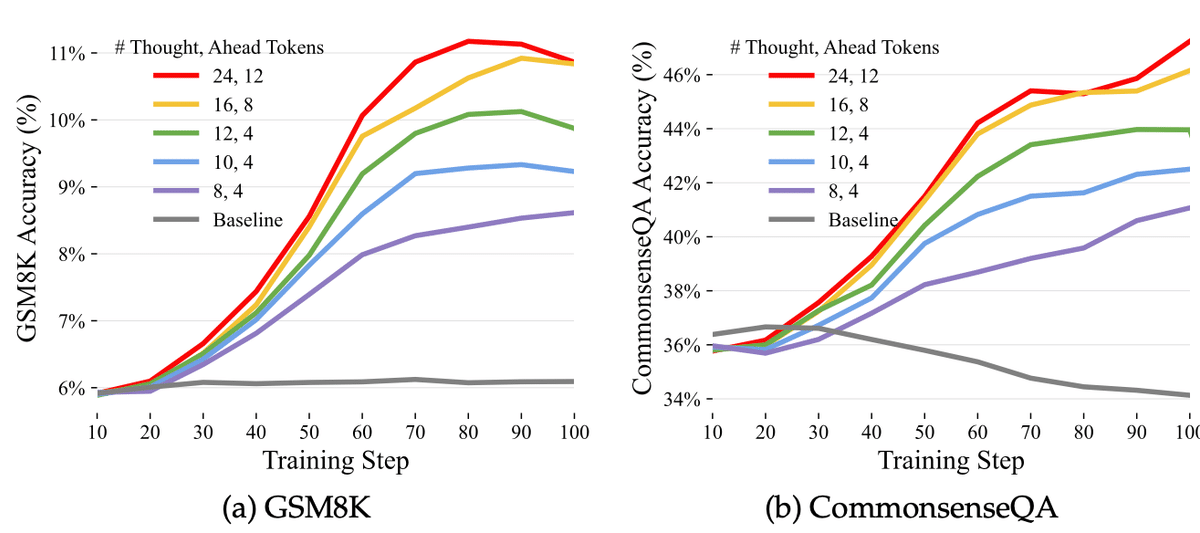

Quiet-STaRを使って学習したLLMは、常識推論(CommonsenseQA)や数学の問題解決(GSM8K)などのタスクで、目覚ましい性能向上を示しています。しかも、これらのタスクに特化したデータで学習したわけではありません。Quiet-STaRによって、LLMは汎用的な推論能力を獲得できることが示唆されています。

図2は、Quiet-STaRで学習したモデルが、CommonsenseQAとGSM8Kというタスクにおいて、思考に使うトークンを増やすほど性能が向上していることを示しています。

まとめ:Quiet-STaRでLLMはもっと賢くなる!

Quiet-STaRは、LLMが人間のように「考える」ことを可能にする画期的な技術です。これにより、LLMは単なる文章生成ツールから、より高度な問題解決や創造的なタスクをこなせるAIへと進化する可能性を秘めています。今後のQuiet-STaRの研究に、ぜひ注目してみてください!