AIやそのデータを起因とする事故やトラブルの責任はどこに? AIデータリスクを最小限に抑えるソリューションを

AIが一般の生活にも浸透してきたために、企業も個人もAIを利用するにあたり、AIやAIデータを起因とした事故やトラブルの責任がどこにあるのかを知っておく必要が出てきました。本記事ではAIやそのデータを起因とする事故やトラブルの責任はどこにあるのかを解説し、AIデータリスクを最小限に抑えるソリューションをいくつか紹介します。

AIデータリスクの基本概念とは何か

AIデータリスクとは、AI(人工知能)がサービスや製品に導入されることにより生じる潜在的なリスクのことを指します。これはAIが偏見や差別的な発言をしたり、誤った判断を下したりすることで、サービス自体が廃止や撤回を余儀なくされる事例が増えてきたことから注目されました。

米オープンAIが公開して大流行したChatGPTのようなAIも「どこまで信用していいのか」という懸念や悪用のリスクが存在します。これらのリスクは、企業の意思決定の失敗に直結し、ビジネスに大きな損害を与える可能性があるのです。

したがってAIデータリスクを理解し、適切な対策を講じることは、AIを活用するすべての企業や組織にとって重要な課題となっています。

AIやAIデータを起因とする事故の法的責任はどこにあるのか

人工知能(AI)やAIデータは、私たちの生活にさまざまなメリットをもたらしています。しかし一方で、事故や損害を引き起こす可能性もあるのです。

車の自動運転の領域は、現在は「レベル2」として知られる、システムが人間の運転をサポートする段階に留まっています。しかしシステムが緊急時を除き運転を担当する「レベル3」、特定のエリアで人間の介入が一切不要な「レベル4」、そしてすべての場所でシステムが完全に運転を行う「レベル5」の導入は、近い未来に実現する可能性が高まっています。

現在の日本の法律体系は、「レベル2」の自動運転を基準としています。この段階では、自動運転が行われていても、事故の責任はドライバー(人間)にあります。運転者の技術や交通ルールの遵守能力は、運転免許の試験を通じて公式に認められ、合格者だけが運転を許されます。さらに、車の安全性は車検を通して確認されます。

交通事故が発生した場合、運転者が事故を予見できたにも関わらず、適切な対応を取らなかったことが原因とされることが多いです。法的には、事故による損害の責任は主に運転者にある、といえます。

責任の所在は技術者、企業、またはAI自体?

それでは、今後さらに自動運転が発展し、AIやAIデータを起因とする事故や損害が発生したとき、責任の所在はどこにあるのでしょうか。ここでは、完全自動運転車を例にみていきます。

完全自動運転車と現行法における刑事責任の所在とは

完全自動運転車が交通事故を引き起こし、人的な被害が出た場合、現在の法律ではどのような法的な責任が問われるのでしょうか。

完全自動運転車には、人間の運転者は不在です。このため運転者を前提とした現在の法律は、この種の車には当てはまらず、異なる法律が適用されることとなります。

刑事的な側面で見ると、自動車運転過失致死罪などの法律は、運転者の責任を前提としているため、完全自動運転車の事故には適用されません。しかし、車のAIプログラムに欠陥があった場合、またその事故の原因となった場合、および車の製造者や関連する担当者が業務上の過失による罪に問われる可能性が考えられます。

完全自動運転車と現行法における民事責任の所在とは

民事的な側面では、被害者が受けた損害の賠償責任は、車の製造者が負うこととなります。主な法的根拠は、製造物責任法(PL法)です。簡単に言うと、完全自動運転車のプログラムに問題があり、それが事故の原因となった場合、車の製造者は賠償責任を負うことになるのです。さらにこのような欠陥を持つ車を製造した過失を、民法を基に製造者に問うことも可能です。

また完全自動運転車が交通法規に反した場合、製造者が行政的な責任を持つことも考えられますが、現在の法律には明確な根拠はありません。

要するに、完全自動運転車が事故を引き起こした場合、法的な責任を問われるのは、車の製造者や関連する担当者となります。運転者が不在のため、この結果は予想されるものといえるでしょう。

AIによる事故や損害に関する法律とは

AI技術の進化と普及に伴い、AIによる事故や損害に対する法的な規制や法律の必要性が高まっています。現在、AIに関する法的な枠組みは、多くの国でまだ発展途上にあるのです。

日本においては、AIのガバナンスに関する議論が進められており、法の追いつかない社会のスピードや複雑さを克服するためのルール形成が検討されています。また、AIに関する法的論点や弁護士実務への影響についても研究が行われています。

つまりAIの進化に法的な規制が追いついていないのが、現状なのです。

AIによる事故が発生した場合、現行の法制度では、製造物責任の枠組みや民法に基づく責任が考えられます。特にAIが搭載するプログラムに欠陥があり、それが原因で事故が発生した場合、自動車メーカーやプログラマー、設計・製造担当者の責任が問われる可能性があります。

2023年現在では、AIによる事故や損害に関する法律は、以下が考えられます。

AIの所有者の不法行為責任:AIが他人に損害を与えた場合、その所有者が責任を負う可能性があります。この責任は「不法行為責任」と呼ばれ、以下の要件を満たす必要があります。

○ 侵害行為に故意または過失があること

○ 損害が発生していること

○ 侵害行為と損害との間に因果関係があること

AIの製造者の製造物責任:AIが他人に損害を与えた場合、その製造者も製造物責任を負う可能性があります。この責任は「製造物責任」と呼ばれ、以下の要件を満たす必要があります:

○ 製造物に欠陥があること

○ 他人に損害が発生したこと

○ 製造物の欠陥と損害との間に因果関係があること

これらの規制や法律は、AI技術の進化と共にさらなる議論や改訂が求められています。

AIによる事故や損害の法的責任とその影響とは

AIによる事故や存在の法的責任について、2つの責任を上述しました。しかしAIやロボットによる事故や損害が発生した場合、その法的責任の所在は非常に複雑です。日本の民法709条には、「故意又は過失によって他人の権利又は法律上保護される利益を侵害した者は、これによって生じた損害を賠償する責任を負う」と規定されています。この原則に基づき、AIやロボットの設計、製造、運用に関与した個人や企業は、その行動や判断による事故や損害に対して法的責任を負う可能性がある、といえるでしょう。

具体的には、AIのプログラムに欠陥があった場合、そのプログラムを開発した企業やエンジニアが責任を問われることが考えられます。また、AIを搭載した製品を販売する企業も、製品の安全性を確保する責任があるのです。

このような法的責任が生じた場合、関与した個人や企業は、損害賠償請求を受けるリスクが高まります。これにより企業の経営に大きな影響を及ぼす可能性があり、企業の評価や信用も低下する恐れがあります。またAI技術の進化とともに、その適用範囲や影響も拡大しているため、今後の法的な議論や制度の整備が求められるでしょう。

法律は間に合っていない?AIに関する法的枠組みやガイドラインの現状

AI技術の進展に伴い、その利用に関連する事故や損害に対する法的規制の必要性が高まっています。日本においても、AIに関する法的枠組みやガイドラインが整備されつつあります。ここからは、以下の3つの観点からAIにまつわる法規制について、詳しく解説します。

AIガバナンスの在り方

経済産業省は「我が国の AI ガバナンスの在り方 ver. 1.1」という文書を公表しています。この中で、AI技術の社会的な利用を促進するためのルール形成について触れられています。特に、社会のスピードや複雑さに法が追い付けない問題を克服するための新しい規制の方向性が示されています。

製品事故救済に関する法制

AIによる自己学習や大幅な改造・改変が進む中、それらが原因で生じる損害についての責任関係を考える際、従来の製造物責任の枠組みだけでは対応が難しいとの認識が示されています。これに対応するための新しい法的枠組みの検討が求められています。

AI・データの利用に関する契約ガイドライン

経済産業省は、AIやデータの利用に関する契約のガイドラインを公表しています。このガイドラインでは、データの管理方法やセキュリティ、個人情報保護法に関する規制など、AI技術の利用に関連する契約上の注意点が示されています。

これらの文書やガイドラインを通じて、AI技術の利用に伴うリスクを最小限に抑え、技術の発展と社会の安全を両立させるための方向性が示されています。ただしまだ法律を整備し法規制する段階までは進んでいないのが現状で、万が一AIを起因とする事故や損害が発生したら、現実と乖離していながらも現行の法律にしたがうしかなさそうです。

AIデータリスクを最小限に抑えるソリューション

法律の整備がAIの進歩に追いついていない以上、AIやAIデータによる事故や損害のリスクを最小限に抑える取り組みが求められるでしょう。ここからは、AIデータリスクを最小限に抑えるソリューションについて詳しく解説します。

NVIDIAのソリューション

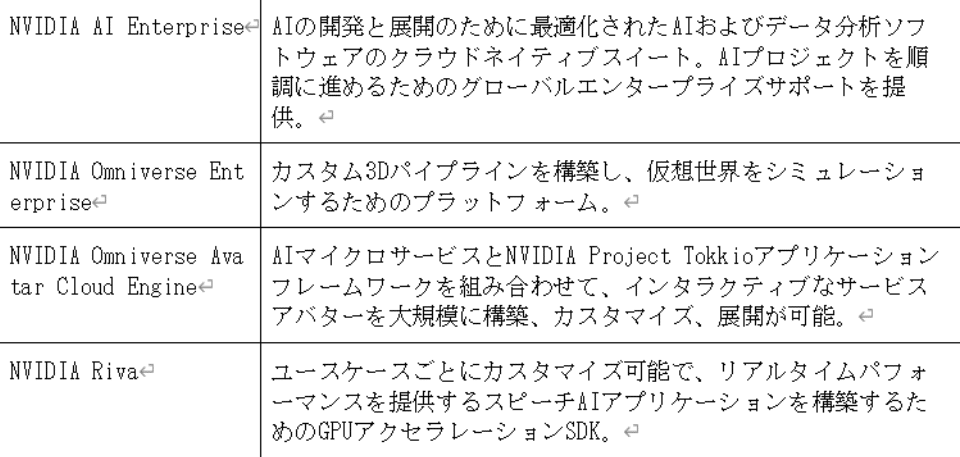

NVIDIAは、AIデータリスクを最小限に抑えるためのソリューションを提供しています。具体的には、以下のような製品とサービスがあります。

これらの製品とサービスは、AIデータリスクを最小限に抑えるだけでなく、ビジネスの効率性と生産性を向上させることも可能です。具体的には、AIシステムのセキュリティ体制を強化し、データ侵害や損害の可能性を低減できます。また、これらのソリューションは、組織が自身のAIシステムをより効果的に管理し、そのパフォーマンスと信頼性を向上させるための重要なツールとなります。

マイクロソフトのAIセキュリティリスク管理フレームワーク

マイクロソフトのAIセキュリティリスク管理フレームワークは、組織がAIシステムを確実に監査、追跡、改善できるようにするためのステップとなるフレームワークです。具体的な特徴は、以下です。

● AIシステムのセキュリティに対し包括的な視点を提供

● 機械学習の脅威と、その緩和策について推奨事項を解説

● 組織におけるリスク評価の実施を支援

またマイクロソフトはオープンソースツールであるCounterfitのアップデートも提供し、AIシステムのセキュリティ体制の評価を簡素化できるようにしています。これにより組織内のAIシステムのセキュリティの現状について情報が収集できるほか、ギャップ分析を実施し、セキュリティ体制の進捗状況を追跡することが可能です。

導入方法はまず、マイクロソフトの公式Webサイトや関連資料を参照し、フレームワークの詳細な内容を理解します。次に自組織のAIシステムに対してこのフレームワークを適用し、必要な改善点や課題を洗い出します。そして、それらの課題に対して具体的な対策を立て、実行に移すことで、AIシステムのセキュリティ体制を強化していきます。

AOSデータ株式会社のAOS IDX

AOSデータ株式会社が提供するAOS IDXは、AIデータリスクに対する有効な対策のひとつです。ここからは、AOS IDXの概要と特徴、使用するメリットについて解説します。

AOS IDXの概要

AOS IDXはすべての産業分野に業界型DXソリューションを融合し、デジタル化を進め市場競争力を高めるインテリジェントなデジタルイノベーションを意味します。

AOS IDXの特徴

● イネーブラー型プラットフォーム(Enabler Platform・他の企業やサービスが独自の製品やサービスを構築・提供するための基盤やツールを提供するプラットフォーム)として、さまざまな産業分野に合わせてコアのエンジンをベースに機能を組み合わせるようにアジャイル型開発で設計されている

● 各産業分野が必要とするDXソリューションをSaaSサービスで、API連携を活用し、短期間で構築できる総合SaaSプラットフォームとしての提供が可能

使用するメリット

● セキュアなファイル共有とストレージ一体型ソリューションであり、クラウドで効率よくファイル共有が可能

● 法務部門向け、医療部門向け、金融部門向け、製造業向け、メディア業界向けなど、各産業分野に特化したソリューションを提供

● データのDX管理を主軸とし、セキュアなファイル共有とストレージ一体型コア技術でAPIを通じて連動しSaaSプラットフォームで各企業DXを支援

これらの特徴により、AOS IDXは幅広い業界が講じることができるAIデータリスクの効果的な対策となるでしょう。

まとめ

AIやAIデータを起因とする事故や損害に対しては、法整備が追いついていないのが現状です。現実と乖離した状況で発生した事故や損害であっても、法律に基づいて損害賠償や責任の追及が行われるため、今後いっそうAIにまつわる法整備を求める声が上がりそうです。

ただし法整備を待ち、AIを採用しないでいることは企業活動における大きな経済的損失を生むでしょう。

そのため法整備が追いついていない現状を踏まえながらも、AIにまつわるリスクを最小限に抑える対策をとりながらAIを導入したり、AIを利用したりすることになるのではないでしょうか。

本記事で紹介したAIやAIデータリスクを最小限に抑えるソリューションを参考に、自社にあったAI導入や、AIデータリスクへの対策を講じましょう。