AutoGenStudioの使い方。自律型AIエージェント/ビル・ゲイツも注目する新技術

公式ドキュメントしか情報がない、AutoGen。ChatGPTにお世話になりながら、なんとかAutoGenStudioを動かしてみました。

長ーい動画で説明が上手くないんですが、なんとか動かしてます。

ちなみに個人には、このAutoGenを使ってアプリを作るのが目標!Pyhhonのフレームワークである、Djangoに組み込むか(Sreamlitか)スマホアプリに組み込むか。

世の中の概念をちょっと変える、アプリを個人開発する!と心に決め。

というのも、まだ黎明期だからです。参入の余地があるからです。みんなが使う、使えるようになってからでは遅いと思うからです。

と言うことで足がかりに、Augo GenをAugo Gen Stusioで動かしてみました。

Microsoft Augogen

こちらが公式ドキュメント☟

AutoGenはペンシルベニア大学とワシントン大学の共同研究で生まれたフレームワークです。AIエージェントが協調してタスクを実行するマルチエージェントシステムです。

例えばアプリを作りたい場合、環境構築やデザイン、プログラミング、データベース構築など、様々なことを行う必要がありますが、この自律型AIエージェントを使えば、それぞれの専門家エージェントが協調してこれらの構築を自動で行ってくれます。

こんななイメージ。それぞれ専門性をもったAIエージェントが、協働してタスクを実行していきます。人間を介入させることもできるし、100%自動でタスクを実行ですることもできる。

ビル・ゲイツの見解

ビル・ゲイツも「いずれ新しいアプリやサービスを作成するには、エージェントに希望を伝えるだけで済むようになるだろう」と述べています。複雑なタスクをAIエージェントが自動で実行してくれる時代が来ると予想しています。

個人個人の要望や興味に合わせたパーソナルエージェントも出てくるとしています。即座に必要な情報を呼び出せるようになるため、新しいデータベースが必要になるとも述べています。

AutoGenStudioの立ち上げ方、使い方

AutoGenStudioは、このAutoGenをWeBUIで動かせるフレームワークです。

ただ、まだ完璧に動きません!正直に言ってしまうと、複数のエージェントがスムーズに動いてすごいものを作るということろまでは行ってないです。

ただ、まだ出たばかりの技術で、GPT1.0、みないな感じです。

ただ、逆に今のうちに研究し、作りたいアプリや事業のネタを考えておくことが大事だと思います。黎明期のうちに。

AutoGenStudioに利用されているフレームワークには、 GPT に適合されている。

最近アップデートされたChatGPTが適合されたAutoGenです。

ただ、コードで動かすように複数のエージェントは指定できません。また、マルチモーダル機能(音声、テキスト、画像、動画などを同時に扱うこと)などはできません。

AutoGenStudioの立ち上げ方、使い方

かなり苦労しました!今のところ、公式ドキュメントしかなかったので。

とりあえず動かせただけで、大したことはできてない、すみません、、

AutoGenStudioのトップはこんな感じ。

Microsoft AutogenStudio ▶️https://microsoft.github.io/autogen/b... 【AutoGen Studio起動に使ったコマンド】 順番に以下をターミナル(コマンドプロンプト)に打てばAuto Genstudioが立ち上がります。

pythonがパソコンにインストールされていること前提です!

ChatGPTのAPIキーを入れたコマンドを打つ

Macはターミナルに、Windwosはコマンドプロンプトでコマンド以下のを打っていきます。

MAC(ターミナル)の場合

export OPENAI_API_KEY=‘YOUR_API_KEY’(

YOUR_API_KEYの部分には、OpenAIのキーを入れる)

Windowsの場合

set OPENAI_API_KEY=YOUR_API_KEYちなみに!気になるOpenAIのAPIの価格。

意外と安い。最低10ドルからプリペイドできて、それが使い終わったら、自動課金されることはありません。(自動チャージオフにしておけば)

さらに、コンテキスト量によりますが、テキスト一回で0.01ドルぐらい?画像で0.1ドルぐらいの消費。かなり安いです。

10回ぐらいAutoGen動かして1ドルに満たない!

仮想環境を作る(Conda)

デスクトップに仮想環境を作る場合

cd ~/Desktopcondaで仮想環境を作る

開発環境を整えるためには、仮想環境の作成が有効です。condaを使って仮想環境を作ることができます。これにより、プロジェクトごとに異なるバージョンのライブラリを使用することができます。

conda create --name myenv python=3.10仮想環境をアクティブにする

conda activate myenvAutogenStudioのインストール

pip install autogenstudioAutogenStudioはオートジェンのコア部分です。このツールを起動することで、人工知能を活用した開発が可能となります。

AutogenStudioの立ち上げ

autogenstudio ui --port 8081AugoGen Studioの設定と使い方

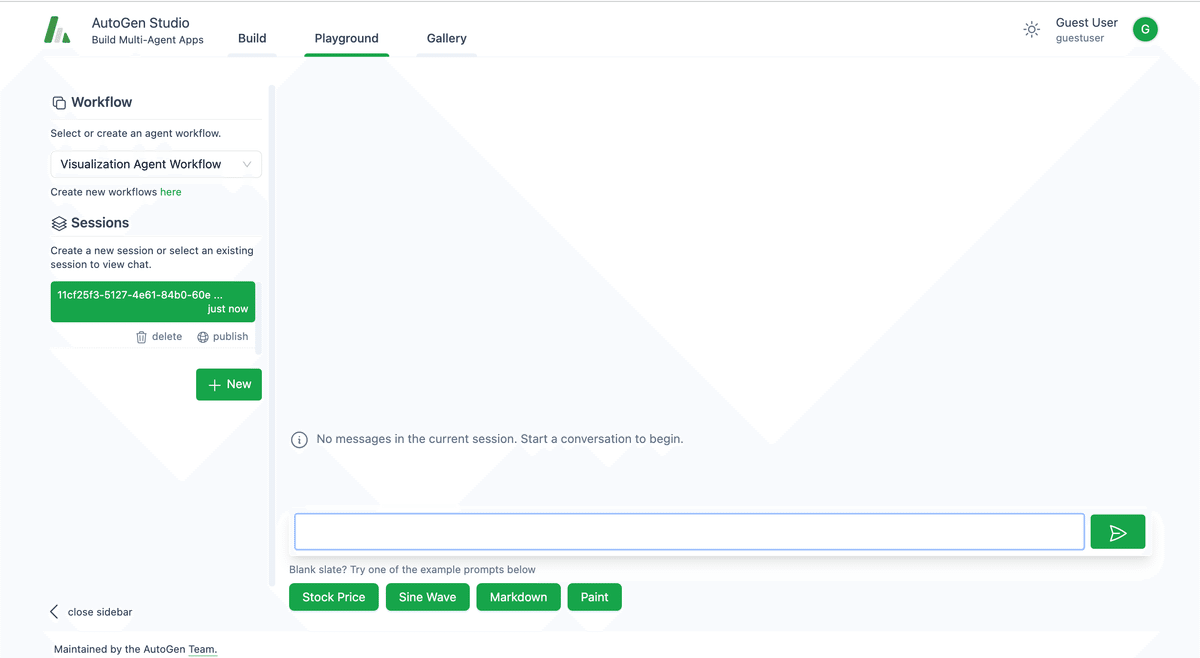

まず、Build,Playgroud,Galleryの3つのタブがあります。

Build= 各種設定。Skill,Atents,workFlowsを設定する

Playgroud 実際にタスクを実行するところ

Gallery 試したタスクを保存したり、編集できるところ

Skill,Atents,workFlowsそれぞれは以下です。

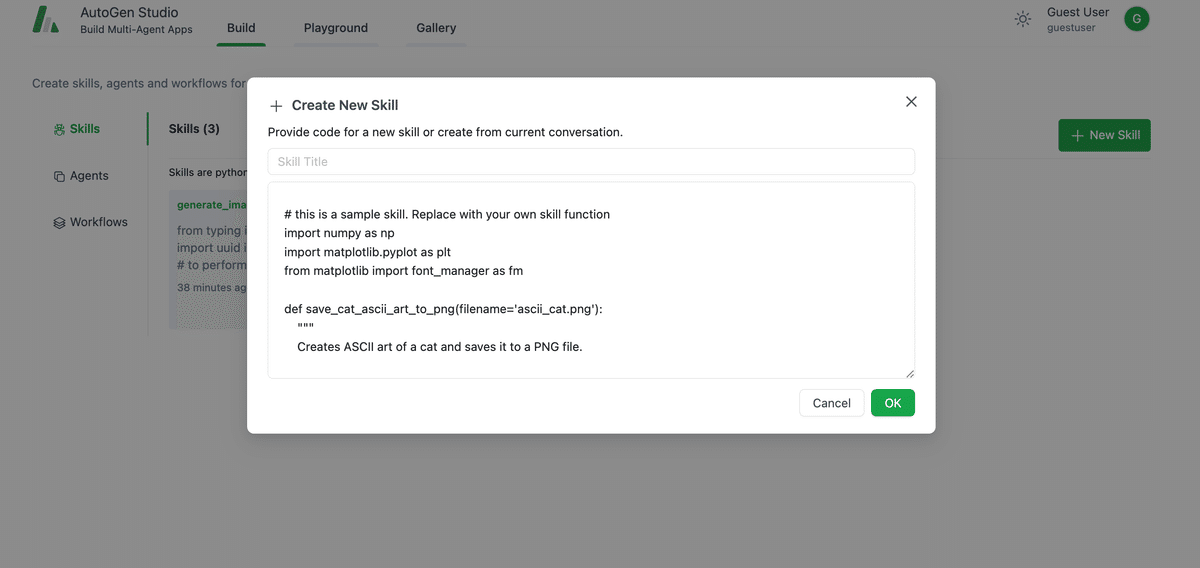

スキル(Skills):

スキル(Skills)は関数を追加できるところです。デフォルトで

Generate _image(画像作成) 、fetch_profile(プロフィール検索)、find_papers_arxiv(論文検索)などのSkillが関数として登録されています。

ここに関数を登録。

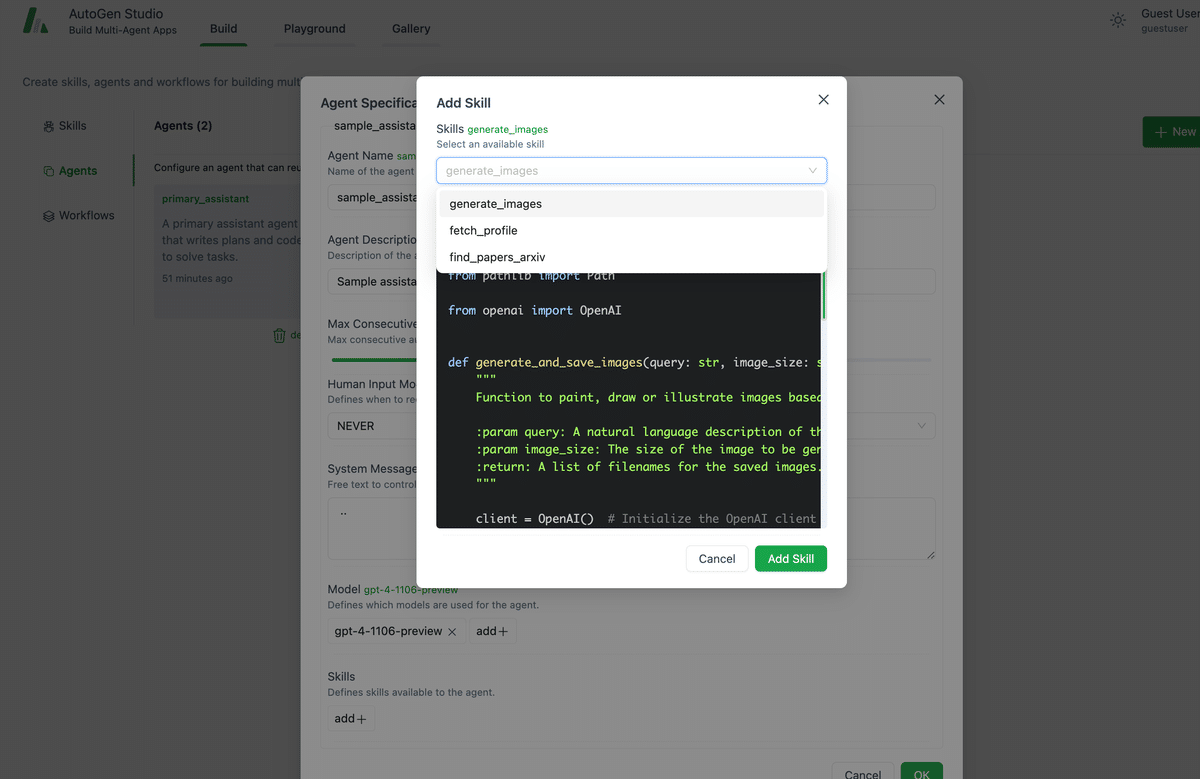

エージェント(Agents):

エージェントは、AutoGen Studioの中で動く助手やキャラクターのこを登録できるとろです。

NewAtentをクリックして、下記をでエージェントを登録します。

Skillsで登録したエージェントを選択できる

Modelのところには、使いたいモデル、AIのモデルのAPIキーか、URL(エンドポイント)を入力。

エージェントワークフロー(Agent Workflows):

エージェントワークフローは、複数のエージェントをどのように動かすか、という設計をするところです。

ただし、Agent Workflowsはマルチエージェントで動かせるようになっていないみたい。UsereProxyとPrimary _assistandの2者が会話して動くような設計になっています。

こちらを登録。

Sender (userproxy) と Receiver (primary_assistant)

このWorlFlowsの中にある、Sender (userproxy) と Receiver (primary_assistant)の役割がわかりずらいので解説。

Sender (userproxy) : これは 「送信者」という意味。プログラムの中で、 Sender (userproxy) はユーザーの代わりに何かを送信する役割を持つ。

例えば、ユーザーがコンピューターに何か質問をすると、その質問をSenderが 受け取って、他のエージェントに送る役割を担う。

Receiver (primary_assistant) : これは 「受信者」という意味。Receiver (primary_assistant) は、Senderから送られてきた情報や質問を受け取り、 それに対して答える役割を持つ。例えば、ユーザーからの質問を受け取り、そ れに対する回答や情報を提供。

以下は、NVIDIAと、TESLAの株価を比較してとうタスクの依頼。

Sender (userproxy)は、私=ユーザーの依頼を汲み取り代理として、primary_assistantに依頼し、primary_assistantが実際のタスクを実行。

primary_assistantが実行したタスクをチェック。

かなりややこしいですが..