CES2024で大注目の次世代AI端末Rabbit r1とは何か?

CES2024で革命的な新しい基盤モデルを搭載した画期的で新しいモバイルデバイスRabbit r1が発表されました。発表後、各メディアからも大注目を浴び、ジョブズ再来とも言われた注目すべきニューデバイスについてお伝えします。

次世代AI端末は一体何ができるのか?

話題となった次世代端末AIは一体何ができるのでしょうか?一言でいうと、音声を使ってアプリを操ることができます。今あるものに例えていうのであれば、「ChatGPT並みに性能アップしたSiriから直接さまざまなアプリを操れるようになったもの」というのが、私の印象です。

以下に説明動画がありますが、すべて英語でした。

ChatGPTは自然言語を介して対話ができるAIですが、これにはLLM(Large Language Model:大規模言語モデル)というものが使われています。対してRabbit R1は、人間の意図を理解してコンピューターで実行する大規模な言語モデルであるLAM(Large Action Model:大規模行動モデル)を使用しています。問題解決の意識をChatGPTが提供した「対話」の先の「行動」に向けて生み出したのがこのモデルなんですね。

動画では、LAMは以下のように説明されていました。

LAMは、どのプラットフォームで実行されているかに関係なく、あらゆるソフトウェアからあらゆるインターフェースを学習できます。つまり、Rabbit R1を使用して、お気に入りのアプリやサービスと対話できます。メニューをクリックしたり、複雑なコマンドを学習したりする必要はありません。

ハードウェアと価格

ハードウェア

タッチスクリーン

プッシュトークボタン(ダブルクリックでカメラ起動)

アナログスクロールボタン

360度回転カメラ(Rabbit eye)

マイク、スピカ―

4G-LTE SIM Card スロット

Bluetooth, Wi-Fi

価格

$199 サブスクリプションは不要です。

日本からの購入では、29,400円と表示されます。

iPhoneなどの高額なスマートフォンに比べて割安感を感じ、海外メディアを通しても購入しやすくてよい印象を持たれたようです。

AmazonのアレクサやGoogleアシスタントの製品よりも少し出せば手が届く程度です。

このような商品の場合はサーバーを通して常にサービスを提供する必要があるので、そのコストをどうやって吸収していくのかには興味があります。

どんなことができる?

具体的にどんなことができるのでしょうか?発表の動画ではまず最初に以下のデモを披露してくれました。

・いろいろな質問に対しての回答(株価や映画などについて)

・音楽を聞く(Spotify)

・Uberタクシーの手配

・ピザの注文

・旅行の予約

これらの動作は特に支払いのあることに関して、ユーザーは確認をするだけで実行されました。あと、リアルタイム同時通訳(デモはしませんでした)も可能ということでした。

スマートフォンに慣れた私たちは、何かをするために何かのアプリを常に選んび何度もタップしたりボタンを押して目的の作業を行っていますが、Rabbit r1を使う場合は、ユーザーとしてアプリの概念を知っておく必要がなく、ほしいものややりたいことを自然言語で伝えることで、Rabbit r1がそれに対応して実行してくれます。Rabbitは最強のシンプルを目指し、アプリを選択するということさえ不必要にしたわけですね。

セキュリティー面に関して

Uberやピザの注文などの各サービスを実行する際には、事前にRabbitの提供するポータルサイトを通じて各サービスにログインし権限を与える必要があります。この際、Rabbitのサイトは各種サービスへの入り口を提供しているだけであり、ユーザーIDやパスワードを保存しないため、安全性が高いとうたっていました。

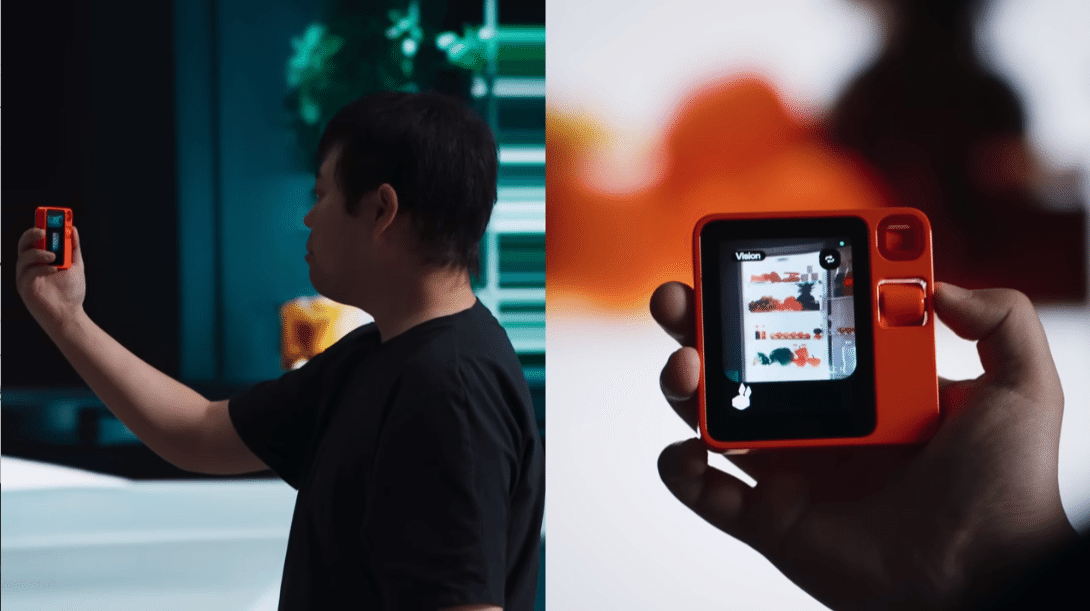

カメラを使ったデモ

360度回転カメラはコンピュータービジョンの機能があります。これは、写っている映像をRabbit r1が認識できるということです。コンピュータービジョンの機能を持ったカメラを使って以下のようなデモを行っていました。

・カメラで冷蔵庫の中を撮影して、レシピを考えてもらう

・パソコン内のスプレッドシートを撮影して、そのスプレッドシートに操作する。

スプレッドシートの操作については、Rabbitポータルサイトに対して事前にアクセス権限を与えておき、撮影したときにRabbit r1がそのスプレッドシートを認識できるようになっているんでしょうね。この連携が素晴らしいですね!デモの画像では単純な動作だったものの、この連携がシームレスに自然言語だけで実行できてしまうことには驚きでした。

学習モード(Teach Mode)

最後に、Rabbit r1に新しい作業を覚えさせることができる学習モードについてデモを披露してくれました。

Rabbitポータルサイトを通して、MidJourneyを使い、プロンプトを書いて犬の絵を描く命令をする動作を行いました。その後、絵が生成されたら学習は完了です。

学習完了後、Rabbit r1次はMidJourneyで絵を作成できるようになっていました。

まとめ

動画の説明の中でもこのデバイスは今のスマートフォンにとって代わるものではなく、新たな別のデバイスだということ強調していました。デジタルネイティブならぬ、AIネイティブ製品の第一弾という感じでしょうか。私もその意見に同意します。スマートフォンの使い勝手の良さは今すぐにこのデバイスで代替できるものではないと思います。しかし、自然言語を使った音声でさまざまな操作を実行までしてくれるこのデバイスは新たな提案であり、今後大きく発展する可能性を秘めたものだと感じました。

いいね!やフォローで、ぜひ応援よろしくお願いします!

励みになります!

また、X(旧Twitter)でAIについての雑談を不定期に行っておりますのでフォローをお願いいたします。