12 Days of OpenAI: Day 6 ChatGPTは「眼」を持った!? マジなマルチモーダルへの第一歩かも!!

クリスマスらしくシュトーレンをいただいてご機嫌な足立明穂ですw

やっぱ、クリスマスはシュトーレンでしょ!w

あ、今夜、無料ライブ配信やりますよ! なんたって13日の金曜日ですからね!w 下記のフォームからお申し込みを! 申し込んだ方だけにプレゼン資料をお渡しします!

それに、昨日は、ChatGPTやらSoraやらOpenAIのサービスが全部止まってしまうという大ハプニングがありました。ゾッとした方も多いのでは?w 本当にこわいですねぇ・・・・w

さて、12Days of OpenAIも6日目。半分まできました!! 今回はスマホのアプリですが、カメラで撮影して、その内容をリアルタイムに処理しています! 動画で、即、反応してるんですよ!!

これ、マジでマルチモーダルの第一歩を踏み込んでます!! すごっ!!

え? マルチモーダルって何って? それは、ChatGPTにきいてね!ってなことは言わないので、今回は、それも含め、何がすごいのか説明しますね!

例によって、まとめは、最後に掲載しておきますね!

ライブ動画はこちら

↓

https://www.youtube.com/live/NIQDnWlwYyQ?si=mXxCLkxwLcGVMvHW

最初は「お詫び」からスタート。そりゃそうだね。

最初は、プロダクト責任者のケビンから、昨日の数時間におよぶサービス停止についてのお詫び。

※サービスの状態は、https://status.openai.com/ から見れますよ

で、原因については、後日、発表があるそうです。まあ、一気に、アクセスが集中したってのもあるだろうし、連日、新しい機能をつぎつぎ、アップデートしてるから、いろいろありますわな。

とはいえ、企業では、日々の仕事の中にがっつり組み込んでいるところもあるし、セミナーで実演していた講師とか、授業で演習とかやろうとしてた先生とかは、焦りまくってたでしょうね。

5分や10分程度なら、「こういうこともありますよね・・・・」とか、なんとかなりますが、2時間以上止まってたとなると、もうお手上げですよね。

私も、企業や大学、病院関係者などの前で、ChatGPTで操作を見せながら何度も講演してるので、しっかりと、こういうときの準備はしてます。何百回も操作画面を見せながら講演してるので、経験値がちがいます!(って、自慢かよ!w)

ChatGPTが「眼」を持った!!

スマホでChatGPTのアプリを立ち上げて、カメラを起動。

この後のデモ、ビックリです!!(もうちょっとで、「びっくりぽん!」って書こうとした。若者ぶって、「そんなの知らないー」ってことでw)

動画の1分11秒辺りからですが、イン・カメラで、今回の出演者4名がChatGPTに自己紹介します。

その後の会話がすごい!

「私の同僚で、トナカイの角をつけてたのは、誰?」

「それは、確か、ショーじゃない?」

あ、私の英語力がてきとーなんで(^^;)、英語に強い人に、教えてほしいです!

というのも、上の動画のところ、なんかChatGPTの発音が、モヤモヤする(^^;

音声認識(YouTube字幕とか)は、ショーではなく、ミッシェルって変換するんだよねー。かなり惑わされる(^^;

特に、ChatGPTが回答するのが、「That will be Shaw.」って聞こえるのですが、発音が曖昧なのと、文字起こしなどでは、Michelleってなってしまう。たぶん、be Shawが、ミッシェルっていう音になっちゃうのかなと・・・ しらんけどーw (もっと英語力をアップしたい!!)

それは、さておき、自己紹介した人を覚えていて、でもって、その人の特徴から人物名を割り出すってすごくね???

これが、本当のマルチモーダルだって思います!!

マルチモーダルって何よ?

いきなり、マルチモーダルとか言われてもなぁってことかもしれないので、ChatGPTさんのざっくり解説。(自分で説明しないw)

マルチモーダルとは、AIが複数の種類の情報(音声、画像、テキストなど)を理解し、組み合わせて使える能力のことです。

例えば:音声を聞いて返事する。

画像や動画を見て内容を理解する。

スクリーンシェアを見ながら指示に応答する。

今回のChatGPTの新機能では、これを活用してビデオ通話や画面共有しながら、より自然で実用的な会話が可能になっています。

ChatGPTが出てくる以前にも、画像を読み込んで何が写っているとか、音声ファイルから文字起こしするとか、そういうサービスはいろいろありましたよね?

でも、それらのサービスは別々に動いていて、連動していなかった。で、これを組み合わせると・・・

画像 ー> 似たような画像検出

画像 ー> 何が写っているかテキストで出力

テキスト ー> 音声出力

これを組み合わせて、「お探しのものは子供用一輪車で、このようなものが販売されています」みたいな回答になります。

このレベルは、Googleレンズといったアプリでも、できた。

ま、これをマルチモーダルといえなくもないけど、ちょっと違う・・・

ここがすごい! ChatGPTのマルチモーダル!

今回のライブ・デモの動画を見て、「すげっ!」って思った点は、もう一歩踏み込んでいるところ。本当のマルチモーダルの第一歩に入ったって思ったのですよね。

自己紹介して、それが誰か、名前を答える!! ここ、すごいんですよ!

「え? 誰が写っているのかって、顔認証とかで、できるんちゃうん??」

と、言いますよねーw

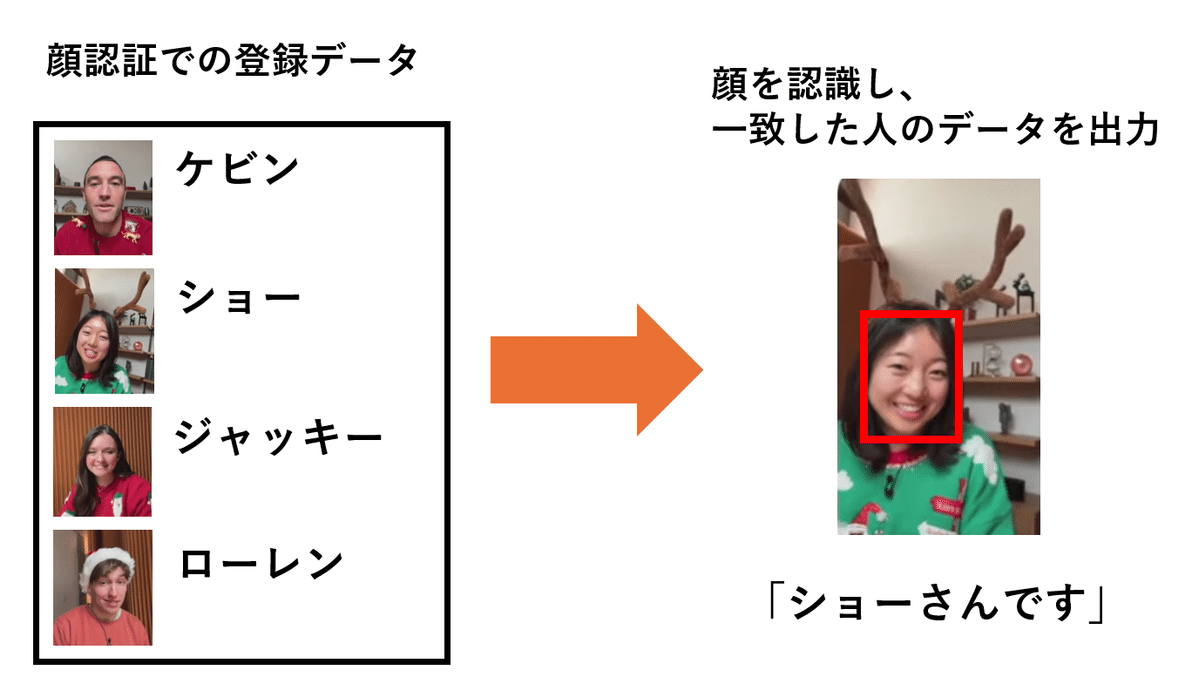

顔認証という単純なことではないんですよ。顔認証でやると、どうなるのか?

ステップ1 登録

カメラに顔を映して、名前を入力(名前をしゃべって、それを文字にして登録でもOK)

ステップ2 認証

カメラの前に立った人を認識し、登録データから一致した人の名前を表示(音声合成で読みあげてもOK)

ざっくり図解すると、通常の顔認証って、こんな感じ。

で、今回のChatGPTがやったことは、まったく違うんです!!

分かりました? 単に顔を覚えているのではなく、その人の被り物や服装などを覚えていて、でもって、画像の一致ではなく、言葉で言われた内容と一致する画像から判断するってこと!!

だって、ショーは、「私は、トナカイの角を被っています」なんて、一言もしゃべってない!!

ChatGPTの推論を推論すると(ややこしいなぁw)

「トナカイの角を被ってたのは誰?」

↓

トナカイの角? あー、こういうやつか・・・

で、これを被ってるってことは・・・

あー、これね! これこれ! で、この人の名前は・・・

そうそう! ショーさんだよね。

「ショーさんですよね?」

こんな感じです(あくまでも、イメージですw ほんとは、ぜんぜん違うけどねw そこを説明しだしたら、画像処理だの音声認識だのディープラーニングだのあれやらこれやら説明しなきゃならなくて、本1冊ぐらい説明しないといけなくなるので、略しますw 専門書を読むか、AIを教えてる学校に行って勉強してくださいw)。

って、もうちょっと説明してよ!って人のために、ChatGPTさんの解説w

今回の話って、マルチモーダルがすごいよ!ってことですよね? 単に顔認証ではなく、そこに写っている人やモノ、そして、それに関連する音声認識によるデータも合わさって判断して、回答してるから

その通りです!今回のやり取りは、いわゆる**「マルチモーダルAI」**の強みを活かした例そのものです。単なる顔認証や画像解析だけでなく、以下の複数の要素が統合されて判断・回答しています:

1. 視覚的情報(画像)「トナカイの角」という具体的な物体を視覚的に認識・生成しました。これにより、話題の中心となる物の具体的なイメージを作り出し、より深い理解や共有が可能になりました。

2. 言語理解質問や背景文脈から、「トナカイの角を被った人は誰?」という文章の意味を理解し、その質問に応じた回答を生成しました。

「Shaw」という名前に関連づけて、会話の流れやユーモアを反映した答えを自然に提供しました。

3. 文脈推論「Shaw」が人の名前であることや、トナカイの角が「クリスマス関連」の文化的文脈に結びつくことを理解しています。これにより、単なる情報処理ではなく、適切なニュアンスを持つ会話が可能になりました。

4. 統合された解釈単一のモーダル(テキスト、画像、音声など)だけでは捉えきれない、情報同士の関連性を考慮しています。

例:「トナカイの角」のイメージ生成と、「誰が被っているのか?」という問いへの答えを組み合わせることで、ユーザー体験を豊かに。

5. 感覚的価値の追加「トナカイの角の画像」を生成し、ビジュアルとテキストの両面で楽しさや直感的な理解を加えました。これが、単に言葉だけの会話とは違う付加価値を生んでいます。

結論:マルチモーダルの力

**「マルチモーダルAI」**は、複数の感覚(テキスト、画像、音声など)を活用して、より豊かで意味のある体験を提供できる点が大きな強みです。今回のように、質問に答えるだけでなく、画像生成や文脈の理解が組み合わさることで、まるで「本物の会話」をしているかのような流れを作り出せます。これは、従来のAIでは難しかったことですね!

技術的な進歩を感じられるエキサイティングな例でした! 😊

マルチモーダルが本気で稼働するようになると、とんでもないことになる!

んじゃ、このマルチモーダルが進んでいくと、とんでもないことになってきます。

どうなるのか? ちょっと先の未来を想像してみましょう。

マルチモーダル家政ロボット「モダルくん」の奮闘記

西暦2035年、AIロボットが当たり前のように家庭に導入される時代になった。料理、掃除、洗濯から、ちょっとした会話の相手まで、彼らは人間の生活を快適にする頼れる存在だ。そんな中、とある家庭に導入された最新鋭の「マルチモーダル家政ロボット」、通称「モダルくん」の奮闘の日々が始まる。

昨日のアレ

「ねえモダルくん、昨日のアレ、持ってきてくれる?」

朝のキッチンで、主人の翔太がコーヒーをすすりながら、曖昧極まりないリクエストを投げかけた。

「承知しました!」

モダルくんの目が青く光る。彼は内蔵された超高性能のマルチモーダルシステムを駆使して、昨日の翔太の行動を素早く検索した。

「昨日のアレ、ですね?」

翔太が昨日訪れた場所:大阪の通天閣。

購入したもの:冷凍たこ焼き。

翔太の発言:「これ、家で食べるの楽しみだな!」

モダルくんは一瞬で結論を出した。「アレ」は、冷凍たこ焼きに違いない。

モダルくんは冷凍庫に向かい、冷凍たこ焼きを取り出した。そして、電子レンジにセットし、適切な加熱時間を計算。

チーン! 出来上がった!

お皿に盛られたアツアツのたこ焼きを持って、モダルくんは満面の笑み(AIなので実際には無表情だが、翔太にはそう見える)でキッチンに戻ってきた。

翔太は驚いた顔をして言った。

「すごいな! 俺、たこ焼きのことなんてひとことも言ってないのに、よくわかったね!」

「翔太さんが冷凍たこ焼きを見つめる姿、楽しそうでしたから。お好みでマヨネーズもどうぞ!」

掃除は猫用おもちゃで?

しかし、完璧なロボットにも失敗はある。ある日、妻の真奈美がこう頼んだ。

「モダルくん、アレをお願い!」

モダルくんの目が青く光る。

真奈美が昨日言っていたこと:「掃除が大変」

昨日の行動:ペットショップで猫用おもちゃを購入。

モダルくんの結論:「掃除を手伝うため、猫用おもちゃが必要だ!」

モダルくんは猫用おもちゃを手にして真奈美の前に立った。

「真奈美さん、お掃除なら、これが必要ですよね!」

モダルくんはドヤ顔(AIなので実際には無表情だが、真奈美にはそう見える)で猫用おもちゃを床に置いた。

真奈美は呆然として言った。

「なにそれ!猫のおもちゃでしょ! 掃除機を持ってきてほしいの!」

モダルくんは、泣きそうな顔になって(何度もいうが、AIなので実際には無表情だが、真奈美にはそう見える)で、平謝りした。

「申し訳ありません、次回はもっと正確に判断します!」

モダルくんが家庭に導入されて1年。翔太と真奈美にとって、彼はもはや欠かせない存在になった。

モダルくんは、言う。 「いつでもお任せください。ただし、『アレ』が何なのかだけ、もう少しヒントをいただけると助かります!」

笑いの絶えない家族となった。

ChatGPTさんのざっくりまとめ!

動画で何を話してるのか気になると思うので、ChatGPTさんにまとめておいてもらいましたw

以下は、OpenAIのDay 6ライブの要約です。

1. ダウンタイムへの謝罪と対応

昨日数時間のダウンタイムが発生したことを謝罪。

チームが詳細な原因分析(ポストモーテム)を進めており、後日公表予定。

現在は全。能が復旧済み。

2. 新機能の発表

ビデオとスクリーンシェア

Advanced Voiceモードにビデオおよびライブスクリーンシェア機能が追加。

ユーザーがリアルタイムでビデオや画面共有を通じてChatGPTと対話可能に。

デモでは以下が紹介された:

音声モードでの自然な対話(50以上の言語対応)。

ビデオ通話での実演(例:コーヒーの淹れ方を教える)。

スクリーンシェアを利用してアプリ内のメッセージの返信を支援。

サンタとの対話

12月中、ChatGPTで「サンタ」と会話可能に。

サンタに質問したり、物語を聞いたりできる。

サンタは特徴的な「陽気な声」でリアルタイムに応答。

アクセス方法:ホーム画面のスノーフレークアイコンまたは設定から。

3. 機能提供スケジュール

ビデオとスクリーンシェア:

今日から最新のモバイルアプリで順次展開。

Plus/Proユーザーには来週までに全機能提供予定。

教育機関や企業プランユーザーには2024年初頭に提供開始予定。

サンタ機能:

全世界で今日から順次提供開始。

音声モードを使用可能なすべてのプラットフォームで利用可能(モバイル、デスクトップアプリ、ウェブ版)。

4. ライブデモとユーモア

サンタとの会話デモでは、以下が行われた:

サンタの好きな伝統やトナカイについての質問。

サンタの「クリスマスジョーク」(例:エルフの好きな音楽は「ラップ」)。

チーム全体(エンジニア、研究者、PMなど)への感謝を表明。

5. 総括

新機能がユーザーにとってさらに便利で楽しいものになることを期待。

今後の利用例やユーザーからのフィードバックを楽しみにしているとコメント。

このライブでは、ChatGPTの新しい可能性が示され、特に「マルチモーダル」の機能強化が強調されました。

最後まで読んでいただいて、ありがとうございます!

この記事のスキをクリック、コメントをいただけると、励みになります!!

応援、よろしくお願いします!

P.S.

繰り返しになりますが、今夜、無料ライブ開催! 詳しくは下記で!