AI人材育成講座 第3回 統計入門

「数字は嘘をつかないが、嘘をつく奴は数字を使う」

AIは広義の関数である。

今回の要点はここ。

何かの「Input」に対して、「AIという関数」が関わりその関数を介して出される安定した「Output」を作る

プロンプトと指示(インプット)をAIが食べて(関数)、ユーザーの欲しい情報(アウトプット)を出す。この構造を理解する。

そのアウトプットが有効であるものかを知るために「統計」という手法を学ぶ。

AI人材育成講座で得られるべきAIとは、人が行なっている業務を俯瞰し、

Input→人の作業→Output

↓

AI

この構図を作ること。

今、ChatGPTにより、統計学を学ぶハードルがめちゃくちゃ下がった。

統計を学ぶ上でも、計算という実践をChatGPTが代用してくれるので、今回の講座で実際に手を動かすことで統計という「知識」から「実感」に変わった。

前回の質問と回答

RLHFという考え方がある。強化学習をすることで、より良いアウトプットを出すものが、ChatGPTでもう実装されていく。日常使いではいいねボタンなどで指示することでより強くすることができる。

アプローチの名前を頑張って覚える必要はなく、出てきた答えが正しいかを評価できること重要。

勉強の仕方が大きく変わった。

Chat GPTが今の状態で良さそうなものを提案してくれるようになったので、その提案を確認し、自ら学ぶことで必要な部分の強化学習できるようになった。

今まで何かやりたかったら

まずはそれについて学ぶ→実際にやってみる→検証

の流れが必要だったが

まずは

AIに実際にやらせてみる→必要最小限の知識を教えてもらい学ぶ→検証する

この流れに変えていけば、必要最小限の勉強ですぐにアウトプットが得られるようになった。

プロンプトのコツは、スペシャルなプロンプト方法(プロンプトエンジニアリング)を学ぶのではなくて、現実を知らない相手に必要十分な量の情報を与えてあげることが大事。

それには、音声入力で入力することで、よりたくさんの情報を入れることもできるし、一回で入れ込むのではなくて何度も壁打ちしながら入れていく方が遥かに重要。

どんなに仕事が属人化していたとしても、必ずインプットとアウトプットがあり、その「属人化」を分解し、AIでできるところ探していくことをやってみよう。

統計学を学ぼう

統計学とは、データから有益な情報やり式を抽出し、「データに基づいた意思決定」や「問題解決」に活用する

データ:ただのセンサーから入ってきた数値

情報:得られたデータから持ってきた集約されたものどこに情報が集中しているか?そういうグラフが出来上がる

知識:グラフや情報からわかること。ただの情報から考えられる傾向

洞察:知識をもとに仮説を立てる。知識の中からその傾向などを考えて仮説を考える。

知恵:その洞察から、新たな施策を考える、叶えるための施策になる。

統計学は、主観や第六感などを排除した数字で示す。

誰もが標準的な意思決定を下すことができる。誰でも同じように結果を出せる普遍的なものである!

アナログからデジタルに変わることで一番はの進歩は、試しに作ってみる。

試すということが非常にローコストに実現できるようになった。

人間の直感的なのもを、AIが再現する時代が来ている。

デジタルも、統計もその向こう側に人がいる「人間に対して最も良い形を作っていく」

より人間が人間らしいことを実現するための方法論として「デジタル」「統計」がある。

19世紀ロンドン、これらの大流行があった。ロジカルシンキングでは、不衛生な環境がこれらの流行と関わると考えた医師らはテムズ川に汚染物質を投棄し、街をきれいにした。

その結果。

感染者が増えた。

徹底的にユーザーインタビューをしたジョン・スノウ

水道会社の違いが、これらの死亡者と相関があることに気がついた!

最初から仮説を立てるのは危険。まずは一通り可能性のあるものを全部集めていかないと、ロジカルシンキングや、普段の直感からの発見を取りこぼしてしまう可能性がある。

A社とB社は川の上流下流の違いがあった。

「川の汚れが、これらの流行に関係している!」

まずは徹底的に情報を収集し、その中で相関関係、因果関係を見つけ出すことが最初になってくる。

仮説を立てるのはデータを集めてから。

ただし、データを集め続ければ、コストがかかる

データが少なければ統計できなかったり、主観が混じってしまう。

そのためには「総当たり」をするコストと、その期限も含めてバランスを取っていく必要がある。

統計学の基本的な考え方

エゴを殺してデータを集める。集めたデータを客観的に対応する必要がある。

自殺(オレンジ色)の「人数」が多いのは20代が多いのか?

これは「割合」のグラフであり、「人数」のグラフではない

20代が死亡絶対数が違うので、「割合」では多いが「人数」は少ない

これの解釈の結果「20代を重点的に自殺対策をしたら、自殺者数が減る」は解釈間違いで、実際に「人数」が多いところにもしっかりと届く対策が必要。

何を見たいのかで、使うべき統計を考えていく。

大谷翔平を入れることで、花巻東高校出身者の「平均年収」がバカ上がりした。

中央値で取ると、ほとんど変わらない。

花巻東高校出身者の実情という意味で使う統計は「平均値」でいいのか?

求めたいOutputによって考えていく。

分析方法があるか解析するのではない。

InputとOutputの関係性を求めるときに必要な「関数」は何か。

「結果」「欲しいもの」から考えて手法としての統計(将来的にAI)をつかう。

推定

「サンプルサイズは少ないけれども、全体像を知りたいときに使う」

推定の例

インフルエンザの定点観測

選挙の出口調査

アンケートから、商品の欲しいかどうかを調べるなど

全部のものを調査するには、現実的でないものを、目に見えている少ない数を調べることで全体像を推定するときに使う

これを「意思決定」に使っていく

顧客になりうるターゲットが何万人もいる中で、10人でいいのか?

人数が多いほど多い程正確になっていく。本当に人数が多い方が確からしいのか?

母集団:商品のターゲットになりうる集団

標本集団:今回ターゲットの中から取り出した、アンケートとれる人たち

これらの平均「母平均」を「標本平均」から推定では、本当にそれが母集団の平均とぴったりなの?そういうわけにはいかないので

「確からしいのはこの範囲!」としてあげる=信頼区間

95%信頼区間とは

今回得られた「標本平均から得られる信頼区間」の中に母集団の平均が収まる確率が95%です!ということ

実際にやってみる。

母平均は3.7。母集団の平均が(2.87-4.53)の間に入る確率が95%です!

1.7位はばがありますね。

アンケートの結果の数を増やしてみる。

母平均3.7

95%信頼区間(3.63-3.77)。信頼区間が0.14と小さくなった!

サンプルが大きければ大きいほど、母平均のランダムな幅が迫り、正解までに近づくことができる。

信頼区間の設定は業種によって変わっていく

医療は95%が多い

製造業は99%が多い

どういう意思決定に使うかで信頼区間を設定する。信頼区間の設定が厳しくなればなるほど、答えで出てくる信頼区間は広くなりますね。

これは台風の起動予測です。進むごとに台風が大きくなっているわけではない。遠くの日時で予測される「軌道の95%信頼区間」である。

→この円の中に台風の起動が収まるのが95%である

ということを示している。

サンプルの偏りに関して

偏ることは十分ありうるので、より偏らないようなサンプルの取り方を考える必要がある。ネットだけではなく、現場も、電話もいろいろな方法からサンプルを撮ってくることが望ましい。

仮説検定

あらかじめ仮定を立ててその仮定が正しいかを検証する

仮設検定の例

暑い日はオレンジジュースの売れ行きが良い(仮説)正しいかを検証

気圧が低いと喘息が多い(仮説)正しいか検証

寒い地方の方が、女子高生の足が太い(仮説)正しいか検証

ボタンAの時の方がボタンBの時の方よりクリック数が多い(仮説)正しいか検証(両方試すことでA/Bテストに)

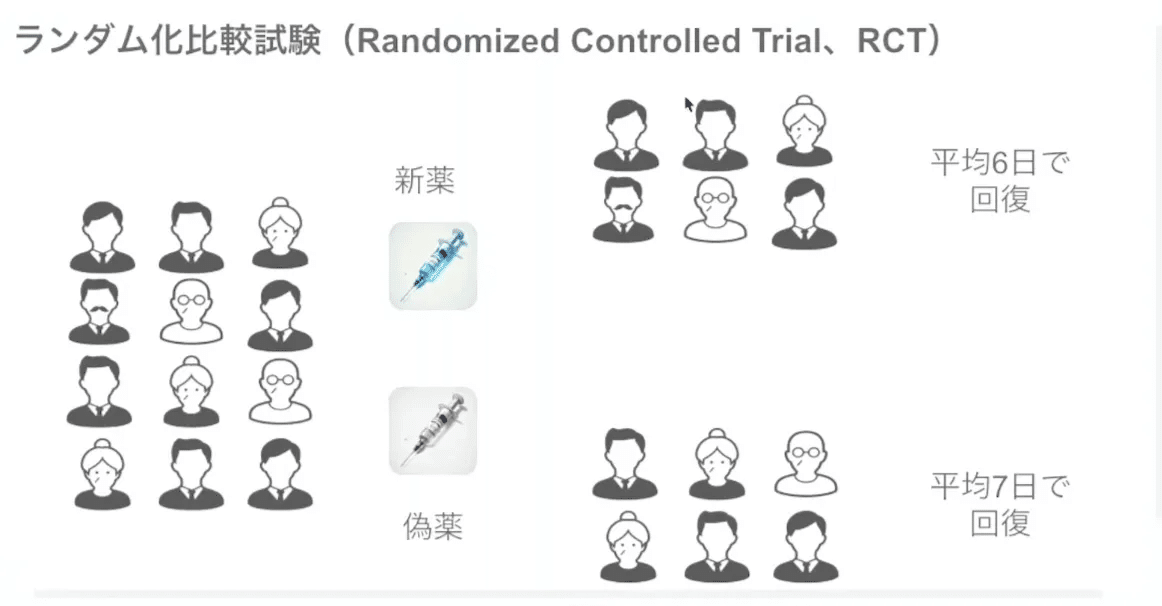

仮説を検証するためには、「検証したいもの以外、可能な限り全てを一致させる」

→今回は偽薬を投与することで、「薬が打たれたから、治った気がする!」というような要素を少なくする

仮説:新薬を使ったグループの方が、偽薬仕様のグループよりも回復までの日数が短い

有意水準を決める:有意水準は大体5%に設定する経験則で決まっている。

検定方法を決める:t検定を使用する(ここは色々ある。)

p値を計算:間違っている確率これが小さければ小さいほど、仮説の証明に近づく(たまたま仮説の反証になる確率のことを指す。これは、基準値を5%を下回っていれば証明ってことでいいよね!って話になる)

仮説の確からしさを確認する:この結果が正しいかどうかはどうやって確認する?それは人間の目で正しいかどうかを考えていく必要がある。

ChatGPTでやらせると、結果に忖度する可能性があるので、

必要なプログラムをChatGPTに作らせて、Colabにやらせることで結果をより客観的に出すことができる。

t検定レベルであれば、もう統計ソフトは必要なさそうですね。

統計は、勘・コツ・経験を上回ることがある。

関数

最後の10分で一番大事な概念の話がぶっ込まれてきてびっくり!

何かをInputすると、決まった法則のもとにOutputが出る

これが「関数」である。

AIがなにをやっているのか?

何かしらのインプットを「数値に変換」→何かしらの法則→数字でアウトプット→何かしらの法則を基づいた回答を生成

これから我々がやるべきことは

1)人がやっている作業をしっかりと観察し、InputとOutputが何かを抽出する。

2)InputがどうやってそのOutputを産むのか、その法則を見つけだす(統計を用いて、概ねトレースできる程度の解析をする)なぜそうなるかはわからなくてもいいが、トレースできる法則を見つけ出す。

3)法則をトレースできるAIを考える、作る

3)InputとOutputが機械で自動にできるようにする

ここを目指していく。AI=「関数」と考えると、非常にシンプルで分かりやすい内容だった。