ノーベル物理学賞(2024年)をクールに語ろう! その2

⇧ の続きいきます。ホップフィールド・ネットワークについて、補足的なことを述べます。

以下はノーベル賞委員会による解説からの引用。Hopfield network とありますね。

これがその後 Bolzman Machine(ボルツマン・マシン)→ Restricted Bolzman Machine(制限付きボルツマンマシン)に発展していくわけですが…

その解説に進む前に、これについて、もそっと語ってみようかと思う次第でございます。

このポップフィールド・ネットワークは、一言でいうと "記憶との照会マシン" です。

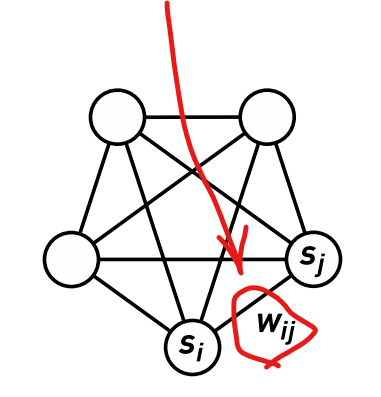

前回説明したこれ。「重み」(weight)といいます。

この「$${w}$$」は、各ニューロンを結ぶすべての線について存在していて…

こんな風に、行列で表せるのです。

.

さらにすごいのは、このごっつい5×5行列のなかに、二つの情報が記憶されているのです。

パターン1: [1,−1,1,−1,1]

パターン2: [−1,1,−1,1,−1]

おっと、「わけわからん」という皆さまの声にならざる声をたった今、私の前頭葉がキャッチしてしまいました。

どうしよう…もっと簡単にしちゃいましょう。

WORDでのお手製なので、線が細すぎるとか薄いとか、そういう文句は今はぐっとこらえて私のありがたいお話を傾聴するように。このネットワークの場合、重み $${w}$$ を行列化すると…

この行列のなかに、二つの情報が仕込まれています。[1,−1,1] と[−1,1,−1] の2つの情報が、この行列内に「記憶」されています。

試しにこの行列 $${W}$$ に [1, 1, 1] という情報を、放り込んでみると…

[0, -1, 0]

…が出力されます。(前回説明した関数 $${h_i=∑_{j≠i}w_{ij}s_j}$$ に出てくる $${w_{ij}}$$ の総体が $${W}$$)

これを再度、同じ行列 $${W}$$ に放り込むと、今度は

[1, 0, 1]

…が出てきます。(関数 $${h_i=∑_{j≠i}w_{ij}s_j}$$ を介するとこうなる)

こうやって何度も行列 $${W}$$ に放り込みなおしていくにつれて…

[1, -1, 1]

に収斂します。ここから先は何度同じ放り込みをしても、これが出てくるので、ここから先はもうない、すなわち収斂するというわけです。

計算の過程をお見せすると、長い式が長々と並ぶのでここでは省きます。(いちいち計算の過程をブログに入力するのめんどくさいし)

要は $${1}$$ と $${-1}$$ の二進数的組み合わせは、上でお見せした重み行列に放り込むと、最終的に必ず [1, -1, 1] か [-1, 1, -1] に収斂するという事実を、理解できればそれでよろしい。

これって何かに似ていると思いませんか?

手書きのアラビア数字を、機械が読み取る仕掛けですよ。

.

もし郵便番号の欄に、手書きでめちゃくちゃな文字を書き込んでも、ホップフィールド・ネットワークの仕掛けを応用すれば、最終的には必ず 0 から 9 までのどれかのアラビア数字に仕分けしてくれると、そういう風に理解すれば、腑に落ちていただけると思います。

むろん実際は、ニューロンが三つや五つどころか、もっともっとたくさん要るわけですが、増やせば増やすほど「記憶」パターンが増えていくし、どの記憶パターンに最終的には当てはまる(収斂する)かの精度も、上がっていきます。

記憶と照合という生物学的機能を、ごく素朴な関数とネットワークで再現できてしまうこの研究は、発表当時(1982年)には衝撃的でした。

近いものは十年ほど前に、日本の学者さんも提示していました。しかしシンプルさではホップフィールド教授のものが際立っていました。

こんな素朴なしくみで、記憶と照合を演算機械で行えてしまうのか、と。

*

このモデルは、溯ると磁性体の研究までさかのぼれます。前回説明した、フランスの科学者ピエール・ワイスによる研究です。1907年。

物理学では「スピン」がよく出てきます。自転のことですが、20世紀に入ってからは、自転していなくてもスピンと名付けることが増えていきます。仮想的な自転のことです。

量子力学の発展とともに、その謎が解けていきました。こんなのです。

語りだすと長くなるので省きますが、1940年にこういうのが提唱されて、それがさらに40有余年後に、ニューロンネットワークつまり人工知性の研究に応用されて、同分野の発展におけるマイルストーンとなったのは、興味深いです。

*

.

ただこのホップフィールド・ネットワークには学習機能はありません。記憶と照合をこの仕掛けで行わせるには、事前に重み行列 $${W}$$ を計算して仕込んでおかないといけないのです。

仕込みではなく、自動的に「学習」する仕掛けは作れないものか?

その野望の基礎石となったのが、次回解説する「ボルツマン・マシン」です。

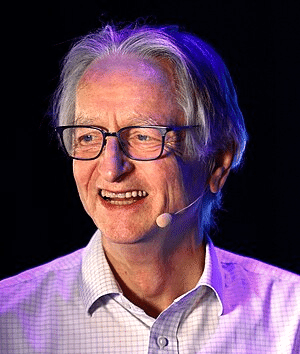

提唱者はジェフリー・ヒントン(Geoffrey E. Hinton)。「ディープ・ラーニング(深層学習)のゴッドファーザー」とも称えられる巨人です。

昨年 Google の研究所から離れた方です。「AI の危険性についてもっと大っぴらに語りたいから」という理由でした。

ノーベル物理学賞が彼に授けられることになったいきさつも、そのあたりに委員会の真意があるのではないかと、私は想像しています。

.

つづくよ

.