ノーベル物理学賞(2024年)をクールに語ろう! その9

その8から続く。今回のお題は、制限ボルツマンマシンについて、です。

その前にボルツマンマシンについて、もう少しお話しておきましょう。

○のうち二つが、色分けされていますね? これは「隠れ層」を表しています。(ちなみに ○のままなのが「可視層」)

どう違うのかというと…うーんここはお話で説明したほうが分かりやすいかな。○は「好きな映画」について、●は「映画の好み」についての演算を司っていると思えばいいです。

Amazon で何かお買い物をしていくと、購入履歴や閲覧履歴をもとにして、お勧め商品が表示されますよね。あれです。●は「ああこいつはきっと好みがあのへんにあるな」と推測する部位であります。

いろいろ使い出がいいわけですよこの「隠れ層」って。

ただ難点がひとつあって、演算が大変なのです。上の絵ではノードが五つしかないので大したことないと思われるでしょうが、これが 50 とか 100 とか 1000 とかに増えていくと、いやおうなしに演算の手間が増えていきます。

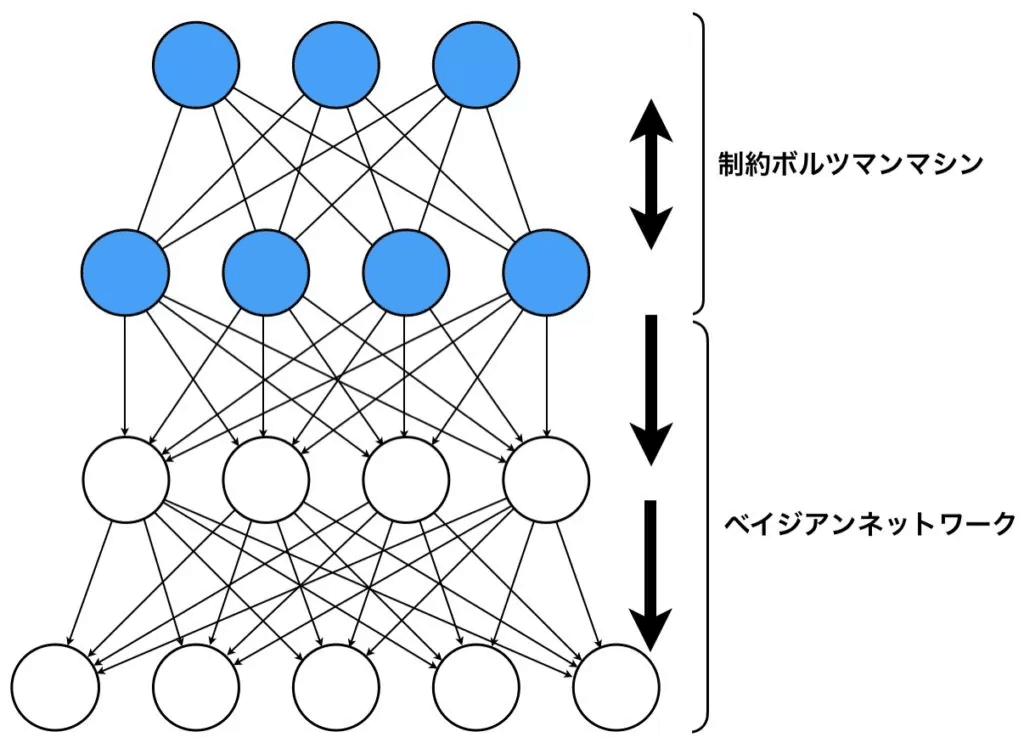

そこでどうするかというと、隠れ層と可視層の二つにばっさり分断して、同じ層のノードどうしはリンクしない(つまり演算させない)ようにすると…

こうすると演算の手間が大幅に軽くなるのですよ。

これが制限ボルツマンマシンです。

1986年当時のコンピュータの性能は、今の目でみたらおもちゃみたいなものでした。ボルツマンマシン(上の図の真ん中のもの)はノードが増えるともはや支えきれなくて、それでもっと簡便な、この制限ボルツマンマシンが発案されました。

一度はこの工夫、過去のものとなっていたのですが2006年になって「制限ボルツマンマシンを多層でつないでいったらどうやろ?」という研究がなされました。

2006年のことです。鉄腕アトム誕生より三年目のことでした。

ディープラーニング(深層学習)です。

ジェフリー・ヒントンが1980年代よりこつこつ研究してきた、その成果です。

2012年に、画期的なことがありました。

画像認識コンテストの2012年大会で、彼のチームが開発したアルゴリズムが、二位以下を引き離しての優勝を果たしたのです。

これをきっかけにディープラーニング(深層学習)は時代のキーワードとなりました。

翌2013年には、彼が率いる開発企業が、あのグーグルに吸収されました。ヒントンとそのチームを買い取ったのですグーグル。

2018年には、電子計算機研究のノーベル賞ともいわれるチューリング賞を授けられています。「AIのゴッドファーザー」という尊称が世に広まったのもこの頃からですね。

昨年(2023年)グーグルを離れました。今のAIの発達進展を見るとむしろ害をなすのではないかと彼は前から懸念していて、そういう懸念の声を大っぴらにするためにもグーグルから離れたいと、そういう意志からの退社だったようです。

今年(2024年)にノーベル物理学賞委員会が、彼を選んだ理由もそのあたりにあるのでは… と私はみます。

*

ところで今回の受賞にあたって、ホップフィールドとヒントンにくわえて、もうひとり受賞すべきだった日本人科学者がいる~!という声をあちこちで見かけます。アマリですね甘利。甘利俊一。

彼はどうして外されたのか? そのあたりの謎解きを、次回より自己流ながら挑んでみようと考えています。

つづくんや~