iPhoneの生成AI性能はすでに十分すぎるかもしれない

iPhone iOS18の目玉であるアップル版生成AI、Apple Intelligenceについてのレビューが海外サイトを中心に多く出ている。ざっくりまとめると「まだまだ」「期待はずれ」なのだけど、機能としてはOSの根っこに入り込んでいることがわかり、逆にいえば「伸びしろたっぷり」だ。他社が「OSに生成AIアプリをバンドルした」「OSからクラウドの生成AIにチャットできるようにした」くらいで「AI搭載OS」を名乗り株価あげてきたのに対し、アップルはAIをちゃんとOSに統合しようとしている。

さて……「生成AIの処理速度のボトルネックはメモリ帯域幅」と、1万回くらいとなえてきたので、iPhoneについても触れてみる。そのうえで、Apple Intelligence目当てでiPhone 16を買っていいのかも考えてみる。

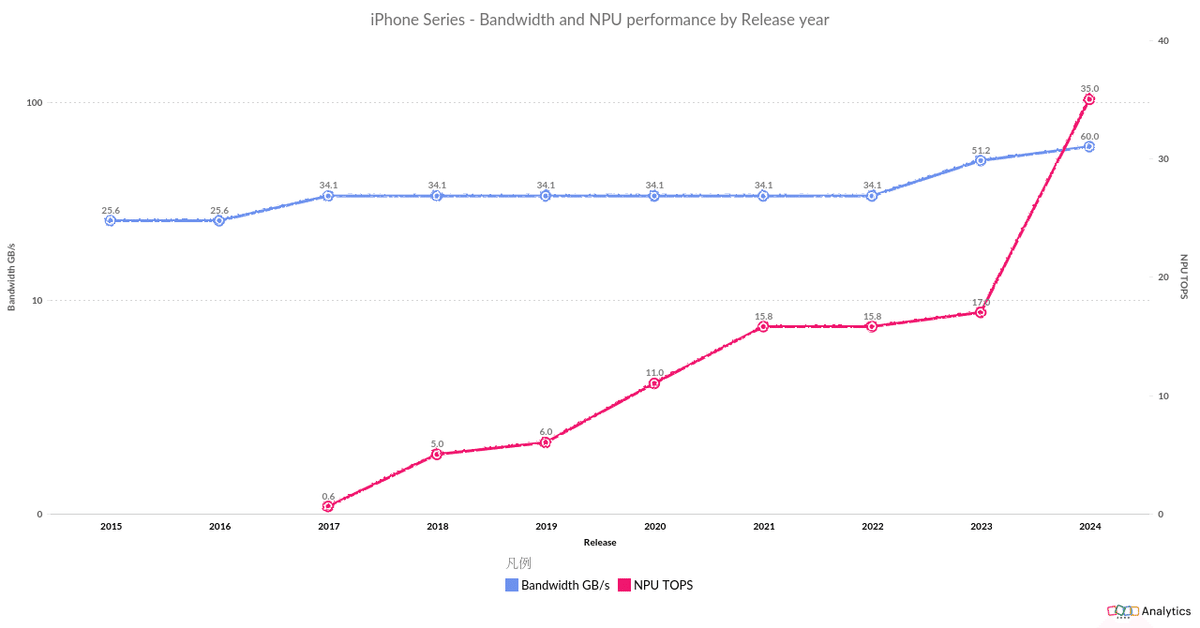

まずは、歴代iPhoneのメモリ帯域幅の推移だ。図で、iPhone 3GSからiPhone 16までのメモリ帯域幅をあらわした。縦軸がメモリ帯域幅を「対数」であらわし、横軸はiPhoneが発売された年、円の大きさは迷ったがメモリ容量とした(が、あまり意味はない)。

かつてのiPhoneのメモリ帯域幅は2世代、つまり2年で2倍になっていた。新たに採用するメモリ規格はことごとく「業界初」で、すべてのスマホはもちろん、チャネルあたりの帯域幅ではハイエンドパソコンさえリードしていた。

その進歩は10年前から突然停滞する。2015年に出たiPhone 6sの25.6GB/sがその倍の51.2GB/sになるには、2023年のiPhone 15まで待った。8世代だ。2017年のiPhone Xから2022年のiPhone 14にいたっては、6世代にもわたってまったく同じメモリ帯域幅だった。メモリ容量だけがじわじわと増えただけで、それさえ変化がなく、カラバリ増やすだけでしのいだこともあった。

このあたりから、新しいiPhoneの発表にがっかりしたり、興味ないわーってひとが増えたようにも思う。実際、根っこは速くなっていなかったし、それゆえ新しい機能を加えるゆとりもなくなっていたのだから、仕方ない。

もちろん、その間にもカメラ性能は格段に進化した。デザインが角ばったり、ワイヤレス充電のMagSafe、USB-C対応など「スマホの性能とは関係ない」変化を別とすると、iPhoneはそのカメラ性能の向上とあわせてNPU(アップルはNeural Engineと呼ぶ)の「AI性能」もあげてきた。

図で、iPhoneのメモリ帯域幅の拡大が停滞してからの、NPUのAI性能(TOPS:1TOPSで秒間1兆回のAI推論を実行する)の変化とあわせてみる。ピンクがNPUのAI性能だ。

メモリ帯域幅が停滞する一方で、NPUによるAI性能は劇的にアップしてきた……ように見えるが、本当にそうだろうか。

iPhoneにNPUが搭載されたのは2017年のiPhone 8(A11)世代からで、同世代のiPhone Xで初めて採用されたFace IDのために開発された。Face IDを実現するには、3万点を超える赤外線ドットを顔に照射した結果を、超並列かつ超低消費電力かつ超リアルタイムに処理する必要があった。NPUは指紋認証のiPhone 8でも使われていた...…のだけど、ミー文字(Animoji)でカメラがとらえた顔の表情を認識しているのがNPUってだけだった。

iPhone X/8のNPUは2コアで0.6TOPS(毎秒6000億回のAI推論ができる)だった。翌年のiPhone XRやXsではNPUのコア数が一気に4倍の8コアに増え、5.0TOPS(毎秒5兆回のAI推論ができる)に達した。iPhone 11におけるNPU性能向上は限定的だったが、2020年のiPhone 12でNPUのコア数を16コアに倍増させ、それ以来AppleシリコンのNPUはこのコア数のままだ。

つまり、2020年のiPhone 12 mini(A14)も、同じ年のM1 MacBookシリーズも、そして、2024年の「M4 Maxを搭載するMacBook Pro最上位モデル」だって同じNPUコア数だ。

同じコア数にもかかわらず、iPhoneのNPUはiPhone 14(A16)からiPhone 15 Pro(A17 Pro)で17TOPSから35TOPSに「性能倍増」する。とはいっても、コアあたりの演算ユニットを2倍にするなどのGPUでは一般的な方法はとっていない。技術的にはできたとしても、超低消費電力とバッテリースペースを確保するためのチップ小型化が最優先のiPhoneでは採用できない。プロセッサーやメモリなどの演算リソースが同じでも、それまでのFP16と変わらない精度の推論を2倍の処理速度でこなせるINT8の実装で実現したのだ。

まあ、発表資料やスペック表での「AI性能」はマーケティング要素がほとんどで、クアルコムのスマホ用SoCやNVIDIAのデスクトップ用GPUは(INT8のさらに倍の速度になる)INT4を用いている。業界として「TOPS出すんならINT8で統一する」といった記事をみた記憶もあるが、ちっさく注釈つければINT4でもOKといった抜け道もあるのだろう。

ともかく、FP16を使う高品質な画像生成AIなどの場合、アップルのNPU性能は4世代にわたって横ばいとなる。発表会では毎回「驚異的なパワー」を繰り返しているが、この点では、そう、やっぱり何も進化していない。

で、オンデバイスAIであるApple Intelligenceが使えるのはiPhone 16からだ(スタンダードモデルの場合)。iPhoneのAI性能が進化していないのに、ある意味、突然変異的にあらわれた生成AIなんかが動くのだろうかと、私でさえ疑問に思う。電源(バッテリー)に余裕のあるiPadやMacBookであれば絶対性能の高いGPUをぶん回せばよいが、iPhoneはNPUだけで生成AIを処理しなければならない。

結論としては「大丈夫そう」だ。LLMのようなテキスト生成はもちろん、Apple Intelligenceでは「AI美女のような」FP16を必要とする高品質なAI画像生成はしない(ポリコレとかいろいろあって「させない」し、クリエイターからの反発も大きいだろう)から、NPUでINT8が使えるiPhone 16で十分な速さなのだ。

動画は、私の2年半前のノートパソコン(Dell Inspiron 16 5625)の「CPUだけ」でLLMを動かしたものだ。モデルはGoogle Gemma 2の9b(90億パラメーター)を使っていて、サイズは5.4GBだ。

実は……動画は4倍速に編集してある。iPhone 16のApple Intelligenceでは、少なくともこのくらいの速さで処理するだろうと考えての4倍速だ。

ノートパソコンのCPUであるAMD Ryzen 5 5625UはAIに強いAVX-512命令に非対応ゆえ(次の世代から対応した)、すべてのAI推論をFP32で実行している。ざっくり言うとINT8の4倍の遅さだ。そして、6コアで処理をしても3コアで処理しても同じ遅さで、2コアまでしぼるとやっと、もっと遅くなる。LLMのAI推論では、CPU 3コアだけでメモリ帯域幅を使い切れてしまうわけだ。

GPUだって同じ傾向だ。NVIDIAのGPUは電力食いだけど、生成AIの推論処理では「半分の電力で動かしても、処理速度は15%低下にとどまる」。LLMに関してはデータセンター用の比較で、より精緻な、だけど難読性高めの検証結果も出ている。厳密な動きの変化やボードごとの差異はともかく、現象からは「半分くらいの演算能力でメモリ帯域幅を使い切っている」と推察され、それ以上は空回りで電力のムダなのだ。

iPhone 16のメモリ帯域幅は60GB/sで、私のコスパ最優先のノートパソコンの51.2GB/sを上回っている。もちろん、iPhoneだってメモリ帯域幅がボトルネックだ。iPhone 16のNPUが備えるINT8はFP32と比べて、同じリソース、つまり同じメモリ帯域幅と同じ処理能力で4倍の速さでAI推論ができる。さらに、モデルをメモリを食う9b(90億パラメーター)ではなくスマホ向けにより最適化された2b(20億パラメーター)にすると、倍速どころではない。そのうえ、アップルのNPUは1Wほどで動き、超エコだ。

ちなみに、生成AIでは9bや2bといった「専門用語のようなもの」が説明抜きで出てくるが、9 billion(billionは10億)パラメーターの略……という説明でよいのだろうか。人間の脳は100兆パラメーター。MacBook ProのM4 Maxは「200b(2000億パラメーター)のLLMを、学習でも推論でも、かんたんに扱える」がウリだから、つまりは「人間の脳の500分の1だよ」ってことでもある。

あとは、改めて書くまでもないが、生成AIの処理速度を推測するのにTOPSはあてにならない。逆に、メモリ帯域幅とどんな演算をするかだけで処理速度は推測できる。「AI推論で実際に使うメモリ帯域幅の使用率」も影響するが、これはアップルの現時点の弱みかもしれず、でも見方によっては強みかもしれず、考察としてもホットな話題なので別にまとめる。

ともかく、iPhone 16のApple Intelligenceは、日本語でも動画より速くAI処理ができるだろう。これで十分すぎるくらいで、進化する必要がなかったのだ。「アップルはiPhoneのAI性能をどんどん上げて差別化する」といった記事も見かけるが、先に述べたように、そんなのはムリだ。iPhoneのこれからのメモリ帯域幅アップは当面はせいぜい10%ほどで、INT4の実装でバックグラウンドタスクであるテキスト処理の飛躍的な性能アップがあっても、そのメリットは体感できるものではないだろう。

というわけで、iPhone 16、そして来春の発売がうわさされる新しいiPhone SEは、突然変異である生成AIにオンデバイスAIとして対応できるスタンダードなスマホといえる。私用はもちろん、両親のiPhoneも新しいSEが出たタイミングで切り替えようと思っている。