ComfyUI HunyuanVideo FastVideoで高速生成ができた 6stepsなら3分も

HunyuanVideoの高速化について、色々調べてみると、FastVideoってのを見つけました。

この中のUsageを見てみると、

Usage

Clone Fastvideo repository and follow the inference instructions in the README.

Alternatively, you can inference FastHunyuan using the official Hunyuan Video repository by setting the shift to 17 and steps to 6, resolution to 720X1280X125, and cfg bigger than 6. We find that a large CFG scale generally leads to faster videos.

と書かれています。

shift: 17

steps: 6

cfg: 6以上

で動くらしい。

モデルはここにあった。

hunyuan_video_FastVideo_720_fp8_e4m3fn.safetensors を取ってくる。

それから、こんなアジア系のLoRAも見つけた。

都合のいいことに、FastVideoを使うワークフローも置いてある。

こちらは、

shift: 17

steps: 8

が推奨設定らしい。

これらを参考に、HunyuanVideoの標準ワークフローに、LoRALoaderを追加して、設定を変えてやってみよう。

まず、FastVideoのモデルを選択する。weight_dtypeはfp8_e4m3fn_fastで。

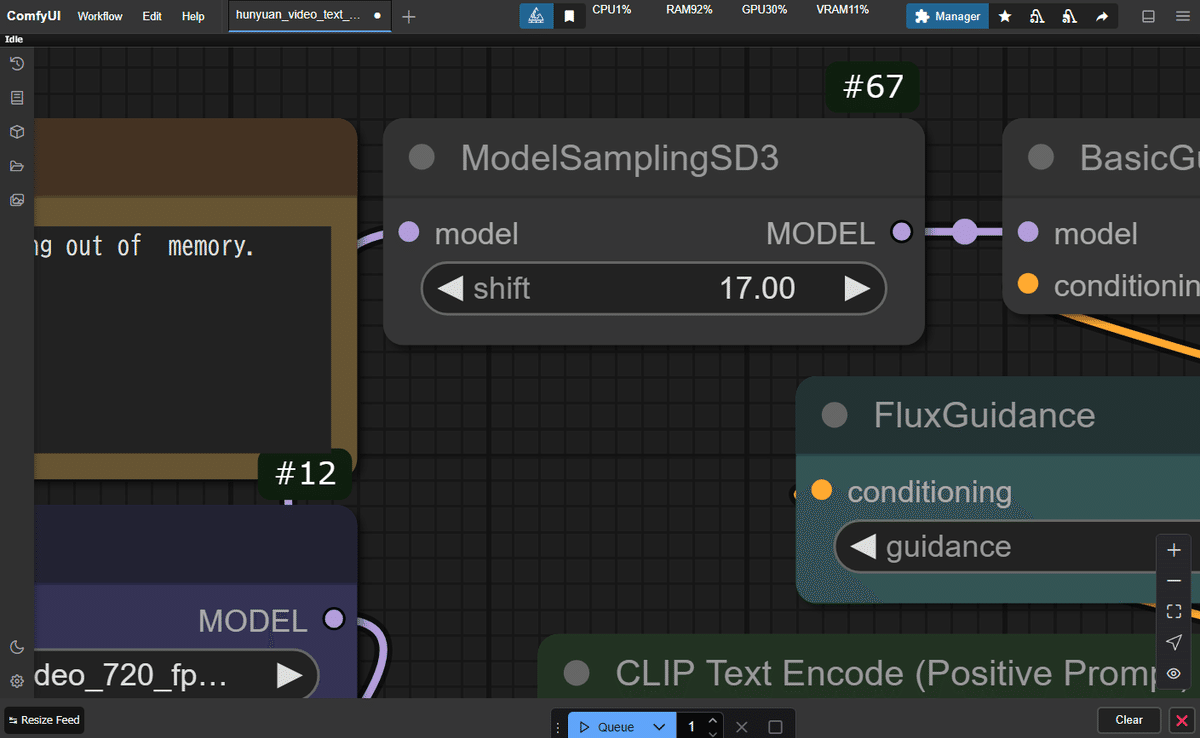

shiftの設定は、ModelSamplingSD3のノードで、これを17にする。

LoRALoaderを追加して、LoRAを選択する。

で、ステップ数は8にする。

プロンプトはこのLoRAのところのを真似て作った。

準備完了。いってみよう。

できた。

Prompt executed in 570.38 seconds

1回目はモデルのロードに時間がかかる。このうち、サンプリングは4分くらい。トータルで9分半。

で、できたのがこちら。

いいね。もうちょっと全身が入って欲しかったけど。

2回目いってみる。

Prompt executed in 325.92 seconds

5分半くらい。同じくサンプリングは4分くらいで、書き出しにもそこそこかかっている。これはRAMが少ないことも影響してそう。

ポートレイトになったけど、これはこれで。

3回目いってみよう。Seed値固定して、Step数を6に減らしてみる。

Prompt executed in 258.80 seconds

4分ちょっと。サンプリングが3分に縮んだ。

やっぱりこれより8stepsの方がいいね。

LoRAをbypassして、Step数を6で。

Prompt executed in 198.21 seconds

3分ちょっと。速っ。サンプリングが2分半。

でも、これはいけてないね。LoRAすごいな。

最後に横置きのものも少し。

髪が不自然に浮いてるけど、いいね。

背景の人たちもよく動く。

RAMもせめて32GBにしたいな。

ではまた。