結局、持続可能な未来の到来を妨げるのはシンギュラリティというより「人間自身による人間自身の為の人間自身の規定」による制約のせいという話。

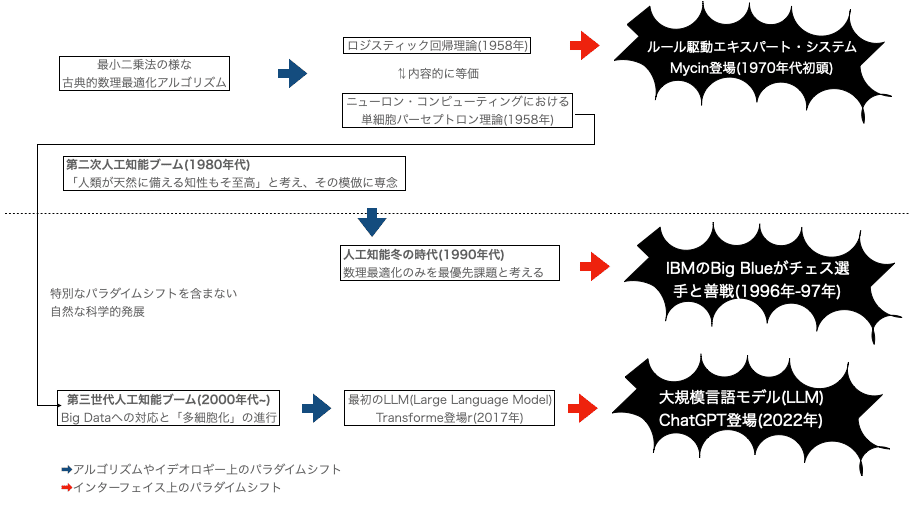

思えばGoogleが最初のLLM(大規模言語モデル)Transformerを採用したのが2017年。翻訳ツールの精度をルール駆動エキスパート・システムで維持するのが困難になったからで、まずその展開自体がパラダイムシフトだった訳ですが、その瞬間には全く話題になりませんでした。人類全体が反応したのは「人間との対話能力を備えた」ChatGBTが登場したタイミング(2022年)。

何もこれが初めてという話でもありません。深層学習アルゴリズムの大源流は、同年発表されたニューロン・コンピューティングにおける単細胞パーセプトロン理論と同内容のロジスティック回帰理論の登場(1958年)。情報理論の古典的教科書たるノーバート・ウィーナー「サイバネティクス(初版1948年)」の1961年増補箇所にもその爪痕を残していますが、世間一般が反応したのもまた「人間と対話しながら特定事例を分類する」Mycin登場(1970年代初頭)あたりからで、しかも「コンピュータ診断の結果は誰が保証する?」なる反人工知能論争勃発の契機に。

これは当時の人工知能研究が「人類が天然に備える知性こそ至高」なる観点からその忠実な模倣に終始していた結果でもあり「数理的最適化のみを最優先課題と設定する」新展開が登場するとIBMのDeep Blueがプロのチェス選手への勝利を飾ります(1996年~1997年)。

そしてあらゆるコンピューターがインターネットに接続され、そこに蓄積されたBig Dataが学習に使える様になると推論に使われるセル(細胞)数も統計力学上の理想気体の分子数$${10^{23}}$$を凌駕する$${2^{10000}=10^{28}}$$規模に増大。今度は「人工知能が人類の知性を上回る事を警戒する」シンギュラリティ論が登場してきます。

こうして全体像を俯瞰すると、人類は全体としては「科学的発展やイデオロギー的進化そのもの」でなく、群盲が像を撫でる様にその「インターフェース」へ脊髄反射的に反発をぶつけてきたに過ぎない事に。

その一方で人類が未来に向けて持続可能な開発目標(SDGs)を切り開いてきたのは常に韓非子「五蠹」にもある先取の姿勢「聖人不期脩古不法常可論世之事因為之備(聖人は必ずしも古えにしたがおうとはせず、一定不変の道にのっとろうとしない。当世のことを論じそれの備えをする)」だったという話になる様です。

ここまでが「課題の1000文字」。

以下が「プロダクション・ノートみたいな追記」となります。

・