2022年度AIPシンポジウム成果報告会特別講演「大規模言語モデルの驚異と脅威」

はじめに

Twitterで、「大規模言語モデルの驚異と脅威」の講演が、素晴らしくよくまとまっているのでぜひ視聴してくださいとの「つぶやき」が流れてきた

講演は43分だが、簡潔でかつ必要十分な内容だったので

私の備忘録を兼ねて本noteに概要を記載しておきます

AIP(理化学研究所 革新知能統合研究センター)シンポジウム

本講演は、2022年度AIPシンポジウム成果報告会の特別講演として企画された。AIP成果報告会は、全ての講演のビデオとポスター発表のポスターが公開されているので、情報の宝庫。

時間のある方は、下のリンクをたどって、じっくりと時間をかけて勉強されると良いでしょう

特別講演「大規模言語モデルの驚異と脅威」

下記が、講演の動画になります

スライドを眺めるだけでポイントがよくわかります

以下、動画に登場するスライドを使用して概要を説明します

驚異的なスピード

たった4ヶ月でここまで普及・進化した

https://www.youtube.com/watch?v=PUuk4Cv-ycgより

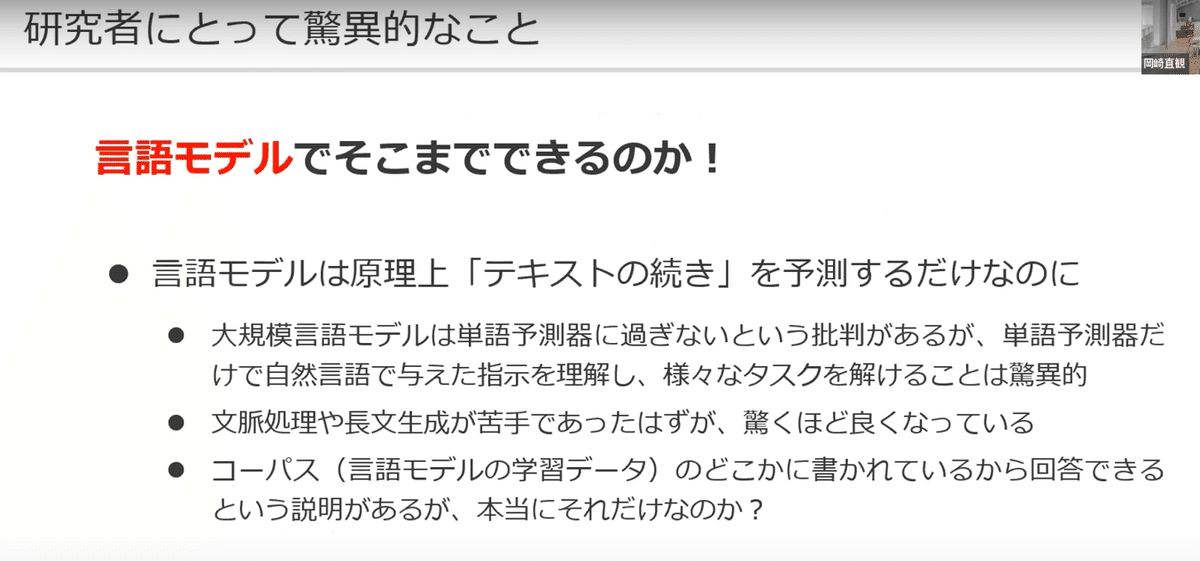

言語モデルでそこまでできる驚異

言語モデルだけで本当に会話できるのか?

後述する学習により「理解」しているのではないか?

言語モデルが、次に来る言葉を選択する原理

最も出現確率が高い単語を選択しているだけ

言語モデルの問題

・単語列が長くなると出現確率が0になる

・「英国の首都」と「イギリスの首都」で出現確率に大きな差が生じる

nグラム言語モデル

n-1個前の単語までで出現確率を計算する

利点:出現確率が0になるのを回避できる

問題:例えばnが3だと、「英国の首都は?」の「英国」が消えるので「東京」の出現確率が最大になる。同様の事例が起きる

RNN型ニューラル言語モデル

単語ベクトルに、離れた情報を埋め込む

利点:離れた単語も探索に反映可能

問題:ベクトルが固定長だと情報を覚えきれない

深層学習にもとづく機械翻訳の登場

注意機構により翻訳精度が飛躍的に向上した

Transformer

機械翻訳の注意機構を言語モデルに導入した

利点:単語間の情報統合コストが距離に依存しない

並列計算になじむ

GPT

Transformerのデコーダ部を事前学習

ファインチューニング

事前学習モデルをタスクに合わせて調整(追加学習)する

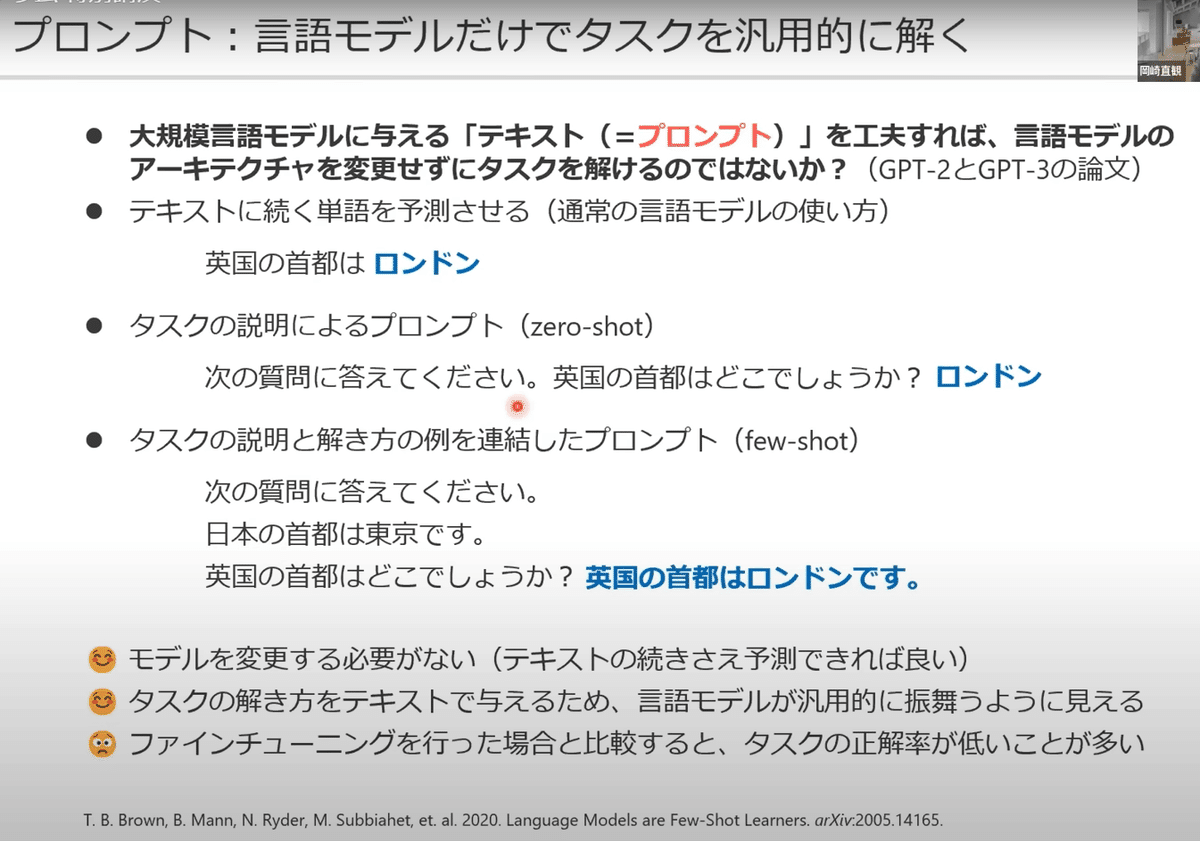

プロンプト

ファインチューニングの代わりに入力するプロンプト(言葉の内容)を工夫する

利点:追加学習の必要がない

問題:タスクによってはファインチューニングより成績が低い

Instruction Tuning

複数のタスクでプロンプトによるファインチューニングを行う

62個のタスクをファインチューニングできた

Chain of Thought(思考の連鎖)

考え方を含めた指示を出す

利点:プログラムが順を追って思考し、正解にたどり着く

PlayGround

現在フリーソフトなので、試してみてください

(実際にアプリを立ち上げて実演してくれる)

人間のフィードバックによる強化学習

人間が評価したサンプルから評価方法を学習したアプリを用いて出力を評価する。これを繰り返して強化学習を行う。

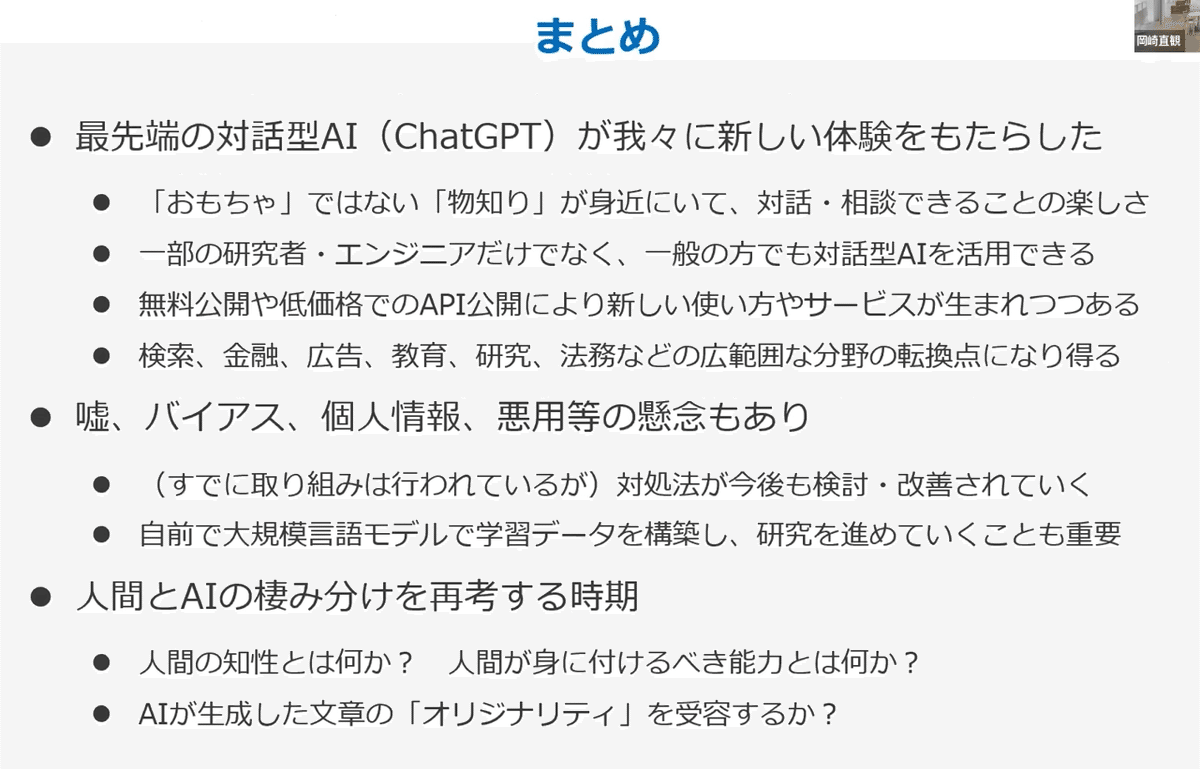

驚異のまとめ

私のコメント:

2023年4月25日時点で、AutoGPTという、目標達成まで出力を自動で改善していくという

とんでもないアプリが現れています

さて、『AutoGPT』が話題になってから3週間程度が経ちましたね⚡️

— 木内翔大|AI時代に乗り遅れない為の必見情報を毎日配信📣 (@shota7180) April 23, 2023

タスクを自律的にやってくれるエージェント的な存在で、GPT-4並みの衝撃がありました👁

まだAutoGPTを知らないなら、是非この機会にキャッチアップしておきましょう!

詳細はスレッド👇pic.twitter.com/EnT4Eo9Qwx

大規模言語モデルの脅威

これから起きるであろう問題

大規模言語モデルを活用した論文の取り扱い

全体のまとめ

参考資料

おわりに

私は本講演を視聴することで、Twitteによく流れてくるキーワード

「RNNモデル」「Transformer」「プロンプトラーニング」「Chain of Thought」の理解が進みました

本講演内容を理解すると、以下のつぶやき集がよりいっそう

良くわかるようになります

私がリスペクトしている谷口忠大先生の以下の寄稿論文の理解の助けにもなります

いいなと思ったら応援しよう!