反AI絵師、ウォーターマークにハマる

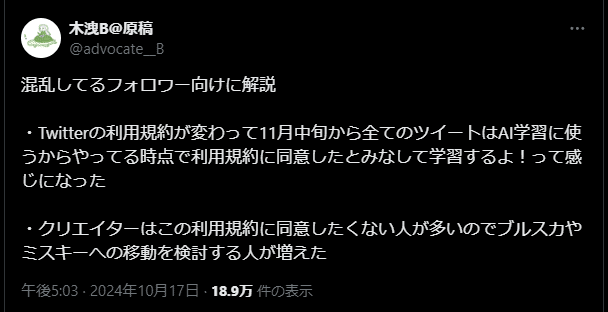

発端は「Twitter(X)に内蔵されている生成AI『Grok』が、2024年11月15日からTwitter内画像の機械学習を始める」というデマ。なぜデマなのかというと、Twitterによる機械学習はこの日に始まったのではなく、2023年9月頃から行われていたため。

これに対し、まず最初に起きたムーブメントは、「Twitterを捨てて他のSNSに行く」であった。しかし、その手の試みはこれまで全て失敗しているうえ、そもそも他のSNSに行っても機械学習を防げるわけではないので、得られるのは「Twitterを見捨ててやった」という満足感だけで、特に解決にはならない(むしろTwitterはscrapingに対してかなり安全な方である)。

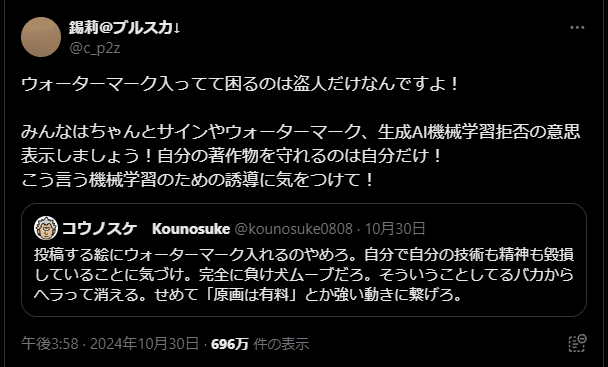

そこで流行ったのが、「アップロードする画像に人為的にノイズを合成し、部分的に破壊する事で機械学習の阻害を試みる」というムーブメントである。この手のアプローチは以前から存在したが、それがついにメインストリームで流行した。ただし流行ったのは、GlazeでもNightshadeでもなく、まさかの手製ウォーターマークである。

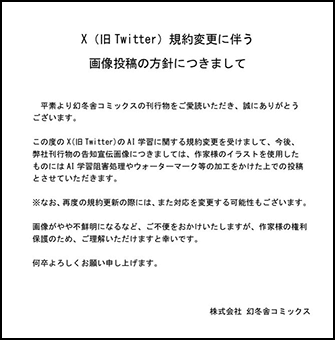

実際に機械学習を阻害する効果があるのかどうかは全く検証されないまま、思い思いの破壊的ノイズパターンが作成・合成され、アップロードされていった。この動きに個人のみならず一部の出版社まで追随した。

しかし、現時点で「AIだけに選択的にダメージを与えるノイズ」という物は存在しない。画像生成AIがどういうアルゴリズムで画像を生成しているかを考えれば分かるが、ノイズ除去はAIが最も得意とする分野の1つであり、中途半端なノイズなどAIにとって無いも同然である。ノイズによる画像の部分的破壊は、AIにダメージを与えられる保証がない一方で、本来の目的である「人間による鑑賞」には確実に悪影響を及ぼす。

もちろん「AIに学習されない事が最優先で、受け手の印象や自分の成功は二の次」という事であれば、特に問題はないのだが。