【7/14日開催】生成AIサミットvol.2 株式会社WEEL 「オンプレで実現するセキュアな生成AI:自社特化LLMのポイント」のセミナーレポート

株式会社WEEL、生成AI事業部の安藤です。

7/14(水)に開催した生成AIサミットvol.2に、

弊社の田村が「オンプレで実現するセキュアな生成AI:自社特化LLMのポイント」というテーマで登壇したので、いち視聴者として聞きながらレポートをまとめました!

・データの流出などセキュリティ面で、生成AIを活用できていない方

・これから生成AIの活用・開発を検討される方

・最新の生成AIの活用について知りたい方

はぜひご覧ください!

目次

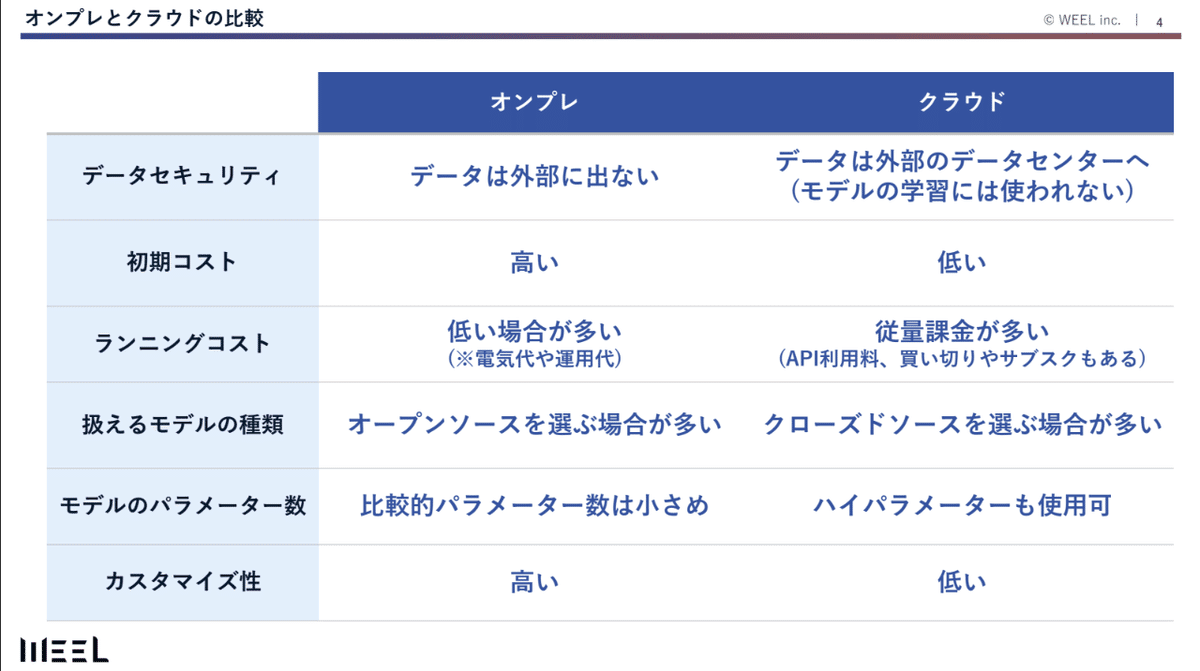

1. オンプレとクラウドの違いとは?

結論、オンプレとクラウドは、「データが外部に出るか&ランニングコスト」が大きく異なる点が異なります。

生成AIの開発を行う場合、クラウド上に開発しopenAIなどのAPIを利用することが多いですが、これは外部データを出しています。

「外部にデータが出ている」とはどういうこと?と思う方もいると思いますが、

クラウドの場合は、生成AIに入力したデータが、openAIのサーバーに届き、その内部で生成AIが動いて回答などを生成しています。そのため、データ自体は外部のopenAIのサーバーに出てはいるのです!

※openAIがAPI経由でやりとりされたデータは学習に利用しないと明記しているので、勝手にデータがモデルに学習されることはありません。

一方、オンプレの場合は、自社のサーバーやワークステーション内で生成AIを動かすため、自社の外にデータが漏れることはありません!そのため、個人情報など様々なルールで外部に出せないデータを生成AIに利用したい時は、この方法を取ることが最適です。

また、クラウドは従量課金で、生成AIを利用するほど金額は増えていきますが、OSSのモデルなどを利用することで、ランニングコストを0円にすることも可能です。

こう聞くと「クラウドよりもオンプレがいい」と思えますが、一概にそういうことではないです!

田村も

「『クラウドよりもオンプレがいい』と言いたいのではなく、どちらもメリット・デメリットがあります!」

と、伝えておりました!

2.オンプレの需要が増えてきている?

弊社にくるお問い合わせも最近オンプレに関するものが増えております。

今年、2024年1月の「オンプレでの生成AI活用」の相談件数は、1件のみでしたが、

24年6月は7件となり、なんと7倍まで増加しております。

(7倍という数値をみると、かなり多いですね!)

この理由としては…

オンプレで利用できるモデルの性能が去年に比べて高くなっていることが考えられます。

去年までは、GPT3.5の性能よりも少し劣る印象でしたが、最近のオープンソースのモデルはベンチマークで比較してもGPT3.5と変わらない性能を示すようになってきました。

また、AI PCやワークステーションなど、ハードウェア側の性能が上がってきていることも関係ありそうです。

(田村も日本HP様のセミナーに登壇した時に、AI PCの動きを間近にみて、性能の高さに驚いたとのことです!)

3.LLMを使う場合のオンプレとクラウドの違いを詳しく見てみると…

セミナーでは、こんな1枚の資料で説明されていました。

これ以外にも、生成AIに指示を出してから、返答するまでのスピード感も異なるとのことです!

クラウドだと、AIが動くサーバーは同じなので、利用する人数によって重くなったりということがあります。

(実際にChatGPTでGPT4を使うときも、ユーザー数が増えた結果、GPTがサボり始めた…みたいな話もありましたもんね…笑)

オンプレの場合は、自社内で動かしているので、そういった問題が発生しづらいです。

また、API経由のモデルだと、細かくアップデートをされる場合もあるので、キャラクターのBotなどを作る場合は、アップデートのたびに挙動が変わるなんて話もあるみたいです。

ローカルにダウンロードしてモデルを利用する場合は、そういったこともありませんよね!

4.オンプレで利用するLLMのモデルはどう選ぶ?

田村は、オンプレで利用するLLMのモデルの選び方は2つあると言います。

①オンプレ環境で利用できるか

②ユースケースに特化しているか

①オンプレ環境で利用できるか?

生成AIのモデルというと、openAIのGPTやGoogleのGeminiなどが有名ですが、

これらはオンプレでは利用できません。API経由で利用できますが、オンプレようにモデルのダウンロードなどはできません。

なので、metaのlamaやclaudeといったOSSで提供されているモデルを選ぶ必要があるとのことです!

②ユースケースに特化しているか?

ただ、OSSのモデルもたくさん存在しています、その中でどのような基準で選ぶかですが、

ユースケースに特化したモデルを選ぶとのことです!

OSSで提供されているモデルの中には、コードの生成や翻訳など特定の用途に特化して再学習されたモデルがあります。

ですので、そういった具体的なユースケースから、特化したモデルを選びましょう。

5.ビジネス現場でのオンプレ生成AI活用事例3選

弊社は生成AIシステムの受託開発を行っている会社です。そんな弊社にきたお問い合わせの中で、相談にきていただいたものや現在開発が進んでいるもの、実際に弊社で開発したものを3つご紹介します。

CASE1.レポート作成業務:金融系企業

この金融系企業様は、レポート作成業務に人間の工数がかなりかかっているという課題を抱えていました。また、個人に関わるデータのため、外部に出すことができないというお話から、オンプレで生成AIの利用を行いました。

ここでのポイントは、超高精度は求めないという点です。

一般的な生成AIのシステム開発にも言えることですが、生成AIは100%正しい答えをだすわけではありません。そのため、生成AIに求めるクオリティを事前に決めておくことが重要です。特に、オンプレのAIモデルは、クラウドで利用できるモデルよりもパラメータなどが低い分、よりそのことを認識しておくことが必要があります。

CASE2.お問い合わせ対応効率化:IT企業

このIT企業様は、自社内のサービスへのお問い合わせが多いので自動化したいというご要望がありました。また、お問い合わせ対応に利用するデータは、専門領域なので自社内で完結させたいということで、オンプレでの生成AIシステムを開発しました。

ここで、視聴者から特に反応が多かった部分が、

「RAGのGはあえてなくてもいい」場合があると話した時です。

「RAGのGがないってどういうこと?」私もびっくりしました…!

生成AIのチャットボットなどでよく聞くRAG(Retrieval-Augmented Generation)とは、

簡単にいうと追加情報を生成AIに与えて、より正しい回答を生成させる手法のことをいいます。

この最後に回答の文章を生成させるG(Generation)は絶対必要なものではないというのです。

特に専門領域のデータを扱うこの企業の場合は、関連するデータを検索するまではできても、生成AIが回答を生成する時に誤った内容を出力をしてしまうということが発生していました。

また、専門領域においては、「生成AIが出力した回答が正しいかどうか」を担当者が情報ソースから確認する必要があり、それなら生成という機能を無くした方が良いのではないかという話になったそうです。

ここで、「Gをさせない場合、生成AIは情報ソースのファイルのみを出力するのか?」という疑問が浮かんだので、田村さんに確認してみました。

すると、「生成AIは情報ソースとなるファイルだけではなく、ファイルの中でどのように書かれているのかまで出力する」とのことでした!

確かにそれなら、「人がファイル検索を行って、該当箇所を調べる」という時間を大幅に削減できそうですね!

生成AIのシステム開発を行う場合、この回答精度の検証にかなり時間とコストを要するため、ユースケースに応じてはRAGのGをさせないということも重要になります。

CASE3.施設内でのみ利用できるAIbot作成:某大手企業

この企業様は、施設内で海外の観光客からのお問い合わせに対応する生成AIbotを作成したいというご要望がありました。システムの処理を施設内のサーバー内で完結させる必要があることから、オンプレでの開発を行いました。

ここでのポイントは、特化型のモデルを利用した点です。

オンプレで使うモデルは、必要ない機能をできるだけ削除して、モデル自体を軽くするということをやっております。

そのため、ある程度なんでも回答できるクラウドのモデルに比べて、オンプレのモデルは特定の機能に特化しています。

このお客様の場合、観光情報を翻訳して回答をさせるというユースケースが限定されていたので、翻訳に特化したオンプレのモデルを利用することで、回答の精度をあげることができました。

6.オンプレで生成AIを活用するための3つのポイント

オンプレで生成AIをうまく活用していくためのポイントは以下の3つがあるとのことです。

ユースケースを決定する

投資対効果の高いハードウェアを選択

ユースケースに応じてカスタマイズする(応用編)

6-1.ユースケースを決定する

このユースケースの決定こそ、最重要ですと田村が力説していました!

みなさんも、2の「投資対効果の高いハードウェアの選択」、3の「ユースケースに応じてカスタマイズする」、は最悪忘れてもいいので、ここだけは覚えていってください!

ユースケースを特定して生成AI開発を行うことは、クラウド・オンプレ関係なく重要なことですが、特にオンプレで重要である3つの理由があります。

6-1-1.オンプレのモデルは軽量化されている

実は…、オンプレで生成AIを活用する時は、生成AIのモデルの必要ない機能を削って、LLM自体を軽くしているんです!

田村はLLMを脳みそに例えて、今回のユースケースに合わせて脳みそのいらないところを削るようなものと話していました。少しおぞましい例えですが、LLMの今回は削ってもいい部分などを考慮して、軽くしているようですね。

LLMを軽くすることで、初めてサーバーやワークステーション内で動かせるようになります。

ただ、ユースケースを特定しなければ、そもそもLLMのどの部分をを削ればよいかわからないですよね?

だからこそ、ユースケースをしっかり特定し、生成AIにどんな回答をさせたいのかなど事前に決めることが重要なようです!

6-1-2.モデルの日本語性能をチェックする

ユースケースの決定にあたり、オープンソースのモデルの日本語性能は必ずチェックしましょう。

オープンソースで提供されているモデルは、ベンチマークの結果から「日本語性能が高い」と言われることが多いですが、最近では使用しているベンチマークによっても性能を表す数値が異なることがわかっています。

(田村も他の企業やエンジニアとモデルについて話す時は、どのベンチマーク使っているのかという話しになるそうです!)

そのため、たとえベンチマークで日本語性能が高くても、今回のユースケースではどうなのかというところを合わせて確認し、モデルの選定を行うことが重要になります。

6-1-3.モデル知識の限界がある

オープンソースのモデルはパラメーターが小さいので、幅広い知識があるわけではありません。

また、オープンソースのモデルの学習データのアップデートが行われるかどうかは、モデルを提供している企業によっても異なるため、モデル自体の知識が大幅に増加することは期待しない方がよいです。(Metaなどモデルをアップデートしてくれる企業もいますが)

そのため、モデルの知識だけで回答させないことやRAGのGをさせないなど、モデルの知識に頼らないユースケースで利用することが大切です。

6-2.投資対効果の高いハードウェア選択

皆さんに、お伝えしたいと田村が力説していた最後の部分です!

それは「生成AIのオンプレ活用 = サーバー」と考えるのはやめてほしい!ということです。

サーバーを利用しなくても、使用用途や規模によっては、ワークステーションやAIPCなどで事足りる場合も多いです!

・全社的に大規模に利用する場合 → サーバー

・部署や大きいチームで活用する場合 → ワークステーション

・個人や小規模なチーム → AI PCを配布する

など、規模や用途に合わせて、投資対効果の高い選択をすることが重要なようですね!

現在期間限定で、AI PCやワークステーションを用いた自社での生成AI活用を検討したい企業にむけて、安価にPoCなどを行っています。

ご興味ある方は下の「日程調整リンク」よりご連絡ください!

日程調整リンク

6-3.ユースケースに特化してカスタマイズする(応用編)

オープンソースのモデルは、GPTなどクローズドのモデルよりもより深くモデルのチューニングを行うことができます。

クローズドのモデルでもfine-tuningは可能ですが、オープンソースのモデルは、ソースコードやパラメータなどの情報が公開されており、より大きい範囲でチューニングすることができます。

そのため、自社の業務に適するようにモデルをチューニングしていくことで、より生成AIの回答精度を高めていくことができます。

7.まとめ

以上が、生成AIサミットのWEEL生成AI事業部統括の田村が登壇した「オンプレで実現するセキュアな生成AI:自社特化LLMのポイント」のレポートになります。

ざっくりとまとめてみましたが、参考になりましたでしょうか?

オンプレでの生成AI活用について、

・オンプレでの生成AI活用を検討している

・自社業務の中で、どのように生成AIが使えるかしりたい

・オンプレやクラウドなどの違いも含めて、より詳しい話を聞きたい

という方がいましたら、ぜひ弊社にお問い合わせください。

弊社は、40件以上の生成AI開発の実績がある、生成AIのシステム開発会社です。生成AIのコンサルティング〜システム開発など幅広く行っております。

また、「すぐに話を聞きたい」という方は、以下の日程調整リンクより、お打ち合わせの日程を選択していただけますと幸いです。今回登壇した、弊社の田村も同席いたします。