【Luminous】ヨーロッパの「OpenAI」が生み出すマルチモーダルAI

皆さん、LuminousというLLMをご存知ですか?異なる3つのLLMがセットになっていて、そのうち2つがマルチモーダル化もいけちゃうんです!普段からLLMをいじっている弊社としても、「また凄いLLMが出たな」という感じです。

Luminousは、ドイツのAIスタートアップAlephAlphaが開発したLLMのセットです。AlephAlphaはヨーロッパでOpenAIの競合と言われるほど注目されているAI企業です。

本記事では、Luminousの使い方や、実際に使ってみた感想、最後にはよくネット上で比較されるGPT4との比較をまとめています。

この記事を最後まで読むと、Luminousの魅力を理解できます!ぜひ最後までご覧ください!

Luminousの概要

Luminousは、Aleph Alphaが開発したLLMのセットです。

このモデルは、膨大なテキストデータを読むことで、人間の言葉を理解し生成する能力を持っています。想像してみてください。ある人が図書館全体とインターネットの半分を読んだとしたら、どれだけの知識が増えるでしょうか。Luminousは、まさにそのような能力を持つAIツールです。

このLuminousには、さまざまなサイズと能力を持つ3つのモデルがあり、英語やフランス語などの主要なヨーロッパ言語で訓練されています。

Luminous-supreme: Luminousで最も大きく、最も能力のあるモデルで、特にクリエイティブなテキストの作成に適しています。

Luminous-extended: 二番目に大きなモデルで、情報の抽出や言語の単純化のようなタスクに適しています。

Luminous-base: 最も小さなモデルで、最も高速かつ低コストで、分類やラベリングのようなタスクに非常に適しています。

すべてのモデルは、テキストを入力として処理します。加えて、Luminous-baseとLuminous-extendedは、画像とテキストの入力の組み合わせを処理し、テキストを出力することも可能です。

また、人間の指示に従うように微調整するために、Controlというモデルも公開されています。

この技術の進化は驚異的ですね。

Luminousの料金体系

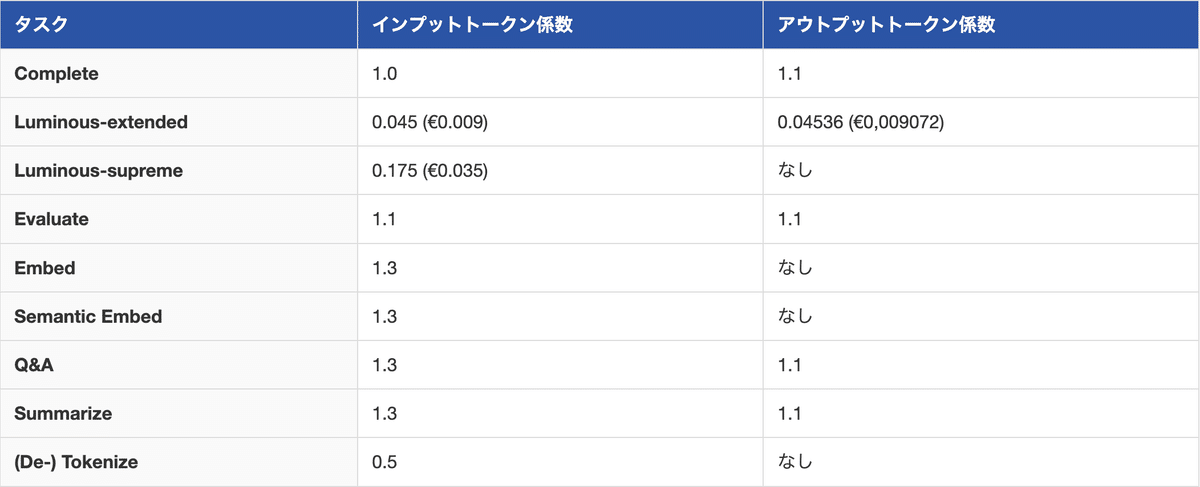

Luminousのトークンベースのモデル料金は、以下の通りです。

また、それぞれのモデルに対して、タスクごとに異なる料金が適用されます。

例として、「Evaluate」タスクの場合、Luminous-extendedで1000入力トークンを使用すると、基本料金0.045に入力タスクの特定の係数1.1を掛けた0.0495クレジットがかかります。

さらに、1000の出力トークンには、0.0495に出力タスクの特定の係数1.1を掛けた0.05445クレジットが追加でかかります。したがって、この2000トークン(1000入力 + 1000出力)のリクエストの合計コストは0.10395クレジットとなります。

Luminousの使い方

今回は、Google Colabで行います。

まずは、以下のページにアクセスして、アカウントを作成してください。

参考記事:Luminousの公式ページ

次に、以下のプロフィールページから、APIトークンを作成してください。

参考記事:プロフィールページ

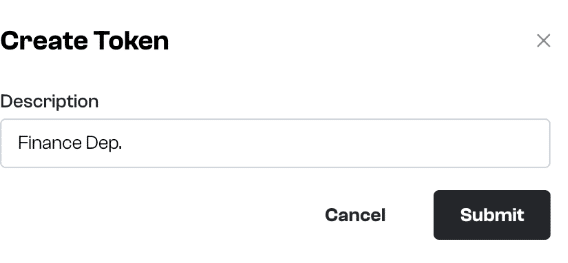

プロフィールページにアクセスしたら、「Create Token」ボタンをクリックしてください。

クリックすると、以下のように「利用目的」のようなものの説明が求められます。ここでは「Finance Dep.」と入力します。

そうすると、以下のようにトークンが作られるので、コピーしておきましょう。

APIトークンの発行方法や消し方は、以下のアカウント管理ページが参考になります。

参考記事:アカウント管理ページ

次に、以下のコードを実行して、API Clientをインストールしましょう。

!pip install aleph-alpha-client最後に、以下のコードを実行して、クライアントをインスタンス化して、Clientを利用できるようにしましょう。その際に、「AA_TOKEN」には、先ほど取得したAPIトークンを入れてください。

from aleph_alpha_client import Client

model = Client(token="AA_TOKEN")なお、エロやアングラも出力できるStable LMについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

→【Stable LM】エロもアングラも教えてくれる禁断のLLMとは?使い方〜実践まで徹底解説!

Luminousを実際に使ってみた

これ以降は、以下の記事からご確認ください。

他の記事もご覧になりたい方は、こちらをご覧ください。