Dify v0.11.2 の新モデル/ツールと、生成AIのランキング状況

はじめに

Dify v0.11.2が、11/18にリリースされています。

今回の注目点は、生成AI関連の各ランキングで、トップレベルのモデルやツールがまたもや追加されたことです。

Difyは刻々と変わる生成AI分野での最新のハイレベルなAPIの導入に積極的です。今回導入されたモデル等がどのような位置づけにあるか最新のランキング上で検討してみたいと思います。

LLM

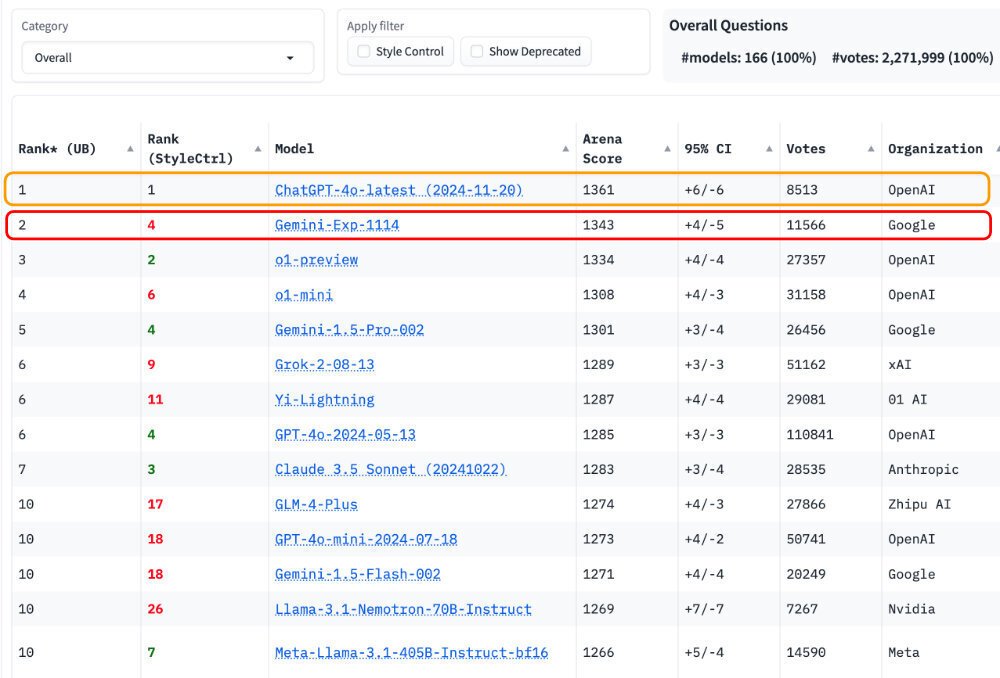

今回追加されたGoogleのGemini Experimental 1114は、v0.11.2がリリースされた時点でChatbotArenaで1位でした。11/21の午前中まで、キープしていましたが、午後になって、ChatGPT-4o-latest (2024-11-20)が1位で登場し、2位となっています。

画像生成AI

また、あらたにツールのプロバイダーとして登場したFal経由で、画像生成AIの最新のモデルであるFLUX1.1 [pro]が使えるようになりました。これは、画像生成AIのモデルとしては、Artificial Analysisで、Recraft v3についで、2位にランクインしています。

さらに、オリジナルプロバイダーのBlack Forest LabsよりもFalの方が、速いという結果がでています。価格は同等です。

SST(Speech to Text)

同じくFalから供給される、音声テキスト変換(Speech To Text: STT)のWizper、これはOpneAIのWhisper (large-v3)をベースとしたモデルですが、本家のWhisperよりも、圧倒的に速いようです。

なお、上記で引用した生成AI関連のランキングサイトについては、前回ご紹介しました。今回それらからランキングを引用して見てみたいと思います。

それでは、まず、Githubから、今回のDifyのリリース内容をメモします。

v0.11.2について

下記は、GithubにあるDifyのリリース内容のリンク先です。

v0.11.2 の新機能 ✨

重要

ご注意ください! 次のマイナー バージョン以降、Python 3.10 はサポートされなくなります。最新のアップデートを入手するには、必ず Python 3.11 または 3.12 にアップグレードしてください。

バージョン 0.11.2 では、新しいモデル、ツール、改善、バグ修正が加わり、よりスムーズなエクスペリエンスが実現しました。新機能は次のとおりです。

🚀 新機能

Gemini-exp-1114モデルを追加しました。

DuckDuckGoビデオ検索とニュース検索を導入

YouTube Transcript APIをツールとして追加しました

メール組み込みツールのリリース。接続性を改善します。

SiliconflowのVLモデルがサポートされるようになりました

SiliconflowモデルのJSONレスポンスを追加し、取り扱いを容易にしました。

Fal AI のWizper ASRは現在、組み込みツールとなっています。

画像生成用のFal AI のFluxを追加しました。

⚙️ 機能強化

反転チャットカラーテーマの切り替えを追加しました

CODE_EXECUTION_TIMEOUTを.envで設定可能にしました。

グループ質問の上下矢印キーナビゲーションを有効にし、デバッグを改善しました。

🛠️ バグ修正

ドキュメント抽出ノードのUTF8以外の文字に関する問題を修正しました。

mp3ファイルのアップロードに関する問題を解決しました

カスタムファイル拡張子のサポートを修正

従来の画像アップロード互換性を復元

デフォルトのモデル設定が音声ツールと競合しないようにしました

未使用のgenerationキューを削除してサーバーリソースを節約

空文字列の数値処理を修正

利用可能な場合にのみCeleryログがファイルに記録されるように、デプロイメントスクリプトを更新しました。

生成AIランキングの状況との関連

Gemini Experimental 1114 関連

冒頭でご紹介したLLMのランキングを示します。

11月21日 7:57 のランキング(Chatbot Arena)

https://lmarena.ai/?leaderboard

11月21日 15:34のランキング(Chatbot Arena)

https://lmarena.ai/?leaderboard

11月21日の午後になって、Chat-GPT-4o-Latest(2024-11-20)が登場して、1位になっています。

1週間前まで、不動の1位だったo1-previewをGoogle Experimental1114が抜いたと思ったら、OpenAIが1120で巻き返す。まぁ偶然では、ないですね。

一位の座は、譲らないぞ、ってことでしょう。

注意したいのは、これらのランキングは、必ずしも絶対ではありません。そもそも、ランキングのサイトによって、特定のモデルがあったりなかったりします。

ただし、11月21日 15:34現在のこの結果は、#models: 166 (100%) #votes: 2,271,999 (100%) であり、227万票の投票結果というのは、それなりの権威を持ちつつあるともいえるかと思います。

複数のサイトをみることで、生成AIの現状が見えてくるという状況かとも思われます。

たとえば、Artificial Analususuの11月21日午後の状況はこうです。

この表は、赤枠で囲んだQualityの項目をオレンジの丸の上下キーを使って性能順で示したものです。スピード順、価格順なども見ることができます。

また、性能の評価項目をもっと詳細に見ることもできます。

便利です。

ただ、すぐ気づくのは、この表には、話題のChatGPT-4o-latest (2024-11-20)やGemini Experimental 1114はありませんし、少し前まで一番だったGemini1.5Pro002もありません。

それでいて、Mistralの11月の最新版であるMistral Large (Nov '24)は乗っています。これは、これで、フランスのマルチモーダル対応ということで話題ではあるのですが。

ランキングサイトそのものが黎明期ということもあり、いろいろ課題はあるようです。

Fal関連

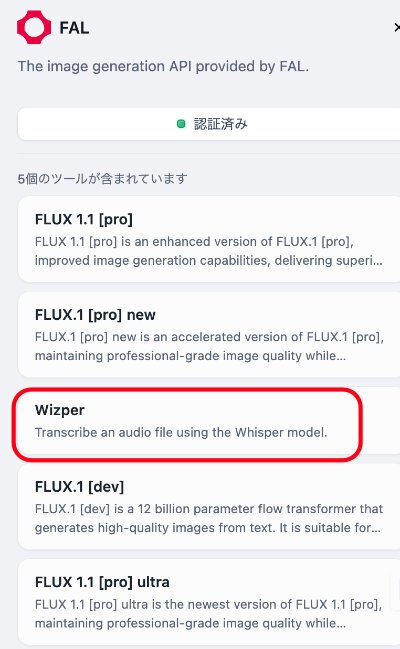

DifyでのFalは、現在のところツールのベンダーという位置づけです。

ツールの表示を示します。

このツールを認証すると次の様な画面が出ます。

なお、この認証のためのAPIは無料で入手できます。APIの名称を入力すると簡単に取得できます。

Flux関連は、なんとFlux 1.1[pro]ultraまでつかえるようです。最も、細かなパラメータ設定の項目はないようなので、どのような画像が出てくるのか不明ですが。

既に導入されているComfyUIとの連携などはできるのでしょうか。

ComfyUIは、あまり詳しくないのですが、画像については、別途試してみたいと思います。

そして、STTのWizperは、これらFlux勢の真ん中の赤い枠で囲んだ位置にさらっとあります。

ちょっと、わかりにくい配置かもしれません。

関連ランキング

まず、Artificial Analysysの画像生成AIモデルのランキングを示します。

画像生成モデルのランキング

一位のRecraft v3以下は、Flux関連が席巻しています。

Fluxは取り扱うプロバイダーがとても多いのですが、その中でも、Falは速度で他を圧倒しています。なんと、本家のBlackFOれstLabsよりも速いようです。

これに対抗しているのは、Appleからのスピンアウト組であるTogether.AIです。ここだけが各モデルでFalと拮抗しています。

この状況をみると、現時点では、Flux系のプロバイダーとして、Falはいい選択だと言えそうです。

STTランキング

次に、Speech to Textのランキングを示します。

この表のオリジナルには、並べ替えの機能がありません。

したがって、ランキングではなく、結果を羅列してあるだけです。

全体を表示すると、少し数字が小さく見づらいのですが、FalのWizperは、エラー率が、この表の中では、他とほぼ同等レベルです。

ただし、表の最下段にあるFireworksは、0%と他を圧倒しています。

これは、これから話題になると思います。

また、右から二番目の列は、速度を示します。

この値は速度係数で、処理時間の 1 秒あたりに文字起こしされるオーディオ ファイルの秒数を示し、係数が高い値ほど、文字起こし速度が速いことを示します。

Falは、223.7と、表で上にあるマイクロソフトの、37.1やOpenAIの34.6を遥かに超えています。ただし、この表での2社は、一つ前のバージョンのLarge-v2の値であるこてゃ留意が必要です。v3はこの時点では、比較対象になっていないようです。

この速度に桁数で対抗しているのは、GroqとFireworksです。いずれも、large-v3ベースで同等の比較となります。ただ、この2社にも、Falの値は勝っています。

さらに、最も右の列は単位時間あたりの価格を示しています。

これについても、Falは、0.50と、OpenAIの6に比べて、10街以上安く設定されています。

なお、Groqも、0.67と安い設定となっています。Fireworksの0は、現在はまだプレリリースの状態と推定されます。

今後が期待されます。

以上を総合的に判断すると、Falは、性能、速度、価格の観点で、トップクラスの位置にあると思われます。

まとめ

今回は、新たにDify に導入されたLLMのGemini Experimental 1114と、ツールプロバイダーのFal関連についてフォーカスしてみました。

いずれも、それぞれの分野でトップクラスの性能をもち、Difyで使うのに、特にお勧めできるモデル/ツールと思われます。

また、それぞれの機能などについて、もう少し深堀りして検討する価値があると思います。別途実施したいと思います。

また、今回新たに機能が追加導入されたDuckDuckGoなどの検索機能、例えば、Google検索、Perplexityなども含め、既にDifyに導入されているこれらのツールについても別途検討したいと思います。