DeepSeek-R1がランキング2位で登場!---Difyで使うための各プロバイダの設定例

はじめに

今、XのAI周りは、DeepSeek-R1の話題でいっぱい。それに対抗するように、アルトマンがXに諸々投稿してますね。O3-miniをフリーにするとか、テキサスで建築中の「Stargate」プロジェクトとか。

いやあ、孫さんもすごいなあ。しっかりOpenAIとも組んでる。今やアンチ アルトマンとなってしまったイーロン・マスクからは、お金ないんじゃない?とか言われてますが、大丈夫でしょうか。

ちなみに、孫さんと外相の岩屋さんは、鹿児島ラサール高校で、一緒だったようです。

低価格化の圧力

DeepSeek-R1の破格な価格体系が、o3-miniの無料ユーザーへの解放という判断を引き出したんでしょうね、たぶん。

つまり、逆に言えば、DeepSeek-R1は、OpenAIに高く評価されてる。

1/28、アルトマンはXに下記のような投稿をしています。

deepseek's r1 is an impressive model, particularly around what they're able to deliver for the price.

— Sam Altman (@sama) January 28, 2025

we will obviously deliver much better models and also it's legit invigorating to have a new competitor! we will pull up some releases.

そして、日本時間の1/24、DeepSeek-R1は、Artificial AnalysisのLLMのQualityランキングに、なんと2位で初登場しています。1位はもちろんo1です。でもたった1点差です。唖然。

Difyへの取り込み

実は、1/22、あまりに話題になってるので、とりあえずDeepSeek-R1をプロバイダーのFireWorks経由でMac上のDifyで使えるように設定しました。ちなみに、1/22の日本時間の夜、Difyは、v0.15.2へのバージョンアップをリリースしてます。

LLM学習へのアクセス情報の取り込み(要注意)

なお、DeepSeek-R1については、API経由でも、そのアクセスする情報が、同社の学習用に使われるようです。その点は、業務関連の使用では、注意が必要です。

また、どうやら、中国関連の情報については、しっかりと学習されているようなので、この点も使い方によっては、留意すべきかもしれません。

そんな方面の使い方をしたいのであれば、Grokなどの方がいいかもしれません。

各社のチャットウェブサイトが登場

なお、DeepSeek-R1は、同社のウェブサイトでチャットが可能です。ちなみに、アリババのQwen系も同様に同社のQwen-Chatで可能となっています。いずれも、無料です。

今回は、ランキング状況と、Dify用の設定例、それと各社のチャットウェブサイトなどについてのメモとなります。

LLMランキングの状況

Artificial AnalysisyのLeaderboard

クオリティでソーティングしたランキングを示します1/27/2025のデータです。

赤の枠で囲んだのがDeepSeel-R1です。1/24に本ランキングに初登場で、2位です。かつ1位のo1とは、89と1ポイント差です。さらに価格が一桁安い。

話題になるのも当然に感じられます。

ただし、このランキングには、Googleの最新のLLMが載っていません。

例えば、Chatbot Arena LLM Leaderboardでは、同じ1/27でこのようになっています。

Chatbot Arena LLM Leaderboard

こちらには、まだ、DeepSeek-R1は載っていません。赤枠のV3は載っています。また、OpenAIのLLMでo1-2024-12-17よりも、ChatGPT-4o-Latestの方が上位ということになっています。

また、これらOpenAIのLLMsは、共に、Googleの最新であるGemini-2.0-Flash-Thinking-Exp-01-21やGemini-Exp-1206 よりも下位に位置づけられています。

いずれのランキングサイトにも言えることですが、特定の会社(グループ)の最新のLLMが、なぜか取り上げられていなかったり、発表されて間もないのに即とりあげられたりするケースが散見されます。

どうも、色々な思惑があるようにも感じられます。留意が必要です。

中国系のLLMの大躍進

後に表示したChatbot Arenaの黄緑で囲んだのは、全て中国製です。DeepSeekも中国系ですので、11位までの15のLLMのうち4つが中国系となります。DeepSeek-R1が登場すれば、当然上位に入ってきますので、5/16、つまり約1/3が中国系となりそうです。

また、ここで、V3の下にいるStep-2-16k-Expというのは、最近、ランキング入りしました。中国系の新しい会社が次々と上位に出てきているようです。

DeepSeek-R1関連情報

DeepSeek-R1を扱っているプロバイダ

Artificial Analysisには、プロバイダランキングというのがあります。

次に最新のデータを示します。

ここで、赤枠で囲んだ5社が、DeepSeek-R1のプロバイダです。

deepseek, Hyperbollic, Fireworks AI, deepinfo, togethr .aiの5社です。

OpenRouterの取り扱っているR1関連のプロバイダ

また、OpenRouterのHPには、同社の扱っているプロバイダリストがあります。1/27の時点では、DeepSeek, NovitaAI, Avian.io, Together, Deepinfra, Fireworksの6社です。

これらは、いずれも、日を追うごとに増えており、また、現状でも、リストは必ずしも重複していません。やはり、人気があるようです。

DifyとDeepSeek-R1

このうち、Difyで使えるプロバイダは、v0.15.2では、上記の2群の中で、次の5社と思われます。

deepseek, Fireworks, together.ai, NovitaAI, OpenRouter

このいづれかを設定して経由することで、DeepSeek-R1のAPIがDifyで使えるようになります。

DifyとDeepSeek-R1について

実は、DeppSeek-R1のプロバイダ設定を行った1/22の時点では、Difyで使えるR1を扱っているプロバイダは、deepseek, Fireworks, OpenRouterの3社のみでした。

この中で、最初に、Dify用に以前モデルの追加を行ったことのあるFireworksを選び設定を行いました。

ただ、扱っているプロバイダの増えた現時点では、少なくも価格の観点では、これは、いいチョイスとは言えないかもしれません。

Fireworksは最も高額です。

この状況は、米国系のプロバイダーに対する嫌がらせという側面もあるかもしれません。似たような立ち位置のtogether.aiも高額です。ただ、ちょっと安いのは、Fireworksが、一番乗りを狙って焦ったから、かも、です。

以下、3例について、設定例を示します。オリジナルのDeepSeekが入っていないのは、どうやら課金=カード情報を入力しないと使えない、と思われるからです。残念ながら、現時点では躊躇してしまいます。

あと、novita.aiは、モデルの追加機能がありませんでした。Difyサイドで使えるように設定してもらわないとダメなようです。

以下、それぞれの設定画面を示します。

DeepSeek-R1のDify用設定例 -1 Fireworks

FireWorksは、米国系のプロバイダで、比較的高速レスポンスを特徴としています。取り扱っているLLMも多く、HPに設定されているプレイグラウンドで、各LLMのAPIを使ってお試しもできます。

比較的としたのは、高速という観点ではGroqやCerebrasなどの独自のAIプロセッサの運用で高速対応に特化しているプロバイダ群も出てきているからです。さらに言えば、Groqなどの超高速対応のプロバイダで、DeepSeek-R1を使えるようになれば、かなり魅力的ではないかと予想されます。

一般的には、価格と高速対応のバランスがとれたプロバイダと言えるかと思います。

各パラメータの設定値については、同社のHPのDeepSeek-R1にあるAPI Examplesに記載のプログラム例を引用してみました。各赤枠の部分です。

Difyでの設定例

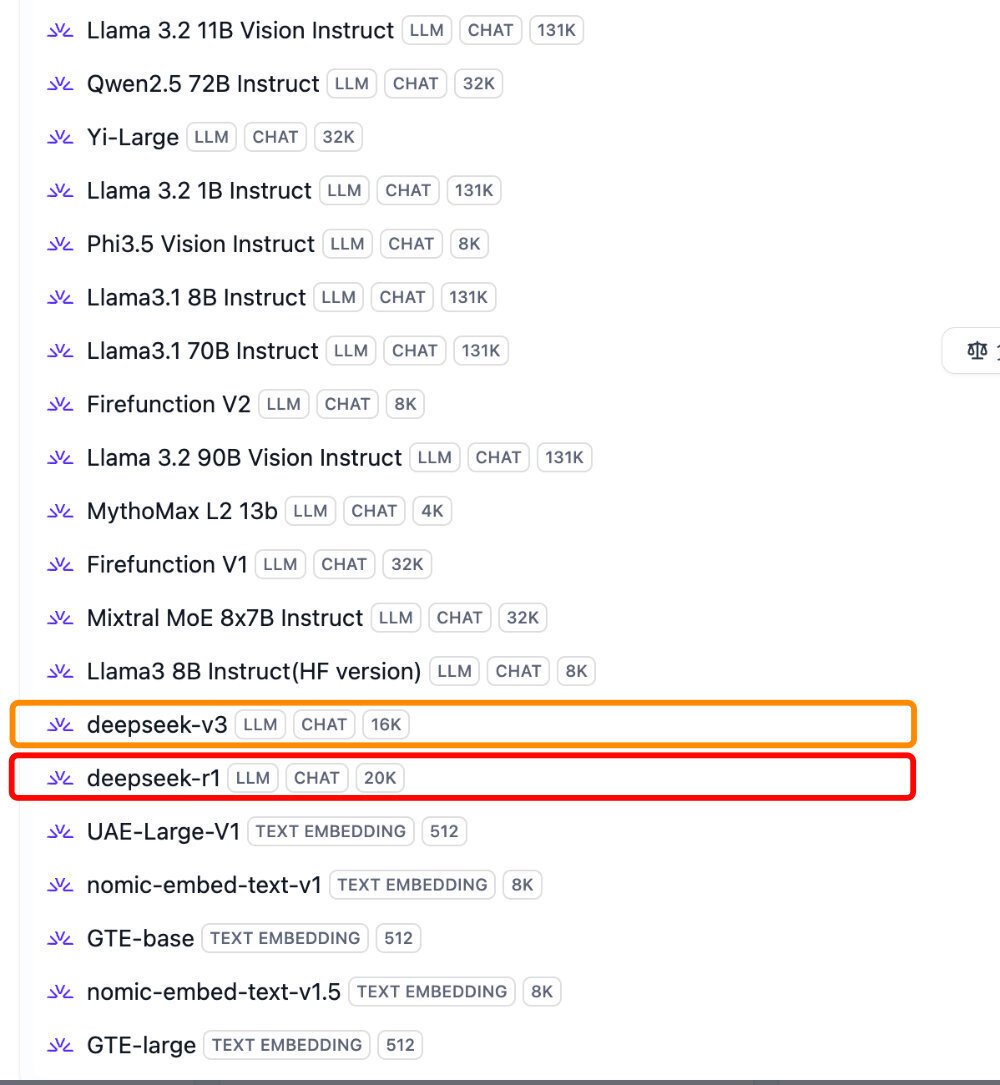

追加後のDifyでの同社のLLMリストの一部を示します。

赤枠が、DeepSeek-R1です。オレンジ枠は、以前設定したDeepSeek-V3です。

DeepSeek-R1のDify用設定例 -2 Open Router

同様に下記が設定例です。

なお、max tokens は、8kに設定しました。

Difyでの同社のモデル設定結果です。

DeepSeek-R1のDify用設定例 -3 together.ai

以下、同様です。max tokensは、16kにしました。

ただし、Dify自身の制限があるので、16k使えるかは分かりません。

together.aiはアップルをスピンアウトしたメンバーが中心となっています。

Fireworksと同様、高速対応が売りとなっています。最新のLLMへの対応も早いようです。

上記設定後のDifyでの同社関連のモデルリストです。

赤枠が、DeepSeel-R1が追加されています。なお、オレンジは、QwenのQwQ-32Bです。機能としてGeminiのThinkingモデルと同様に、考えて、Thoughts相当の出力をします。Qwen-Chatでも試すことができます。

各パラメータの設定例

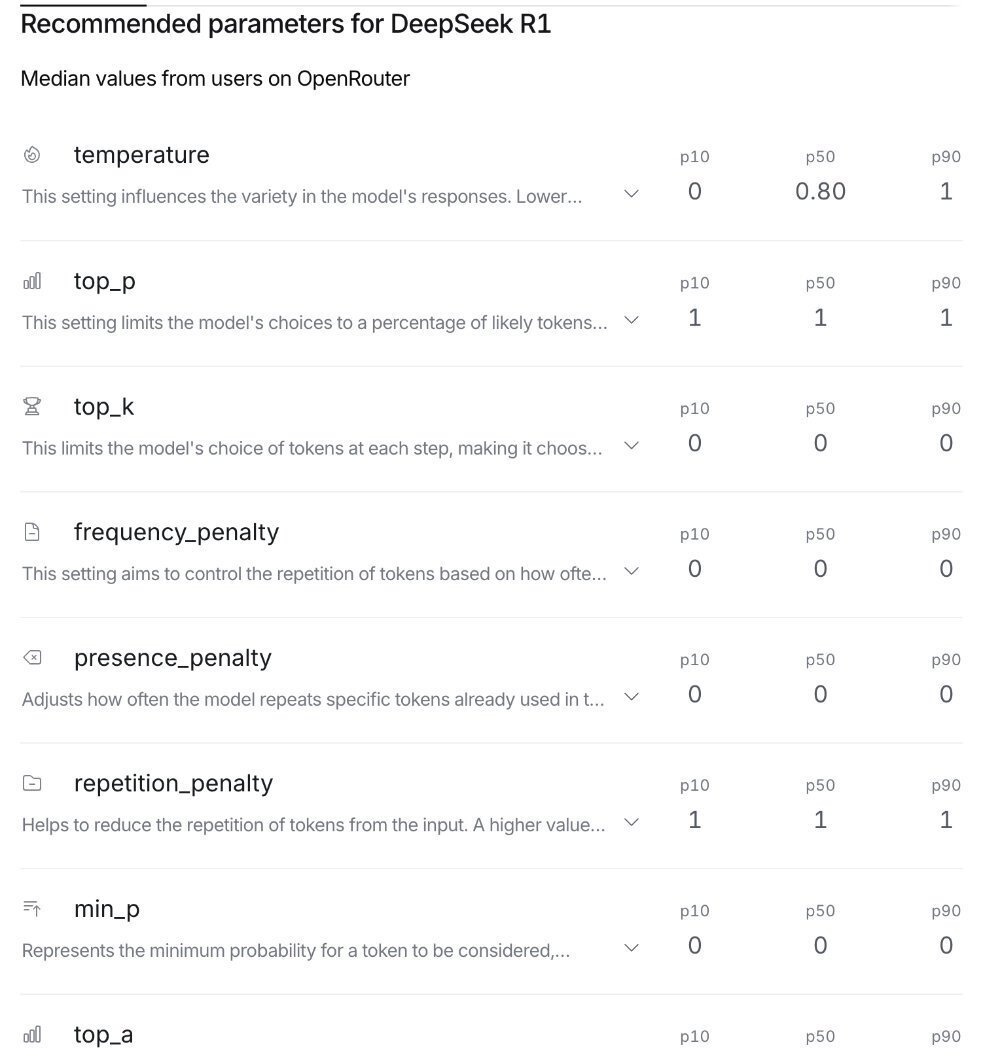

OpenRouterに書くパラメータの設定例があったので、引用します。

最後のtop_aは、その上と同様、0,0,0 とのことです。

DeepSeek-R1のチャット環境

ここになります。

下記の画面の赤枠部分をクリックするとR1が使えます。

プロンプトを入れて、動作させると、英語で、どのように考えて推論するかの手順を示した後、回答が表示されます。

GeminiのThinkingモデルのThoughtsと同様の機能です。

今の所は、英語でやりとりした後、別の手段で日本語にする方がいいようです。

DeepSeek-R1に英語で問い合わせ、英語と日本語での回答を要求すると。英語での回答の一部を省略した日本語版が表示されます。

日本語は、不得手なようです。

Qwenのチャット環境

Qwen Chatで検索すると表示されます。

詳細は、例えば、このYouTube動画に説明があります。

なお、こちらも、英語で質問して英語で回答してもらい、それを別途日本語に訳した方が無難です。日本語で質問すると中国語の回答がでてきたりします。

最後に

Difyで、ユーザーサイドにてモデルの追加が行えるプロバイダのLLMリストに、DeepSeek-R1を追加してみました。

高性能で低価格のオープン型LLMの登場です。それも、o1-previewを超えるトップレベルの性能です。

価格という点では、これまたトップレベルのGoogleの最先端LLMの価格は現時点では無料です。ただし、Googleは、いつ価格が変わるかは分かりません。もっとも、DeepSeek-R1のおかげで、無料期間が伸びるかもしれませんが。

それに比べ、こちらは、恒常的な低価格が期待できます。

また、DeepSeek-R1の短時間で安価な学習方法などによって、Llama等の他のオープン型のLLMの性能も飛躍的に伸びるかもしれません。

またQwenや01-AI、GLMなどの中国勢は、そのような急速な進化もあり得ます。

なんせ対応が早いので。

それらが相まってプロバイダの存在感が一気に増す可能性が出てきました。さらに、プロバイダ間の競争激化と共に、プロバイダの選定の重要性が増してくると予想されます。