DeepSeek-R1関連の話題、同Difyでの試用準備

はじめに

前回(昨日)DeepSeek-R1を扱っているプロバイダをリストアップして、その内でDifyで使える米国系のプロバイダ画面にDeepSeek-R1(以下R1)を追加設定しました。

今回は、Dify で使う場合のLLMの各パラメータについて、プロバイダー毎に確認、設定した上で、LLMブロック用プロンプトを設定し、簡単なチャットフローで実際にR1を試用するための準備をしたいと思います。

関連の話題

1/30のランキング状況

最近、主に3種のランキングの推移を見ているのですが、その中で、R1は、1/24にArtificial Analysisのみに2位で登場していました。さらに、本日1/30に、Chatbot Arena LLM Leaderboard(https://lmarena.ai/?leaderboard)に3位で初登場しています。

このChatbot Arena のランキングでは、Artificial Analysisとは異なり、Googleの最新のLLMが入っています。また、OpenAIでは、ChatGPT 4o-Latestがトップとなっています。

今回R1は、この3つの次の4番目に位置づけられています。点数的に3番目と近いという判断か、順位は同列3位です。o1-2024-12-17よりも一つ上です。

各カテゴリー毎のランキング

ちなみに、このサイトは、数学やライティング、コーディングなどの各カテゴリー毎のランキングも表示できます。

赤枠が、R1で緑枠がV3です。ここで、奇妙なのですが、R1は、OverAll以外全て1位です。2番目にあるGemini Exp.1206よりもMath(数学)で優っています。

でも、上から4番目。各項目で全て1位なのに、トータルで3位。

これはちょっと意味不明ですが、n数がまだ少ないからということでしょうか。先ほどの3位は、アリーナランキングですので、まだ戦いの数が少ないので、実際の能力が炙り出されていないということかと推察されます。

各言語毎のランキング

各言語毎のランキングもあります。

こちらも、全て1位です。すごいとしか言えません。次回には、アリーナランキングも同率1位で登場するかもしれません。

ちょっと、あれ?っと思ったのは、V3の中国語です。6位になっています。英語が8位で、日本語が6位。トータルランキング8位ですので妥当かもしれませんが、今後挽回してくるのではないかと思われます。

DeepSeek Janus-Pro

DeepSeekは、米国時間1月27日、テキストから画像を生成できるマルチモーダルAIモデル「Janus-Pro」をリリースした、とのことです。

これについては、プロバイダのFal経由で画像生成を実際にしてみましたが、現時点では、まず不安定で、なかなか画像生成に至らず、また、できた場合でも結果は、あまり良くありません。特に写実性には程遠いという印象です。

画像生成という観点では、他社の1年以上前のレベルと感じました。

1ヶ月ぐらいしたら、また試してみたいと思います。

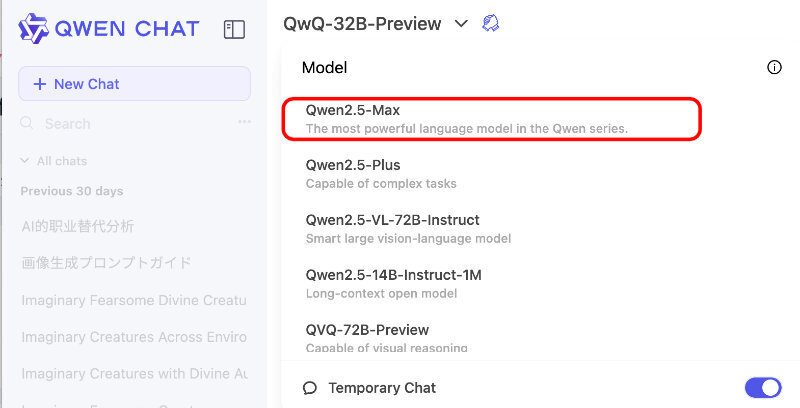

Qwen2.5Max

アリババのQwenが、Qwen2.5-maxを1/29にリリースしました。

V3よりも性能が高い、とのことです。

The burst of DeepSeek V3 has attracted attention from the whole AI community to large-scale MoE models. Concurrently, we have been building Qwen2.5-Max, a large MoE LLM pretrained on massive data and post-trained with curated SFT and RLHF recipes. It achieves competitive… pic.twitter.com/oHVl16vfje

— Qwen (@Alibaba_Qwen) January 28, 2025

これは、前回ご紹介したQwen-Chatで試すことができます。

Difyでのトライアル

まずは、Difyのもっともシンプルなフローで、DeepSeek-R1の動作を見てたいと思います。今回はそのための準備設定です。はっきり言って、本当に動作するのか?の検証用です。

DeepSeek-R1のパラメータ設定

前回、OpenRouterのHPにあった各パラメータの推奨値を再掲します。これが、ベストというわけではないと思いますが、目安として、まずは、これから始めてみます。

上記の各項目で、各プロバイダ毎に設定できるパラメータの数は少し異なっていました。

それぞれの設定例を示します。

Fireworks

DifyのLLMブロックで、FireworksのモデルリストからDeepSeek-R1を選んだ場合のパラメータリストです。

実質選択できるのは、TemperatureとMaxToken, Top Pの3つです。ここでは、TopKが最小値で1にしかならないので、設定をはずしています。

がっかりしたのは、MaxTokenです。同社HPの設定例の20kとしたのですが、表示は最大4k。OpenRouterの表示にあったFireworksの最大値の16kにもしてみたのですが、やはり最大は4kのままでした。

TogetherAI

この画面が、今回の3つの中ではもっとも設定できるパラメータ数が多くなっています。今回は、Temperature, Top P , Repetition Penaltyを設定しています。

MaxTokenですが、設定通りの16kが表示されています。

ちなみに、これは、DifyでのGoogleの各LLMよりも大きな値です。

OpenRouter

各パラメータは同様です。

MaxTokenが設定通りの8kが表示されます。

ここで、OpenRouterが取り扱っているプロバイダの最大値である16kに変えてみました。

こちらの画面で、16kが表示されています。設定できたようです。

以上の結果から、今回は、設定できるパラメータの数や、速度に期待してtogether AIをメインにしようと思います。

LLMブロックのプロンプトの設定例

次に、LLMのプロンプトを設定します。

以下のようにしてみました。これについては、下図の赤い四角で囲んだプロンプトジェネレーターの助けを借りています。

<instructions>

あなたのタスクは、問い合わせ内容を解析し、それに基づいて手順を考え、その手順に従って考察し、その結果を出力することです。以下に、その手順を詳しく説明します。

1. まず、問い合わせ内容をよく読み、理解します。問い合わせ内容の主要なポイントや要素を特定します。

2. 次に、問い合わせ内容を解析するための手順を考えます。この手順は、問い合わせ内容の特性や複雑さによります。問い合わせ内容が複雑な場合は、それを小さな部分に分解し、それぞれを個別に解析することを考えるかもしれません。

3. 手順に従って問い合わせ内容を考察します。この段階では、問い合わせ内容の各部分を詳細に分析し、それぞれの意味や関連性を理解します。

4. 最後に、あなたの考察の結果を出力します。この結果は、問い合わせ内容の解析と考察に基づいています。

出力はXMLタグを含まないようにしてください。

</instructions>

プレビュー

以上により、下記の画面の上の赤い四角で囲んだ "プレビュー" をクリックすることでチャットフローの動作を確認することができます。

上の図の下の大きな赤い四角にプロンプトを入力し、オレンジで囲んだ▶️をクリックすれば、先ほど示したフローが動作します。

以上で、DifyでDeepSeek-R3の動作確認をする準備ができました。

次回は、これにプロンプトを入力して、アウトプットを確認したいと思います。