Dify v0.14.2とAIランキングのLLMs---OpenAI vs Geminis、、DeepSeek-v3?

はじめに

昨年の12/23にDify v0.14.2がリリースされています。その前の0.14.1のリリース後、すぐにGoogleのGemini2.0Flashの新しいバージョンが出たので、早速それに対応してきました。Gemini 2.0 Flash -Thinking-exp-1219ですね。

既に、OpenAI のAPIは、o1とo1-mini等がつかえるようになっているので、Difyの最新版では、トップランキングのLLMをほぼ使えるという状況ということです。

そして、先月12月26日にDeepSeekの発表したDeepSeek-V3が年明けから話題となっています。

🚀 Introducing DeepSeek-V3!

— DeepSeek (@deepseek_ai) December 26, 2024

Biggest leap forward yet:

⚡ 60 tokens/second (3x faster than V2!)

💪 Enhanced capabilities

🛠 API compatibility intact

🌍 Fully open-source models & papers

🐋 1/n pic.twitter.com/p1dV9gJ2Sd

🚀 DeepSeek-V3 のご紹介!

これまでで最大の飛躍:

⚡ 60 トークン/秒 (V2 より 3 倍高速!)

💪強化された機能

🛠 APIの互換性はそのまま

🌍完全にオープンソースのモデルと論文

これは、オープンソースで、APIも超格安の料金体系なのに、Claude 3.5 Sonnet (Oct)とほぼ同等の性能を有する、との評価を得たからです。

また、1月1日に、プロバイダーのFireworksが、このDeepSeek-v3を使用可能になったことを発表しました。

DeepSeek V3, a state-of-the-art open model, is now available on Fireworks Serverless and Enterprise!

— Fireworks AI (@FireworksAI_HQ) December 31, 2024

🥇 SOTA open model for coding and reasoning

🥇 Best performing open model on Chatbot Arena and WebDev Arena

🧠 671B MoE parameters, 37B activated parameters

Congrats to the…

最先端のオープン モデルである DeepSeek V3 が、Fireworks Serverless および Enterprise で利用可能になりました。

🥇コーディングと推論のためのSOTAオープンモデル

🥇 Chatbot ArenaとWebDev Arenaで最高のパフォーマンスを発揮するオープンモデル

🧠 671B MoEパラメータ、37B アクティブパラメータ

このリリースに対して

@deepseek_ai

チームに祝福を!

DeepSeek V3 は Fireworks で使用するのに最適です。

ロングコンテキストが有効 - コンテキストサイズ 131K

最大 30 キロ/秒の速度で、さらに高速化します。

価格は0.9ドル/Mトークン

これは早期リリースであり、モデルの最適化を継続しています。リリース時には高い需要が見込まれるため、API エンドポイントの高速化に取り組んでいきます。量子化後のモデル品質を保証するためにいくつかの評価を実施しており、今後数日間でより包括的な評価を実施する予定です。

今すぐプレイグラウンドまたはAPI経由でモデルを使い始め、エンタープライズ展開についてはお問い合わせください。リンクは下記にあります。

そこで、DIfyのv0.14.2で、Fireworks経由で使えるようにできるか試してみました。すると、設定の、モデルを追加、でDeepSeek-v3を追加できたようなので、忘れないうちに手順等をメモしておこうと思います。

LLMs系のランキング状況等

Artificial AnalysisのLLMsランキング

まず、DepSeek-v3の位置付けを見ておきたいと思います。

1月3日のArtificial AnalysisのLLMsのランキングを示します。これは、総合能力順のソーティング結果です。

赤枠が、DeepSeek-v3です。一つ上に、オレンジ枠のClaude3.5sonnet(oct)がいます。ただし、能力の指標は、同じ80となっています。つまり同レベル。

ここで、緑で囲んだのは、私のDIfyで使えるLLMsです。AWS以外、ほぼ全てが使える状況です。もっとも、いくつかは、プロバイダ経由での契約です。

私の場合、現時点では、ちょっとずつ使えればいいので、プロバイダ契約の方が便利です。

Chatbot Arena LLM Leaderboard

ちなみに、もう一つのランキングであるChatbot Arena LLM Leaderboardの状況を示します。

こちらでは、まだDeepSeek-v3は登場していません。一つ前のv2.5が同列8位となっています。おそらく登場すれば、単独7位となるように思います。

Language Model API Providersランキング

Artificial AnalysisのAPIプロバイダのランキングを示します。

昨日の1月2日には、リストになかったFireworksが、1月3日には登場しました。これらプロバイダーは、Metaなどのオープンソース系のLLMを扱うことが多いので、性能のランキングでは、Qwen系ぐらいであまり上位に出てきませんでした。速度ランキングにすると結構上位に出てくるのですがね。

そう言った意味でも、今回のDeepSeek-v3の登場は、画期的と言えそうです。Groqなどが対応したら、相当すごいことになるかもしれません。

DeepSeek-v3のプロバイダリスト

ちなみに、OpenRouterのHPに、1月3日時点で、DeepSeek-v3のAPIを取り扱っているプロバイダのリストがありました。

これを見ると、DeepSeek自身も含め、一長一短のようです。DIfyを基準にすれば、DeepSeekかFireworksの2択となります。

先ほど述べた理由で、私の場合、DeepSeek系は今の所プロバイダ経由にしています。

ちなみに、今回気づいたのですが、OpenRouterというところは、APIベンダーの各プロバイダーと契約してユーザーとの間に立つ、というビジネスモデルのようです。

FIreworksへのDeepSeek-v3の登録

さて、本題のDIfyでの設定です。

設定画面

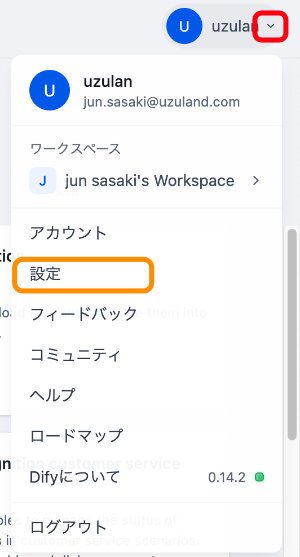

まず、Difyのどの画面にもある右上に注目です。

赤の四角で囲んだ、逆三角形をクリックします。

すると、下記の画面がプルダウン表示されます。

ここで、設定、をクリックします。

モデルプロバイダーの選択

これは、先ほ。どクリックした、設定、の画面です。

ここで、左側の、モデルプロバイダーをクリックします。

すると、今使えるプロバイダーが出てきます。

私の場合、既にFireworksにAPIを入力して、使える状態になっているので、このような表示となります。

初めての場合は、DIfyのマニュアル等を参照して、まずは、APIをゲットして、登録してください。

ちなみに、Fireworksは、高速対応等、いいプロバイダーではないかと思います。おすすめです。ランキングでも、各APIで比較的上位にいることが多いように思います。

それ以外、Graq, Fal, together, などもいいのではないか、と考えています。

モデルを追加

右側の、モデルを追加、をクリックします。

参考画面

以下の設定にあたっては、FireworksのHPの、DeepSeek-v3のところにある下記のプログラム例などを参考としました。

設定画面

最初のURLについては、上記で、黄色で囲んだ部分か、その下の赤の部分か、よくわかりませんでしたが、まずは、赤を選んでみました。

動作しているようなので、変えてません。

それと、tokenを上記の最大値で入力したのですが、結果、4096とLLMの画面で表示されました。これまた、動作原理等不明です。

真ん中の、短い枠の2つは、モデル名を中国語でいれるか、英語で入れるか、という意味のようです。中国名がわからないので、どちらも英語名を入れました。これは、Fireworksの表記ルールに従っています。

どちらも、deepseek-v3、でいいようです。

APIキーは各自のをご使用ください。

ともあれ、これで、Fireworks経由で、DeepSeek-v3が使えるようになりました。

実際に、フローを組み、プロンプトもいれて、動作は確認済みです。

今回は、以上です。