(2023/9/1 更新)AUTOMATIC1111簡単導入!PythonもGitも必要無しのスタンドアローンセットアップ法

@更新情報

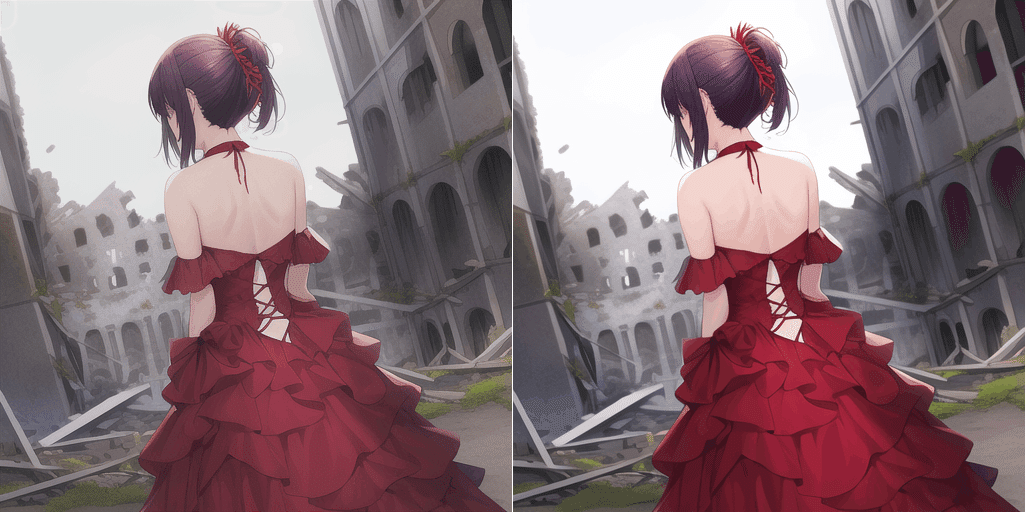

■AUTOMATIC1111 WebUIとは

AUTOMATIC1111氏という方が作った『お絵描きAI StableDiffusionをわかりやすく簡単に使う為のWebUI型(ブラウザを使用して操作するタイプ)のアプリケーション』のことです。

機能も豊富で更新も頻繁にあり、Windowsローカル環境でStableDiffusionを使うなら間違いなくコレです。本記事はその素晴らしいWebUIを公式とは違う方法で簡単に導入する為の、やや初心者向けの解説記事です。

■本記事の導入方法の特徴

1.PythonとGitインストール不要!

PythonやGitのややこしいインストール作業は必要ありません。全て内包済みの専用セットを用意してあるので、それをダウンロードしてセットアップを実行するだけ!

2.システムドライブにゴミが残らない!

通常の導入方法だとPythonやGitをインストールする関係上、ギガ単位のキャッシュや不可視ファイルなどがシステムドライブのわかりにくい場所に大量に保存されてしまいます。

この方法であれば全てのファイルや構成を1フォルダ内にまとめることができ、ファイルの管理や削除も容易になります。

3.複数の環境を簡単に使い分け!

導入が完全に独立した構造になるため、バージョン違いの環境を個別に持ったりなど、用途によって複数の環境を使い分けることが出来ます。また、本家と違い、インストール後にフォルダを移動したりフィルダ名を変更しても問題無く動きます。

ただし注意点も!よく読んで!

公式の推奨とは異なるインストール方法なので、思いもよらないトラブルが起こる可能性はゼロではありません。

特にPythonもGitもWindowsに環境変数が設定されない、いわゆる『パスが通っていない』という状態になります(※表向きはPythonもGitもインストールされていない)

また、通常であれば可能な右クリックによるgit bash here(どこでもgitコマンド)が使えません。

また、ごく一部のExtension導入後(※追加の拡張機能)で、PythonやフルバージョンのGitが入っていないことが原因でエラーが出てしまうことがあるようです。

■動作に必要なPC環境って?

・Windowsは10か11で

今現在、大抵の人が使うWindws環境はほぼバージョン10か11だと思います。一応7でも動くという話も聞いてはいますが正直オススメはしません。また、OSは32bit版ではなく64bit版前提で話をすすめます。大丈夫です。ここ数年内に買ったPCであればだいたい64bit版です。

・CPUは画像生成に無関係!?

無関係は言い過ぎですが、画像生成にはそれほど大きく影響することはありません。後述するGPUが使用出来る環境下であれば、おのずと規定以上のスペックは満たしているはずです。また、intelでもAMD

でもどちらでも大丈夫ですが、一部のハイエンドGPUを使用する場合はCPUの性能が低いことで足を引っ張ってしまうこともあるようなので、気になる方は調べてみてください。

あ、ちなみにAMDってCPUもGPUも両方作ってますけど、これはあくまでもCPUの話です。

・メインメモリは多いほうが良い?

実はメモリも直接画像生成能力には関係無いのですが、生成のための学習モデル(2〜8GBぐらいある)の読み込みや切り替えに非常に多くのメモリを消費します。ストレス無く楽しみたいのであれば32GB以上は欲しいところです。16GB程度でも動かないことはないのですが、出来る限り他のアプリケーション立ち上げず、サイズの小さい学習モデルを使うなどの工夫が必要になるかもしれません。

・HDDよりもSSD?

画像生成という部分だけであればSSDもHDDも実は大きな差はありません。

ただ、現在は追加出来る学習モデルデータも非常に増え、大容量データの読み書きが頻繁に行われることも多いので、基本的にはSSDでの運用のほうがストレスなく楽しめると思います。本導入法なら別途外付けSSDを購入してそちらにインストールしての運用というのも可能です。

ただし、インストールには最低でも20GB以上を使うため、出来れば空き容量が100GB以上あるストレージが望ましいです。

・グラフィックカード(GPU)が命

これが今回一番重要なパーツとなります。

StableDiffusion公式の推奨スペックはNVIDIA製で10GB以上のVRAMを搭載したGPUとなってはいますが、現在はAUTOMATIC1111側のオプション設定によって推奨スペックもかなり緩和されています。

GTX1000シリーズ(VRAM 2GB~)以降のGPUであれば、非常に遅いですが動作はするようです。

VRAMの容量は生成サイズや追加学習などで必要になり、多ければ多いほど出来ることも多くなります。欲を言えば12GB以上積んでいるGPUが欲しいところです。

現在AUTOMATIC1111の全ての機能が最低限全て動作するコスパ最強のGPUは『RTX 3060 VRAM12GB(およそ4~5万円)』と言われています。

一応、RadeonシリーズやGPU非搭載のPCでも導入する方法はありますが、現状Radeon自体が対応しているわけではなく非常に遅い動作となってしまい実用性はかなり低いかと思われます。よって本記事ではNvidia製GPU環境での説明のみとさせて頂きます。

グラフィックボード(グラボ)の確認方法とその見方とは(ドスパラ)

https://www.dospara.co.jp/5info/cts_str_parts_vga

グラフィックドライバは必ずお手持ちのGPUに合った最新のものをインストールしておきましょう。

Geforce公式ドライバー

https://www.nvidia.com/ja-jp/geforce/drivers/

■セットアップ

まずはセットアップ用のファイルをダウンロードしましょう。

※2023/08/24更新

インストールしたい場所に新規フォルダを作り、ダウンロードしたZIPファイルを解凍してください。

ただしデスクトップは避けてください。また、日本語を使用したフォルダや極端に長い名前のフォルダの中も避けてください。ファイル名の問題で導入や運用でエラーが出る可能性が高いです。よくわからない場合は、Cドライブの直下やDドライブの直下などが無難です。

インストールフォルダはセットアップ後でも移動が可能となっているので、容量が厳しくなってきたら別のドライブに移動させましょう。

ちなみにこの起動ファイルですが、メモ帳で中身を見るとわかる方もいらっしゃるとは思いますが、パスを再設定し、公式セットアップの流れをひとまとめにしただけのバッチファイルとなっています。

それではさっそくセットアップファイルを起動しましょう。

1_セットアップ.bat

というファイルをダブルクリックして起動すると、黒いコマンドプロンプトウィンドウが開きます。

セットアップの準備が出来たら、『 y 』キーを入力してからエンターキーを押してください。

この後、結構な容量のファイル類をダウンロードをすることになります。外出先の不安定なwifiや転送速度が極端に遅い場所などでは途中でエラーが出てしまう可能性があるので注意してください。

順調に進んだ場合、光回線で100mbps出る環境下でも15分程度かかります。気長に待ちましょう。

仮に切断などで中断しても再度『 1_セットアップ.bat』 を開始することで続きから再開出来るとは思いますが、そういった場合は念のため最初の手順からやり直したほうが良いでしょう。

インストールが無事終了すると、最後に以下のような一文が表示され

To create a public link, set `share=True` in `launch()`.

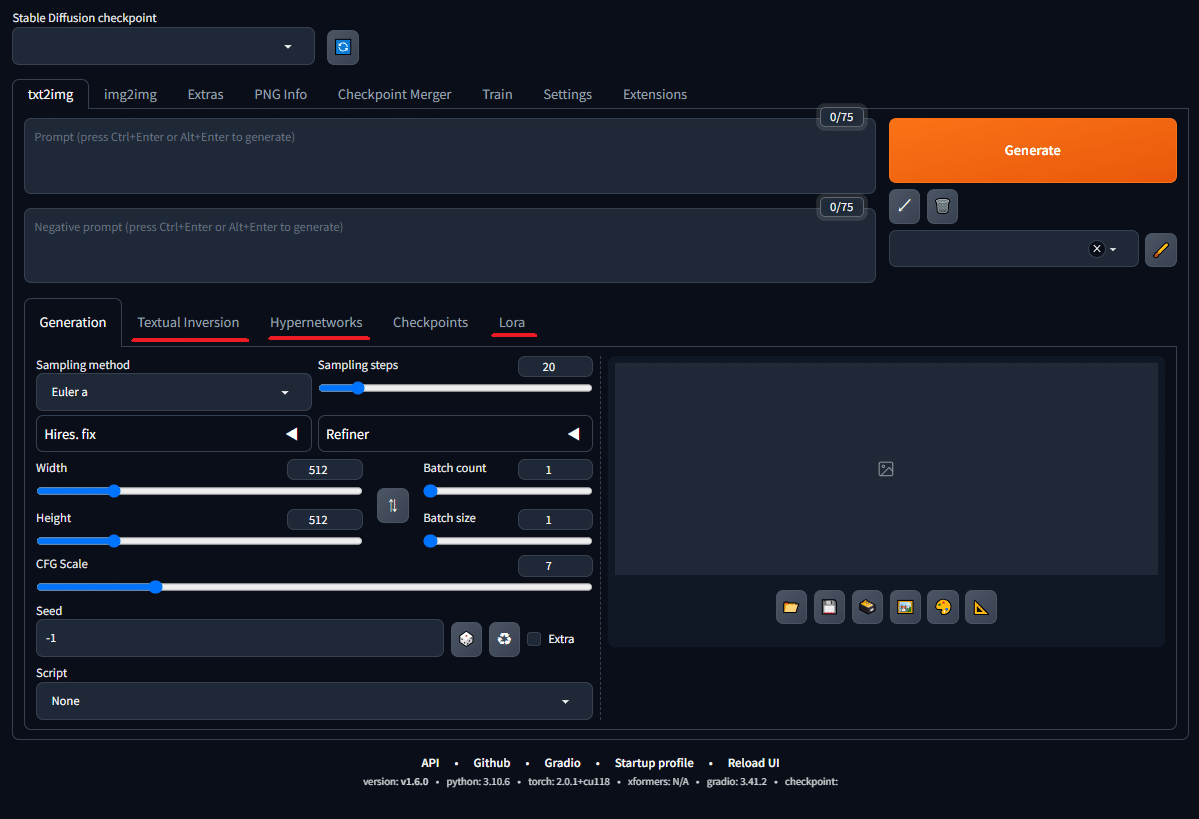

自動的にブラウザが起動してWebUIが表示されます。

これでひとまずセットアップは完了です。

ちなみにインストール中からずっと開いている黒いプロンプトウィンドウは、起動中のWebUIプログラムの本体です。

閉じてしまうとWebUIが動かなくなってしまいますので注意してください。

次回の起動からは『2_スタート_webui-user.bat』 から起動するようにしてください。

また、終了する時は、ブラウザだけでなくコマンドプロンプトウィンドウも閉じてください。

【トラブル発生!?】

もしも途中でエラーのようなものが出てセットアップが終わってしまった場合も慌てずに。

まずひとつ考えられるのは セットアップは無事完了したけどVRAM不足で起動できなかった です。

この場合はセットアップ自体は完了しているので、この記事の先のほうにある 起動オプションを追加しよう という項目を参考に、低VRAM用の設定をしてみてください。

それ以外の場合は、もしかするとダウンロードそのものが失敗してしまった可能性があります。何度か 1_セットアップ.bat を起動し直してみてください。環境や時間帯によってはざんねんながらファイルが正常にダウンロードされずにファイルが破損している場合もあるようです。

何度トライしても途中でエラーが出てしまう場合は、一旦最初の状態に戻してから再度セットアップを実行してみてください。

筆者も何度かこのトラブルに遭遇したことがあります。

削除する際は、設置済みの各モデルファイル等を以下の場所から退避させることを忘れずに。

AUTOMATIC1111 WebUIの使い方については詳しく解説しているサイトが沢山あるので当記事では割愛させていただきます。

ただ、とにかく更新の多いプログラムなので一番良いのは公式ページに頻繁に目を通すことです。

AUTOMATIC1111 公式Github

https://github.com/AUTOMATIC1111/stable-diffusion-webui

■起動オプションを追加しよう

AUTOMATIC1111 WebUIは、起動オプションを指定することで

様々な状況に対応することが出来るようになります。

特に低性能のグラフィックカードを使用している方は性能に見合ったオプション設定が必要になるので必ず設定してください。

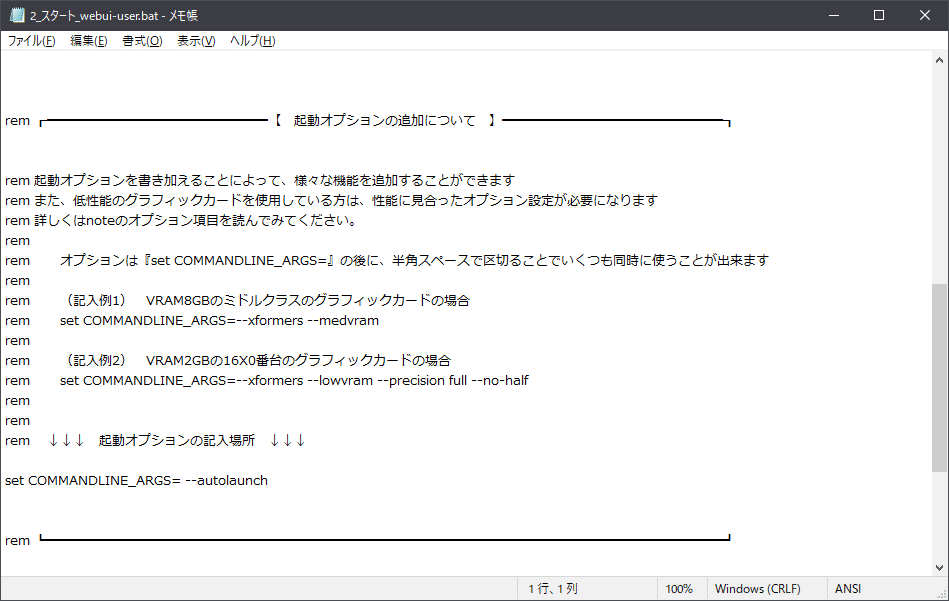

本来であれば、stable-diffusion-webuiフォルダ内にあるwebui-user.batをメモ帳で開いて編集するのですが、今回の導入方法では、

2_スタート_webui-user.bat

をメモ帳で開いてオプションを追加してください。

webui-user.bat のほうに記入しても何も効果はありません。

他所で「webui-user.batにオプションを~」となんて言われたり、解説に書いてあった場合も、2_スタート_webui-user.bat のほうを開いてオプションを追加してください。

当然ですが、『起動オプション』ですので、追加した場合はWebUIを再起動してください。

set COMMANDLINE_ARGS=

起動オプションは「set COMMANDLINE_ARGS=」の後ろに続けて記述していきます。

本セットアップの初期設定には--autolaunch(※起動時に自動的にブラウザが開かれるというオプション)がすでに記入してあります。

起動オプションを複数付ける場合は、オプションとオプションの間に半角スペースを入れてください。

また、追加後は必ずファイルを保存してからWebUIを再起動してください。

起動オプションに関しては当記事でも少しだけ紹介しますが、もっと詳しく知りたいという方は公式wikiを確認するようにしてください。

起動オプションの設定について(英語)

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Command-Line-Arguments-and-Settings#all-command-line-arguments

ちなみにオプションは今後も更新によって増減があると思われます。

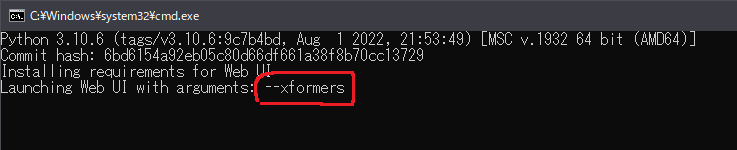

--xformers

VRAMの消費が格段に減り、画像生成速度が30%ほど速くなりますが、生成画像のクオリティが多少犠牲になります(同条件下で生成した画像でも小さな差異が出るようになってしまう)

オプションとして追加すると初回起動時にインストール作業が始まります。

--no-half-vae

VAEを使用している場合、VRAMが足りているのに時々黒い画面が生成されてしまうバグがあるようです。そういう時はこのオプションを付けることによって解決することがあります。

--precision full --no-half

グラボが16X0番台を使用時、画像の色がおかしくなる時につけてください。

--medvram

VRAMが4~6GBの場合に必須です。VRAMが少なくても生成可能になりますが、若干生成速度は落ちます。

--lowvram

VRAMが2~4GBの場合に必須です。VRAMが少なくても生成可能になりますが、若干生成速度は落ちます。

--gradio-img2img-tool=color-sketch

img2imgでカラーペイントを使用できるようになります。

--listen

起動したプログラムに対して、同ネットワーク内の別の端末(別のPCだけでなく、タブレットやスマートフォンなど)からの操作が出来るようになります。

(記入例1) VRAM8GBのミドルクラスのグラフィックカードの場合

set COMMANDLINE_ARGS=--xformers --medvram

(記入例2) VRAM2GBの16X0番台のグラフィックカードの場合

set COMMANDLINE_ARGS=--xformers --lowvram --precision full --no-half

■モデルファイルのダウンロード

・学習モデルについて

一番大事なデータであるお絵描きAIの頭脳、StableDiffusion学習モデルについていくつか知っておきましょう。

基本的には公式が作ったナンバリングモデルが存在するのですが、世間一般で使用されているモデルのほとんどは、公式モデルに追加学習を加えた派生モデルとなっています。公式モデルはあくまでもベースの汎用モデルなのでたいした出力は出来ないのです。

さらに

Ver 1.x系(1.4〜1.5)

Ver 2.x系(2.0〜2.1)

SDXL Ver1.x系(※バージョン3相当)

という3つの系統があり、様々な面において互換性がありません。

1系は最初に出たモデルということもあり派生モデルが非常に多く汎用性が高いです。現在世間一般で見る多種多様なイラストやAIグラビア等はほとんどが1系モデルを使用したものです。あと、エッチなのが得意です。

ただし、生成の基本解像度が低いので大きな解像度の生成には補助機能等が必要となります。

2系は基本解像度を高くして新機能を盛り込んだ新規格でしたが、いまいち普及せず不人気のまま役割を終えてしまいました。

SDXL系はVer3に相当する最新バージョンですが、2系の正当進化として界隈でもわりと好意的に受け入れられ、新しい派生モデルも作られ始めています。が、まだまだ1系のようなハイクオリティなモデルは登場していないようです。

初めてSDに触れる方は1.x系から派生したモデルが一番扱い易いでしょう。モデルの種類もバリエーションも非常に豊富です。あと、エッチなのが得意です。

※ 学習モデルのバージョンとAUTOMATIC1111WebUIのバージョンを混同する方が多いですが、まったく関連はありません!

現在、AUTOMATIC1111WebUIは全てのバージョンのモデルに完全対応しています。

モデルファイルの形式には、拡張子が『.ckpt』と『.safetensors』となっている2種類があります。

同じモデルであればどちらの形式でも同じ結果が生成されますが、ckpt形式は悪意のあるプログラムを埋め込むことが可能なので、見知らぬモデルをダウンロードする時はsafetensors形式のモデルをダウンロードするほうが安全です。

また、AUTOMATIC1111においてはckptよりもsafetensorsのほうが読み込みが速いです。

・StableDiffusion 公式モデル Ver 1.5

※セットアップ時に自動でインストールされています

https://drive.google.com/file/d/1ext08hsLsYoaaGLRcNcU-B2TdSYN8-DG/view?usp=sharing

・StableDiffusion 公式モデル Ver 2.1

https://huggingface.co/stabilityai/stable-diffusion-2-1/resolve/main/v2-1_768-ema-pruned.ckpt

2.x系 専用設定ファイル

v2.x系モデルを使用する場合に限り、専用の設定ファイルが必要になります。右クリックで「名前を付けてリンク先を保存」でダウンロードしてください

https://raw.githubusercontent.com/Stability-AI/stablediffusion/main/configs/stable-diffusion/v2-inference-v.yaml

設定ファイルダウンロードしたら、ファイルネームをv2.1モデルと同じ名前である

v2-1_768-ema-pruned.yaml

に変更し、v2-1_768-ema-pruned.ckptと同じ場所に置いてください

・StableDiffusion 公式モデル SDXL Ver1.0

https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0/resolve/main/sd_xl_base_1.0.safetensors

・StableDiffusion 公式モデル SDXL Ver1.0 Refinerモデル

SDXLからの新機能で、途中までをベースモデルで生成し、最後の清書をRefinerモデルに生成させるという方法が出来ました。これはそのRefine用のモデルとなります。

https://huggingface.co/stabilityai/stable-diffusion-xl-refiner-1.0/resolve/main/sd_xl_refiner_1.0.safetensors

・モデルファイルの追加

公式モデル以外にモデルを追加したい場合は、各モデルをダウンロードの後、所定のフォルダに手動で移動させてください。

モデルファイルを追加するフォルダ

AUTOMATIC1111_webui/stable-diffusion-webui/models/Stable-diffusion/

新たにモデルを追加した後は、必ずWebUIをリロードするようにしてください。

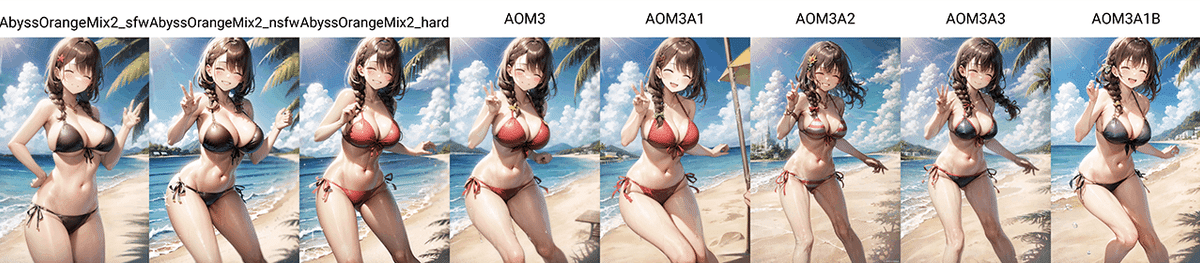

・人気の派生モデルの一部を紹介

様々な派生モデルの中から、Twitterや5ちゃんねる界隈で人気のあるモデルの一部を紹介します。用途や好みに合わせて導入してみてください。

★ ちょっと大事な話 ★

現在、沢山のイラスト系学習モデルが発表されていますが、実はそれらは有料AIお絵描きサービスである『NovelAI』から違法に流出したモデルに対し、追加学習を施したり別のモデルを混ぜたりなどして作られた、NovelAI遺伝子を持ったモデルが大半なのです。

だからといって、現状はそれらを使用することで何かを咎められるということはありません。ただ、あくまでも『そういう存在なのだ』ということを心に留め、使用に関しては自己判断で、またそれに伴ったトラブルに関しましても自己責任ということでどうかよろしくお願いしたします。

ちなみに当たり前ですがNovelAI公式は怒ってます。

また、NovelAIの学習データ自体がdanbooruというイラスト無断転載サイトからの流用だったりもするので、そういった一連の事情が一部の絵描きの方々から反感を買う要因ともなってしまっているようです。

ちなみにNovelAIはSD公式v1.4に追加学習を施した1.x系モデルなので、そこから派生した各モデルも必然的に1.x系ということになります。

・各モデルの細かな種類について

公開されているモデルによっては、学習途中のものや精度によってサイズ容量の異なる(およそ2〜8GB程度)モデルが多数公開されていることがあります。

基本的には大きく生成結果が変わることはありませんので、prunedとなっているものか、fp16のprunedを選んでおけば問題ないでしょう。容量が軽いモデルのほうがメインメモリの負担も減ります。

fp32

通称Fullモデル、どのモデルでもだいたい7GB以上ある。

理屈の上では一番高精度な結果が得られるとされている。

fp16

精度を半分に下げて容量を軽くしたモデル。

ただし生成結果はFullとたいして変わらない。

pruned

余計な情報を削除して整理したモデル。

さらに容量も軽くなっている。

・元祖 大人気2Dモデル Anything 3.0

https://huggingface.co/Linaqruf/anything-v3.0/tree/main

界隈でも一大ブームを引き起こした2Dモデルの決定版。いまだに根強いファンもいますが、最新の各モデルに比べると細部の表現が若干甘く感じるかもしれません。

・Anything バージョンアップ版「Anything-V4.5」

https://huggingface.co/andite/anything-v4.0/tree/main

別の作者によって作られたAnythingのバージョンアップ版です。

・様々なモデルを融合させた人気のミックスモデル「OrangeMixs」

https://huggingface.co/WarriorMama777/OrangeMixs

用途別(?)に分けられたイラストモデルシリーズです。某所でよく話題に上がるAOMはこのシリーズのAbyssOrangeMixのことです。

・5ch発祥、Anything派生モデル 「7th_Layer」

https://huggingface.co/syaimu/7th_Layer

Orangemixと同じく、バージョンによって細かく分かれているようです。

・日本の方が作った日本人特化の実写系モデル「ChilloutMix」

https://civitai.com/models/6424/chilloutmix

モデル作者がテレビなどでも紹介して一躍有名になったマージモデルです。

ただし現在は商用利用不可となっているので使用の際は気を付けてください。

※あくまでも色んなモデルを混ぜたマージモデルであり、レシピも公開されているので個人で同じものを作ることも可能です。

・商用利用可能なChillout系MIX「chilled_remix」

https://huggingface.co/sazyou-roukaku/chilled_remix

商用利用不可モデルを排除したマージを行うことで、限りなくChilloutmixに近く、尚且つ商用利用可能モデルとして作られたのがこのchilled_remixシリーズです。

・Beautiful Realistic Asians 通称「BRAシリーズ」

https://civitai.com/models/25494/brabeautiful-realistic-asians-v2

上記のマージモデルとは異なり、新たに追加学習を施してリアルなアジア人女性を生成出来るようにした特化型モデルです。わりと世の中に出回っている『まるで本物のようなAI画像』はだいたいこのモデルで生成されているようです。

・Hugging Face

AI学習関連全般の情報共有サイトです。StableDiffusion用の沢山のモデルデータもこのサイトを通じて共有されています。

https://huggingface.co/

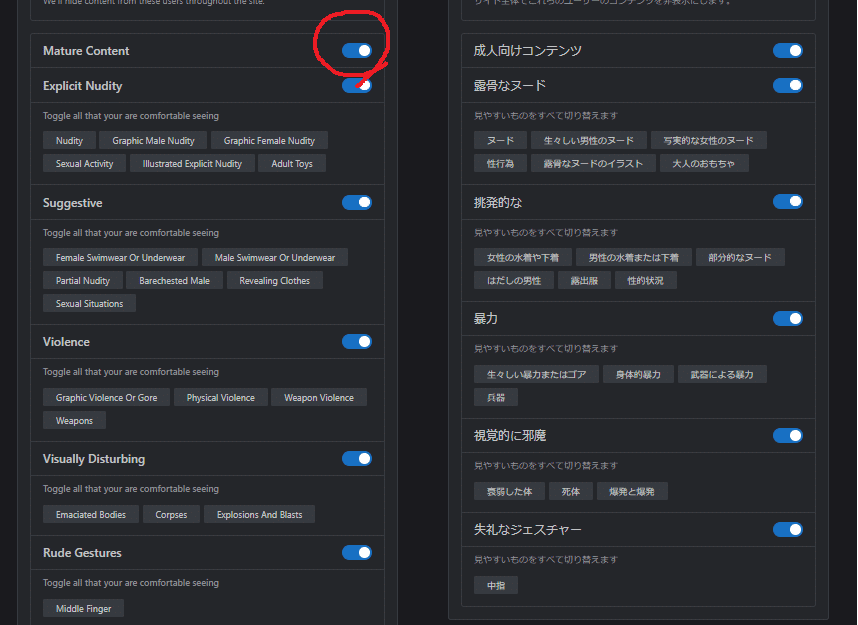

・モデル共有サイト 「Civitai」

https://civitai.com/

たくさんのモデルや追加学習ファイルが公開されているサイトです。とても便利なサイトなのでアカウントを作成しておきましょう。

(※非常に人気のあるサイトのため、時間帯によってはアクセス過多で表示が重くなることがとても多いです)

ただ、とても大きな注意点があります!

紹介したモデルを含め、共有サイトでダウンロードできるモデルや学習データは、著作権にガッツリ触れるものばかりです。それらを使って生成した画像を公開することで、どんなトラブルに巻き込まれても筆者は責任を負いません!

ご自身の為にもモラルと節度を守って使用しましょう。

また、通常設定では成人向けコンテンツが非表示になっています。

右上の設定より、Accont settingを選択し、成人向けコンテンツの表示にチェックを入れてください。

■VAEファイルのダウンロード(※オプション)

学習データには、モデルファイルの他にVAEファイルというものがあります。VAEは簡単に言ってしまえば、画像を生成する時に一部の精度を上げる為の補佐的な追加学習データのことです。大抵は1GB未満、数百MB程度のファイルとしてモデルとは別に配布されています。

種類は様々ですが、一番多いのは人物の指や目の描画をさらに向上させたり、彩度(絵の鮮やかさ)などに大きな影響があります。

VAEは実写系モデルや2Dイラスト特化モデルごとに特徴が分かれていたり、最近ではモデル自体にVAEが埋め込まれているものもあり、使用するモデルによって切り替えて使う必要があります。

StableDiffusion 1.x系 公式のVAE 主に実写系モデルに有効

https://huggingface.co/stabilityai/sd-vae-ft-mse-original/resolve/main/vae-ft-mse-840000-ema-pruned.ckpt

※ダウンロード後、拡張子を『.ckpt』から『.vae.pt』に変更してください

Anything用VAE 主に2Dイラスト系モデルに有効

https://huggingface.co/andite/anything-v4.0/resolve/main/anything-v4.0.vae.pt

Waifu-Diffusion v1-4 VAE 主に2Dイラスト系モデルに有効

https://huggingface.co/hakurei/waifu-diffusion-v1-4/resolve/main/vae/kl-f8-anime.ckpt

https://huggingface.co/hakurei/waifu-diffusion-v1-4/resolve/main/vae/kl-f8-anime2.ckpt

※ダウンロード後、拡張子を『.ckpt』から『.vae.pt』に変更してください

SDXL用公式VAE

https://huggingface.co/stabilityai/sdxl-vae/resolve/main/sdxl_vae.safetensors

VAEファイルをダウンロードしたら、モデルファイルと同じように所定のフォルダに手動で移動させてください。ただし、入れるフォルダは違うフォルダです。

VAEファイルを追加するフォルダ

AUTOMATIC1111_webui/stable-diffusion-webui/models/VAE/

■WebUIの更新(通常更新)

AUTOMATIC1111版 WebUIはいまだにアップデートが頻繁に行われているプログラムです。最近は落ち着きましたが、多い時は1日のうちに数回あったりもします。そしてよくバグも出ます。そしてバグ修正のためのアプデがあります。

そして新バージョンが公開されたとしてもお知らせをしてはくれないので、各自公式サイトを頻繁にチェックする必要があります。

AUTOMATIC1111氏のGitHub

https://github.com/AUTOMATIC1111/stable-diffusion-webui

このWebUIはGitというシステムを使用して管理されているので、更新も全てGitコマンドを使うことで出来るようになっているのですが、本導入では通常はGitコマンドが使えません。

よって、同封の更新用バッチファイルを使用してください。バッチファイルの中身は同梱のGitにパスを通してGitコマンドを実行するというシンプルなものです。

3_通常更新 (git pull).bat

どこかで「アプデがあったから~~~でgit pullしろ」なんて言われたら、このファイルを起動してください。

ただし、更新の内容によって初期設定ファイルの構成が変わったり、それどころかフォルダ構成そのものが変わったりで以前の環境がそのまま使えなくなる事態が非常に多く起こります。

後述のエラーやトラブル対応の項でも書いていますが、更新によってどうしてもエラーが出たり挙動がおかしくなった時は、諦めて再セットアップしましょう。

よくあることです。

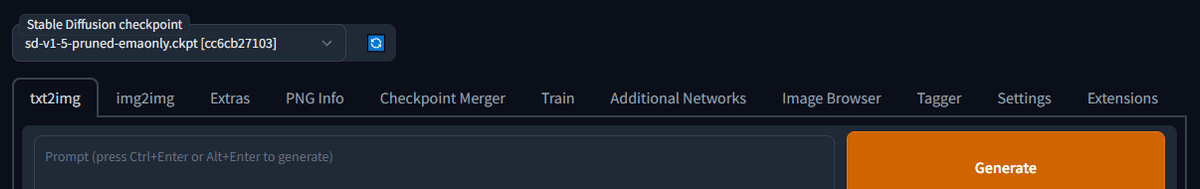

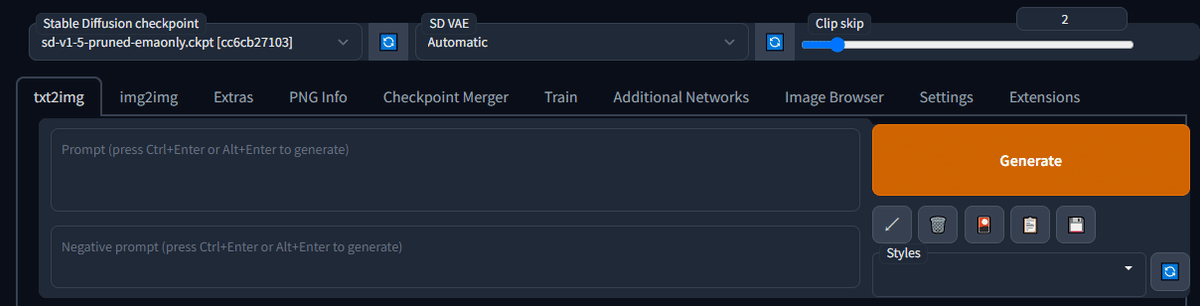

■クイック設定でモデルやVAEを簡単切り替え

SettingのUser interfaceにQuicksetting listという設定があり、そこに目的の設定項目を記入することで、その設定項目をトップ画面に持ってくることが出来るようになります。

初期設定ではモデルファイルの切り替えがのみがUIのトップに表示されていますが、WebUIを使い続けていくうちに、モデルファイルだけでなくVAEをモデルごとに手動で切り替えたいなど、色んな状況も発生すると思います。

初期設定だとsd_model_checkpointだけが項目あると思いますが、右の▼ボタンを押すことでさらに項目を選んで追加できます。

筆者は基本的にVAEの選択とCLIPの切り替えを追加しています。こんな感じでどんどん追加することが出来ます。

sd_model_checkpoint, sd_vae, CLIP_stop_at_last_layers

記入後はApply settingを忘れずに。

うまくカスタマイズすることで使い勝手もよくなっていくので色々試してみてください。

★CLIP skipって何!?★

SDでお絵描きAIを使っていくうちに必ずブチ当たる謎の壁、CLIP。

CLIP skip設定とはモデルごとに設定された設定であり、プロンプトの効果や生成結果に大きく影響します。大抵の場合は2DイラストモデルはCLIP2、実写系モデルはCLIP1かCLIP2が推奨設定になっています。場合によってはモデルごとに切り替えてみてください。

何故そうなっているかについては、話すとひじょーーーーに長くなるのでココでは割愛します。

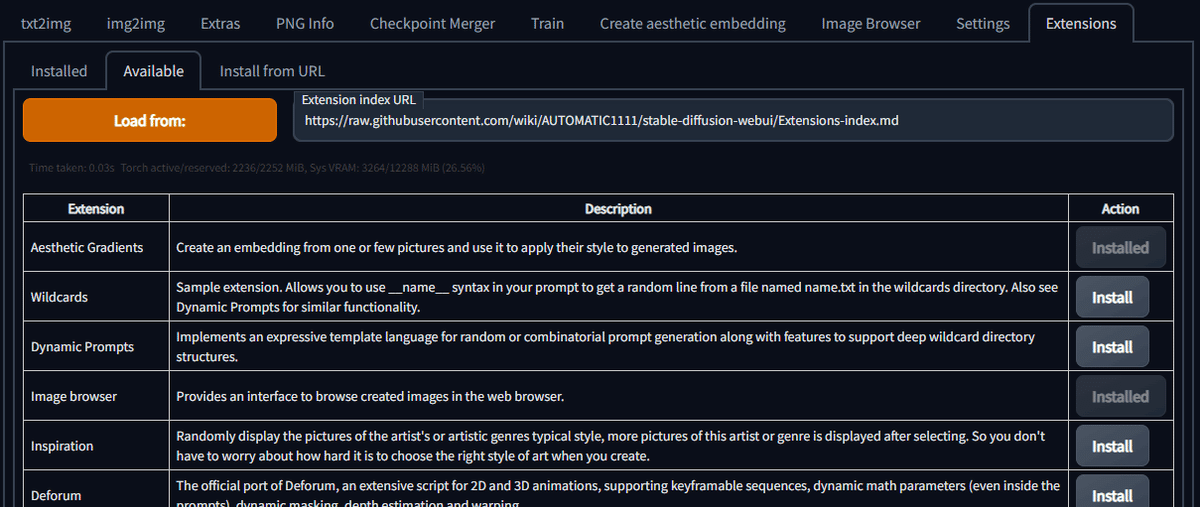

■拡張機能のダウンロード

WebUIの基本機能の他に、便利な拡張機能を追加することが出来ます。

以前は個別に自分でダウンロードしなければいけなかったのですが、現在のバージョンでは右端のExtensionsタブからインストール可能になっています。

ExtensionsタブのAvailableタブにあるオレンジ色のLoad From:ボタンを押して機能拡張一覧を読み込みましょう。

追加したい拡張機能を選択し、右のInstallボタンでインストール、そしてその後は適用するために必ずWebUIを再起動してください。

また、公式のExtension一覧にない機能拡張もInstall from URLタブより個別に導入できます。ただ、場合によってはそれが原因で未知のエラーが出る可能性もあるので気を付けてください。

インストール済みの機能拡張を削除する時は

AUTOMATIC1111\stable-diffusion-webui\extensions

以下にある該当フォルダを手動で削除してからwebuiを再起動してください。

詳しくは公式のWikiに目を通してみてください

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Extensions

説明は書いてある通りですが、慣れてない方にはよくわからないものも多いかと思います。なので、特に便利だったり初心者に有用なものだけ一部だけ紹介しておきます。

【 Image browser 】

履歴閲覧ブラウザを追加します。

履歴だけでなく、一覧からPNG info を取得出来たりと非常に使い勝手が良いブラウザなので、最低でもこれだけは導入しておきましょう。

ただ、Extension一覧からインストール出来るimage browserはwebuiの更新に対応できていないようなので、改良版であるAlUlkesh氏版を使用することをオススメします。

https://github.com/AlUlkesh/stable-diffusion-webui-images-browser

【 WD14-Tagger 】

Danbooruタグを元に、画像から逆引きでタグを探し出してくれます。真似したいイラストの再現だけでなく、学習素材として集めた画像にまとめてタグをつけてくれるなど便利機能満載です。今後学習をやろうという方は必ず導入することになると思います。

【 ControlNet 】

ControlNetとは、プロンプトを入力する際に、ポーズや深度情報、輪郭情報などを指定できる新機能です。プロンプトや単純なイメージToイメージだけでは生成不可能だった複雑な構図の指定や、比較的自由の効く人物のポーズ指定など、今まで以上に画像生成の可能性を広げてくれると思います。

ControlnetはAUTOMATIC1111公式版もあるのですが、導入手順がとてもややこしくてトラブルも多く、公式としても別の方(ミクビル氏)が構築したバージョンを勧めているようです。

正直、Controlnetに関しては別の方の記事とか参考にして導入してみてください…詳しく説明すると膨大な量になるんです。

・インストール方法

extension(拡張機能)タブのInstall from URLを選択し、以下のURLを入れてインストールボタンを押します。

https://github.com/Mikubill/sd-webui-controlnet.git

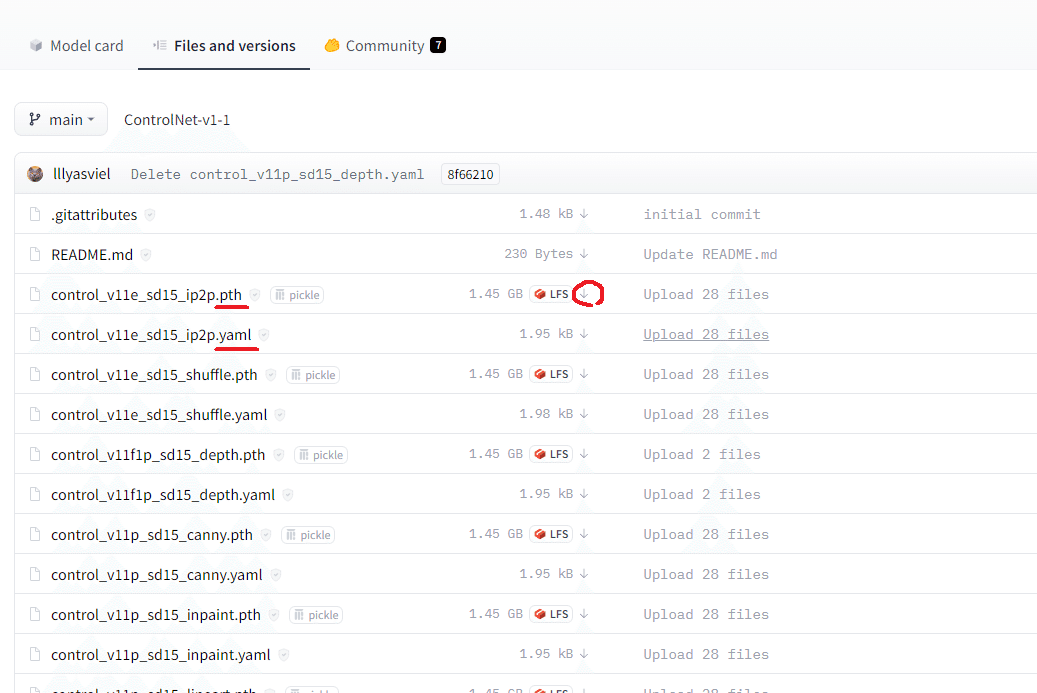

次に、以下より事前トレーニングモデルを全てダウンロードし、所定のフォルダ内に入れて、WebUIを再起動します。

事前トレーニングモデル

https://huggingface.co/lllyasviel/ControlNet-v1-1/tree/main

〇〇〇〇.pth となっているファイルと、〇〇〇〇.yaml となっているファイルの両方をダウンロードする。

ただし、右クリックで保存するのではなく、下向きの矢印ボタン を押してダウンロードしてください。

ダウンロードしたモデルを入れるフォルダ

AUTOMATIC1111_webui/stable-diffusion-webui/models/Controlnet/

詳しい使い方等についてはミクビル氏のリポジトリを読んでみてください。

ミクビル氏によるControlnet Extension

https://github.com/Mikubill/sd-webui-controlnet

■UIの日本語化について

実はAUTOMATIC1111webuiはとても簡単に日本語化ができます。

ただ、筆者としてはあまり日本語化はオススメしていません。一番の理由は、公式サイトやwiki、海外や他サイトの解説等がわからなくなるからです。

なので、出来ることなら英語のまま覚えて使用することを強くオススメしたいのですが。まぁ、でもやっぱり日本語がいいですよね?

というわけで導入方法です。

まず、ローカライズファイルは全て拡張機能扱いになっているので、ExtensionタブのLoad Fromボタンを押し、インストール可能なExtensionを読み込んでください。その際、初期設定ではローカライズファイルが隠す設定になっているのでそのチェックを外し、全てのローカライズファイルが表示されるようにします。

一覧の中からja_JP LocalizationというExtensionをインストール

Apply and restart UIをクリックしてwebuiを再起動します。

次はsettingタブに移動し、User interfaceの項目の一番下、Localizationからjp_JPを選択します。もしも何も表示されない場合は、右端の再読み込みボタンを押してみてください。

■追加学習について

AUTOMATIC1111は各種の追加学習機能に対応しており、マシンスペックさえ足りていればwebui単体で追加学習を行い、画像生成に反映させることが出来ます。

対応している追加学習機能

Hyper Network

Textual inversion

Dream Booth ※Extensionにて追加

LoRA(Low-Rank Adaptation)※Extensionにて追加

他、Locon、LoHAなど複数の改良版が存在

公式wikiによる学習項目の解説

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Textual-Inversion

各トレーニング方法についての説明はとても長くなってしまうので本記事では割愛しますが、すでに他の方々がトレーニングした学習済みファイルがあれば簡単に生成結果に反映させることが出来るようになります。

詳しい使用方法に関しては、Googleで

AUTOMATIC1111 LoRA

などで調べてください。丸投げですスイマセン。

Civitai(モデル共有サイト)などに沢山の学習済みデータが公開されています

https://civitai.com/?query=LoRA

■エラーやトラブルについて

!なんかエラーみたいなのが出て起動しない!

RuntimeError: CUDA error: device kernel image is invalid

CUDA kernel errors might be asynchronously reported at some other API call,so the stacktrace below might be incorrect.

For debugging consider passing CUDA_LAUNCH_BLOCKING=1.OSError: Unable to load weights from pytorch checkpoint file for 'D:\AUTOMATIC1111_webui\.cache\huggingface\transformers\インストール後に↑ようなエラーが出ていたのなら、残念ながら一部のファイルのダウンロードに失敗してしまったようです。

仕方がないので、ダウンロードしたファイルを全て削除し、もう一度最初の手順に戻ってセットアップをやり直してみてください。

ファイル類を削除する際は、各モデルファイル等を退避させることを忘れずに。

!更新したけど新機能が反映されない!

AUTOMATIC1111においてはよくあることです。

上記2つのやり方の場合、WebUIの個人の設定が書き込まれている設定ファイルは更新されません。古い設定ファイルのままだと、新機能そのものが使えない、ということが起きます。なので、そういった場合は

stable-diffusion-webuiフォルダを開き、

config.json

ui-config.json

という2つのファイルを削除してから再起動してください。

設定は初期設定に戻ってしまいますので注意してください。

!更新してもエラーが出たままだよ!

AUTOMATIC1111においてはよくあることです。

慌てずに再セットアップしましょう。はい、最終手段です。といっても最初から全ての手順をやり直すわけではありませんのでご安心を。

stable-diffusion-webuiフォルダ内のvenvというフォルダを削除し、もう一度プログラム類だけをダウンロードし直します。

venvフォルダを削除したら、

1_セットアップ.bat

を再度使用することで、プログラム類だけを再インストールすることが出来ます。ただし、またセットアップ時と同じぐらいダウンロードに時間がかかるので注意してください。

! 画像生成できたけど真っ黒な画像しか出ない!

生成する画像サイズが大きすぎるか、もしくは16X0番台のグラボを使用しているか、ともかくVRAM不足の可能性が高いです。

生成する画像サイズを小さくしてみるか、環境にあった起動オプションを追加してWebUIを再起動してみてください。

!それでも時々真っ黒な画像が出てくるよ!

起動オプションの項目を読みながら --no-half-vae 追記してみてください。

!MSVCP140.dllがみつからないって言われた!

「MSVCP140.dllが見つかりませんでした。」

「VCRUNTIME140.dllが見つかりませんでした。」

「api-ms-win-crt-runtime-l1-1-0.dllが見つかりませんでした。」

「エントリポイントがProcedure に見つかりませんでした。」

などのエラーが出る場合は、

Visual Studio 2015、2017、2019、2022 の再頒布可能パッケージ

をダウンロードしてインストールのうえ、PCを再起動してください。

このプログラムは、主にゲームの他、様々なアプリケーションを動かすために必ず必要になるプログラム群なので入れておいて間違いはありません。

!有料サービスのNovelAIが無料で使えるって本当?!

AUTOMATIC1111 WebUIは流出したNovelAIのデータに完全対応しており、公式と同じ結果を再現できることは確かです。

ただデータの出どころがかなりグレーな為、当記事で紹介することはできません。

Googleで検索すれば情報はいくらでも出てきます。ただし、何が起きても全ては自己責任でお願いします。

とはいえ、もうすでに世の中にはリークモデルを元にしたモデルがガンガン出回ってるんですけどね…

!『openOutpaint』という機能拡張でエラーが出る!

この環境下でopenOutpaintというextensionを追加すると、Outpaint起動時にエラーが出てしまうことが確認されています。原因は『セットアップ用ファイルに同梱しているGitの機能不足』にあるようです。よって、openOutpaintを使用したい場合は別途フルバージョンのGitを導入する必要があります(※インストーラーではなくフォルダ解凍形式のものがありますのでご安心を)

PortableGit 64bit版

https://github.com/git-for-windows/git/releases/download/v2.39.1.windows.1/PortableGit-2.39.1-64-bit.7z.exe

exeを起動しそのままOKをクリックをして解凍しましょう(※下手に解凍先を選ぶと、指定フォルダ内に中身を全てぶちまけてしまう為)

解凍して出てきたPortableGitというフォルダの名前をminiGitに変更し、AUTOMATIC1111_webuiフォルダ内に同梱してあるminiGitフォルダと入れ替えてください。そのうえで再度openOutpaintをExtensionからインストールしてみてください。

あとがき

前回、「どうにかしてPythonやGitをインストールせずAUTOMATIC氏のwebuiを導入する方法を広めたい」という想いで記事を書きましたが、

「余計なトラブルを避けるためにもちゃんと公式通りに導入すべき」

という意見も少なからず出たようです。

ご指摘はごもっとも。基本的にはその通りです。

そのほうが想定外のトラブルも少ないですし、なにより他所での解説や、他の方々からのアドバイスも受けやすいことでしょう。

ただ、最近はあまりPCに詳しくない状態でWebUIを導入し始めている方々もちらほらいらっしゃる様子。

であればこそ、筆者としてはそういった方々にこそわかりにくい謎のファイルやキャッシュ類を残さない導入方法をオススメしたいのです。

まずは簡単な方法でAIやWebUIに触れ、それらを扱う中で新たにAI学習や開発環境などに興味を持ったのであれば、その時にあらためてPythonやGit等を導入してみても良いのでは、と考えておりますので何卒ご理解いただけたらと思う次第です。

(追記)

と思っていたら、公式から同じ方法論のインストーラーが出ましたよ!

これでもう誰にも文句は言わせません。

ただ、公式版はほんの少しだけCドライブにゴミが残るのです。それと、通常であれば仮想環境としてvenvフォルダが作られるところを、pythonフォルダに全てぶちこんでしまうという仕様のため、更新でエラーが出た時にvenvだけ消して再セットアップが出来ないなどやや不便なところもあるかもです。今後改善してくれるといいのですが。

公式版ワンクリックインストーラー v1.0.0-pre

https://github.com/AUTOMATIC1111/stable-diffusion-webui/releases/tag/v1.0.0-pre