[実行用プログラム公開] 21の多クラス分類手法を一気に実行して結果を比較する!ダブルクロスバリデーションによる評価付き (Python言語)

[New] 実業家としても有名な堀江貴文さん(ホリエモン)のメルマガ[Vol.359]における副業紹介において、このプログラム・コード販売が、なんと 1番 に紹介され評価していただきました!

こんにちは!大学教員ブロガーのねこしです。http://univprof.com/

仕事や研究において、多クラス分類をしたい方もいらっしゃると思います。でも、たくさん手法もあってどれを使えばよいか、迷いませんか?こっちのクラス分類手法のがよいのかな・・・、と考える人も多いはずです。

どんなときはどうすればよいのでしょうか?答えは、下の記事でも書かれているように、すべての多クラス分類手法を実施して、結果を比較すればいいんです。

http://univprof.com/archives/16-11-18-8441806.html

それはわかったけど、どうやって実行すればよいの? って人のために、21の多クラス分類手法をすべて実施して、結果を比較するプログラムを作りました!データを準備して実行すれば、すべて自動的に行われます!

21の多クラス分類手法はこちらです。

1. 線形判別分析(Linear Discriminant Analysis, LDA) http://univprof.com/archives/16-05-30-3588648.html

2. 多クラス線形サポートベクターマシン (Linear Support Vector Machine, LSVM)

3.多クラス非線形サポートベクターマシン (Non-Linear Support Vector Machine, NLSVM)

4. 二次判別分析 (Quadratic Discriminant Analysis, QDA)

5. k近傍法によるクラス分類 (k-Nearest Neighbor Classification, kNNC)

6. 単純ベイズ分類器 (Naïve Bayes, NB) http://univprof.com/archives/16-07-10-4585774.html

7. 決定木 (Decision Tree, DT) http://univprof.com/archives/16-05-25-3464187.html

8. ランダムフォレスト(Random Forests, RF) http://univprof.com/archives/16-04-06-2889192.html

9. Gaussian Process Classification (GPC)

10. LDAに基づくバギング(アンサンブル) (Bagging[LDA])

11. LSVMに基づくバギング(アンサンブル) (Bagging[LSVM])

12. NLSVMに基づくバギング(アンサンブル) (Bagging[NLSVM])

13. QDAに基づくバギング(アンサンブル) (Bagging[QDA])

14. kNNCに基づくバギング(アンサンブル) (Bagging[kNNC])

15. NBに基づくバギング(アンサンブル) (Bagging[NB])

16. DTに基づくバギング(アンサンブル) (Bagging[DT])

17. GPCに基づくバギング(アンサンブル) (Bagging[GPC])

18. LSVMに基づくAdaptive Boosting (AdaBoost[LSVM]) http://univprof.com/archives/16-07-01-4380227.html

19. NLSVMに基づくAdaptive Boosting (AdaBoost[NLSVM]) http://univprof.com/archives/16-07-01-4380227.html

20. NBに基づくAdaptive Boosting (AdaBoost[NB]) http://univprof.com/archives/16-07-01-4380227.html

21. DTに基づくAdaptive Boosting (AdaBoost[DT]) http://univprof.com/archives/16-07-01-4380227.html

このように代表的な多クラス分類手法が揃っております。一通りのデータ分析・解析ができるってことです。ちなみに今回はクラス分類の中でも”多”クラス分類ですので、サンプルのカテゴリは2種類以上になります。

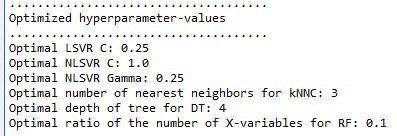

もちろん、クロスバリデーションにより、

■LSVMにおけるC

■NLSVMにおけるC・γ

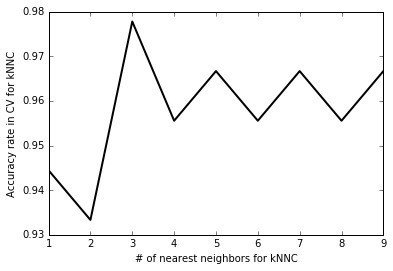

■kNNCにおけるk

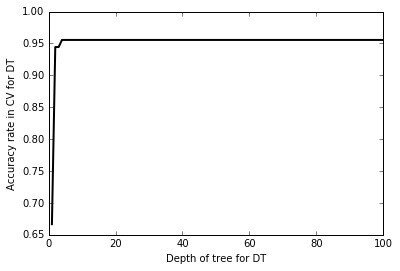

■DTにおける決定木の深さ

■RFにおける各決定木で使う説明変数の割合

を最適化しており、その結果も出力されます。

最後は、ダブルクロスバリデーション http://univprof.com/archives/16-06-12-3889388.html により各手法の予測性能を評価します。つまり、至れり尽くせりなプログラムになっております。

ダブルクロスバリデーションにはサンプル数が多いと少し時間がかかるため、ダブルクロスバリデーションを省略することもできます。

データ形式・必要なソフトウェア

以下の記事に示す形式のデータ(data.csv, data_prediction1.csv, data_prediction2.csv)さえ準備すれば、Python言語で21のニクラス分類手法をすべて実施して結果を比較することが可能です。

https://note.mu/univprof/n/n694487325cb1

Python言語のために必要なソフトウェアは以下の記事をご覧ください。

https://note.mu/univprof/n/nb07629b23252

実行結果

実行したあとに保存されるcsvファイルとその内容をまとめます。

■CalculatedY.csv ・・・ それぞれのクラス分類手法におけるモデル構築用データの目的変数の計算値

■PredictedYcv.csv ・・・ それぞれのクラス分類手法におけるモデル構築用データの目的変数のクロスバリデーション予測値

■PredictedY1.csv ・・・ それぞれのクラス分類手法における予測用データ1の目的変数の予測値

■PredictedY2.csv ・・・ それぞれのクラス分類手法における予測用データ2の目的変数の予測値

■StatisticsAll.csv ・・・ それぞれのクラス分類手法におけるモデル構築用データ・クロスバリデーション・予測用データ1のそれぞれ正解率

■PredictedYdcv.csv ・・・ それぞれのクラス分類手法におけるモデル構築用データの目的変数のダブルクロスバリデーション予測値 http://univprof.com/archives/16-06-12-3889388.html (省略可能)

■StatisticsDcvAll.csv ・・・ それぞれのクラス分類手法におけるモデル構築用データのダブルクロスバリデーション後の正解率 (省略可能)

■本プログラムのディレクトリ(フォルダ)に、”ConfusionMatrixes”というディレクトリ(フォルダ)が作られ、そこにCalculatedY.csv・PredictedYcv.csv・PredictedY1.csv・PredictedYdcv.csvのそれぞれに対応するすべてのクラス分類における目的変数の実測値と予測値との混同行列 (4×21=84つ) のcsvファイルが保存されます。

実行結果を下に示します。

決定木によって得られたルールを見るためには、DTResult.dotというファイルをGraphvizというソフトウェア(アプリ)で開く必要があります。Graphvizをインストールされていない方は、こちらからダウンロードしてインストールしてください。

http://www.graphviz.org/Download..php

この他、ここには載せませんが、CalculatedY.csv・PredictedYcv.csv・PredictedY1.csv・PredictedYdcv.csvのそれぞれに対応するすべてのクラス分類における目的変数の実測値と予測値との混同行列 (4×21=84) も出力されます。

プログラム公開

ここまでお読みいただきありがとうございます。

Python言語のプログラムは有料コンテンツとします。ただ、こちらのプログラムのように代表的な21の多クラス分類手法をすべて実施して結果を比較できるプログラムは他にありませんし、2,3の多クラス分類手法だけでもそれが可能なソフトウェアを購入すると、数万円や数十万円かかることがあります。さらに、こちらのプログラムからスタートしてさらにプログラミングを進めたいと考えている方も活用可能です。

人気が出てきたら値段を上げてみるかもしれません。しかし、それにしても かなりお得なプログラムです。21もの多クラス分類のプログラムを、自分で書くことなくすぐに使えるようになるんです。十分、元がとれます。

こちらからプログラムのzipファイル自体はダウンロードできます。

http://univprofblog.html.xdomain.jp/code/mclass_analysis_all_e_python_pass.zip

購入していただくと解凍のためのパスワードがありますのでそちらをご利用ください。

またこちらのzipファイルに必要なスクリプトと関数があります。パスワードはかけていません。購入後に使い方の説明があります。

http://univprofblog.html.xdomain.jp/code/supportingfunctions.zip

ここから先は

¥ 9,800

Amazonギフトカード5,000円分が当たる

この記事が気に入ったらチップで応援してみませんか?