画像を見ながらおしゃべりできるMiniGPT-4の論文を読んだ

こんばんは。ぴんだ(@884deep)です。

MiniGPT-4、とりあえず動かしてみた

Minigpt-4

画像も入力できて、画像をみながらお話できるAIです。すげえ。

まずは使ってみました。ブラウザで試せます。

おお~、すごい。結構わけわかんない画像なのにちゃんと説明してくれます。なんとなく、英語のほうが安定しそうなので英語で聞いてみたら丁寧に答えてくれました。

こんな感じの会話をしてます。

わたし:これはなんですか?

MiniGPT-4:この画像は、顔がピクセル化され、テキストが日本語で書かれていることから、デジタルアート作品または加工されたものと思われる。追加情報がない限り、画像の意味や文脈を判断することは困難である。

わたし:この画像は不気味ですが、この画像にインスパイアされた何かストーリーを書いてください。

MiniGPT-4:昔々、ある山奥の小さな村に、ユキという少女が住んでいました。彼女は繊細な顔立ちと、人の心を見透かすような鋭い瞳で知られていました。その美しさとは裏腹に、ユキは友達もいない孤独な少女だった。

ある日、彼女は市場から家に帰る途中、奇妙なピクセル化されたマスクに出くわした。赤と黒のデザインは、見る見るうちに変化し、動いていく。最初は躊躇していたものの、ユキはその誘惑に勝てず、マスクをつけてみることにした。

装着した途端、不思議な感覚に襲われた。まるで自分が自分でなく、まったく別の人間になってしまったかのような感覚だった。マスクは彼女の顔を覆い隠し、冷たく無感情な表情に変えてしまったようだ。

しかし、何かがおかしいという感覚は拭いきれなかった。まるで自分の周りの世界がピクセルとコードでできているかのように。自分の考えや感情さえも、1と0の羅列に見えてきた。(続くみたい)

論文を読んだ

中身はどうなっているのか、論文を読んでみました。

キング・アブダッラー科学技術大学(King Abdullah University of Science and Technology)というところから出ている論文です。

MiniGPT-4/MiniGPT_4.pdf at main · Vision-CAIR/MiniGPT-4 · GitHub

アブスト

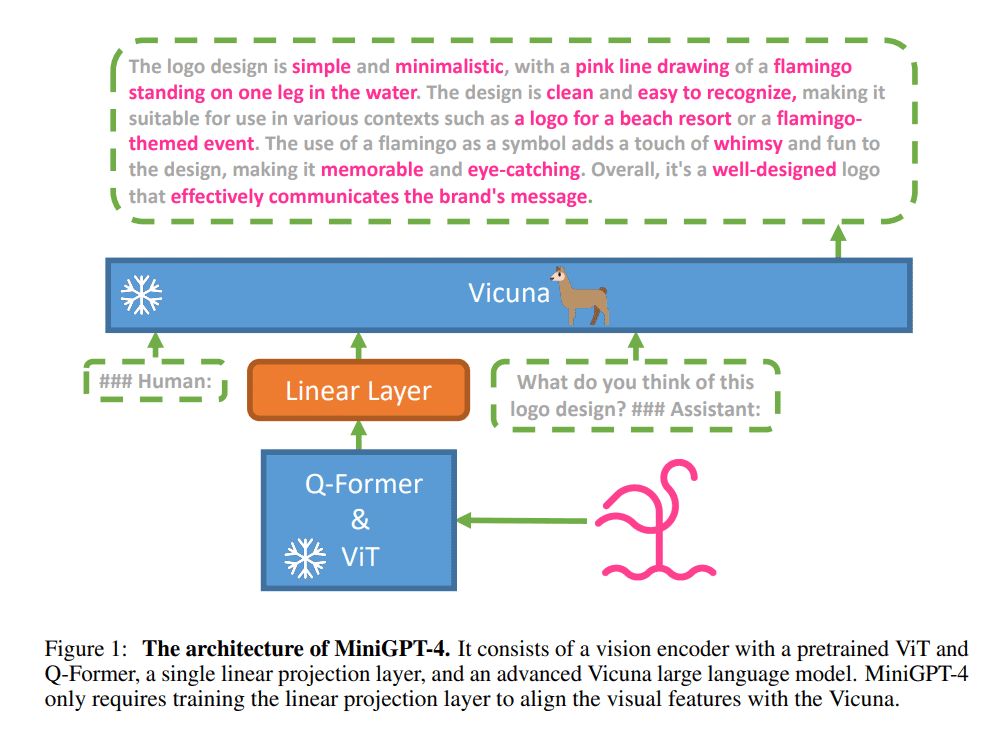

MiniGPT-4は、視覚エンコーダ(画像を理解する部分)と言語モデル(文章を理解・生成する部分)を組み合わせたモデル。

MiniGPT-4は、GPT-4と同じような機能を持っていて、詳細な画像の説明を生成したり、手書きの原稿からウェブサイトを作成したりできる。

ただし、画像とテキストのペアで学習するだけでは、繰り返しや断片的な文章が出力されることがあった。会話型のテンプレートを使って、高品質なデータセットでモデルを調整(ファインチューニング)することで、より自然な文章を生成できるようになりました。めでたし。

モデルの構成

MiniGPT-4は、事前学習済みの視覚エンコーダと高度な大規模言語モデル(Vicuna)を組み合わせてる。

ちなみにVicunaは、UC Berkeleyとかが作ったLLM。ChatGPTを100%としたとき、90%以上の精度がでるらしい。学習にかかったコストはなんと約$300!

Vicuna: An Open-Source Chatbot Impressing GPT-4 with 90%* ChatGPT Quality | by the Team with members from UC Berkeley, CMU, Stanford, and UC San Diego (lmsys.org)

で、そのままだといろいろ問題があったので、fine tuningしたらうまくいったらしい。

GPT-4ではないんすね

MiniGPT-4とかいって、GPT-4ではないんですね。GPT-4みたいに画像入力できますよってことか。だからMiniなのね。なるほど。