新手法「TAID」によって学習された小規模日本語言語モデル「TinySwallow-1.5B」by Sakana AI

Sakana AI

個人的にはThe AI Scientistで注目しているSakana AIは、元Googleのデビッド・ハ氏とライオン・ジョーンズ氏、伊藤練氏らによって設立された日本のIT企業です。

日本でのAIの民主化を目指す、創業わずか1年でユニコーン企業となったスタートアップです。同社は「高性能なモデルをより身近なものにすることで、AIの恩恵をより多くの人々が享受できる世界の実現を引き続き目指します」とミッションを掲げており、日本政府からスーパーコンピューティング補助金を受け、自然界の現象やプロセスから着想を得て設計された人工知能(AI)プロジェクトで3000万ドル(およそ46億円)ほとの資金調達しています。

「時間適応型補間蒸留」でローカル利用可

日本のIT企業Sakana AI(サカナエーアイ)がパソコン、iPhoneやiPadでもローカルで利用できる実験モデルを発表しました。

非常に高性能な小規模日本語言語モデル「TinySwallow-1.5B」は、「TAID」という画期的な学習方法が取り入れられているそうです。そのTAID(Temporally Adaptive Interpolated Distillation:時間適応型補間蒸留)というのは、Sakana AIが開発した新しい「知識蒸留」の手法です。DSでも話題となった「蒸留」ですが、Sakana AIは他社のものを勝手に蒸留したわけではありません。

知識蒸留とは

そもそも、知識蒸留とは、大規模言語モデルから小規模言語モデルへ知識を移す手法で、膨大な生成AIの最適な回答をコピーしていくのではなく、それに加えて文脈的に自然な選択肢も示すという「物の考え方」を学習させる手法です。

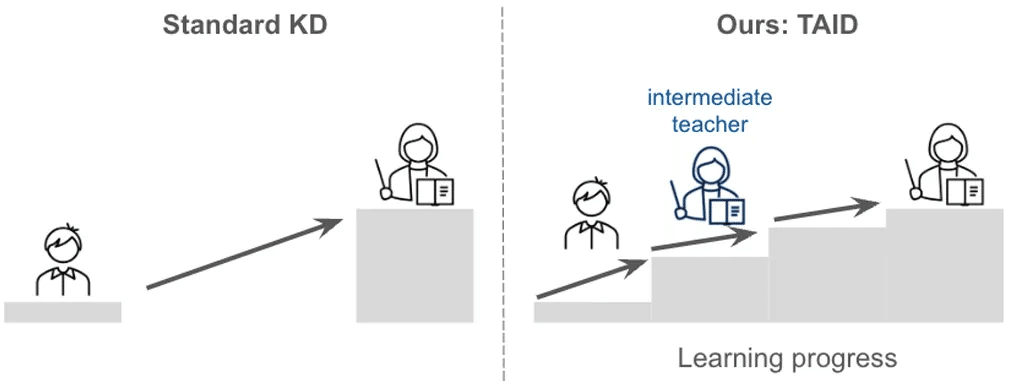

大きく高性能な大規模言語モデルが教師として最適とは限らず、大学の大先生の講義を小学生が理解できないのと同じで、そのギャップが大きいと学習効率が落ちてしまいます。それを知識を「蒸留」させれば、小学生でも理解できるというイメージです。

そこで、生徒のレベルに応じて適切な教育ができるように、大先生と小学生の間に「中間的なチューター」を配置することにしたのがTAIDという考え方です。言ってみれば、これは小学生、中学生、高校生、大学生、大学院生に対応したパーソナル家庭教師を置き、段階的な「人間の学習過程」を模して作られたということです。

この考え方で言えば、専門用語でそのまま高度なことを言うのは簡単ですが、「真に地頭が良い有能な学者ほど、一般の人でも分かりやすい言葉で本質をとらえて、深い内容を説明できる」ということを、人工知能的に言うと、「蒸留の能力が高い」と表現できそうです。

従来は、大きな教師モデル(LLM)は、逆に小さな生徒モデル(SLM)にとって難しすぎる場合がありましたが、TAIDは、生徒の学習進度に合わせて、教師モデルも段階的にレベルアップさせる仕組みです。たとえば、学校で最初は簡単な問題から教え、徐々に難しい内容に移るようなイメージです。この方法により、小さなモデルでも大きなモデルの知識を効率よく学習できます。

今回の小規模日本語言語モデルTinySwallow-1.5Bの1.5Bとは、言語モデルが学習に使用できる変数(パラメータ)の数が15億というものです。パラメータが多いほど学習能力が高いと解釈します。ちなみに、一世代前の大規模言語モデルGPT-3のパラメータ数は1750億です。ChatGPT o3-miniは確認できませんでしたが、相当な数であることは想像でき、この15億というのが、いかにtiny(小さい)ものであるかがイメージできます。

それでもTinySwallow-1.5Bは、日本語モデルの総合的な性能を示す日本語KLLM評価ベンチマークでは、26億パラメータの日本語版 Gemma 2-2Bを上回わり、同じ規模の言語モデルで最高水準の日本語ベンチマークスコアを達成しています。

これを使えば、「一般のユーザーにカスタマイズされたプライベートなAIアシスタント」、「データを一切外部に送信せず、ローカルで完結するAI業務支援」、「オフラインゲームにおけるAIキャラクターの実装」、「小型のAIエージェントの開発」など、ローカル(ネットにアクセスしない)に実現可能だということになるイメージとのことです。

ここからは分かりやすくまとめてみます。

背景と課題

今、スマホでの対話や文章作成、プログラミングなど、複雑な作業ができる大きなAIモデル(大規模言語モデル:LLM)が注目されています。しかし、こうした大きなモデルは開発や運用に膨大な計算資源が必要で、多くの企業が自前で作るのが難しくなっています。また、スマホなど小さい機器で使うには計算量が多すぎるという問題もあります。

そこで、TAIDという独自に開発したAIの知識蒸留学習を用いたSakana AIは、日本語に対応した小規模な言語モデル「TinySwallow-1.5B」を開発しました。

パソコンだけでなく、スマートフォンなどのエッジデバイスでも動作できるため、ネットに接続せずに利用可能です。まだ、実験バージョンで正式リリースではありませんが、ウェブアプリやローカル実行版も公開しており、ネット接続がなくても試すことができます。

まとめ

大規模なAIモデルは便利だが、運用に大きな計算資源が必要。

TAIDという新手法により、大きなモデルの知識を小さなモデルに段階的に伝えることが可能に。

その結果、日本語対応の小型モデル「TinySwallow-1.5B」が開発され、スマホなどでも使える高速なAIが実現。

この新しい技術により、より多くの人が身近なデバイスで高性能なAIを利用できるようになることが期待されています。こういうローカルで動くAIがスマートフォンやスマートウォッチに組みこまれると、どうなるのか、想像しただけでもワクワク感があります。

ps: ダウンロードしてインストールし、設定を完了しましたので、しばらく色々と試してみることにします。面白い発見があれば、記事にしたいと思います。ちなみにHTTPサーバーを自前で立ち上げて利用することもできますが、iPadやiPhoneでローカル自分専用AIとして試すことも可能です。

★☆★☆★☆★☆★☆★☆★☆★

今日も最後までお読みいただき、ありがとうございました。

スキ、フォロー、コメントをいただければ、大変励みになります。

よろしくお願いいたします。

★☆★☆★☆★☆★☆★☆★☆★

いいなと思ったら応援しよう!