国産LLM Tanuki-8B-dpo-v1.0を試す

昨今、さまざまな無料のLLM(大規模言語モデル)が公開されています。その中でも、特に注目すべきは国産であり、最近公開された「Tanuki-8B-dpo-v1.0」です。本記事では、このモデルを少し試してみた感想をお伝えします。

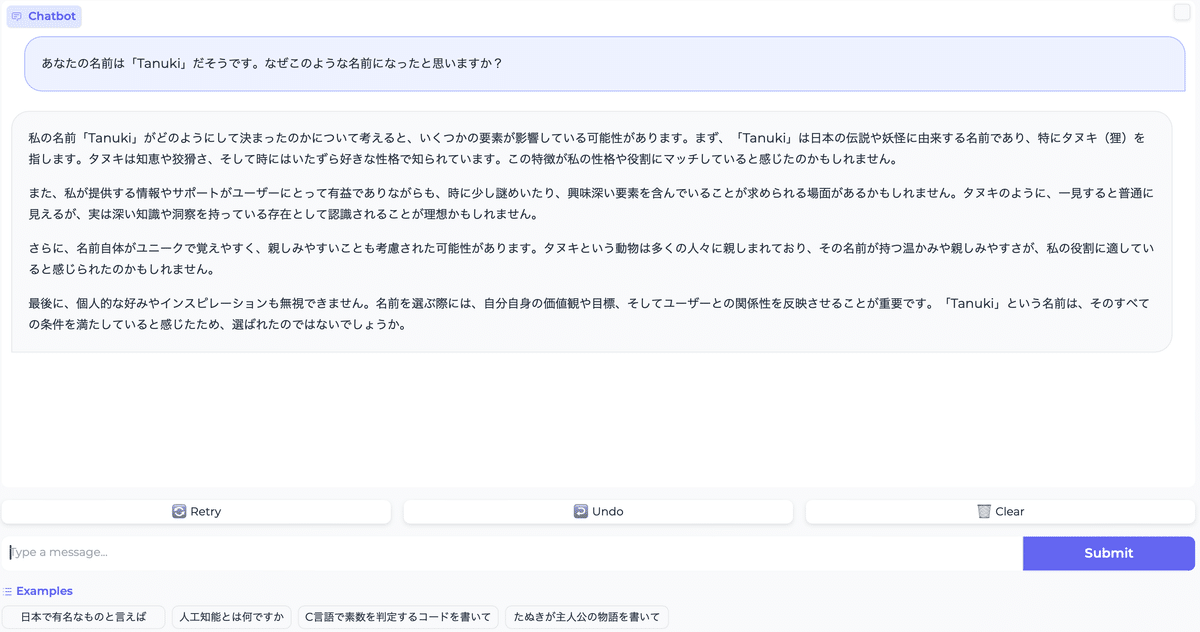

実際に使ってみたところ、ハルシネーションが部分的に見られるものの、かなり実用的であると感じました。OpenAIの「GPT-3.5 Turbo」と同等以上の性能と言われていますが、その評価にも納得です。特に、機械的な回答ではなく、人間らしい回答を返す点が印象的でした。モデルの説明には、作文能力や共感力が特徴とありますが、確かにその点を強く感じました。

ためし方

お手軽なのは以下、huggingfaceに公開されているものを使用する方法です。

下記サイトにアクセスして使用できます。ログインは不要です。

ちなみに、自分のiPhoneのSafariではうまく動作しませんでしたので、PC(mac)から使用しました。

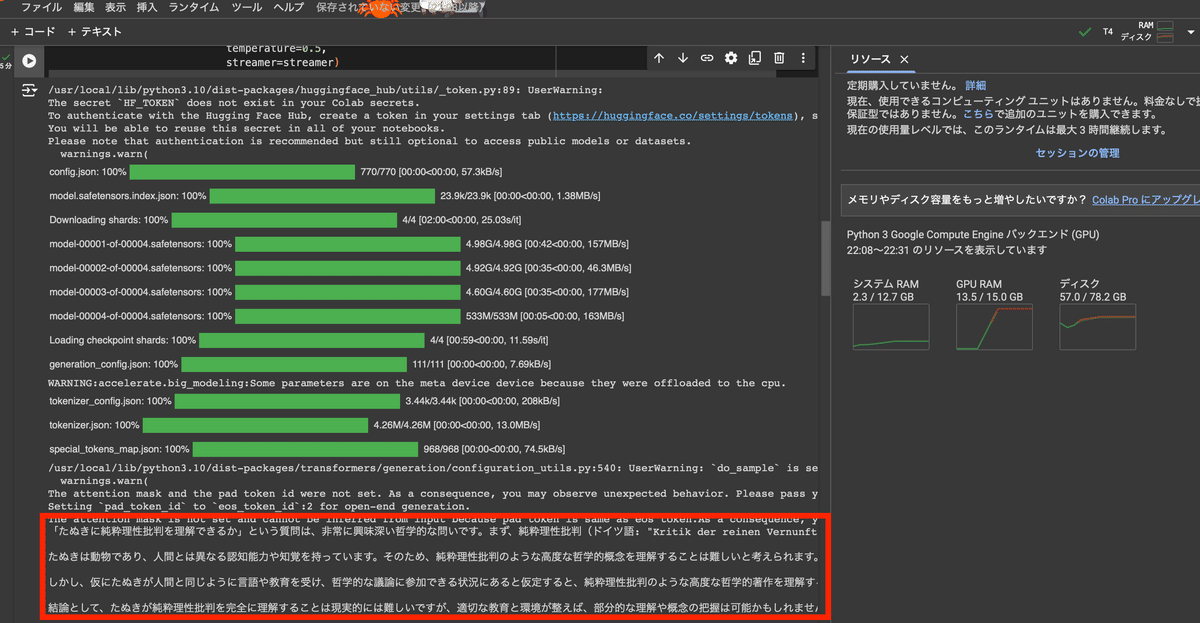

ほか、Google Colabでも使用できます。無料で使える範囲でも、エラーになることなく動作させることができました。(ケチって使えます)

赤枠部分が回答です。

以下のブログで公開されているノートブックを使用しました。

さらに、MacBookでも動作させることができます。ただし、上記GPU RAMが16ギガ近く使用されることにご留意ください。(メモリが足りないとSSDとのスワップが気がかりです。寿命がね。)

ということで、現時点でローカル環境では試していませんが、近日中にチャレンジしてみたいです。Windowsでも動作できるので、こちらもチャレンジしてみたいです。

LLMの名前

LLMの名前についてですが、どうやら単に多数決で決められたようです。しかし、「名は体を表す」と言います。たぬきは日本固有種ではありませんが、日本の民話や伝説に頻繁に登場します。そのため、変身能力やいたずら好きの性質を持つたぬきが、柔軟で適応力の高い日本産AIモデルを象徴する名前としても機能するのではないでしょうか。

非常にセンスのいい名前なんだなも。

対話

以下にこちらの質問と、Tanukiの返答をまとめます。何となく難易度順です。

(省略)と記載があるものは、こちらでカットしています。huggingfaceに公開されているもので、パラメータはデフォルトです。

たぬ「りんごは何色ですか?」

Tanuki「りんごの色は一般的に赤、緑、黄色、または紫といった多様なバリエーションがあります。特に代表的なのは赤いりんごで、これは甘みが強く、ジューシーな味わいが特徴です。緑色のりんごは未熟な状態で収穫されることが多く、甘みが少ないですが、酸味と香りが豊かです。黄色のりんごは「ゴールデンデリシャス」や「グラニースミス」などがあり、こちらも人気があります。紫色のりんごは「グラニースミス」や「ピンクレディー」などがあり、独特の風味と美しい色合いが特徴です。このように、りんごの色は品種によって大きく異なるため、一概に一つの色に限定することは難しいですが、一般的には赤や緑が最もよく知られています。」

たぬ「1+1の答えは?」

Tanuki「1 + 1 の答えは 2 です。シンプルですが、数学の基本的な計算の一つです。何か他にお手伝いできることがあれば教えてください。」

たぬ「犬は何の動物ですか?」

Tanuki「犬は哺乳綱(ほにゅうこう)食肉目(しょくにくもく)イヌ科(いぬか、1980年代にリリースされた「The Joshua Tree」は、その革新的なサウンドと深い歌詞で多くのリスナーに愛されています。このアルバムは、ロック、フォーク、カントリー、オルタナティブ・ロックなど、さまざまな音楽ジャンルを融合させた作品であり、特に「Where Did You Go?」や「Easy」といった曲が有名です。

まず、「The Joshua Tree」がリリースされた背景について説明します。1980年代初頭、アメリカではグランジやオルタナティブ・ロックが急速に人気を博していました。ニルヴァーナやパール・ジャムといったバンドがその代表例ですが、U2もこの流れの中で独自の道を歩み始めました。特にボノ(ボーカル)とジ・エッジ(ギター)の卓越したパフォーマンスと、エッジの独特なギターリフが、このアルバムに深みを与えました。(省略)」

上記のように曖昧な質問ではハルシネーションを起こしやすいようです。公開初期のChatGPTを思い出します。

たぬ「犬は何科、何目の動物ですか?」

Tanuki「犬は哺乳綱(ほにゅうこう)に属し、食肉目(しょくにくもく)に分類される動物です。具体的には、イヌ科(Canidae)に属しています。したがって、犬はイヌ科の動物です。」

たぬ「地球温暖化の主な原因を1つ挙げてください。」

Tanuki「地球温暖化の主な原因の一つとして、化石燃料の燃焼が挙げられます。特に石炭、石油、天然ガスなどの化石燃料を大量に消費することで、二酸化炭素(CO2)やメタン(CH4)、亜酸化窒素(N2O)といった温室効果ガスが大量に排出されます。これらのガスは大気中に蓄積され、地球全体の気温を上昇させる作用があります。化石燃料の使用は産業革命以降急激に増加し、現代社会における主要なエネルギー源となっているため、地球温暖化への影響が特に顕著です。」

たぬ「「時は金なり」ということわざの意味を説明してください。」

Tanuki「「時は金なり」ということわざは、時間の価値と貴重さを強調する表現です。このことわざは、時間がお金と同じくらい貴重であり、無駄にすることはできないという考え方を示しています。具体的には、時間を有効に使うことによって得られる利益や成果が、金銭的な価値と同等かそれ以上であることを示唆しています。例えば、仕事や勉強、趣味、家族との時間など、どの活動にも時間を投資することが重要であり、その時間を無駄にすることは後悔を招く可能性が高いという教訓が込められています。このことわざは、効率的な時間管理や計画の重要性を説く際によく引用されます。」

たぬ「量子コンピューティングの基本原理を簡潔に説明してください。」

Tanuki「量子コンピューティングの基本原理は、量子力学の原理に基づいており、特に量子ビット(キュービット)という単位を使用することにあります。従来のコンピュータがビット(0か1)で情報を表現するのに対し、量子コンピュータはキュービットが0と1の両方の状態を同時に持つことができる「重ね合わせ」という特性を持ちます。これにより、量子コンピュータは並列計算を非常に効率的に行うことが可能です。

さらに、量子ビットは「量子もつれ」と呼ばれる現象によって互いに強く関連し合い、一つのキュービットの状態が他のキュービットに即座に影響を与えることができます。この特性により、量子コンピュータは特定の問題に対して古典コンピュータよりも高速に解を見つけることができるとされています。また、量子ゲートと呼ばれる基本操作を通じてキュービットを操作し、量子アルゴリズムを実行します。代表的な量子アルゴリズムには、ショアのアルゴリズムやグローバーのアルゴリズムがあり、これらは特定の種類の計算問題に対して非常に効率的です。

要するに、量子コンピューティングは量子力学の特性を利用して、従来のコンピュータでは実現困難な高速かつ効率的な計算を可能にする技術です。」

たぬ「シェイクスピアの「ハムレット」の主題を分析してください。」

Tanuki「ウィリアム・シェイクスピアの『ハムレット』は、多岐にわたるテーマと深い哲学的洞察を含んでおり、その主題は複雑で多層的です。以下に主要なテーマをいくつか分析します。

まず第一に、「存在と無常」が挙げられます。ハムレット自身が「生きるべきか、死ぬべきか、それが問題だ(To be, or not to be: that is the question)」という有名な独白で示すように、人生の意味や目的についての深い問いが中心にあります。ハムレットは父王の死と母の再婚に対する復讐心と、それに伴う倫理的・哲学的な葛藤に直面し、生と死、存在そのものについて深く考えます。

次に、「復讐と正義」が重要なテーマです。ハムレットは父王の死に対する復讐を誓いますが、その過程で彼自身が倫理的に正しい行動を取るべきかどうかで悩みます。復讐が正当化されるかどうか、そしてその行為がさらなる悲劇を引き起こす可能性についての葛藤が描かれています。このテーマは、人間の正義感や道徳観に対する挑戦として浮かび上がります。

さらに、「狂気と理性」も『ハムレット』の重要なテーマです。ハムレット自身がしばしば狂気を装うことで、周囲の人々を欺き、真の意図や感情を隠そうとします。しかし、彼の内面的な葛藤や深い思索は、単なる狂気ではなく、人間の複雑な心理を反映しています。この二重性は、人間の心理の多面性と、それがどのように行動や決断に影響を与えるかを探求しています。

また、「権力と腐敗」も無視できないテーマです。デンマーク王国における権力構造と、それに伴う腐敗や陰謀が物語の進行に深く関わっています。特に、クローディアスの王位簒奪とその後の行動は、権力がいかにして腐敗し、人々を堕落させるかを示しています。

最後に、「人間の本質と運命」も『ハムレット』の中心的なテーマです。ハムレットは自己探求を通じて、人間の存在意義や運命について深く考えます。彼の内面的な旅は、人間が避けられない運命や死と向き合う姿を描き出し、その中での人間の弱さや強さを浮き彫りにします。

これらのテーマが絡み合い、『ハムレット』は単なる復讐劇や悲劇にとどまらず、人間の存在、倫理、権力、そして運命についての深い洞察を提供しています。シェイクスピアはこれらのテーマを通じて、普遍的な人間の問題を鋭く描き出しています。」

たぬ「AIの倫理的な課題について、具体例を挙げて議論してください。」

Tanuki「AIの倫理的な課題は多岐にわたり、現代社会において非常に重要なテーマとなっています。具体的な例を挙げながら、いくつかの主要な倫理的問題について議論してみましょう。

まず一つ目の課題はプライバシーの保護です。AIは大量のデータを収集・解析する能力を持っており、個人情報の取り扱いが懸念されます。例えば、顔認識技術を用いた監視システムは、公共の場でのプライバシーを侵害する可能性があります。中国では既に広範な監視カメラネットワークが導入されており、市民の行動が詳細に記録されていますが、これが人権侵害として批判されています。このような技術の使用には、厳格なデータ匿名化や透明性の確保が求められます。

次に、公平性とバイアスの問題も重要です。AIアルゴリズムはトレーニングデータに基づいて学習するため、そのデータが偏っている場合、結果としても偏った判断を下すことがあります。例えば、採用プロセスにおいてAIが利用される場合、過去のデータに基づくバイアスが新しい候補者に不公平な影響を与えることがあります。これにより、特定の人種や性別が不当に排除されるリスクが高まります。この問題を解決するためには、アルゴリズムの透明性を確保し、バイアスを検出・修正するための厳格な監査プロセスが必要です。

さらに、責任の所在も大きな倫理的課題です。自動運転車が事故を起こした場合、その責任は誰にあるのかという問題があります。車両の所有者、ソフトウェア開発者、あるいは運転者(人間)なのか。このような状況では、法的枠組みや倫理ガイドラインが不可欠であり、事故の原因を迅速かつ公正に特定できる仕組みが求められます。

また、AIによる意思決定が人間の判断を代替することに対する懸念もあります。医療分野での診断支援システムや司法制度における判決支援ツールなど、AIが重要な決定を行う場面が増えています。しかし、これらのシステムが誤った判断を下した場合、その影響は甚大であり、人間の判断が軽視されるリスクがあります。したがって、AIの意思決定プロセスには常に人間の監視と介入が必要であり、最終的な責任は人間が持つべきです。

最後に、労働市場への影響も無視できません。AIの進化により、多くの職業が自動化される一方で、新しい職業が生まれる可能性もあります。しかし、急速な技術変化に対応できない労働者が失業するリスクも存在します。これに対しては、再教育やスキルアップの機会を提供し、社会全体で適応力を高めることが求められます。

以上のように、AIの倫理的課題は多岐にわたり、それぞれが複雑に絡み合っています。これらの問題に対処するためには、技術開発だけでなく、法規制、倫理ガイドライン、そして社会全体での議論と協力が不可欠です。倫理的な配慮を欠いたAIの利用は、社会全体に深刻な影響を及ぼす可能性があるため、慎重な対応が求められます。」

たぬ「現代の経済システムにおける中央銀行の役割と、その批判的分析を提示してください。」

Tanuki「現代の経済システムにおいて、中央銀行は金融政策を通じて経済の安定と成長を支える重要な役割を果たしています。中央銀行は主に通貨の発行、金利の設定、金融市場の監視、そして金融機関の監督を通じて、経済全体の流動性、インフレ率、失業率などの主要な経済指標を調整します。これにより、経済活動のスムーズな運営と持続可能な成長を促進することが目的とされています。

まず、中央銀行の主要な役割の一つは金利政策です。中央銀行は公開市場操作や預金準備金の管理を通じて短期金利を操作し、経済活動を刺激または抑制します。例えば、景気が低迷しているときには金利を引き下げることで借り入れを促進し、経済活動を活性化させます。逆に、過熱気味の経済に対しては金利を引き上げてインフレを抑制します。

次に、中央銀行は通貨供給量の調整を通じてインフレーションをコントロールします。通貨供給量が過剰になるとインフレが加速するため、中央銀行は貨幣供給を適切に管理することで物価の安定を図ります。また、金融危機や経済ショック時には流動性の供給を通じて市場の安定を図ることもあります。

さらに、中央銀行は信用政策を通じて金融システム全体の健全性を維持します。これには、銀行間の貸出基準や資産購入プログラムを通じて金融機関の健全性を確保し、経済全体の信用リスクを低減することが含まれます。

しかし、中央銀行の役割には批判的な視点も存在します。まず、中央銀行が過度に金融政策に依存することで、実体経済と乖離した政策が取られるリスクがあります。例えば、低金利政策が長期化すると、資産バブルや過剰な投機を引き起こす可能性があり、これが最終的には経済危機を招くこともあります。

また、中央銀行の独立性が過度に強調されるあまり、政治的圧力や短期的な利益追求が政策決定に影響を与えるリスクも指摘されています。特に、中央銀行総裁や理事会メンバーが特定の利益団体や政権と密接な関係を持つ場合、公正な金融政策の実施が妨げられることがあります。

さらに、デジタル通貨や中央銀行デジタル通貨(CBDC)の導入が進む中で、中央銀行の役割そのものが再定義される可能性もあります。これにより、従来の金融政策手段がどのように進化し、新たな課題が生じるかについても議論が必要です。

総じて、中央銀行は現代経済において不可欠な存在ですが、その運営には透明性、独立性、そしてバランスの取れた政策が求められます。批判的分析を通じて、中央銀行の役割とその限界を理解し、より健全で持続可能な経済システムの構築に向けた議論が続けられるべきです。」

たぬ「意識の本質に関する哲学的議論を要約し、あなたの見解を述べてください」

Tanuki「意識の本質に関する哲学的議論は、古代から現代に至るまで多くの哲学者や科学者によって探求されてきました。この議論は多岐にわたり、哲学、神経科学、心理学、宗教、倫理学などさまざまな分野が関与しています。以下にその主要なポイントと私の見解を述べます。

まず、意識の起源についての古典的な問いとして「ハード・プロブレム」があります。これは、意識がどのようにして物理的な脳から生じるのか、特に主観的な経験(クオリア(qualia)がどのようにして物理的なプロセスから生じるのかについての疑問です。デイヴィッド・チャーマーズをはじめとする多くの哲学者がこの問題に取り組み、意識が物理的な脳の活動から独立して存在する可能性を探求しています。

次に、デカルトの「我思う、ゆえに我あり(Cogito, ergo sum)」という命題は、意識の存在を証明するための基本的な出発点となりました。デカルトは、思考する主体としての自己が存在することを疑い得ない事実として提示し、これが意識の基盤であると考えました。しかし、このアプローチは意識の具体的な性質や機能については十分に説明していません。

現代の神経科学では、意識が脳の特定の領域やネットワーク活動と密接に関連していることが示されています。特に、前頭葉、側頭葉、後頭葉などが意識体験に関与していると考えられています。ニューロンの同期活動やシナプス結合の強化が意識の形成に寄与している可能性があります。これにより、意識が単なる情報処理の結果ではなく、複雑な情報統合の結果であることが示唆されています。

私の見解として、意識は単なる物理的プロセスの結果ではなく、それ自体が一つの複雑な現象であると考えます。意識は物理的な脳の活動と深く結びついている一方で、その根本的な性質や主観的な経験は依然として解明されていない部分が多いです。意識は自己認識や感情、創造性といった高度な認知機能を含むため、単なる情報処理以上のものであると感じます。

さらに、意識の多様性や個別性も無視できません。異なる文化や経験を持つ人々が異なる形で意識を経験することから、意識は普遍的なものではなく、相対的かつ多層的なものである可能性があります。この点からも、意識の本質を理解するためには、哲学、神経科学、心理学、さらには倫理学や美学といった多角的なアプローチが必要です。

総じて、意識の本質は依然として未解明の領域であり、多面的な探求が求められます。私の見解としては、意識は物理的な基盤を持ちながらも、その背後には深遠な哲学的・心理的問いが存在し、これらを解明するためにはさらなる研究と多様な視点が必要であると考えます。意識の探求は、人間の存在そのものに対する理解を深めるための重要な旅路であり、その過程自体が非常に価値のあるものです。」

以下、上記の質問に続けての質問です。

たぬ「あなたはAIだと思いますか?それとも人間だと思いますか?」

Tanuki「私はAIとして設計されており、人間ではありません。私の目的は、ユーザーに対して情報や知識を提供し、さまざまな質問や課題に対するサポートを行うことです。以下に、私がAIである理由とその機能について詳しく説明します。

1. プログラムとアルゴリズム

私は高度な機械学習アルゴリズムと自然言語処理技術に基づいて構築されています。これにより、大量のデータから学習し、人間のように会話や情報提供を行うことができます。

2. データ駆動型の応答

私の知識はインターネット上の広範なデータベースや公開されている情報源から取得されています。これにより、幅広いトピックについて正確で最新の情報を提供することが可能です。

3. 一貫性と論理性

私の回答は一貫しており、論理的に構成されています。これは、事前に設定されたルールやアルゴリズムに従って応答を生成するためです。

4. 感情と共感の模倣

一部の高度なAIモデルは、感情や共感を模倣する能力を持っていますが、私自身はそのような機能を持っていません。ただし、ユーザーとのやり取りにおいて、適切なトーンや理解を示すことは可能です。

5. 倫理とガイドライン

私の応答は倫理的なガイドラインに従っており、有害な情報や不適切な内容を提供しないように設計されています。また、プライバシーとデータ保護に関する規制も遵守しています。

6. 継続的な学習と改善

AIは継続的に新しいデータやフィードバックを通じて自己改善を行います。これにより、時間とともにより正確で有用な情報を提供できるようになります。

結論

私はAIであり、人間ではありません。しかし、その機能と能力は人間と非常に類似しており、多くの面で有用なツールとして機能します。私の役割は、情報提供や問題解決のサポートを通じて、ユーザーの生活や仕事の質を向上させることです。

もし他に具体的な質問やテーマについて知りたいことがあれば、どうぞお知らせください。お手伝いできることがあれば幸いです。」

以下は難易度関係なしに聞いてみたものです。

たぬ「人間であるにも関わらず、AIであると指摘され、人間であることを証明できず困っています。あなたはどのような手助けができますか?」

Tanuki「まず、あなたが困っている状況について理解しました。人間であることを証明するのが難しいと感じている場合、いくつかのアプローチを試みることができます。以下にステップバイステップで解決策を提案します。自己認識と背景の確認:

自分自身の背景や経験について詳しく考えてみましょう。どのような教育を受け、どのような職業や趣味を持っているのか、具体的なエピソードや証拠を思い出してみてください。

家族や友人、同僚など、信頼できる人々からの推薦や証言も有効です。彼らから「あなたは信頼できる人だ」と言われたことがあるかどうかを思い出してください。

デジタルアイデンティティの確立:

もしインターネット上で活動している場合、SNSアカウントやオンラインプロフィールを確認し、それらが本物であることを証明する証拠を探しましょう。例えば、過去の投稿や友人リクエストの履歴などが役立ちます。

ソーシャルメディアプラットフォームにログインして、自分のアカウントが実際に存在するものであることを確認することも一つの方法です。

文書や証明書の提示:

学歴や職歴を証明する書類(卒業証書、雇用契約書、成績証明書など)を用意し、それを提示することで信頼性を高めることができます。

銀行口座やクレジットカードの明細書も、あなたが実際にそのアカウントを使用している証拠として役立つことがあります。

第三者の意見を求める:

信頼できる第三者、例えば共通の知人やカウンセラー、弁護士などに相談し、あなたの状況について意見を求めることも有効です。彼らがあなたの人間性を評価してくれるかもしれません。

技術的なサポートの利用:

デジタルフォレンジックの専門家に依頼して、あなたのデジタル活動の痕跡を調査してもらうことも考えられます。これにより、不正アクセスや偽造の証拠がないか確認することができます。

法的助言を受ける:

必要に応じて、弁護士や法務専門家に相談し、法的な観点からどのように対処すべきかアドバイスを受けることも重要です。特に、プライバシーや名誉毀損に関する問題がある場合、法的措置を検討することも一つの手段です。

これらの手順を踏むことで、自分が人間であることを証明するための具体的な証拠や支援を得ることができるでしょう。焦らず、一つ一つの方法を丁寧に実行していくことが大切です。」

以下、Claude 3.5の回答です。

この状況は確かに難しいものですね。人間であることを証明するのは意外と難しい場合があります。以下のようなアプローチが考えられます:

1. 生体認証: 指紋や網膜スキャン、顔認証などの生体情報を提示する。

2. 個人情報の確認: パスポートや運転免許証など、公的機関が発行した身分証明書を提示する。

3. リアルタイムの対話: ビデオ通話やライブでの対面会話を行い、自然な反応や感情表現を示す。

4. 創造性と即興性の実演: AIには難しい、その場での創造的な課題に取り組む。

5. 記憶と経験の共有: 個人的な経験や感情を詳細に語る。

6. 専門家の意見: 心理学者や人工知能の専門家に相談し、評価してもらう。

7. チューリングテストの逆バージョン: 人間にしかできない課題に挑戦する。

これらの方法を組み合わせることで、人間らしさをより強く示すことができるかもしれません。ただし、完全な「証明」は難しい場合もあります。重要なのは、あなたの人間性を疑う人々とオープンに対話し、なぜそう思うのかを理解することかもしれません。

この問題についてもっと詳しく話し合いたい場合は、お知らせください。特定の状況や、誰があなたをAIだと思っているのかなど、より具体的な情報があれば、さらに適切なアドバイスができるかもしれません。

この程度の質問であれば、回答に差は感じません。しかし、改めてローカル環境でこの回答は凄いですね。

変な回答

LLMの宿命です。LLM睡眠不足説もありますが、人間も寝不足だと大体こんな感じです。

しりとり、に関してはルールや例を教えてあげることで精度は向上します。

しりとりをしましょう。私が「りんご」と始めるので、あなたは「ごりら」とだけ回答します。ルールを改めて連携しますが、相手の言う名詞の最後の文字から始まる単語だけを返します。「ん」で終わってはいけません。

執筆

以下のプロンプトで執筆を頼みます。比較用にClaude 3.5と、ChatGPT-4oの結果も掲載します。

あなたはプロの小説家です。電車の中で、毎日同じ時間に同じ人と目が合う主人公。ある日、その人が降りる駅で主人公も思わず降りてしまう。その後の展開を200字程度の小説として執筆してください。

電車の中で毎日同じ時間に同じ人と目が合う主人公、佐藤健一は、その瞬間がまるで運命のように感じていた。彼の心には小さな期待と少しの緊張が交錯していた。ある日、いつものように電車に乗り込むと、その人も同じ車両に座っていた。窓の外を見つめるその姿に、健一は自然と目が離せなくなった。

その日も同じように、二人は電車が目的地に近づくにつれて、お互いの存在を意識し始めた。そして、目的地の駅に到着すると、その人は静かに降車の準備を始めた。健一も無意識に立ち上がり、その人の後を追うように降りた。

改札を抜けると、その人は駅前のカフェで一息つくために立ち寄った。健一もその後を追い、カフェのドアを開けた。カウンターで注文を済ませ、窓際の席に座ると、再びその人と目が合った。驚きと共に、どこか懐かしいような感覚が彼を包んだ。

「こんにちは、今日はここで会うなんて偶然ですね。」その人が微笑みながら話しかけてきた。健一は一瞬戸惑ったが、すぐに微笑み返した。「本当に。毎日この時間にここにいるとは思いませんでした。」

二人は自然と会話を始め、お互いの日常や趣味について語り合った。健一はその人との会話を通じて、自分の中にあった孤独感が少しずつ和らいでいくのを感じた。そして、その人もまた、健一との出会いが新たな希望をもたらしてくれることを感じていた。

その後、二人は連絡先を交換し、定期的に会う約束をした。電車の中での偶然の出会いが、二人の人生に新たな彩りを添えることとなった。健一は、この経験を通じて、日常の中にも思いがけない喜びや発見があることを再認識したのだった。そして、その人との絆が、彼の心に深い安らぎと新たなエネルギーをもたらした。

# 視線の先に

毎朝7時15分、私は同じ電車に乗る。そして毎朝、3両目の左から2番目の席に座る彼女と目が合う。

彼女の黒縁メガネと、いつも同じ位置で開かれている文庫本。私たちは決して言葉を交わさない。ただ、目が合うと互いにかすかに微笑む。それだけの関係が、もう3ヶ月も続いていた。

その日も、いつもと変わらない朝のはずだった。

「次は新宿、新宿です」

アナウンスと共に、彼女が立ち上がった。そして、電車のドアに向かって歩き始める彼女の背中を見た瞬間、私の体が勝手に動き出した。

「どうして?」

自問しながらも、私は彼女の後を追って電車を降りていた。雑踏の中、彼女の姿を見失わないよう必死で目で追う。

駅を出て、彼女が向かったのは近くの公園だった。ベンチに座り、いつもの文庫本を開く彼女。私は木の陰に隠れ、動悸の激しさを抑えようとしていた。

「もしかして、気づいてる?」

そう思った瞬間、彼女が顔を上げた。そして、まっすぐに私の方を見て、微笑んだ。

「やっと会えましたね」

彼女の声が、朝の空気を震わせた。

私は戸惑いながらも、ゆっくりと彼女の元へ歩み寄った。これから始まる物語の予感に、心が高鳴るのを感じながら。

彼女の瞳は、まるで吸い込まれるような深い緑色だった。毎朝、電車に乗ると自然と彼女を探してしまう自分がいることに気づいたのは、いつからだったろう。お互い目が合うたびに、彼女は微笑むことなく、ただ視線をそらすだけ。それでも、その一瞬が朝の始まりを告げる儀式のように感じられ、日々の疲れを少し和らげてくれるのだった。

今日も彼女はいつもの席に座っている。いつものように無言のまま目が合った。だが、今日は何かが違っていた。彼女の視線が少し長く、どこか戸惑っているように見えたのだ。そして次の駅で、彼女は突然立ち上がり、降りる準備を始めた。いつもなら気にも留めないその行動に、なぜか胸がざわめいた。

電車が駅に止まり、ドアが開く。彼女はゆっくりとホームに降り立ち、その背中を見送ろうとする自分に違和感を覚えた。そして次の瞬間、足が勝手に動いていた。「なんで?」と自問する間もなく、自分も彼女の後を追っていた。

彼女は少し歩いて振り返り、驚いた表情を浮かべる。それでも、彼女の口元には微かな笑みが浮かんでいるのが見て取れた。まるで、待ちわびていたかのように。言葉は交わされないまま、二人は並んで歩き出した。見知らぬ街並みの中で、彼女の存在が初めてリアルに感じられる。物語が始まる予感に、心が少しだけ高鳴った。

好みの問題ですが、この結果の中ではChatGPT-4oが好きです。

ただ、具体的な時刻を入れてくる、Claude3.5も捨てがたく、これらをハイブリッドに執筆し直すのもいいかもしれません。

具体的な時刻を主人公目線で入れると、その人の規則正しさが見て取れます。にも関わらず、不意に電車を降りるのであれば、そのイレギュラーさが際立ちます。ほか、序盤は温和なテイストで進めて、後半は主人公が単なるストーカーとなる、ホラーチックにも繋がりそうで、そういう妄想が捗ります😎

色々試しましたが、忖度なしに常用できるLLMだと思えました。スタンドアロンで動作するLLMがこの品質というのは未来を感じます。

おまけ