ローカル環境でAIを動かす: ollamaのインストールと使い方ガイド

1. はじめに

ollamaとは何か

ollamaは、大規模言語モデル(LLM)をローカル環境で簡単に実行できるオープンソースのツールです。様々なAIモデルを手軽にダウンロードし、コマンドラインやAPIを通じて利用することができます。

ローカル環境でAIを動かすメリット

プライバシー:データがローカルマシンから外部に送信されない

カスタマイズ性:モデルやパラメータを自由に調整可能

コスト効率:クラウドサービスの利用料金が不要

レイテンシの低減:インターネット接続に依存しない

2. ollamaのインストール

システム要件

OS: macOS 12+, Linux, Windows 10+

RAM: 最低8GB(16GB以上推奨)

ストレージ: モデルによって異なるが、最低10GB以上の空き容量

OSごとのインストール方法

macOS

Homebrewを使用してインストール:

brew install ollamaまたは、公式サイトからインストーラーをダウンロードして実行

Linux

curl https://ollama.ai/install.sh | shWindows

公式サイトからインストーラーをダウンロード

インストーラーを実行し、画面の指示に従う

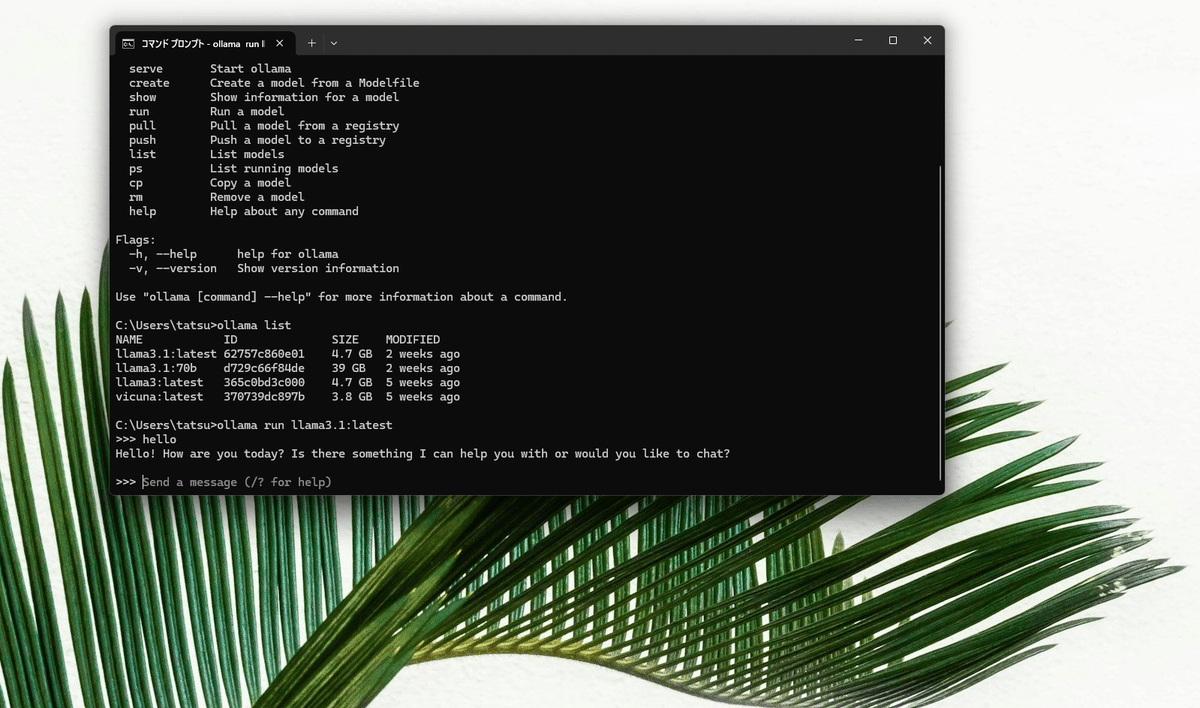

3. ollamaの基本的な使い方

コマンドラインでの利用方法

ターミナルを開く

ollama run [利用可能なモデル名]を実行してモデルを起動

ollama run [利用可能なモデル名]3.プロンプトが表示されたら、質問や指示を入力

利用可能なモデルの一覧表示

ollama listモデルのダウンロードと選択

以下のサイトからモデルを探せます。

モデルのインストールコマンド

ollama pull [モデル名]

ollama run [モデル名]4. テキスト生成の実践

基本的な対話の例

> ollama run llama2

>>> 日本の首都は?

日本の首都は東京です。東京は日本の政治、経済、文化の中心地であり、世界有数の大都市の一つです。プロンプトの工夫とベストプラクティス

具体的で明確な指示を与える

コンテキストを十分に提供する

必要に応じて制約や条件を明示する

5. コード生成と補完

プログラミング言語別の使用例

Python

>>> Pythonで素数を判定する関数を書いてください

以下は、Pythonで素数を判定する関数の例です:

def is_prime(n):

if n < 2:

return False

for i in range(2, int(n**0.5) + 1):

if n % i == 0:

return False

return True

# 使用例

print(is_prime(17)) # True

print(is_prime(24)) # False. パフォーマンスの最適化7. パフォーマンスの最適化

GPUの利用

NVIDIA GPUの場合、CUDAドライバーをインストール

ollamaは自動的にGPUを検出して利用

モデルの量子化

小さなモデルを選択(例:`llama2:7b-q4_0`)

メモリ使用量を削減しつつ、性能をある程度維持

8. トラブルシューティング

よくある問題と解決方法

メモリ不足エラー

より小さなモデルを選択

不要なアプリケーションを終了

モデルのダウンロードが遅い

ネットワーク接続を確認

別の時間帯に試す

生成結果の品質が低い

プロンプトを改善

異なるモデルを試す

9. まとめ

ollamaの利点

簡単なセットアップと使用

多様なモデルに対応

ローカル環境での高速な推論

制限事項

大規模モデルには高スペックなハードウェアが必要

一部の最新モデルは利用できない場合がある

今後の展望

より多くのモデルのサポート

パフォーマンスの向上

コミュニティによる継続的な改善と拡張

ollamaを使用することで、ローカル環境でAIの力を手軽に活用できます。プライバシーを保ちながら、カスタマイズ可能なAI機能を自由に実験し、開発に組み込むことができるのが大きな魅力です。

この記事が気に入ったらサポートをしてみませんか?