【実践AIガバナンス(2024/6/1)】ケース検討「Case02. 人材採用AI」⑤コントロールコーディネーションまとめ

シン・リスクチェーンモデルを用いたケース検討シリーズです。

少し間が空いてしまいましたが、ケース「人材採用AI」を対象にAIサービスに関わる重要なリスクシナリオのリスク対策をまとめています。

シン・リスクチェーンモデルのアプローチはこちらの記事をご覧ください。

前回までの振り返り(パーパス&リスクアセスメント)

前回まで、AIサービスに関わるパーパスとリスクシナリオを検討しました。

Step6&7. コントロールコーディネーションサマリー

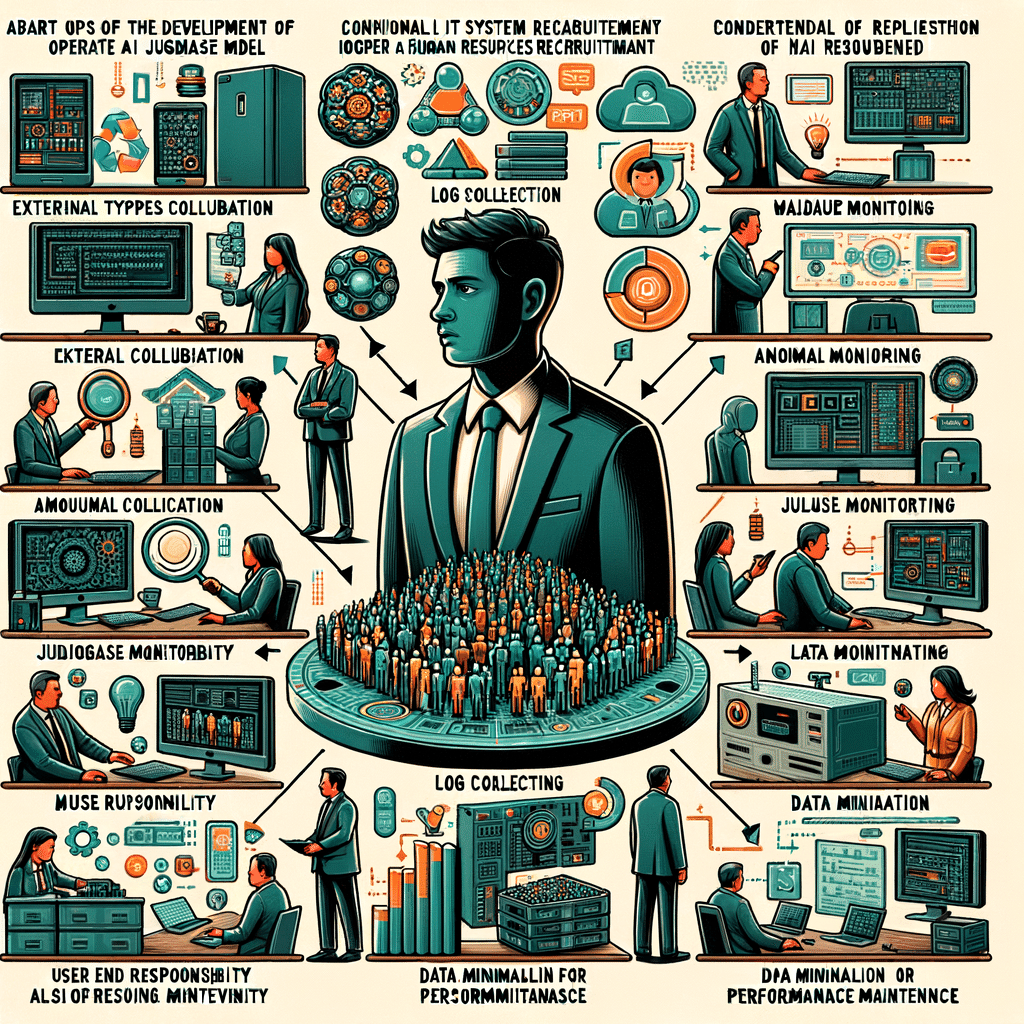

リスクアセスメントでVery High/High/Mediumと評価したリスクシナリオを対象として、リスクチェーンを引きながらコントロールコーディネーション(Step6&7)の検討を行いました。最終的に以下のようになります。

数が多いので詳細は割愛しますが、次のステップではこれらのコントロールをどのステークホルダーが実施していくか(役割)を整理します。

Step8. リスクシナリオの検討を集約して各ステークホルダーの役割を整理

リスクアセスメントでVery High/High/Mediumと評価したリスクシナリオを対象として、リスクチェーンを引きながらコントロールコーディネーション(Step6/Step7)の検討を行いました。

AIモデル開発以外にも従来のITシステム管理(外部連携、異常監視、ログ取得、アクセス管理等)も当然必要ですし、モニタリングもバリエーションがありますね(判断根拠の妥当性、バイアス、目的外利用等)。

また、利用者側にも重要なコントロールが存在しています(ユーザー責任の理解、目的外利用の監視、人材トレンドの理解、データの最小化、エスカレーションは日常利用だけではなく、性能維持のためにも必要ですね)。

ということで、あくまで一例ではありますが「人材採用AI」に関わる検討でした。