多層パーセプトロンと活性化関数

多層パーセプトロンと活性化関数

機械学習やディープラーニングにおいて、多層パーセプトロンと活性化関数は重要な概念です。これらはニューラルネットワークの基本的な要素であり、データの非線形性を捉えるために使用されます。

多層パーセプトロン(Multilayer Perceptron)

多層パーセプトロン(MLP)は、人間の脳神経回路を模したニューラルネットワークの一種です。MLPは、入力層、中間層(隠れ層)、出力層から構成されます。各層は複数のユニット(ニューロン)からなり、層と層の間のユニット同士が結合されます。MLPは、入力データをネットワークに入力し、中間層を通じて処理を行い、最終的な出力を生成します。

MLPの中間層では、活性化関数が適用されます。これにより、非線形性が導入され、ネットワークがより複雑な関数をモデル化できるようになります。

活性化関数(Activation Function)

活性化関数は、ニューラルネットワークの各層の出力に非線形性を持たせるために使用されます。活性化関数は、入力値を受け取り、出力値を生成します。

いくつかの一般的な活性化関数には以下のようなものがあります。

シグモイド関数(Sigmoid Function): シグモイド関数は、入力値を0から1の範囲に変換します。入力値が大きいほど1に近づき、小さいほど0に近づきます。主に2値分類問題で使用されます。

ReLU関数(Rectified Linear Unit Function): ReLU関数は、入力が負の場合は0を出力し、非負の場合はそのままの値を出力します。一般的には中間層で使用され、勾配消失問題の解決や計算効率の向上に役立ちます。

LeakyReLU関数(Leaky Rectified Linear Unit Function): LeakyReLU関数は、ReLU関数と似ていますが、負の入力に対して微小な傾きを持つことが特徴です。これにより、勾配消失問題を軽減する効果があります。

ソフトマックス関数(Softmax Function): ソフトマックス関数は、多クラス分類問題で使用されます。入力の各要素を正規化して確率分布を生成し、クラスの選択を行います。

tanh関数(Tanh Function):tanh関数は、双曲線正接関数とも呼ばれ、入力値を-1から1の範囲に変換します。

Maxout関数(Maxout Function):Maxout関数は、入力値の最大値を出力する関数です。

これらの活性化関数は、ニューラルネットワークの中間層に適用され、モデルの非線形性を担当します。それぞれの関数には特徴と使われる場面がありますので、適切に選択することが重要です。

活性化関数によってニューラルネットワークの学習や予測がより高度になり、複雑なデータのモデリングが可能になります。適切な多層パーセプトロンと活性化関数の組み合わせは、機械学習のタスクにおいて良い結果をもたらすことが期待されます。

LeakyReLU関数について詳しく説明

LeakyReLU関数について説明します。LeakyReLUは、入力値が負の場合に微小な傾きを持つ線形関数として定義されます。具体的には、入力が負の場合、LeakyReLU関数は負の傾きを持つ直線状の関数として振る舞います。これにより、負の入力に対しても情報を保持し、勾配消失問題を軽減する効果があります。

ニューラルネットワークの中間層に適用され、モデルの非線形性を担当します。

例えばですが、

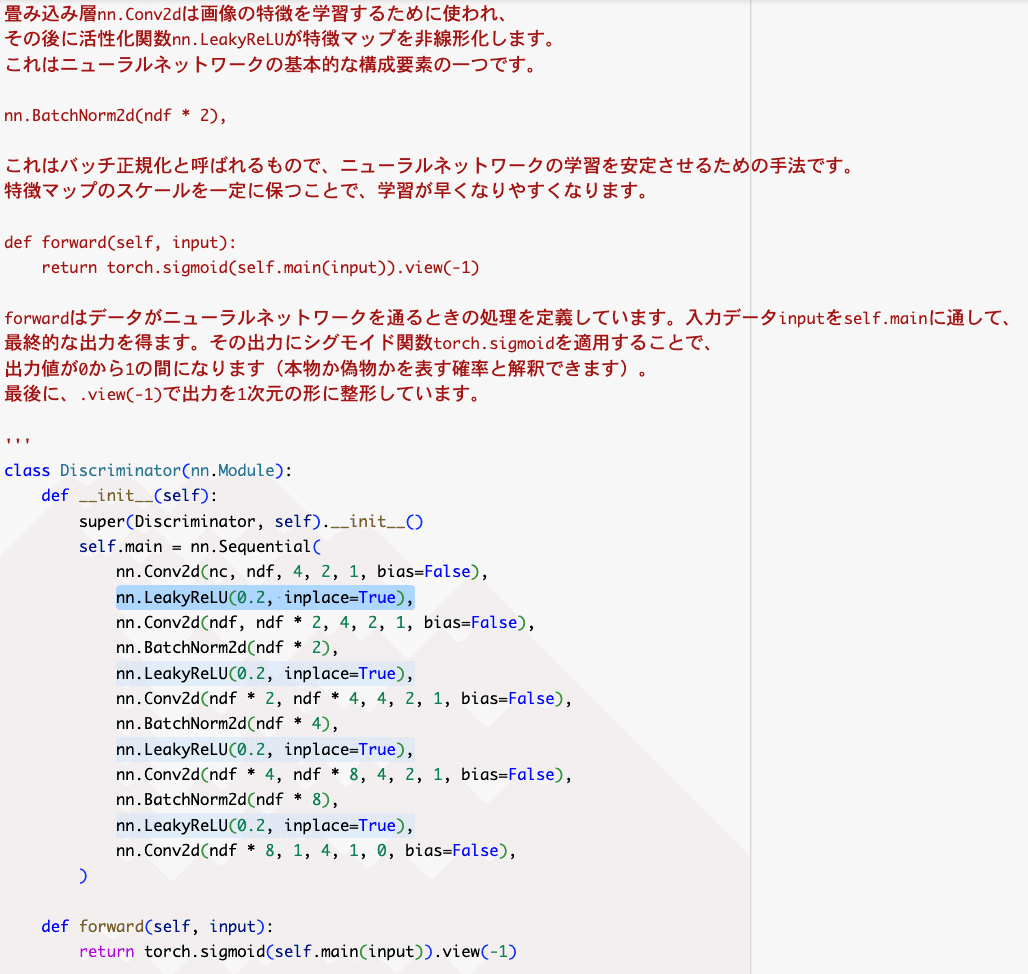

以下は GAN のディスクリミネータの一部となります

GAN(Generative Adversarial Networks)と呼ばれる人工知能の一種を設定しています。GANは、実在しない新しい画像(例えば人の顔やアートなど)を作り出すことができます

ディスクリミネータは、画像が本物(訓練データ)か

偽物(ジェネレータが作ったもの)かを見分ける役割を果たします。

活性化関数の概念がわかれば

画像生成GAN の ディスクリミネータ Discriminator

でも LeakyReLU関数 が使われることがわかりました

ReLU関数について詳しく説明

ReLU関数は、入力が負の場合には0を出力し、非負の場合にはそのままの値を出力します。nn.ReLU(True)と指定することで、ReLU関数はinplace演算として実行されます。inplace演算では、入力のTensor自体が変更され、新たなTensorを作成しないため、計算リソースの節約になります。

ニューラルネットワークの中間層に適用され

モデルの非線形性を担当します。

ジェネレータ Generator はランダムな

ノイズから新しい画像を作り出します

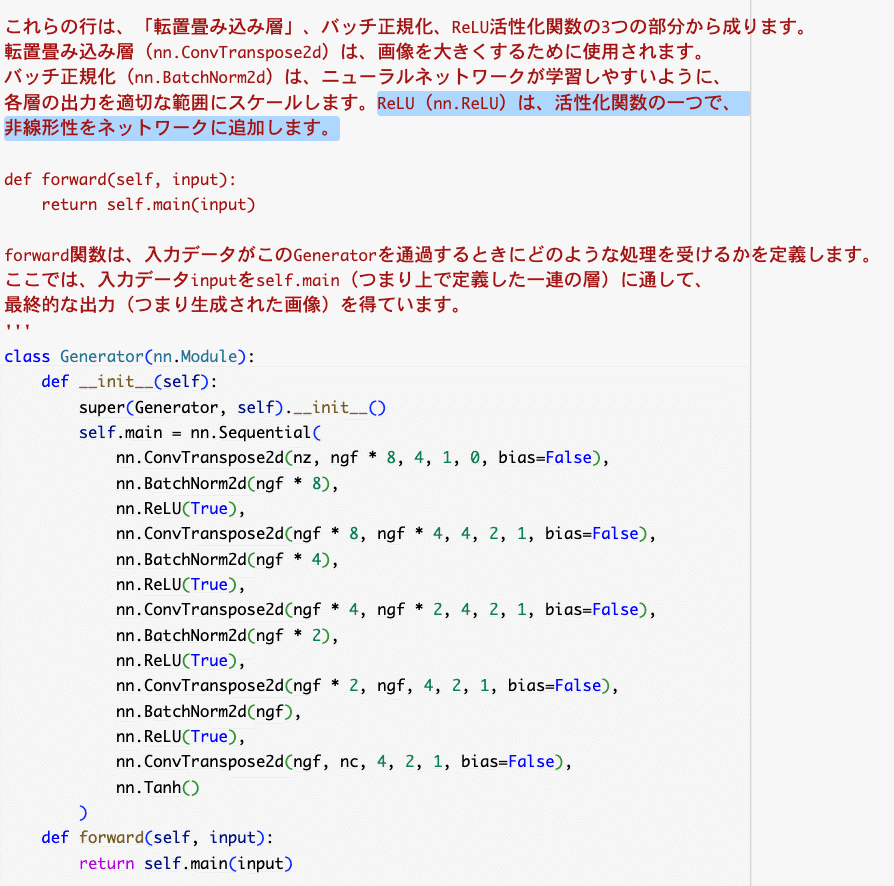

例えばですが、

以下は GAN のジェネレータ Generator の一部となります

nn.ConvTranspose2d(nz, ngf * 8, 4, 1, 0, bias=False),

nn.BatchNorm2d(ngf * 8),

nn.ReLU(True),上記の3行は

「転置畳み込み層」、バッチ正規化、ReLU活性化関数の3つの部分から成ります。

転置畳み込み層(nn.ConvTranspose2d)は、画像を大きくするために使用されます。

バッチ正規化(nn.BatchNorm2d)は、ニューラルネットワークが学習しやすいように、

各層の出力を適切な範囲にスケールします。ReLU(nn.ReLU)は、活性化関数の一つで、非線形性をネットワークに追加します。

tanh関数について詳しく説明

tanh関数は、双曲線正接関数とも呼ばれ、入力値を-1から1の範囲に変換します。数式で表すと以下のようになります。

scssCopy codetanh(x) = (e^x - e^(-x)) / (e^x + e^(-x))

tanh関数は、シグモイド関数の拡張版とも言えます。入力が大きいほど1に近づき、小さいほど-1に近づきます。そのため、tanh関数は非線形かつ中心対称の特性を持ち、シグモイド関数よりも広い範囲で変動することができます。

ニューラルネットワークの活性化関数として使用されることがあり、特に双方向の入力や出力を表現する場合に適しています。また、tanh関数は入力値の平均を0に近づける効果もあり、データの中心化や正規化に役立つこともあります。

Maxout関数について詳しく説明

Maxout関数は、入力値の最大値を出力する関数です。Maxout関数は以下のような形をしています。

scssCopy codeMaxout(x1, x2, ..., xn) = max(x1, x2, ..., xn)

Maxout関数は、入力値の中で最大の値を選ぶことにより、非線形性を導入します。ニューラルネットワークの中間層で使用されることがあり、異なるパラメータを持つ複数の線形関数の組み合わせとして機能します。

Maxout関数は、モデルがより複雑な関数を表現できるようになります。複数の線形関数の組み合わせにより、非線形な決定境界を学習できるため、モデルの表現力が向上します。

活性化関数の利用されてきた順番

中間層の活性化関数として

これまでは

●tanh関数(双極線正接関数)

●シグモイド関数

などが利用されてきました

最近は勾配省失が起きにくいように改善された

●ReLU

●Leaky ReLU

●Maxout

などが利用されています

●Maxout は複数の線形関数を一つにした構造を持つ

それらの中での最大値を出力する 面白い特徴があります!

上記の活性化関数の特徴として

勾配省失が起きにくい

と言われていますが、 勾配 とは何かについてお伝えします

勾配とは

勾配とは、山や坂などの傾斜のことを表します。イメージとしては、山の斜面がどのくらい急なのかを表すものです。

例えば、坂道を自転車で上る場合を考えてみましょう。坂道が急な場合、自転車を上るのが大変でしょう。逆に、坂道が緩やかな場合は比較的楽に上ることができます。

同様に、数学や機械学習の分野での勾配とは、関数の傾きや変化の大きさを表します。関数の傾きが大きい場合、勾配が急であると言います。

例えば、グラフ上の2つの点を結んでできる直線の傾きを考えることができます。傾きが急な直線は、関数の変化が急速であることを表します。一方、傾きが緩やかな直線は、関数の変化が緩やかであることを表します。

勾配は、関数のどの点でも計算することができます。具体的には、その点での関数の変化量を、その点でのx座標に関しての変化量で割ることで求められます。

勾配は、関数が上がっているのか下がっているのか、どれくらい急なのかを知る上で重要な情報です。機械学習では、勾配を利用して最適なパラメータを探し出したり、モデルを学習させたりすることがあります。

勾配消失

勾配消失は、ニューラルネットワークの学習時に起こる問題です。ニューラルネットワークの層が深くなるほど、勾配が急速に小さくなってしまい、学習が進まなくなることがあります。

勾配消失の問題は、活性化関数の選択に関係しています。例えば、シグモイド関数の場合、入力が大きい場合や小さい場合に勾配がほとんど消失してしまう傾向があります。これにより、層が深くなるにつれて勾配がほとんど伝播しなくなり、学習が困難になることがあります。

勾配消失問題を解決するためには、勾配消失が起こりにくい活性化関数の選択や重みの初期化方法の工夫、またはバッチ正規化などの手法を使用することがあります。これにより、勾配の効果的な伝播が可能になり、深いニューラルネットワークの学習が成功する場合があります。

GAN→ReLU関数とLeakyReLU関数が一般的

GAN(Generative Adversarial Network)では、ReLU関数とLeakyReLU関数が一般的に活性化関数として使われます。それぞれの関数がなぜ使いやすいのか、以下に具体的なメリットを説明します。

ReLU関数(Rectified Linear Unit Function)のメリット:

計算が効率的: ReLU関数は非常にシンプルな関数であり、計算が高速です。また、指数関数や対数関数のような複雑な演算が必要なく、コンピュータ上での実装が容易です。

スパース性を持つ: ReLU関数は入力が正の場合にはそのまま出力し、負の場合には0を出力します。この性質により、ネットワーク内のニューロンが活性化する割合が低くなり、スパースな表現が促進されます。スパース性はネットワークの学習や表現能力の向上に寄与します。

LeakyReLU関数(Leaky Rectified Linear Unit Function)のメリット:

勾配消失問題の軽減: 通常のReLU関数では、負の入力に対しては勾配が0となり、勾配消失問題が発生する可能性があります。一方、LeakyReLU関数では負の入力に対して小さな勾配を持つため、勾配消失問題が軽減されます。これにより、より深いネットワークでの学習が可能になります。

情報の流失を防ぐ: LeakyReLU関数は負の入力に対して小さな値を出力するため、情報の完全な消失を防ぎます。これにより、ネットワークがより豊かな表現を学習できる可能性があります。

ReLU関数とLeakyReLU関数は、GANにおいて特に生成器ネットワークに適しています。生成器の役割はデータの生成であり、非線形な表現を学習する必要があります。ReLU関数やLeakyReLU関数は、非線形性を導入するために非常に有効であり、生成器が複雑なデータを生成するための表現力を高めます。また、勾配消失問題の軽減により、より安定した学習が可能になるという利点もあります。