AIはついに考える力を手に入れた。まじでAGIが来るかも

OpenAIが9月上旬に、ChatGPTの最新版o1-previewをリリースしました。

OpenAIは定期的に、ChatGPTの新バージョンを発表しているので、またいつもの「漸進的改善か」と思われるかもしれませんが、o1-previewは今までとは違います。

OpenAI、よく考えて回答する新AIモデル「OpenAI o1」を発表

「よく考えて」というのがポイントのようです。別の記事のタイトルを見ると、

OpenAIが新モデル「o1」を発表、論理的思考というAIの弱点を克服する新境地

とあり、「論理的思考」を獲得したとのこと。

ここでいう「論理的思考」とは何でしょうか?今までのChatGPTシリーズを見ても、雰囲気的には「論理的に回答しているように見える」ので、これだけだと、従来との違いが良く分かりません。

そこで、幾つかの記事を見ていった結果、数学・物理の分野において、従来比で圧倒的な高得点を取るようになった、というのが目を引きました。

国際数学オリンピックの予備試験で比較したところ、GPT-4oは13%しか正しく解けなかったがo1は83%正答した

o1は物理学、数学、生物学で博士課程の学生と同等のパフォーマンスを発揮した

これにより、私が以前書いた「ChatGPTはなぜ数学や物理が苦手なのか」に対して、解が与えられた、と認識しています。

これは、これまでに機械学習を長年やってきた私からすると、信じられないことです。AIが物理や数学が苦手な理由2に書いた通り、

AIは「なぜなぜ」分析が苦手である。

なぜかというと、AI(機械学習技術)は、大量データに現れる「パターン」を見つけるだけなので。

例えば、歴史上全ての人が死んだという事実(データ)を踏まえて、AIは「人はいつか死ぬ」というパターンを見つけることができる。しかし、「なぜ」人が死ぬのか、という細胞学的・生物学的な理由はわからない。

別の例としては、あるECサイトでクーポンを大量のユーザに送った結果、20代の女性に限っては、購買率が上がることが分かった、とする。しかし、「なぜ」20代女性だけがクーポンに反応しやすいのか、逆に他の性別・世代(例:50代男性)では「なぜ」反応しないのか、その理由はAIにはわからない。

というわけで、AI(機械学習技術)が実現するのは「パターン認識」である。というのが、従来の常識でした。

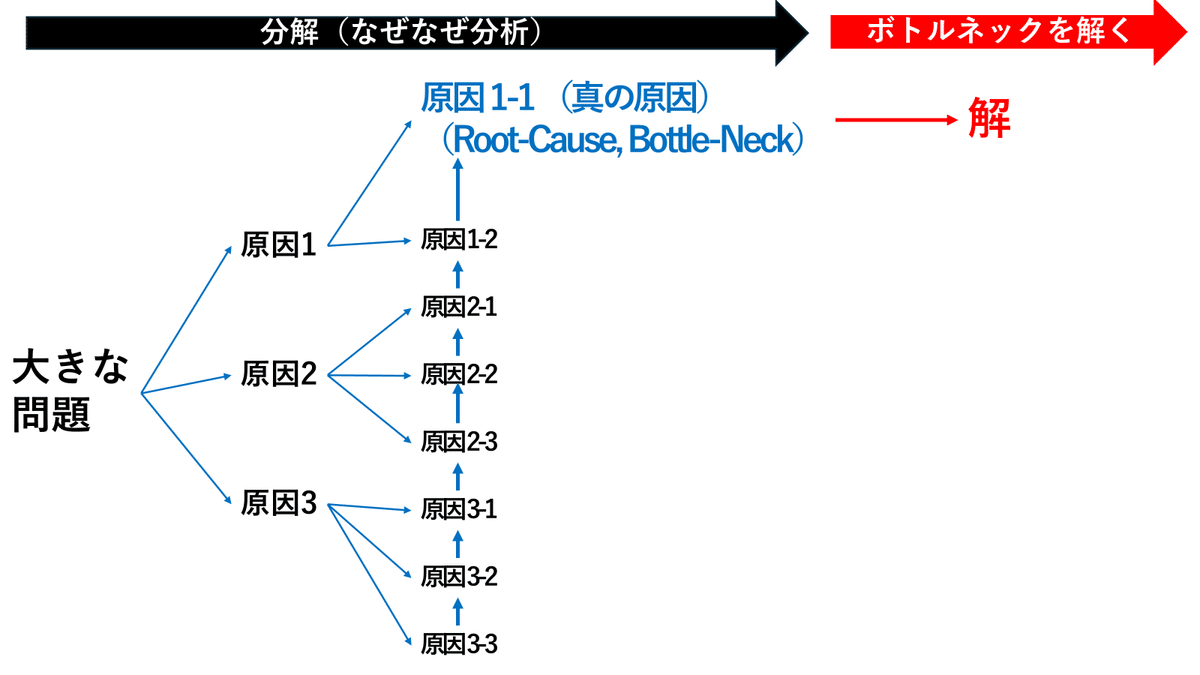

ところが、数学や物理などに限らず、難しい問題に時間をかけて考えないと解けない場合、パターン認識で解を求めるのは無理でした。それは「大きな問題を小さな問題に分割して、小さな問題を解き、それらの解を統合する」必要があったからです。これを図で端的に示すと以下の通り。

上の図で大きな問題を小さな問題に分解する具体例としては、算数・数学・ビジネスで出てくる「場合分けの問題」を考えてみれば、イメージがつきやすいかもしれないです。

もしくは、以下のような場合もありえます。

この図では、問題を引き起こす原因を分解していますが、「原因を引き起こす原因」(←の関係)がある点に注目してください。その関係を辿った結果、「原因1-1」こそがRoot-Cause(Bottle-Neck)であり、これさえ解けば一網打尽に解決できることが分かります。ビジネスでは、特に頻繁に遭遇するパターンではないでしょうか?

ここでは2つの例を挙げましたが、いずれの場合でも、問題を分解し、Step-by-Stepで解く、ということに変わりはありません。そのためには、思考を何段階かに分割して進める”Chain-of-Thought”*(CoT)という考え方が必要でした。

“Chain-of-Thought”(CoT)という考え方そのものは、ChatGPT o4以前にも存在しました。有名な話ですが、「『Step-By-Stepで考えて』というおまじないプロンプトを一言入れる」というテクニックが存在します。しかし、それでも、数学や物理といった深く考えねばならない分野では、ChatGPTが正しい答えを与えることは難しい状況でした。簡単な算数の文章題すら、計算ミスを頻繁に起こしていたので、この手の分野ではChatGPTは使い物になりませんでした。というか、現代の機械学習の技術的な仕組みを前提にする限り困難でだろう、と筆者は予想していました。だからこそ「ChatGPTはなぜ数学や物理が苦手なのか」を書いたわけです。

しかし、ついに、今回のChatGPT o1-previewは、この問題を克服した可能性が高い、という点で、 筆者にとっては大きなブレークスルーでした。なので、この発表を聞いたときは、知的興奮が止まらず、思わずFacebookとXに書き込み、なおかつ、実の弟に思いのこもった長いLINEメッセージを送ってしまったほどです。

なお、上では数学と物理を例に挙げて説明しましたが、このような「深く考えてゆっくりと回答を導き出す思考プロセス」は、「考えは浅いが迅速に回答を導く思考プロセス」とは、脳科学や行動経済学の観点から全く別である、ということが、ダニエルカーネマンの名著「ファースト&スロー」で示されています。彼によると、後者の「浅くて速い思考(ファースト)」はシステム1と呼ばれ、前者の「遅くて深い思考(スロー)」はシステム2と呼ばれており、人間の脳には2つの異なるシステムが同居しているとのことです(「二重過程理論」)。

通常、人間はシステム1で日常生活を送ります。日々の細かい意思決定や小さな問題解決を行う際、人は、自分の経験パターンに合致する回答を瞬時に導きだそうとします。他方で、難しい問題に遭遇し、かつ、それを突破しないと困った事態に遭遇すると、人は初めてシステム2を起動し、じっくりと問題解決にあたります。

人は日常生活では、システム1を中心的に使って暮らしています。なぜなら、朝起きて、ご飯は何食べようか、着る服は何にしようか、などをいちいち「じっくり」考えると疲れて一歩も動けなくなってしまうからです。なので人間は楽なシステム1を使うことが殆どです。システム2は、脳としては怠慢な機能であり、めったに働こうとしません。

しかし、システム1は、先に示した「パターン認識」に基づいて、安易な結論を出すことで、よく間違いを起こします。また、人生経験や価値観に基づいてパターンが形成されるため、そのパターンには思いこみ(バイアス)が入り込んでいる可能性が高く、必ずしも客観的もしくは科学的な答えを出すわけではありません。したがって、時には間違いも言うわけですが、大抵の生活はシステム1を中心に使って対応することでうまくいっている現実があるため、人間がそれを気にすることは多くはありません。

ChatGPTの話に戻ると、o1-previewが出る前までのChatGPTや他のLLMが実現していた脳モデルは「システム1」でした。深く考えることはせず、過去の大量データの学習結果から得られる「パターン」に基づき、パターンに合致する回答を瞬時に導いていたわけです。僕から言わせると、以前のAIは「英語がペラペラな自信家だが、ロジカルシンキングが少々苦手な人」(いるよね、こういう人)に近いです。

しかし、o1-previewが出たことによって状況が大きく変わったと筆者は考えています。ついにAIは、システム1だけでなく、システム2を取得したことで、人間の脳に限りなく近づいた、と考えています。もちろんシステム1も2も精度の上ではまだ不十分な面がありますが、今後も継続的な改善は続くでしょうから、いずれは、人間のシステム1やシステム2以上に「賢い」AIができても不思議ではないと考えています。大学院生の卵程度の知力を得たChatGPT o1-previewは、今後進化が続くと、いずれは自分で勝手に数学や物理の論文を書き、新定理を発見するかもしれない、と本気で思っています(SakanaAIによるAI Scientistという提案もあるくらいです)。

今、筆者は、小学5年生の娘の中学受験や、高校1年生の息子の定期テストの勉強内容をみて、複雑な気持ちになることが多いです。「こんな問題、全てAIが解くようになる時代が来るのに、頑張って勉強する意味はあるのか」と惨憺な気持ちになってしまいます(その代わり、子供たちには有料のChatGPTを使うよう、強く推奨するようになりました)。

昔、Google検索が市民権を得たころ、「博識であることは価値を失う」と言われていました。筆者は、今でも全くその通りだと思っています(それでも学校教育が変わらないのは、彼らが既得権を失ってしまったり、失業してしまうからでしょう)。それが、今度のChatGPT o1-previewの発表によって、「難しい数学や物理の問題を解ける知性」すら無価値になる未来をイメージするようになりました。パズル又は娯楽として、数学や物理の問題を解くのは良いけども、ビジネスや社会課題解決に使うことに果たしてどこまで競争優位があるのであろうか?、そう思うようになりました。

最後に、繰り返しになりますが、ChatGPTがシステム2を体得したというのは、間違いなくブレークスルーです。これまでの漸進的精度改善とはわけが違うと思って頂きたいです。この結果「知的労働はすべてAI、もしくは、AIを扱う一部のAIエンジニアだけ」がするものとなり、残りの人間全員は「肉体労働」だけを行う時代が遅かれ早かれ来るかもしれない(ロボットによる「肉体労働」の代替はさらに難易度が高い)。私たちは、この不都合な(かもしれない)事実を、自分の子供たち含め、すべての若者に伝えていく責務があると思っています。