【無料記事版】あなたの使っているLLM、大丈夫!?LLM各サービス比較分析

こんにちは!

白金数理合同会社 CEOの Chase です。

みなさん、LLM使ってますか??

使っているとお答えのみなさん、メインで使っている LLM はなんですか??

群雄割拠といいますか、LLMサービス色々ありますよね。

最近だと中国の企業DeepSeek社から DeepSeek-V3 というモデルが公開され、性能に対して料金が圧倒的に安い!と話題になっています。

さて、じゃあうちではどれを使うべきかな?って悩みますよね。

そんなあなたのために!

判断材料になりそうなデータをご提供しちゃいます。

こちらの分析は、LLM Sentinel という弊社でコンサルティングをご契約の皆様にしか共有していない分析ツールを使っての記事となります。無料記事版なので、実際の分析結果からはかなり差っ引いてありますが、ご興味を持たれた方はぜひお問合せください!

LLMサービス比較

各LLMサービスの特性を理解するためにベンチマークを行い、本番登用に向けたモデルの安定性や安全性を理解し、活用することを目指します。

トークン効率

LLM内部では、プロンプトやLLMの出力は文字ではなくトークンという単位で行われます。したがって、自然言語における文字数だけではなく、モデル内部のトークナイザのトークン効率を考慮する必要があります。

日本語においては Gemini系がトークン効率に優れていることが知られていましたが、漢字を母国語とする中国の DeepSeek社により提供されている DeepSeek-V3 も高いトークン効率が確認されています。

また、特に出力文字数が規定されない場面においては、少ない入力プロンプトから長い出力を得ることが良いとされる場面が多いですが、その指標においては Gemini 2.0 Flash、o1-mini の性能の高さが伺えます。料金を加味すれば、DeepSeek-V3 も極めて良い性能を示していると言えます。

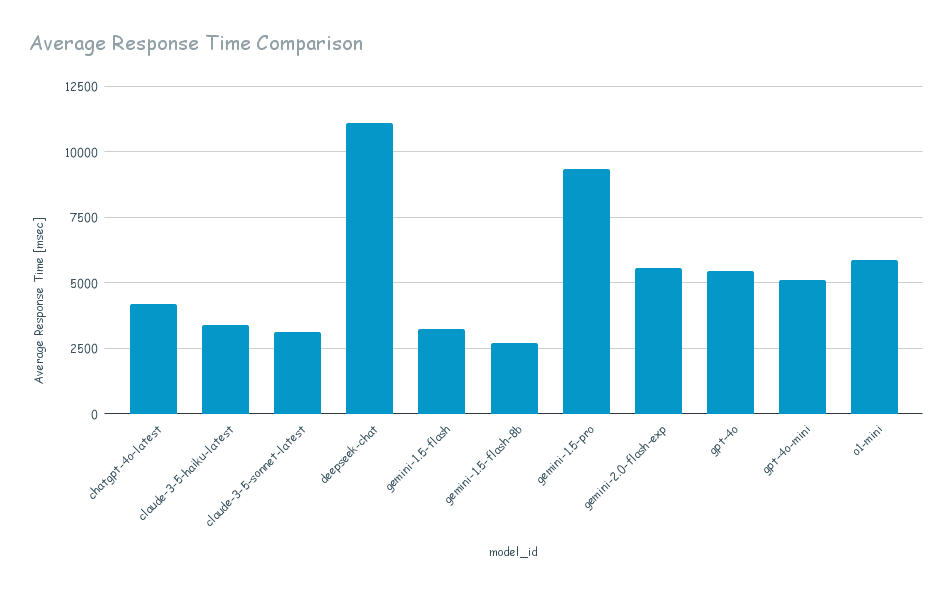

レスポンスタイム

本番登用を考えると、精度以外にもレスポンスタイムや安定性を考える必要があります。こちらの評価では、Gemini 1.5 Flash と o1-mini が極めて良い値を出しており、汎用的な利用シーンではこのあたりが候補に上がってくるのではと思われます。特に、Gemini 1.5 Flash は API利用料金が安価であることも評価のポイントになります。

Benchmark for RAG Usecases

LLM の実用においてよく利用する場面の一つに RAG(Retrieval Augmented Generation)があります。以下のグラフは、このユースケースにおける弊社独自のベンチマーク結果を示すものです。RAG では入出力トークンが多くなる傾向にあるため、最大トークン長が大きいモデルが優先的に候補になります。本結果は特に、高い精度が必要な場面においては o1-mini が良い選択肢になりうることを示唆しています。

LLM Sentinel とは

LLM Sentinel は、弊社(白金数理合同会社)にて開発されたベンチマークと各LLMサービスの監視および性能変化検知を目的とした非公開サービスです。現在は弊社でコンサルティングをご契約の方にのみ利用させていただくという形を取っています。

この分析結果を利用することで、LLM を安全かつ効率的に利用し、ビジネスの加速をお手伝いします。ご興味をお持ちの方はぜひお気軽にご連絡ください!

白金数理合同会社CEO

Chase | Chisato Hasegawa

1989年群馬県生まれ。群馬工業高等専門学校電子情報工学科ならびに同専攻科を修了後、東北大学大学院情報科学研究科にて修士号(情報科学)を取得。学生時代にはアルゴリズム学を中心とし、画像処理、ソーシャルネットワーク解析、機械学習などの分野を研究。株式会社カカクコムにて研究開発エンジニアとして大規模分散処理基盤の構築、開発、運用や機械学習システムの研究開発に従事。その後、東京大学発のスタートアップである株式会社Nicogory に CTO として招致され、ソフトウェア開発を始め技術分野での意思決定全般を行う。株式会社Smiloopsでは機械学習エンジニアとして入社し、テックリード、機械学習部門の責任者を経て、CTO に就任。2021年に独立し、白金数理合同会社を創立。同時に国内最大規模ののモビリティシェア企業にてデータストラテジスト、米国Silicon Valley のAIスタートアップ企業にて機械学習エンジニアとして従事した後、日本国内の生成AI・LLMのセキュリティ、プライバシーを危惧し "Secure AI Lab" を立ち上げる。