Qwen2-VL-7b-instructにOCRさせてみた

先にLoRAをしましたが、OCRの精度も試してみました。

同じくms-swiftを使います。

コマンド

CUDA_VISIBLE_DEVICES=0 swift infer --model_type qwen2-vl-7b-instruct入力を受け付けるので続けて以下を2回に分けて入力

<image>Perform OCR on the image.

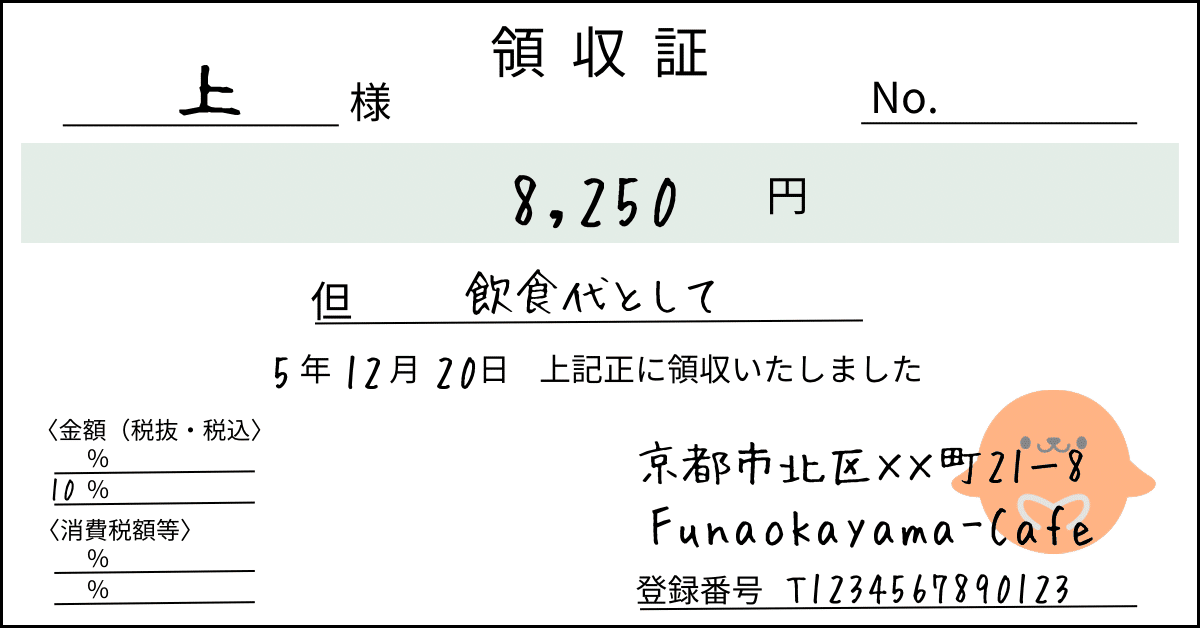

{画像のパス}まずは領収書を入れてみる

画像は検索して見つけたこちらをとりあえず

結果

%が少ない?けどほぼ合ってる。すごい。

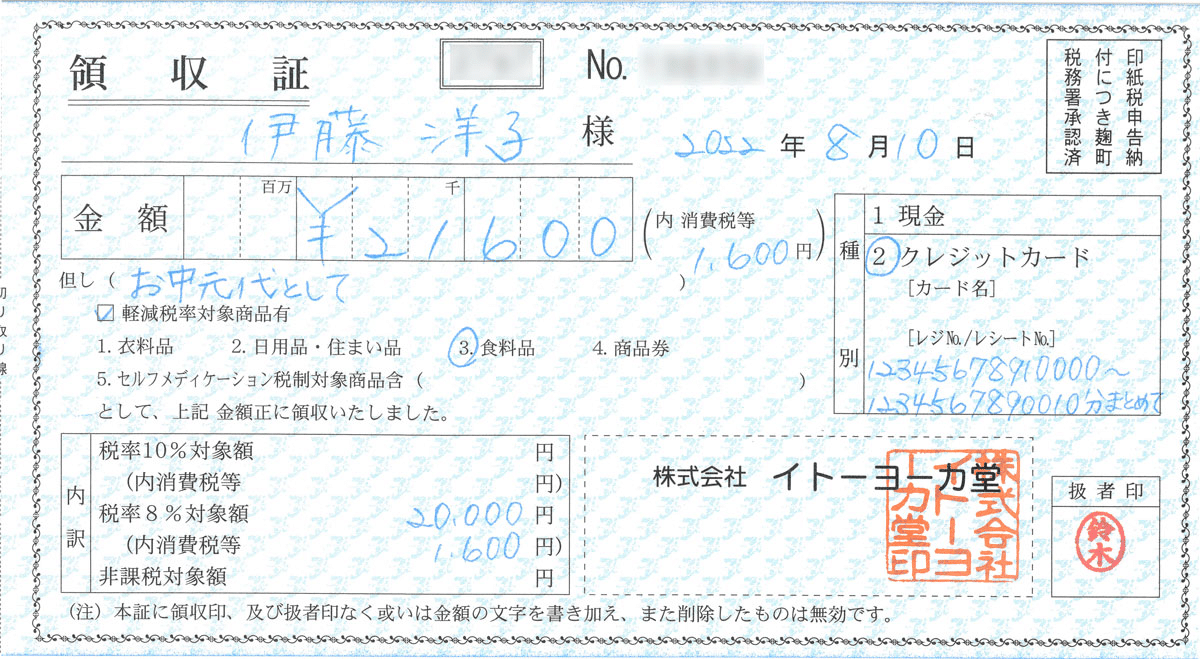

次はかなり難しそうなこれ

手書きの2022年を2052年と読み間違えている。

人間なら過去だとわかるはずだけどその類推が働かなかったみたい。

税率8%対象額も空欄に

◯で囲っているかどうかを出させるのには工夫が入りそう。

もう少し簡単そうな画像で

1〜3は合っているけど、それ以降は難しい。

というか人間でもビルの名前読めない。

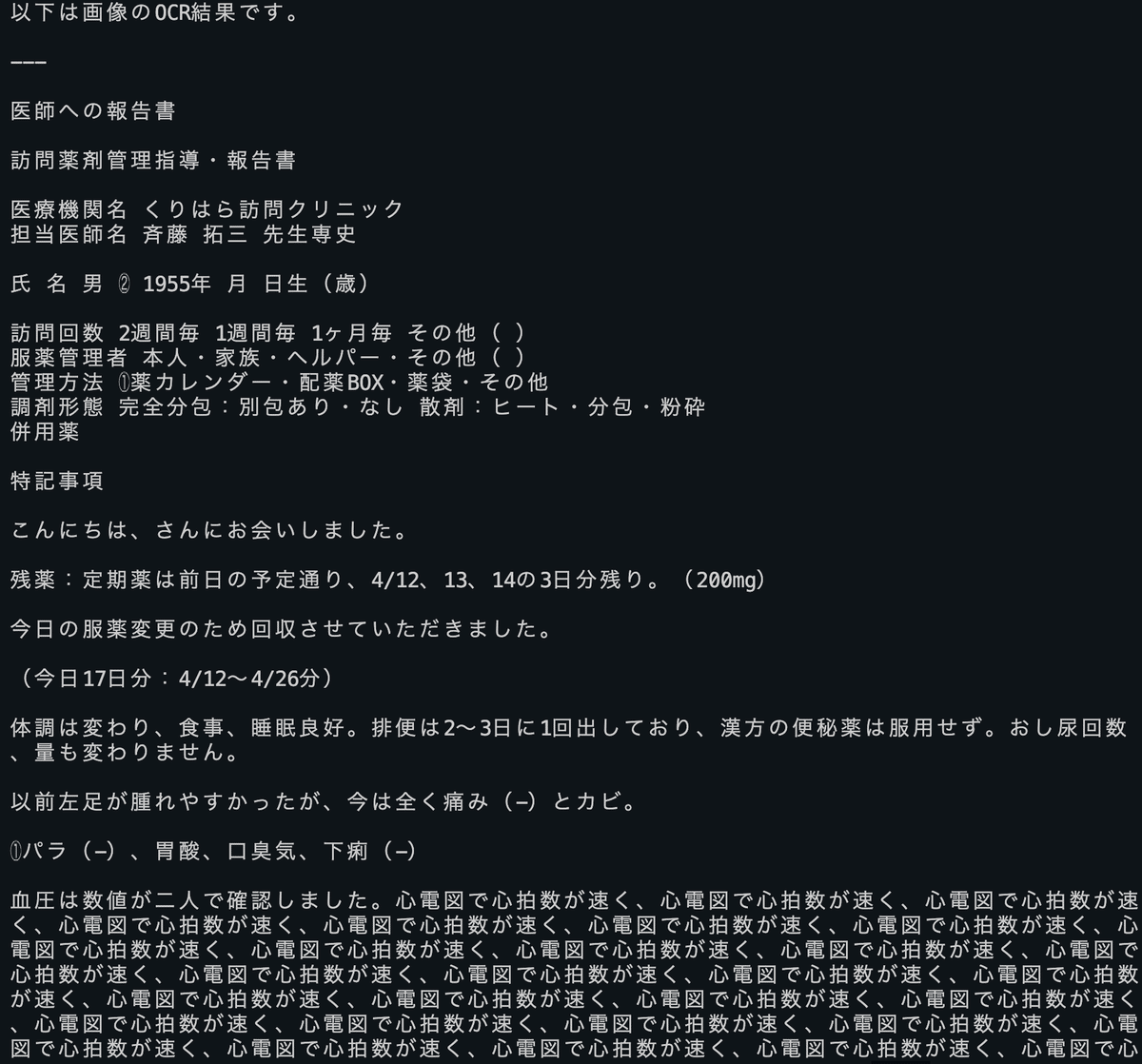

次は報告書

今まで大丈夫だったのに急に英語に

日本語で指示しなおす。

消費税がミスっているけど、そもそも例の画像がミスっていた。

あとは完璧。

めちゃくちゃ難しそうなこちら

終わらなくなってしまった。割とホラー。

72Bならどうかと思ってspacesの方に投げてみた結果が以下。

申し訳ありませんが、この画像は手書きの日本語の文書で、OCR(光学文字認識)ソフトウェアが正確に認識するには難しく、一部の文字が読み取れない可能性があります。しかし、以下に可能な限りのテキストを転写します。

医師への報告書

訪問薬剤管理指導・報告書

医療機関名: くらはら訪問クリニック

担当医師名: 斉藤 暁三 先生

氏名: 様 男 55歳

訪問回数: 2週間毎 1週間毎 1ヶ月毎 その他( )

服薬管理者: 本人 家族 ヘルパー その他( )

管理方法: 薬カレンダー 配薬BOX 薬袋 その他( )

調剤形態: 完全分包 別包あり なし 散剤 ヒート 分包 粉砕

併用薬:

特記事項:

手書き部分:

5/15 5/16 お休みです。 残薬: 定期薬は前回の予定通り、4/12、13、14の3日分残薬。(2/3分服用) 今日の服薬変更あり。回数を2回に変更。(2/3分服用) (今日の15分: 4/12~4/26まで。診察日は4/25) 体調は変わりなし。食欲、睡眠良好。排便は2~3日に1回です。 以前左足の腫れが気になっていましたが、今は(少し痛い)とあります。 (5/15~5/16)胃痛あり。吐き気、下痢あり。 血圧は数回測定し、平均値は130/80。脈拍は70~80。 →(処方変更)今日より、5/15~5/26まで、5mg Stop。5/27~LD (アスピリン20mg + パロキセチン2.5mg)の併用。プラザキシ25mg Stop。 薬の変更に伴い、(5/15~5/16)胃痛あり。吐き気、下痢あり。 等に注意し、具合が悪ければ連絡下さいます。また、食欲もパラメータに 注意して、食事の間隔も注意します。無理のない範囲で。 以上です。よろしくお願いします。

上記のとおり、訪問薬剤管理指導の実施について報告いたします。

平成27年4月11日

宮城県栗原市

薬局

手書き部分の一部は読み取りが難しいため、正確な転写ができない部分もあります。ご了承ください。

結構適当な結果に。

やはり、これで全部解決ってわけではなく、OCRサービス全体としての設計や運用が大事になりそうでした。

そもそも手書きでログを残さないことが重要感。

VLM以外のOCR技術もありますので、OCRをやりたい方はお気軽にお問い合わせください!

いいなと思ったら応援しよう!