WhisperをGoogle Colabで試す

Whisperとは、OpenAIが開発した音声認識モデルです。

Whisperは、68万時間分の多言語音声データで訓練されたTransformerモデルです。英語や日本語をはじめとする98言語の音声認識と文字起こし、そして英語以外の言語を英語に翻訳することができます。

利用するのはGitHubに公開されているWhisper-WebUIを使います。

Google Colabで試す

Whisper-WebUIにアクセスしhereをクリックするとColabにアクセスできます。

Colabが開いたらランタイム▶すべてのセルを実行をクリックもしくはショートカットCtrl+F9入力

警告が出ますがそのまま実行します。

オプションには何も入力しなくていいです

実行中に警告が出ますが無視をします

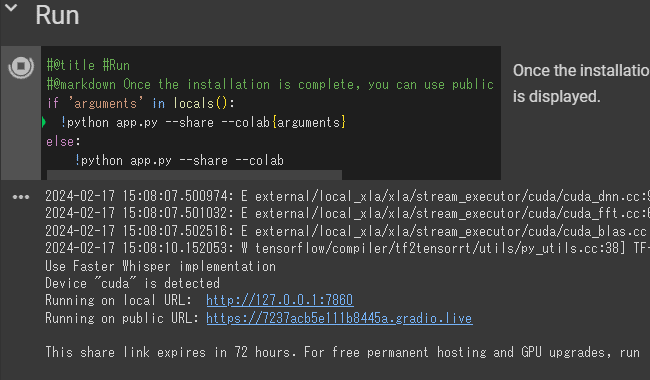

RunセッションのセルにURLが出てきたらアクセスします

アクセスすると以下のWebUIが表示されます

Whisper-WebUIできることは以下の通りになります

字幕の生成

ファイル

YouTube

マイク

出力できるファイル形式

SRT

WebVTT

txt (タイムラインのないテキスト ファイルのみ)

音声からテキストへの翻訳

他の言語から英語へ。 (これは Whisper のエンドツーエンドの音声からテキストへの翻訳機能です)

テキストからテキストへの翻訳

Facebook NLLB モデルを使用して字幕ファイルを翻訳する

DeepL APIを使用して字幕ファイルを翻訳する

実際に使ってみた結果

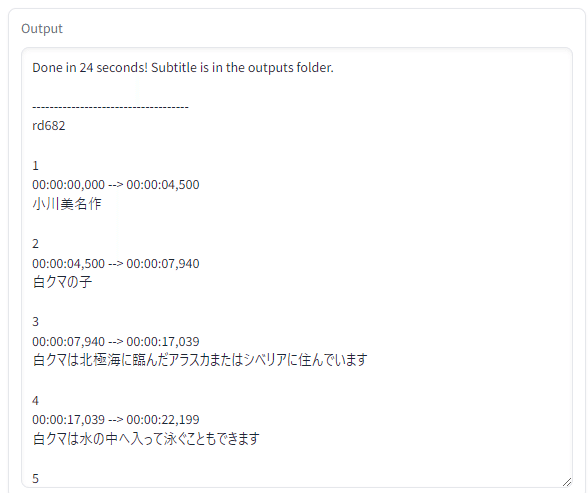

青空朗読のしろくまの 子

SRT形式での出力

ほとんどあっていました

備考

Whisper-WebUIではVRAMの使用率と速度を出すためにデフォルトでFaster-Whisperを使用しています

Faster-Whisperとは何か

faster-whisperはOpenAIのWhisperモデルをTransformerモデル用の高速推論エンジンであるCTranslate2を使って再実装したものです。 この実装は、同じ精度でopenai/whisperよりも最大4倍高速で、より少ないメモリしか使用しません。CPUとGPUの両方で8ビット量子化を行うことで、効率はさらに向上します。

要約すると

faster-whisperはOpenAIのWhisperモデルを高速化したもの。

CTranslate2という高速推論エンジンを使用することで、最大4倍高速に動作する。

メモリ使用量も少なく、CPUとGPUで8ビット量子化を行うことでさらに効率が向上。