大規模データ処理~BigQuery~

近年、企業がデータドリブンな意思決定を行うために、大規模データの収集・分析が欠かせなくなっています。しかし、膨大なデータを高速に処理するには、専門的な知識とインフラが必要で、ハードルが高いと感じる方も多いのではないでしょうか。

そんな悩みを解決してくれるのがBigQueryです。BigQueryを使えば、サーバーの管理なしで、SQLを使った大規模データ分析をシンプルに行うことができます。

BigQuery データウェアハウス上で機械学習モデルを構築・実行できるBigQuery ML (BQML)についてはリンクから。

BigQueryの主な特徴

フルマネージド&サーバーレス:インフラ管理が不要で、構成や調整に煩わされずにデータ分析に集中できる

高速&大規模処理:列指向データベースと分散処理技術により、ペタバイト級のデータも数十秒で分析可能

標準SQLによる操作:データサイエンスの専門知識がなくても、SQLクエリでデータ分析が行える

低コスト:使った分だけの従量課金制で、無料枠も用意されている

BigQueryの使い方

データのアップロードとテーブル作成

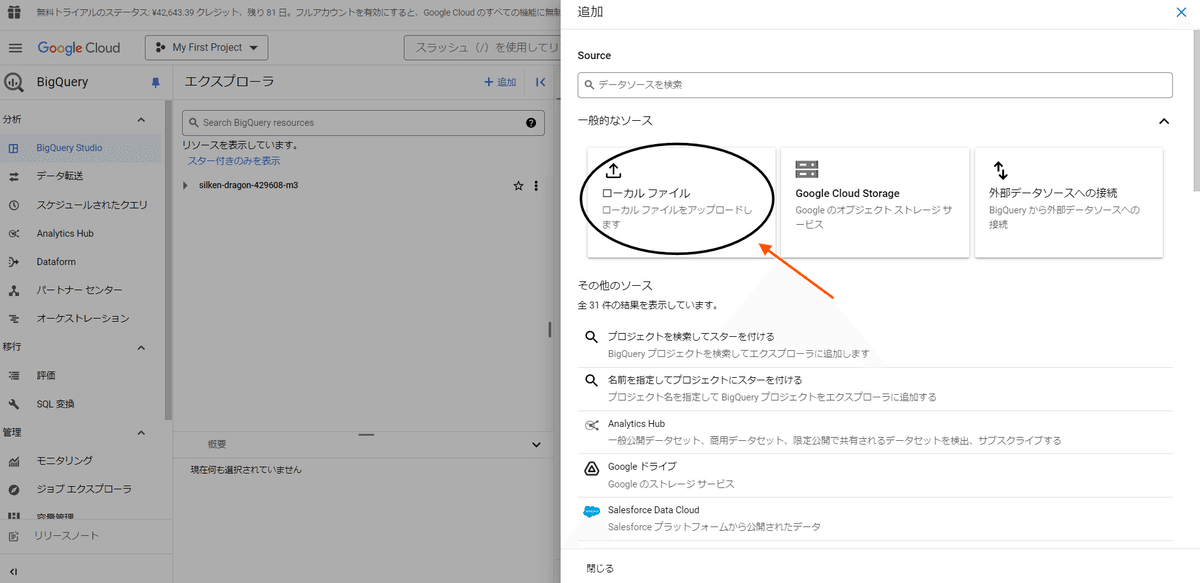

BigQueryプロジェクトのコンソール画面で「+追加」をクリックします。(ケバブメニュー「︙」に収納されていることもあります。)

2.分析したいデータを用意します。今回は例としてKaggleからダウンロードしたCSVファイルを使用します。

追加バーからローカルファイルを選択。

3.ローカルのCSVファイルをアップロードします。アップロード時には以下の設定を行います。

ただし、数値と判断されてしまう可能性がある「数字の文字列の電話番号」や「数字の文字列の商品ID」などのデータがある場合は、手動でスキーマを設定しましょう

設定が完了したら、「テーブルを作成」をクリックします。

これでデータのアップロードとテーブルの作成が完了します。あとはこのテーブルに対してSQLクエリを実行することで、様々な分析が可能になります。

テーブルエクスプローラ

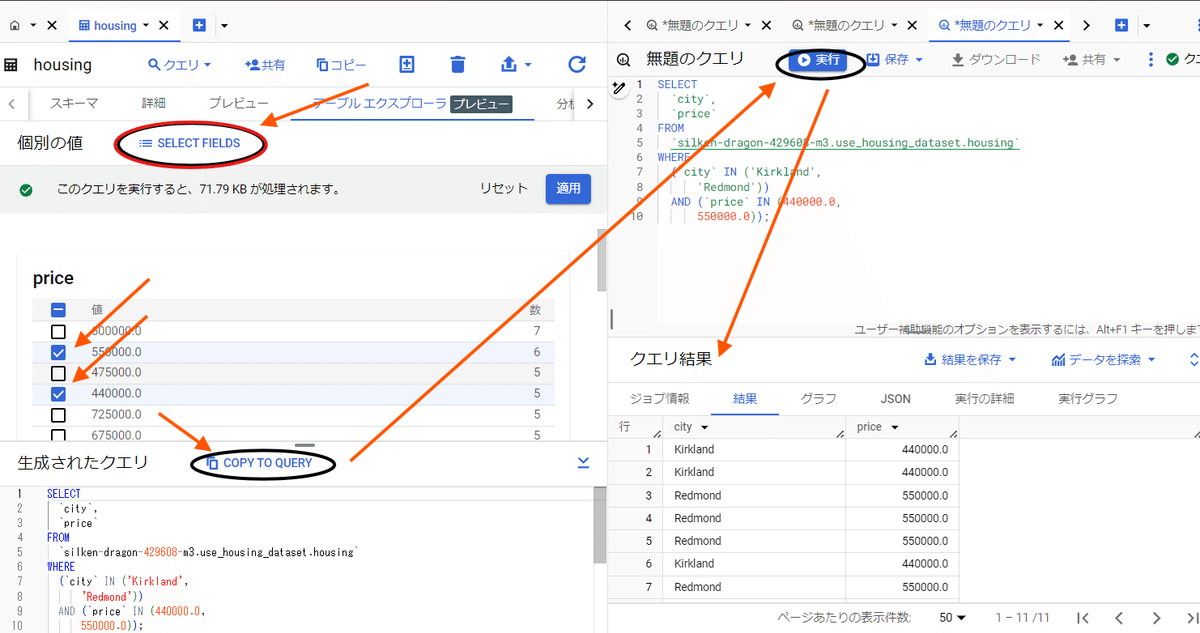

BigQueryの新機能であるテーブルエクスプローラは、SQLを書かなくてもテーブルのデータを探索的に確認できる便利なツールです。この機能を使えば、データの全体像を素早く掴むことができます。

[SELECT FIELDS]から表示する情報を選択、その後下図のように実行。

分析情報

SQLに詳しくない人でもデータ分析に取り組める強力なツールです。この機能を使えば、分析例とクエリを自動生成してくれるので、複雑な条件を指定しなくても簡単に分析結果が得られます。

下図のように[APIを有効にする]をクリック。構築に少し時間がかかります。

「分析情報」タブをクリックすると、自動生成された分析例とSQLクエリが表示されます。

分析例は英語で書かれているので、内容を理解するために翻訳ツールを使うのも良いでしょう。中には、現実的でないものもあるので、そのまま使用せず、内容を確認してから実行しましょう。

(例えば、画像の一番上の出力にある「築年数が2000年以上の住宅の平均価格」といった分析例は、現実的ではありません。)

分析例は多条件のものだけでなく、短い文で検索をかけるものもあります。下にスクロールすると、そういった例も見つかるでしょう。

データ分析の敷居を大幅に下げてくれる便利なツールです。特にSQLに不慣れな人にとっては、分析のきっかけを作るのに最適でしょう。ただし、自動生成された内容をそのまま鵜呑みにせず、しっかりと確認することが大切です。

その他

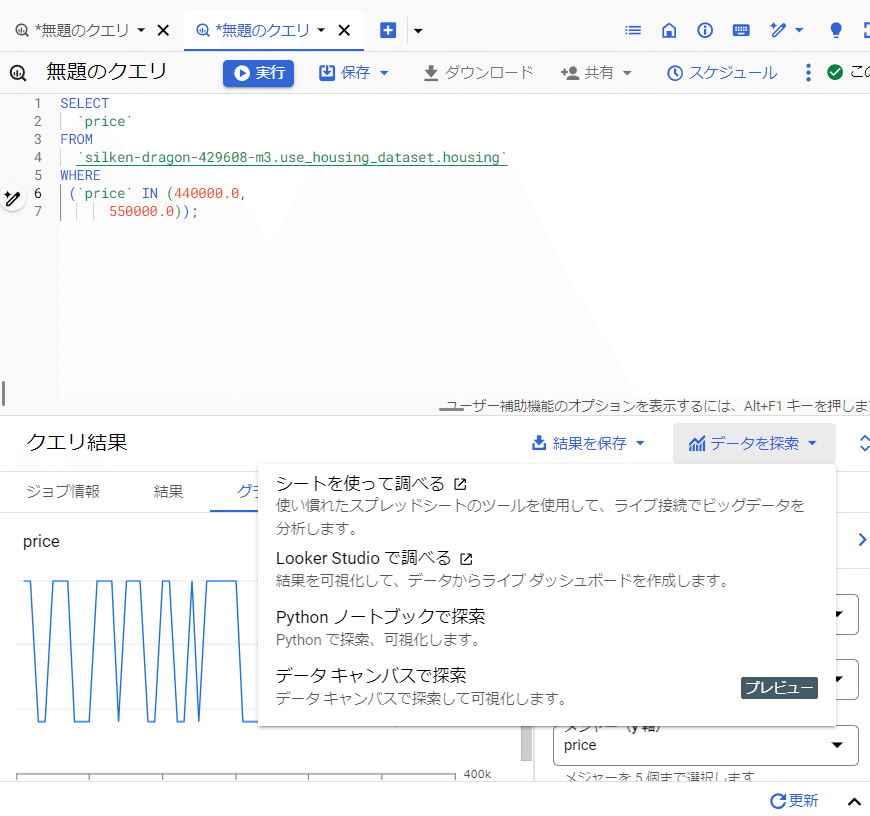

限定検索した出力結果を保存することができる。

限定検索を別の方法で分析もできます。

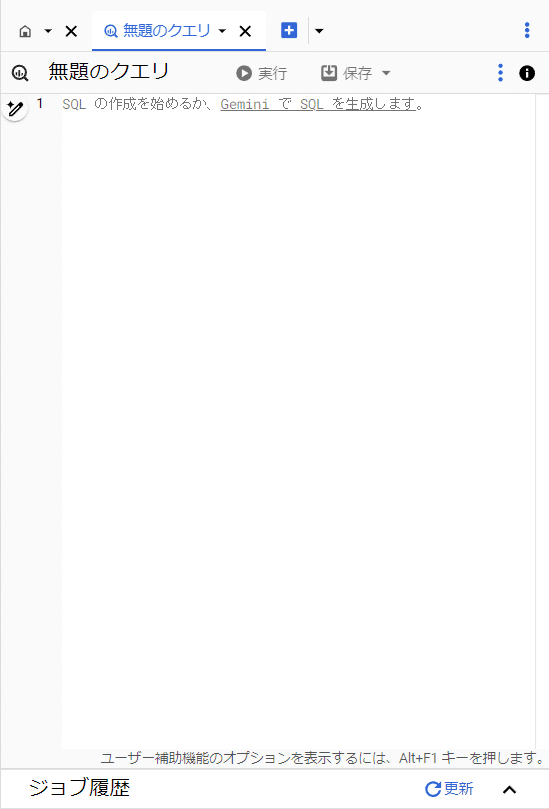

クエリを生成AI : Geminiで生成することができる。

注意

大量のデータを扱うため、使用量に応じた料金が発生し、予算管理が必要です。データの保存方法やクエリの最適化など、コストを抑えるための工夫を行いましょう。また、予算アラートを設定して使用量を監視することで、予期せぬ高額請求を避けることができます。

これらのツールを賢く使いこなして、ビジネスに役立つデータ分析を実現していきましょう。コスト管理に気を付けながら、データの力を最大限に活用してください。