iOS 15で画像分類や音声分類のモデルが「オンデバイスで」学習可能に #WWDC21

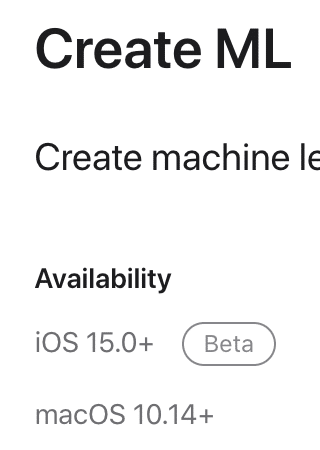

iOS 15ではCore MLはAPI的にはあまり大きな追加はなかった、とか思ってたら、なんと、Create MLのAPIがごっそり「iOSで」使えるようになっていた!

つまりImage ClassificationもSound Classificationも、iOSで「オンデバイス」で学習できるように!これはすごい。(というツイートをした)

iOSデバイスで学習できると何が嬉しいのか

たとえば音声認識により議事録を自動で取るアプリがあるとする。Sound Classifier(音声分類)がiOSで学習を行えるようになったことで、社内のAさんとBさんの声をアプリ内で動的に学習させ、AさんとBさんの声を分類しつつ議事録を起こす、ということが可能になる。

アプリ開発者が事前にAさんとBさんの声を収集しようがないので、こういった機能は従来の(Macの)Create MLで事前に学習させたSound Classifierモデルを使用する場合は提供できなかった。

Image Classificationも同様。Aさんの顔、Bさんの顔というのをエンドユーザーがパシャパシャと数枚写真を撮って学習することで分類可能になる。

従来のCore MLのオンデバイス学習との違いは?

オンデバイスの学習自体はCore ML以前から可能だった。

年末年始についにiOSでのオンデバイス学習に成功したので見てやってください。MNIST手書き数字認識の学習をゼロからiPhone上で行っています。 #coremlhttps://t.co/hTFbDjKMl5

— Shuichi Tsutsumi (@shu223) January 5, 2020

(Core MLのオンデバイス学習は拙著でも解説しています)

Image Classification, Sound Classificationに関していうと、一番の大きな違いは、Create ML APIを利用する場合、Vision Feature Print / Audio Feature Print(前者は拙著にて解説/後者は別記事で解説)を利用できる点だ。

端的にいうと、

ここから先は

#WWDC21 の勉強メモ

堤がWWDC 2021およびiOS 15についてセッションやサンプルを見つつ勉強したことを記事にしていくマガジンです。NDAの都合上、Ap…

Amazonギフトカード5,000円分が当たる

最後まで読んでいただきありがとうございます!もし参考になる部分があれば、スキを押していただけると励みになります。 Twitterもフォローしていただけたら嬉しいです。 https://twitter.com/shu223/