おっさん初めての生成AI(環境構築編 その2)

前回、無事Stable Diffusionを導入することができ、早速画像を作成し始めました。プロンプトを工夫して入力することで、いろんな画像が簡単にできるのが楽しいですね。

ローカルLLMも動かしたい。

画像生成についてネットを徘徊しているうちに、今度はAMDでローカルLLMを動かしてみたくなり、今回もいろいろと試してみました。ローカルLLMを動かすPCのスペックは前回記載しておりますが、GPUは、AMD Radeon RX6650XTになります。

また、環境構築には、以下のサイトを参考にさせて頂きました、

LM Studio

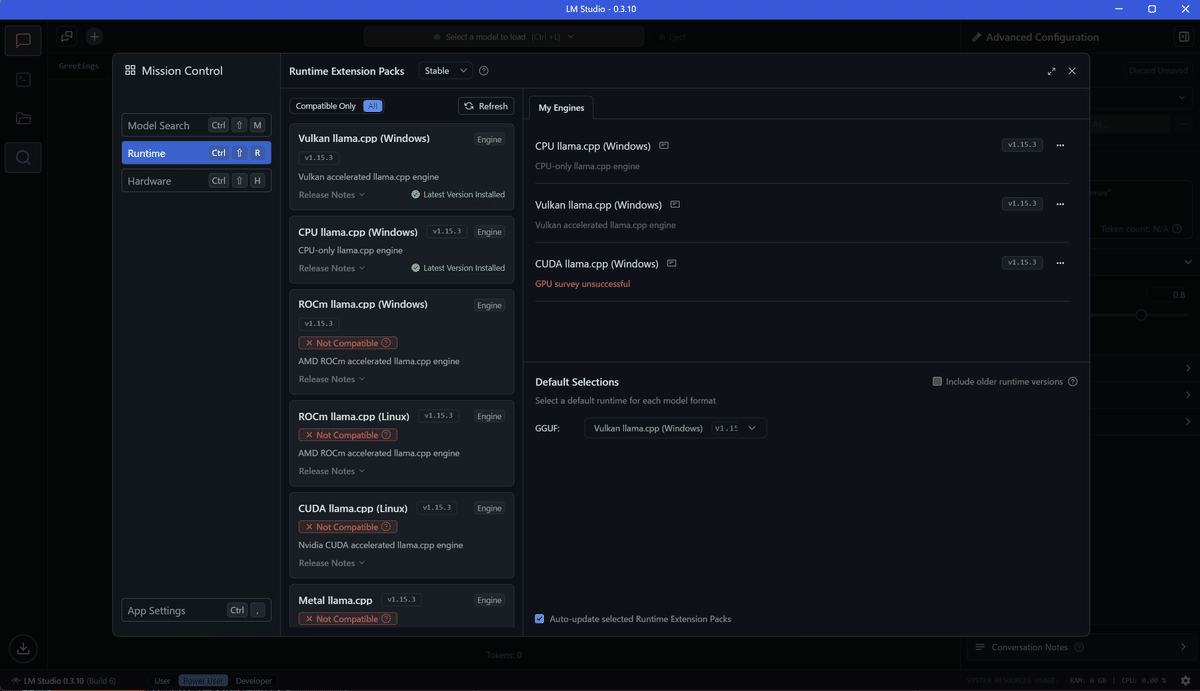

いろいろなサイトで導入が手軽と紹介されていましたので、まずはLM Studioにチャレンジしてみました。AMDのサイトで紹介されている手順を参考に、LM Studioをインストールします。Windows用インストールファイルをダウンロードして、ファイルをダブルクリックで簡単にインストールできます。LM Studioを起動すると以下の画面になります。

画面の中央付近もしくは画面左端にある虫眼鏡アイコンをクリックすると、モデルを探したり、モデル実行プラットフォームの選択、ハードウェア設定が行えます。"Model Search"で、"TheBloke/OpenHermes-2.5-Mistral-7B-GGUF"を検索しダウンロードします。

ダウンロードが完了すると、"Load Model"のポップアップが出ますので、クリックするとチャット画面が表示されます。

次に、"GPU Offload"を"Max"にするのと、"Detected GPU type"が"AMD ROCm"であることを確認しようとしましたが、Settingsの画面が分からない。画面上部のモデル名の左にある歯車アイコンがSettingsだと思われますが、"GPU Offload"は"32/32"となっているので恐らく"Max"、"Detected GPU type"の表示が無いので正しくGPUが認識されているのかが良くわかりません。

ひとまずこの状態で適当にチャットしてみて、処理中のGPU使用率を見てみました。タスクマネージャーからは、正常にGPUが動いているように見えます。

虫眼鏡アイコンからHardwareを見ると、GPUは正常に認識されています。

ただし、よく見るとVulkanの文字が・・・

どうもこれが原因のようです。Runtimeも確認してみますが、やはりROCmのRuntimeがインストールされていません。

インストールできるのかどうか確認するため、"Compatible Only"から"All"に切り替えてみると、"Not Compatible"って表示されています。

だめじゃん!ROCm使えない!

ただ、ここでいろいろと疑問が湧いてきました。

・Vulkan、CPU、ROCm、CUDAの違いって?

・そもそもllama.cppって何?

・Vulkanはだめなの?ROCmじゃないとだめなの?

などなど・・・

ということで、ネットの力で見よう見まねでやってきましたが、やはり知識不足すぎて難しすぎる。もう少し勉強が必要そうです。

尚、LM Studioの操作感についてですが、ChatGPTと同じくらいのレスポンスです。手持ちのGPUは1つだけなので、GPUの種類や性能による違いや、モデルの大きさなどによって変わってくるのかもしれませんが、少なくとも私の環境では、快適に使えています。

基礎勉強も進めつつ、いろんなモデルを試してみたいと思います。

最後までお付き合いいただきありがとうございました。