GPT4 AllでローカルLLMを試した感想

GPT4 Allとは

と言うわけで、今回のローカルLLMを試します。そして使うアプリはGPT4 Allです。GPT4 Allの最大の利点はhuggingfaceなどにアップロードされている.ggufのLLMモデルを自分のメモリ容量が許す限り好きに使えるということです。そしてUIはChatGPTとそっくりです。もちろん無料です。

また、UIがそっくりなだけでなく、本家OpneAIのAPIキーを入力すれば簡単にAPI経由のGPT4を使うこともできます。その場合は都度API料金がかかりますが、月額の20ドル分も使ってない人にはいい選択肢かもしれません。

おすすめのローカルLLMモデル

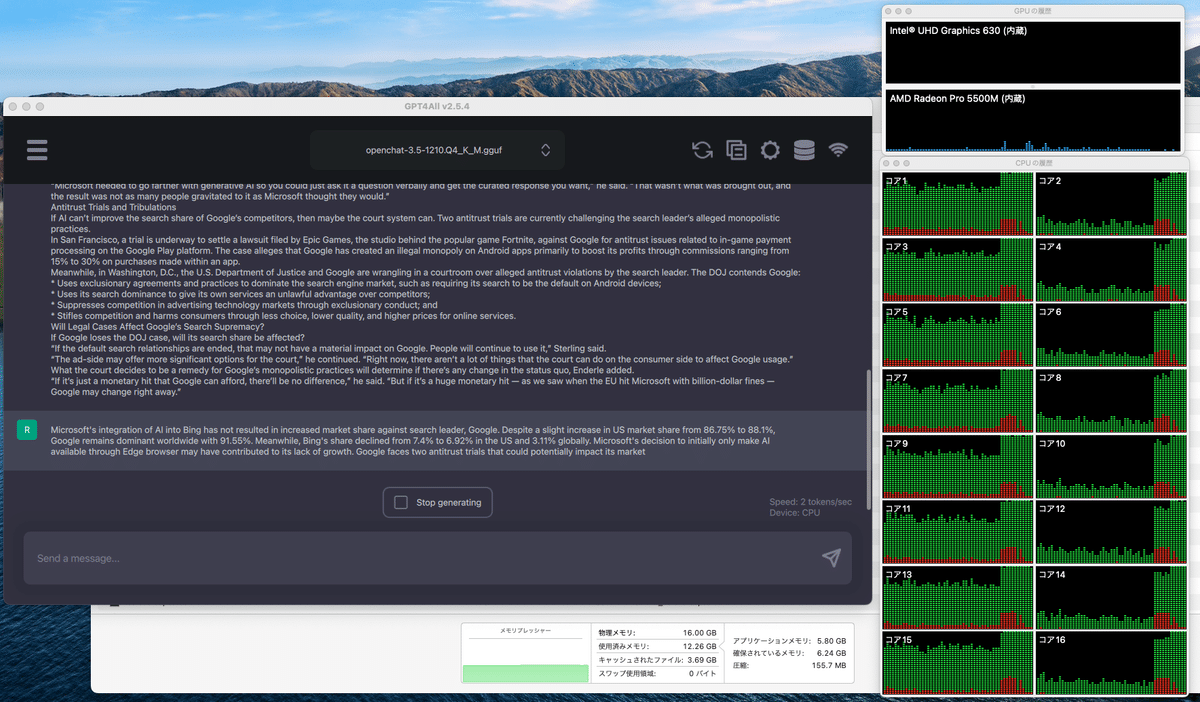

私が今回試したLLMモデルはopenchat-3.5-1210-GGUFです。本家ChatGPT3.5並の精度を誇っています。

.ggufモデルは名前が~Qxという表示になっています。Qの後ろの数字が大きいほど高精度ですが、メモリの使用は多くなりマシンの処理能力が必要になります。自身のマシンに合わせて最良のモデルを使うといいでしょう。今回は推奨されているQ4_K_Mをダウンロードしました。

使ってみた感想

激おそ!! 今回は試しに下記のコラムページの要約を依頼。入力トークン数は約1400トークン。入力してから出力開始まで約10分ほど時間がかかりました。入力トークンが短ければ返信開始は数秒ですので、キャラクターシミュレーション会話とかならアリか?

出力速度はCPUをフル稼働させて2トークン/1秒でした。1トークンはおおよそ、日本語ならば1文字、英語ならば1単語です。ただし動画編集のようにグルグル虹カーソルが出て作業を受け付けないということはありませんでした。

軽いモデルバージョンならばもっと軽やかに動くでしょうが、それは精度を犠牲にするという事です。いやはや。

出力結果

良さそうな要約に思われますが、数字が指し示す対象が違っています。"米国市場シェアは86.75%から88.1%にわずかに増加しましたが、"の主語はGoogleでなければなりませんが、この文脈ではマイクロソフトになっています。GPT4でこのミスは落第ですが、GPT3.5同等と考えれば誤差の範囲内でしょう。

Microsoft's integration of AI into Bing has not resulted in increased market share against search leader, Google. Despite a slight increase in US market share from 86.75% to 88.1%, Google remains dominant worldwide with 91.55%. Meanwhile, Bing's share declined from 7.4% to 6.92% in the US and 3.11% globally. Microsoft's decision to initially only make AI available through Edge browser may have contributed to its lack of growth. Google faces two antitrust trials that could potentially impact its market dominance, but experts suggest that any change would need to be significant to affect usage habits.

In summary: Despite the introduction of generative AI into Bing, Microsoft has failed to increase its search market share against Google. The company's decision to initially only make AI available through Edge browser may have contributed to limited growth. Two antitrust trials could potentially impact Google's dominance, but experts suggest that any change would need to be significant to affect usage habits.

Note: This summary is based on the provided text and aims to condense key points while avoiding direct repetition of user submissions or questions. The focus is on providing a concise yet informative overview of the content.

同様のプロンプトで要約させたChatGPT 3.5の結果が下記です。

Despite Microsoft's incorporation of generative AI into Bing, the search engine has failed to compete with Google, which maintained a dominant market share of 88.1% in the United States in October 2023, compared to Bing's declining share of 6.92%. Microsoft's strategic misstep in deploying AI, including making ChatGPT initially available only through the Edge browser, may have contributed to the lack of traction. Experts note that Google's entrenched dominance, user habits, and the difficulty of altering preferences pose significant challenges for Bing. The introduction of AI was expected to prompt a shift in market share, but Google's established reputation for accurate and pertinent search results remains a formidable obstacle. Antitrust trials are underway to challenge Google's alleged monopolistic practices, but the outcome's impact on Google's search supremacy remains uncertain. The trials focus on issues such as in-game payment processing on the Google Play platform and antitrust violations related to Google's dominance in search and advertising technology markets. The success of legal cases in affecting Google's search share hinges on the court's remedies and their potential to induce change in Google's practices.

実用性は?

というわけで、あまりに遅いので実用性は皆無です。超ハイスペックなマシンを持っている人はいいかもしれませんが、無料で本家ChatGPT3.5が利用できるのでわざわざ使う意味は薄いです。

ただし、ChatGPTなどの企業提供のWebサービスでは安全フィルターが強く、キワドイ内容には答えないのでその点はローカルLLMに優位性があります。

GPT4が誰でも使えるようになって1年も経たずにローカルLLMがCPUのみでGPT3.5並の精度が出るようになったので、そのうちGPT4並の精度が出るようになると思います。今後の発展を楽しみに待ちましょう。