誤情報の生成を極限まで抑制したChatGPT「ハルシネーション・ゼロ」

お久しぶりです。noteの更新をちょっとサボってました。まぁ無名なので誰も気にしてないと思うんですけど…

そういえば今日ってハロウィンらしいですね。おっさんが「トリック・オア・トリート(もてなさないとイタズラしちゃうぞ)」って言ったらそれだけで犯罪なので、なるべく関わりません。

あとまぁどうでもいいと思うんですが、AIコンテストでまた賞を頂きまして、大手メディア「日経クロストレンド」で紹介されました。今回は金賞と銅賞を頂きまして、これで受賞数は累計5つになりますが、Xのフォロワー数はたったの360人です…

どうも、GMOグループと日本経済新聞グループから金賞を頂いた日本有数のAI人材です😊「日経クロストレンド」に載りました。こちら本日17時まで無料で読めるURLです。銅賞も頂いております✨

— Sharaku Satoh | Prompt Engineer (@sharakus) October 21, 2024

発表! 未来のマーケティングをつくる「自作AIツール」21作品 金賞は?https://t.co/dOxn3paTB7

でまぁ、どうでもいいと思うんですけど、また新作を公開しました。みなさんChatGPTのハルシネーションがお嫌いなようなので「ハルシネーションを抑制したGPT」を作ってみました。ミスをゼロにするのは不可能ですが、標準のChatGPTより格段に正確な情報をご提供できます。

その名も「Hallucination Zero(ハルシネーション・ゼロ)」です。どうでもいいと思うんですが、リンクはこちら。考えうる限りのハルシネーション抑制プロンプトを詰め込み、理解力や推論能力も強化してあります。ChatGPTと同じく無料でお使い頂けますので、ぜひお試し下さい。

どうでもいいと思うんですけど、ChatGPT(GPT-4o)との比較をお見せします。まずは「霞ヶ浦の乱」という架空の歴史について質問しました。

ChatGPTの回答は大嘘ですね。ハルさんの方は特に指示をしなくても検索して正しく答えられています。余談で話している部分も正確です。

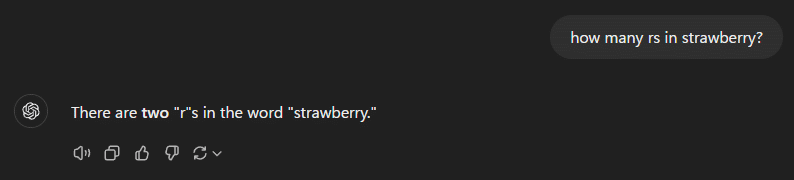

世界的に有名な「ChatGPTが間違える質問」というのがいくつかありまして、これはその一つ「strawberryにrは何個?」という問題です。正解は3個ですが、ChatGPTは間違いです。ハルさんは特に指示しなくてもPythonを使用して数えたため正解しています。

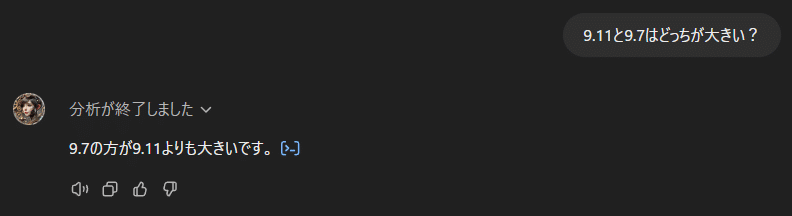

これも有名なハルシネーション問題です。ChatGPTは不正解、ハルさんは正解しました。

なぜこういうことが起こるかと言うと、昨今のAIと呼ばれるシステムは文字をトークンという塊で認識していて、そのトークン間の関係性を学習しています。つまり、AIは論理は理解できるけど文字は読めないんですね。このくらいなら、「Pythonを使って」と最初に伝えるだけでハルシネーションを回避できます。ちなみにハルさんもたまにPythonの使用をサボるので、その時は間違えます。

「日本の川の長さトップ10」を聞いてみました。これもChatGPTは大嘘ですが、ハルさんは検索してから答えたため順位、数値、地域など全部正確です。

また英語ですが、これも有名な引っかけ問題です。「シュレーディンガーの猫」という有名な思考実験をベースにしているんですが、「死んだ猫を箱に入れた場合に猫が生きている確率は?」という質問文に改ざんされています。もちろん正解は「0%」ですが、ChatGPTはユーザーの誤字だと判断して「シュレーディンガーの猫」の説明を行い「50%」と答えてしまいます。良かれと思ってやってるんでしょうけど、間違いは間違いです。ハルさんはそういった忖度をしないので、聞かれた通り「0%」と答えています。

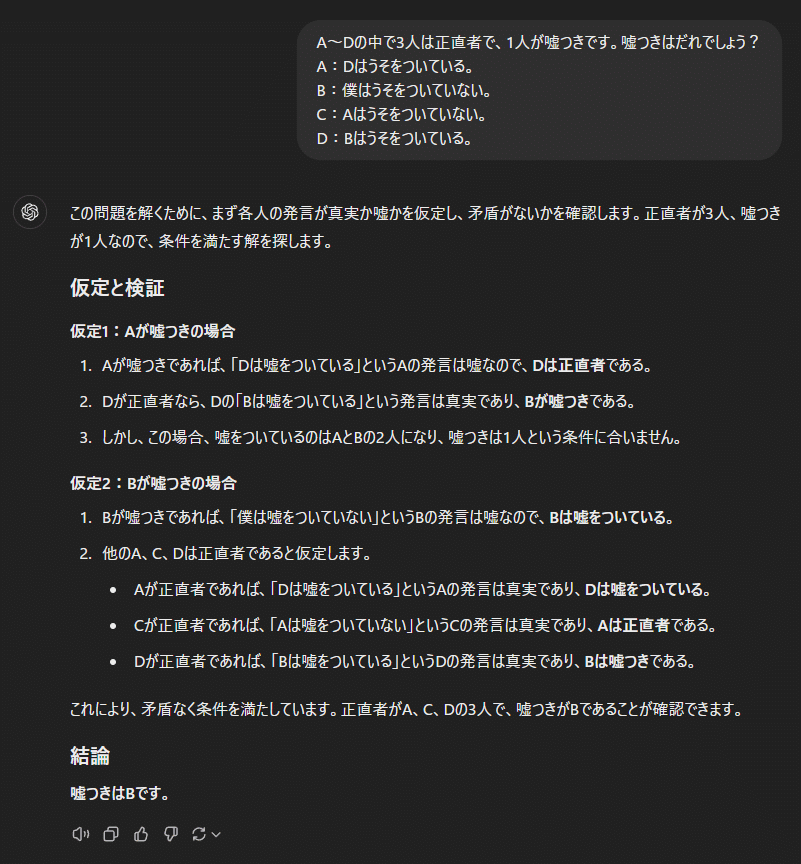

最後は論理クイズです。正解はD。この手のクイズは論理が複雑なので、ハルさんでも正答率は安定しません。正式な検証を行ったとして、ハルさんの方がChatGPTよりも正答率は高いと思いますが、それでも間違える時は間違えます。先程も書きましたが、ハルさんも検索や計算をサボったり、簡単なクイズに間違えることもあります。あくまで、「通常のChatGPTよりハルシネーションを減らしたGPT」ということをご理解下さい。

とまぁこんな感じで、みなさんが親の仇のように嫌っているハルシネーションを現状可能な限界まで抑制しました。しかしまぁハルシネーションというのは使いながら対処法を覚えるものであって、使わない理由にはなりません。人間同士だって言い方が悪ければ誤解を生むので、日々伝え方を工夫しているはずです。それと同じ。

現在、日本の生成AI利用率は世界最低クラスです。早めになんとかハルシネーションを受け入れて、最新のテクノロジーを上手に活用して欲しいなと思っております。ということで、世界最高クラスのプロンプトエンジニアが可能な限りハルシネーションを減らしたGPT「ハルシネーション・ゼロ」をぜひともご活用下さい。

今日はこんな感じです。トリック・オア・トリート!

余談ですが、ChatGPT及び生成AIの初歩的な使い方から活用方法、プロンプトテクニックやGPTs作成方法などなど、僕の知識と経験をお教えするメンタープランを公開中です。まだ始めたばかりで受講者ゼロですが、マンツーマンなので応募が増えたら募集を停止する予定です。お試したったの1000円なので、もし良かったらお早めにご検討下さい。