LLMニュースまとめ[2024年8月26日~9月1日]

2024年8月26日~9月1日のLLM関連のニュースとして有名なもの、個人的に刺さったもの15点を以下にまとめる。

1. GameNGen

GameNGen: ニューラルモデルのみで構成された初のゲームエンジン

2. Agentic RAG for Time Series Analysis

時系列用のために、Agentic RAGを提案。メインのエージェントが全体統制、サブの時系列に特化したエージェントがそれぞれのタスクを解く。過去のパターンや傾向に関する知識をプロンプトプールに集約し、推論に役立てる。

3. AutoGen Studio

AutoGen Studio:Microsoft Researchが発表した、AI エージェントを迅速にプロトタイピングするためのローコード・インターフェイス。マルチエージェントワークフローのデバッグや評価にも使用可能。

4. Smaller, Weaker, Yet Better

限られた計算リソースの中で、LMの推論性能を最大化するために計算コストの低いモデル(WC)で生成したデータの活用を提案。

WCモデルで生成したデータは、カバレッジと多様性が高いが、偽陽性率も高い。

だがWCデータで訓練したモデルが、計算コストが高く、質の高い(SE)データで訓練したモデルを一貫して上回ることを発見。

5. Transfusion

Transfusion: テキストと画像の両方を同時に扱うことができるAIモデルを作る方法であり、言語モデルの学習方法(次の単語を予測する)と、画像生成に使われる「拡散モデル」を組み合わせている。

画像を16個の「パッチ」(小さな区画)に圧縮しても高い性能を維持できたそう。

6. ReMamba

ReMamba: Mambaモデルのロングコンテクスト性能を改善するために提案された手法。

7. TAG

データベース上の自然言語の質問に答えるための、統一されたパラダイムであるTAG(Table-Augmented Generation)を提案。TAGモデルは、これまで未開拓であったLMとデータベース間の関係性を表現。

8. Guide to Continual Multimodal Pretraining

継続事前学習や効果的な継続的モデル更新のための包括的ガイダンス。継続事前学習の解析のためのデータセットであるFoMo-in-Fluxデータセットを提案。

9. VLM tutorial

VLM理解のためのチュートリアル論文。(実際abstructに書いてある)

VLMの原理や手法、Idefics3-8Bの作成方法について記述。

10. Online Subspace Descent

射影行列の任意の更新ルールに対する収束保証を提供。

SVDを用いない新しいオプティマイザであるOnline Subspace Descentを提案。

11. Power Scheduler

WSDスケジューラの最適な学習率、バッチサイズ、学習トークン数の相関を研究し、変数間にべき乗の関係があることを発見。

学習トークン数とバッチサイズに依存しない新しい学習率スケジューラPower schedulerを提案。

12. LlamaDuo

LlamaDuo: LLMOpsパイプライン

開発/PoCフェーズでの①プロンプト設計、②データセット収集(プロンプト、応答)、アライメントフェーズでの、③訓練、④推論、⑤評価、⑥データ合成をモデルの性能が閾値を満たすまで実施できる。

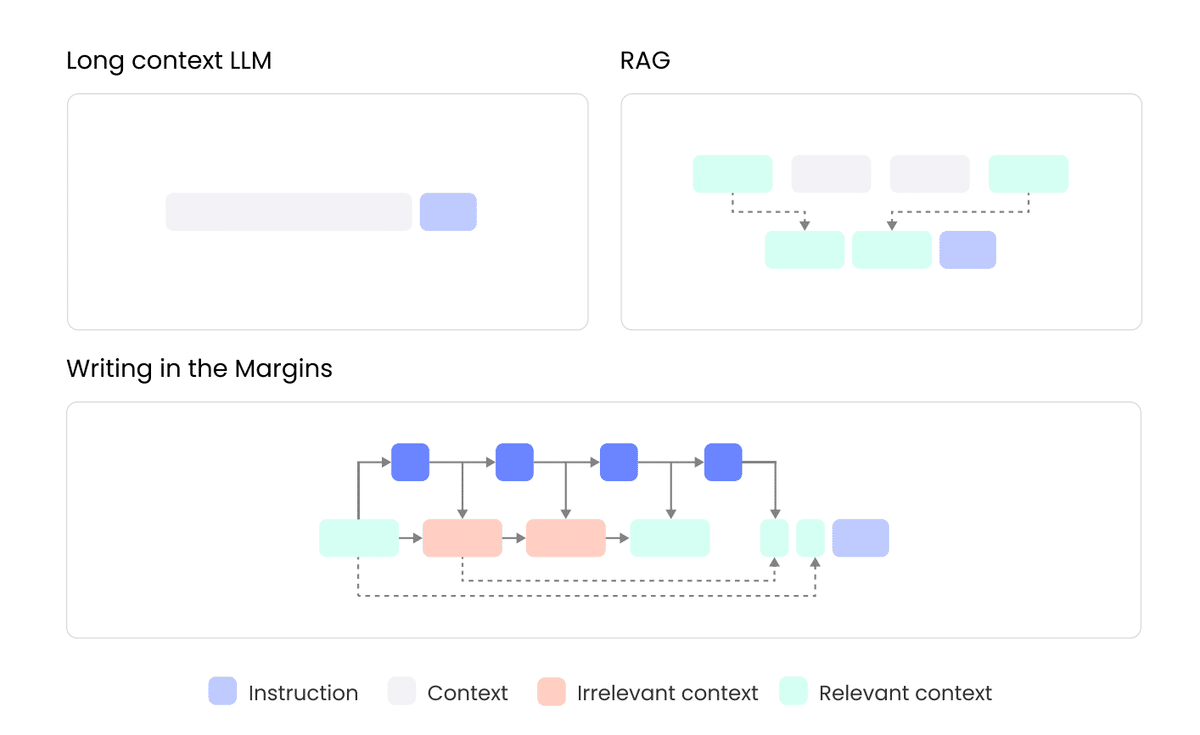

13. Writing in the Margins (WiM)

WiM: ロングコンテキストの入力をチャンク分けし、各チャンクを処理する際に、そのチャンクに関連する情報を抽出する「マージン」を生成し、関連する「マージン」のみをフィルタリングして元のコンテキストに追加する手法。

14. Knowledge Navigator

Knowledge Navigator: 科学文献を効果的に探索するためのツール

Knowledge Navigatorでは検索された文書が埋め込まれ、クラスタ化される。その後、各クラスターにタイトルが付与され、構造化される。

15. WavTokenizer

WavTokenizer: 音声信号を効率よく圧縮しつつ、高品質に再現するトークナイザー

WavTokenizerは圧縮効率に優れ(1秒の音声(24kHzのサンプリングレート)を40〜75個の「トークン」に圧縮)、高品質な再現が可能。(UTMOSスコアが高い。)