Pacific Hacker Conferenceへ参加してきました

11/2(土)にPacific Hackers Conferenceが開催されました。

開催日時:2024.11.2(土)9:00-18:00

会場:Hacker Dojo, Mountain View, CA, USA

スポンサー:Google、Checkmarx、Akamai、etc

会場の様子:以下の写真参照

以下は発表

タイトル:「APIセキュリティにおける認証と認可の脆弱性と対策」

発表内容

認証(Authentication)と認可(Authorization)の違い

認証はバイナリ的な判断で、全製品に一貫して適用される。

認可は機能やポータルに依存し、ユーザーによってアクセス権限が異なるため、実装が複雑で脆弱性が生じやすい。

API脆弱性の種類

BOLA(Broken Object Level Authorization):

オブジェクトIDやユーザーIDを操作することで、他のユーザーのデータに不正アクセスする脆弱性。

**OWASP APIトップ10(2023年版)**で頻出する脆弱性。

BFLA(Broken Function Level Authorization):

機能IDを操作し、本来アクセスできない機能を不正に利用できる脆弱性。

具体的な脆弱性の事例

EHRシステム(電子カルテ):

15年分の医師記録が含まれるデータベースを持つ大規模システム。

複数の診療所にまたがる患者データを管理。

UI上の「印刷」ボタンからクレームIDを操作し、他の患者のデータにアクセス可能。

増分ID(incremental ID)を利用して、連続的にクレームデータにアクセス可能。

別の事例では、UIに表示されない編集・削除ボタンを直接API経由で操作することで、不正にデータを改変可能。

テグス(Tegus):

専門家インタビューを提供する製品で、ライセンス料は年間10,000~20,000ドル。

API呼び出しでハードコードされた20件のレコードを返すが、2000件や20,000件といった無制限のリソース取得が可能。

Feeld(デーティングアプリ):

認可が欠如しており、他ユーザーのメッセージや写真、プロフィール情報の取得・送信が可能。

発見から修正まで約6ヶ月を要した。

Arcブラウザ:

Firebase上に保存された「Boosts」機能により、他ユーザーのプロファイルにスクリプトを不正にアップロードし、リモートコード実行(RCE)を引き起こす脆弱性。

脆弱性報告から24時間以内に修正された。

セキュリティ対策

モニタリング:

セッションごとの失敗サーバー呼び出し数や不正なAPIアクセスを監視。

テスト自動化:

CICDプロセスでの認可脆弱性テスト(ファジング)を導入。

リファクタリング:

増分IDやグローバルIDの再検討、認可機構の実装強化。

セマンティック分析の難化:

パラメータ名を直感的でなくすることで、解析を困難にする。

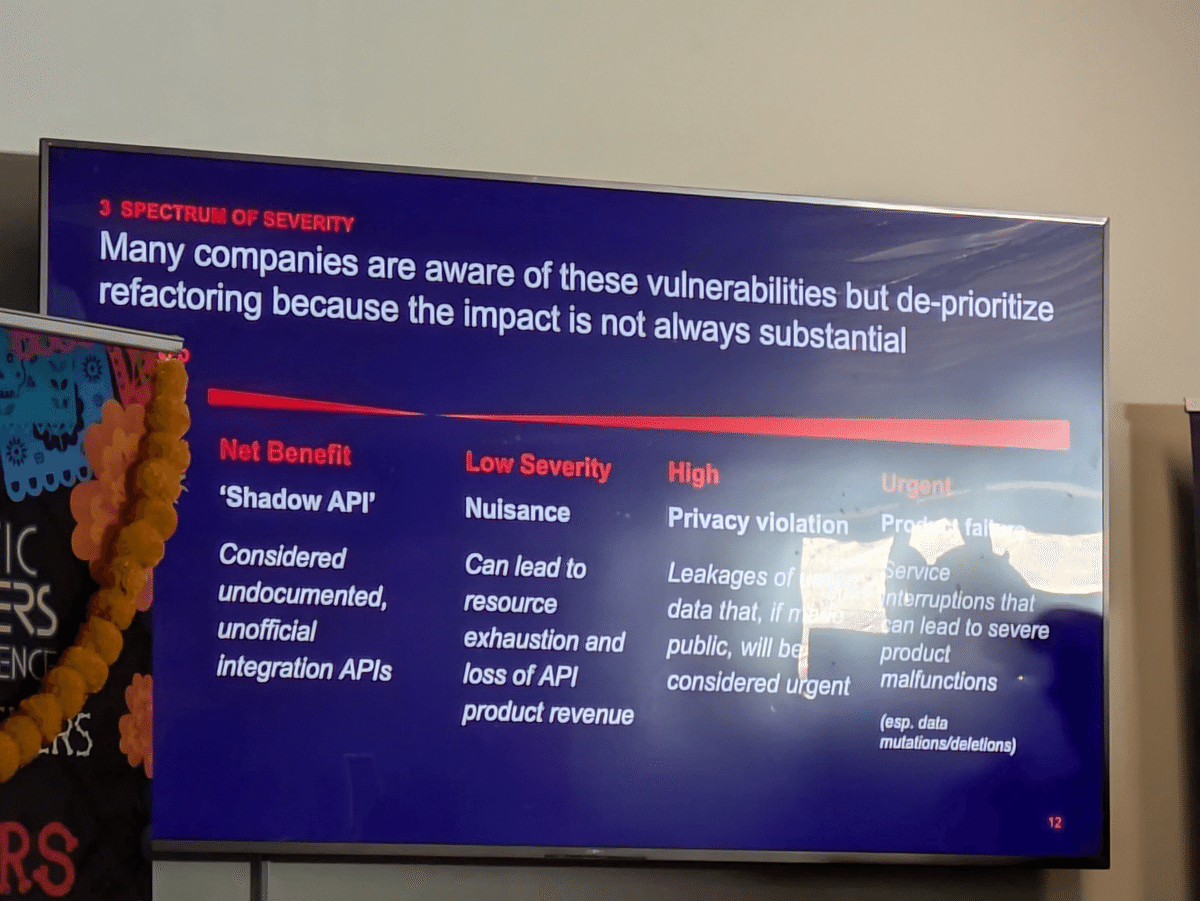

脆弱性の影響とリスク評価

多くの企業が脆弱性の存在を認識しているが、影響が常に重大でないためリファクタリングが優先されないケースが多い。

リスクのカテゴリ:

低リスク:リソース消費やAPI収益の喪失

高リスク:プライバシー侵害

緊急:データの改変や削除による製品の重大な障害

キーワードと数値情報

APIセキュリティ:認証と認可の欠如による脆弱性が多発

BOLA(Broken Object Level Authorization):他のユーザーのデータへの不正アクセス

BFLA(Broken Function Level Authorization):本来アクセス権がない機能を不正に利用

OWASP APIトップ10(2023年版):BOLAやBFLAが頻出する脆弱性

タイトル:「データ駆動型防御:機械学習を用いたネットワークトラフィック解析」

発表内容の概要

この発表は、ネットワークトラフィック解析における機械学習(ML)の活用をテーマにしています。IoT(モノのインターネット)やIIoT(産業用IoT)デバイスの急増に伴い、ネットワークへのサイバー攻撃のリスクが増大しています。発表では、機械学習を導入した侵入検知システム(IDS)が、従来のルールベースのシステムよりも柔軟かつ高精度で脅威を検出できることを解説しています。また、IoT/IIoT環境に特化したデータセットを用いて、IDSの構築・評価プロセスを実演しました。

キーワードと関連情報

IoTおよびIIoTデバイスの増加:

2024年末までに、270億台以上のデバイスがネットワークに接続されると予測(Forbes, 2023)。

IoTヘルスケア市場は2023年に1500億ドルに達し、2028年までに2890億ドルに成長する見込み。

ネットワークトラフィック解析(NTA):

NTAはネットワーク内の通信の監視・解析を行い、異常を検出することで、セキュリティと運用の問題を特定。

攻撃を早期に検出することで、対応時間を短縮し、攻撃対象領域を最小化する役割を果たす。

侵入検知システム(IDS)における機械学習の利点:

従来のIDSはシグネチャベースで、既知の攻撃パターンのみを検出可能。

機械学習を用いることで、未知または進化する脅威を検出できる。

例えば、異常検知型のIDSにMLを適用すると、ネットワーク行動のパターンを分析し、固定ルールに依存せずに脅威を特定できる。

データセットとテストベッド:

使用されたデータセット:「Edge IoT Dataset」

2022年発表、IoTおよびIIoT環境におけるサイバーセキュリティのための現実的なデータセット。

7層のテストベッド構成:

クラウドコンピューティング層、ネットワーク機能仮想化(NFV)層、ブロックチェーン層、フォグコンピューティング層、ソフトウェア定義ネットワーキング(SDN)層、エッジコンピューティング層、IoTおよびIIoT知覚層。

1090台以上のデバイスから収集されたデータ。

63種類の特徴量が抽出され、さまざまな攻撃(DDoS、SQLインジェクションなど)に対応する情報が含まれる。

前処理とデータ準備:

重複データや欠損値の削除、カテゴリ変数のエンコード、データの正規化。

トレーニングとテスト用に80:20の割合でデータを分割。

データのサンプリングにより、120,000件のデータを使用してモデルを訓練。

モデル構築と評価:

Gaussian Naive Bayes:シンプルかつ高速で、特徴量間が独立していると仮定する分類アルゴリズム。約88-89%の精度を達成。

Random Forest:複数の決定木を使用し、約99.8%の精度を達成。ランダムフォレストは高次元データに適しており、特徴量の重要度も評価可能。

PCA(主成分分析):63次元のデータを2次元に縮約し、データのパターンを可視化。45成分でデータの**95.13%**の分散を説明可能。

K-meansクラスタリング:2つのクラスタに分類し、正常なトラフィックと異常なトラフィックを視覚的に分離。

特徴量の重要度:

ランダムフォレストで重要な特徴量を分析。たとえば、DDoS攻撃では特定の特徴量が予測に大きな影響を及ぼす。

特徴量の可視化により、各攻撃タイプに対する重要な特徴量が特定され、より詳細な脅威分析が可能に。

数値情報のまとめ

270億台以上のデバイスが2024年までにネットワークに接続(予測)。

IoTヘルスケア市場の価値は2023年で1500億ドル、2028年までに2890億ドルに成長見込み。

データセットは1090台以上のデバイスから収集され、63種類の特徴量を含む。

トレーニングデータは約120,000件にサンプリングし、80:20でトレーニングとテストに分割。

Gaussian Naive Bayesモデルで88-89%の精度、Random Forestで99.8%の精度を達成。

PCAによる次元削減で、45成分でデータの**95.13%**の分散を説明可能。

タイトル:AIモデルのバックドア攻撃とセキュリティ対策についてのセミナー

発表内容

この発表では、AI(特にLLM、Large Language Models)に対するバックドア攻撃や回避手法について詳細に説明されています。LLMのバックドアとは、意図的に組み込まれた、特定のトリガーによって悪意ある動作を誘発する仕組みを指します。主な内容は以下の通りです。

バックドアの概要と種類

バックドアはモデルのテンサ(Tensor)やベクトルデータベースの一部に埋め込まれ、特定の入力によりトリガーされる。

これには「毒盛り(ポイズニング)攻撃」や「回避(イベージョン)攻撃」などがあり、毒盛り攻撃はモデル訓練時にデータに細工をするもので、回避攻撃はデプロイ後のモデルを対象にするものです。

攻撃手法と事例

ポイズニング攻撃: モデルの訓練データに悪意あるデータを追加し、意図的な誤認識を引き起こす。特に公開データセットに毒を盛ることで実施可能。

イベージョン攻撃: 入力の工夫によってモデルが意図しない応答を返すようにする。例として「プロンプト注入攻撃(Prompt Injection)」が挙げられる。

攻撃の検知と防御策

モデルの継続的監視による異常検知(モデルドリフト、バイアスドリフトの検出)。

キャッシュの管理とアクセス制御。モデルが過去のクエリをキャッシュすることで、認可されていないユーザーに対してデータが流出する可能性がある。

モデルのフィルターとガードレール(安全策)の強化。

将来の脅威と課題

LLMが広範に利用されることで、攻撃対象が拡大する可能性が指摘されている。特にエージェントベースのモデルは、リモートコード実行(RCE)リスクを伴う。

防御策の発展が必要であり、モデルの再訓練やベクトルデータベースの更新を通じてバックドアを無効化することが提案されている。

キーワード

LLM(大規模言語モデル)

バックドア

ポイズニング攻撃

イベージョン攻撃

プロンプト注入

モデルドリフト

データキャッシュ

ガードレール

リモートコード実行(RCE)

エージェントベースモデル