M1 Macで英語の動画やPodCastを文字起こしする方法メモ

M1 MacでSoundFlowerが使えないため、いろいろ調べてこれに落ち着きました。

英語のカンファレンスを見る時や、同僚が週末の度にレコメンドしてくれるPodCast、はたまたサッカー実況を見る時に使っています。

※YoutubeやTwitchのクローズドキャプションは高精度だと思いますが、画面上を流れるのが速くて追いつかないことが多く。それに引き換え、テキストにしてファイルに書き出せば翻訳ツールにかけることもできるので大変助かるのです。

※著作権の問題があるので、個人用途のみですよっ、もちろん

環境:

MacBook Pro (13-inch, M1, 2020)

OS : Big Sur

(1) BlackHoleをインストール

仮想オーディオデバイス。音声の出力先をこれにして、音声の入力元もこれにすることにより、同じMac上で受け取ることができる。

(2) アプリケーション>ユーティリティ>Audio Midi.appで「複数出力装置」を作成

(3) システム環境設定>サウンド>出力>複数出力装置を選択

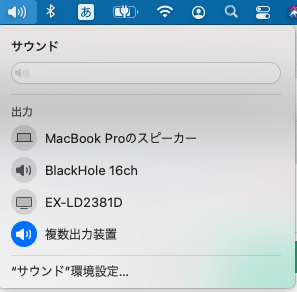

あるいは手っ取り早く、メニューバーのサウンド>複数出力装置を選択

(4) Chromeブラウザで、Google ドキュメントを開き、ツール>音声入力を選択

マイクのポップアップが表示されたら、上から二段目をクリックして「English(United States)」など、対象言語を選択し、クリック。

この常態で動画やPodcastをを再生すると、文章が表示されます。

注)マイクは無音が続くとオフになってしまうので、時々クリックしてオンにする必要あり。

そのため、長時間聴き続ける時は、Pixel4の純正音声文字アプリを使っています。机の上に置いてサブモニタ的に使ってます。GoogleのUS英語の聞き取り能力は高いですね。なお同じGoogleでも、Chrome+Google ドキュメントの音声入力より、Pixel4 + 音声文字アプリの方が高い気がします。

おまけ

聞き取り精度を比べてみました。こちらのpodcast の冒頭の数秒を比べてみます。

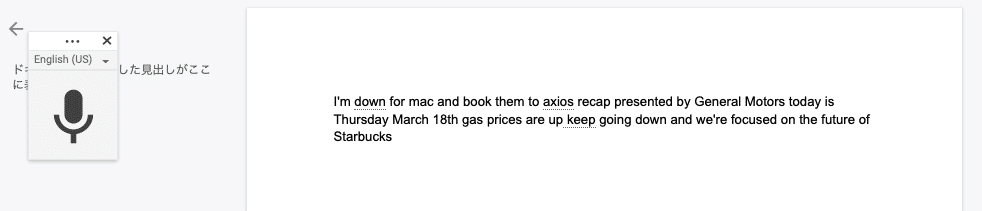

まずGoogle ドキュメント。

次にPixel4の音声文字アプリ。

Google ドキュメントは出だしの「Hi and welcome」のところが間違ってますね。同じMac内で音声をバイパスしてるのに、こっちの方が聞き取りが下手というのは何故なのか。両方ともネットに繋がっていないと変換できないので、クラウドのSpeech-to-textを使っていると思われますが、その上で、使ってる内部ロジックが違うんでしょう。もしかしたらPixel4の方は、モバイルアプリということもあり、帯域を使わないようにする工夫の一貫として、内部である程度処理してからサーバーに送ってるのかもしれません。何かすごい圧縮技術にくわえての何かすごいローカル処理が??

現場からは以上です!