Code for Nerima に登壇し VoiceOver について話してきた

以前書いた記事でご紹介した同僚の全盲のエンジニア中根さんのお誘いで、 Code for Nerimaという地域に密着したコミュニティーのイベント に中根さんと共に登壇しVoiceOver 対応アプリの開発方法などについて話させていただきました。イベントでは、中根さん、阿部のそれぞれの発表の後、代表の青木さんとのパネルディスカッションをさせていただきました。それらついてまとめたのでご紹介いたします。

今回のセミナーは全盲の「中根雅史」さんにお越しいただきVoiceOverでのiPhoneの使い方をレクチャーしてもらいます。そして中根さんと同じ会社で働くプログラマー「阿部諒」さんにアプリの実装上の工夫したことなどをお話しいただきます。そしてCode for Nerima代表の青木の方からはAppleが取り組むアクセシビリティのトピックをご紹介したいと思います。パネルディスカッションやみなさんからの質問などもお答えして「「なぜいまアクセシビリティに取り組むことが大事なのか?」を考えてみたいと思います。

そもそも Code for Nerima とは

Code For Japanという「自分たちの街の課題を技術で解決するコミュニティ作り支援や、自治体への民間人材派遣などの事業に取り組む非営利団体」があり、Code For Nerima はその内の Brigadeという地域コミュニティーの一つになります。代表は、聴覚障害者とのコミュニケーション支援のためのアプリUDトークの作者で、中根さんがやられているPodcast「AccSell」にも以前出演されたことのある、Shamrock Records 株式会社代表取締役 青木 秀仁さん。Code for Nerima では Code For Japan の理念を引き継ぎつつ「みんなで練馬を楽しもう」というコンセプトのもと活動をされているとのこと。

そんな青木さんともともと交流のあった中根さんが、 VoiceOver の利用方法や開発上の工夫、そもそも「なぜいまアクセシビリティに取り組むことが大事なのか?」などについて話す場を設けようということで、お声がけをいただき登壇することとなりました。

では、それぞれが話された内容とパネルディスカッションについて簡単に紹介いたします。

VoiceOver レクチャー by 中根さん

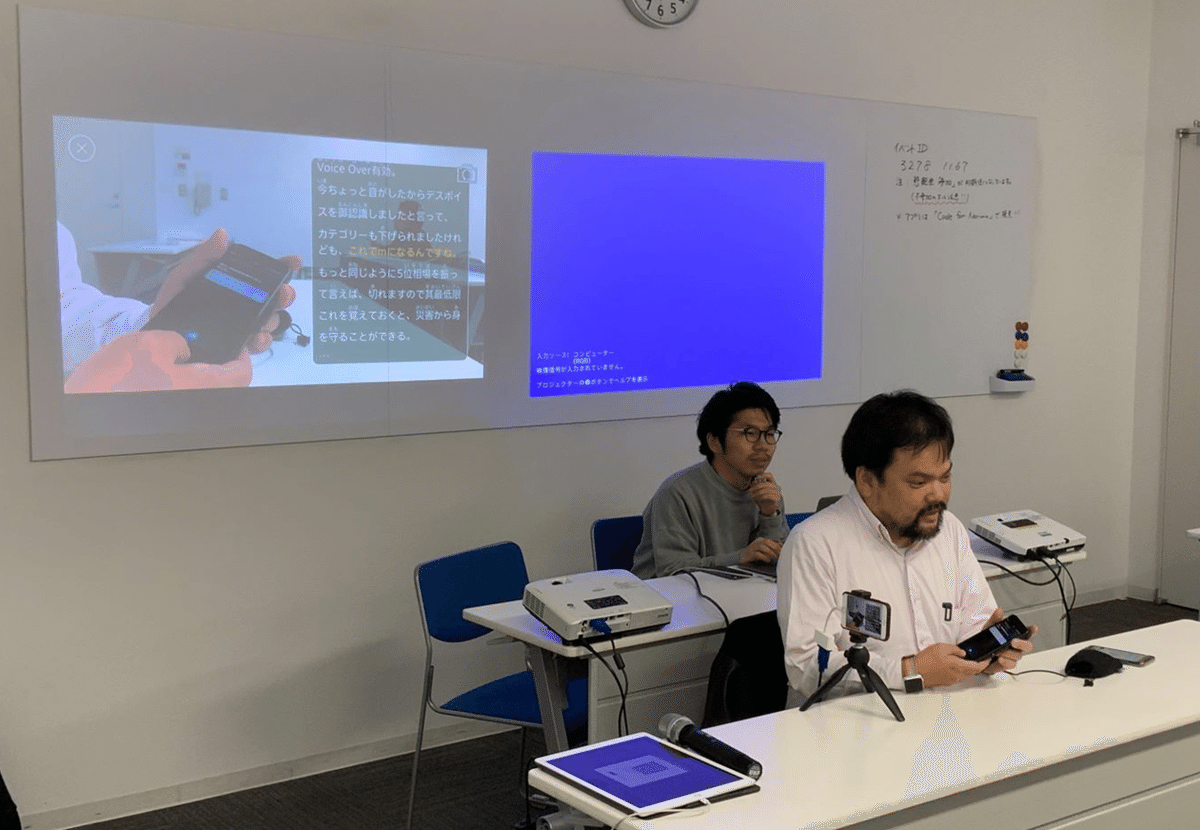

中根さんの iPhone をスクリーンに映しながら VoiceOver の使用方法についてレクチャーしていただきました。

中根さんが VoiceOver で iPhone を操作しレクチャーしている様子

・VoiceOverのON/OFF

OFFに出来なくて大変な目に合う可能性があるためちゃんと知っておく必要があります。手軽に試すには Siri を使うのが良いですが、ショートカットを設定しておくと楽にON/OFFができます

・VoiceOver がなぜ必要なのか

タッチスクリーンは凸凹していないため全盲の人にとってはどこに何があるか分からない。駅の券売機や銀行の ATM など最たるもの。だが、タッチスクリーンのデバイスの iPhone には VoiceOver という画面上の情報を読み上げてくれる機能があるため、全盲の人でも利用可能である

・VoiceOver の操作方法

ホーム画面を例として、VoiceOver が有効にすると触ったアプリがなんなのかということをまず教えてくれます。アプリが選択されると枠線が表示され「選ばれた」という状態となります。その状態から画面のどこかをダブルタップするとアプリが起動します。左右にスワイプすることで、Windowsパソコンの Tab キーによる操作のようにフォーカスを移すことができます。

・キー入力の方法には2つ

標準入力モードという左右スワイプで対象の文字を探して入力する方法と、タッチ入力モードという画面を指で触った状態で文字を見つけて指を離すと入力されるという方法があります。慣れると後者のほうが楽です。

・スクリーンカーテン

機能3本指でトリプルタップすると画面が真っ暗(スクリーンカーテン オン)になる。こうすることで電車の中で覗き込まれる心配せずに使用できます。

・ローター機能

(人差し指と親指の)2本指でつまみを回すような操作をすると、「単語」、「文字」、「言語」、「読み上げ速度」といった風に読み上げられる。「読み上げ速度」の状態で上下スワイプすると音声のスピードを変えられます。「文字」の状態で画面上の文字にフォーカスを当てると一文字ずつ文字を読み上げてくれます。このローター機能を知らないとVoiceOverは非常に不便かと思います。

VoiceOver 対応に携わった僕でも、「単語」や「文字」のローター機能についてや、キー入力に標準入力モードやタッチ入力モードがあることは知らなかったため新しい発見がありました。

VoiceOver 対応アプリ開発について by 阿部

以前作成したスライドを元に標準コンポーネントを使用していれば対応は不要だが、独自UIを実装したり画像のボタンを配置すると途端に意図した様に読み上げられなくなるので、そういった際の具体的な対応方法についてお話ししまいた。

また、晴眼者の私もVoiceOverを使っており、iPhone の Kindle アプリで読書する際に VoiceOver を使うことでオーディオブックのように手を使わずに歩きながらでも読む(聞く)ことができるため、読書が捗りますよという話しもしました。

阿部が話している様子

(後日、VoiceOver をオンにしなくても、[設定] > [一般] > [アクセシビリティ] > [スピーチ] > [画面びの読み上げ] という機能でも出来るよというのを青木さんに教えていただきました。こっちの方がページめくりや読み上げスピードの変更などが楽そうです)

WWDC の a11y セッションについて by 青木さん

WWDCは Apple が毎年開催しているエンジニア向けの技術カンファレンスです。アクセシビリティーに関係したセッションも毎年いくつかあり、そのうち去年のWWDCのセッション「Deliver an Exceptional Accessibility Experience」を取り上げセッションの内容について紹介してくださいました。「6人に1人に発達障害の人がいる」、「Apple では、学習と読み書き、身体機能、視覚、聴覚の4つの領域に分けてアクセシビリティーを考えている」、「VoiceOverのテストは実際に目をつぶって試してみるとよい」などといった、なぜアクセシビリティーに取り組むのかについては、VoiceOver対応の tips などを紹介してくださいました。また、ARKit2 の Face Tracking を用いた視線入力についてのお話もありました。(面白そうなので趣味でやってみようかと思ってる)

ARKit2 の Face Tracking を使用した Hawkeye Access の紹介動画

パネルディスカッション

それぞれが考えてきた質問を他2人に投げかけるという形でパネルディスカッションをしました。僕はその中で「アクセシビリティーに関心を持つ人とそうでない人の違いってなんだと思いますか?」という質問をさせていただきました。意図としては、日本にはアメリカなど世界各国の法制に比べると罰則規定もないのでアクセシビリティーの普及に遅れているところがある中で、僕はIT業界に対して意義を訴求していきたいと考えていて、興味を持ちそうな層はどういった人なのか知りてく質問をしました。

パネルディスカッション中の様子

中根さんの回答として、「まずは身近にいるとかどうかで『見えない人が使えるようになったら、あいつが使えるな』などと考えられるかが変わる。また、障害者の社会進出に対しても、身近に障害のある人がいれば、障害者にできないこともあるけれど障害を補う仕組みがちゃんとあれば、しっかりと自立して働くことができるということを分かっているはず」と中根さん。僕は納得しつつも「中根さんと知り合う前に同僚の伊原さんからVoiceOver対応の話を受けて、それをきっかけに開発してみようと僕は思ったため必ずしも身近にいるからではないかもと思うのですが、何かそういった人の特徴があるんですかね?」と追加で質問させてもらいました。すると「技術が大好きで『こんなことできるんだやってみよ!』と技術的興味で楽しめるようなエンジニアはやってくれる。ありがたいことにうちの会社にはそういった人が多い」とおっしゃっていました。(僕はまさにそんな感じだったのかもと思い出しました。誰かのためというより面白そうだからやってみたといった感じ)

まとめ

これまで VoiceOver の技術的なことで登壇する機会はありましたが、今回初めて「アクセシビリティーについてどう考えるか」といった、 VoiceOver の開発的な部分を超えた自分の考えを述べる機会となりました。僕が VoiceOver を始めたのは、技術的に面白そうとか日本でやってる人少なそうといったそんなレベル感の動機でしたが、改めて自分のアクセシビリティーに対する考えと向き合い、その意義を見つめ直すきっかけとなりました。今後もアクセシビリティーが当たり前になる世界を作っていけるよう、登壇や記事を書くことを継続し、自分の考えを発信し続けていきたいと思います。