小さいけれど初めてAIに意思決定を任せられたかもという嬉しさ

私が人工知能や機械学習というものに初めて関わったのが学生だった1999年頃です。それから趣味や仕事で多少関わりつつもずっと気になっていたのは全然自分の意思決定を任せるようにならないなということでした。

もちろんGoogle Mapでの経路探索、各種レコメンドエンジンなど意思決定を支援してくれるようなものはあるのですが、ランチの決定を任せる、お金の使い道を勝手に決めるというところまでこないなという感じです。

絵を上手にかけるStable Diffusionが登場した時も社内で「これはすごいけどまだ意思決定を任せられるようなものは身の回りに全然ないよね。なんかありますか?」と話したのを覚えています。

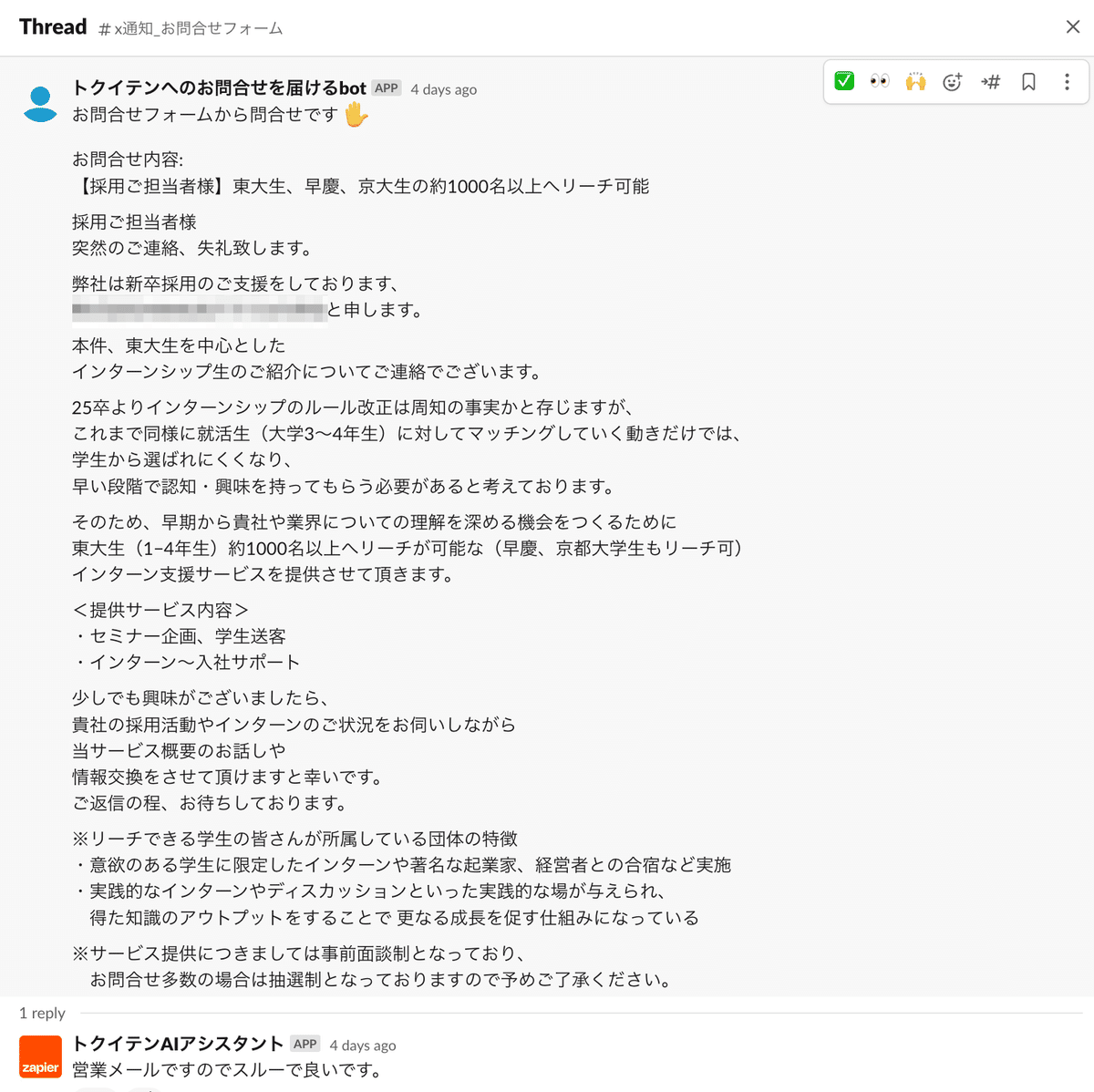

それがChatGPTが登場して「できるかも?」ということが急激に増え、早速トクイテンの会社内で使い始めた事例が出てきました。今やっているのはWebからのお問い合わせ内容の振り分けです。

これまでトクイテンではWebから問い合わせがあるとSlackで受信して、内容のチェック係が内容を読んで、各担当者に振り分けるということをしていました。

それが今は自動化され次のように分別してくれます

これらの分類をするのに使用したChat GPTへの指示は

これからお渡しするメール本文を分析して、営業メールかどうかを判断してください。 営業メールの場合は「営業メールですのでスルーで良いです」とだけ回答し、営業メールではない場合は・・・

というようなものでとても簡単なものです。これだけで文書の分類ができるようになったというのはすごいことです。

このシステムを2週間ぐらい試運用して今はAIにお任せで分類をしています。

ポイントは僕や他のメンバー含めて、このシステムを短時間で信用できると思えたことです。人間は人間のミスには寛容ですが、アルゴリズムにはとても厳しいと考えられています。書籍NOISEでも次のような一節がありました。

アルゴリズムに対する抵抗感を「アルゴリズム回避(algorithm aversion)」と呼ぶが( 20)、これは新しい意思決定支援ツールとしてのアルゴリズムを頭から受け付けないという強固な性質のものではない。だいたいにおいて、人々はアルゴリズムにチャンスを与えようとする。ただ、アルゴリズムが一度でも判断ミスをしようものなら、すぐさま信頼を失ってしまう( 21)。 この反応は理解できないこともない。信用できないアルゴリズムにかかずらわってはいられない、というわけだ。人間には誤りがつきものだと私たちは承知している。だがそれをアルゴリズムに認めてやる気はない。アルゴリズムはパーフェクトであってもらいたい。この期待が裏切られると、アルゴリズムはあっさり退場を命じられて

ダニエル カーネマン、オリヴィエ シボニー、キャス R サンスティーン、村井 章子

今回導入したお問合せの分類ですが一定の割合で間違えることもあると思いますが、でもやめようということにはならないなというぐらい信用ができています。(お問合せ対応の失敗がそれほど致命的になることはないというのはありますが)

このようにAIに意思決定を任せられたのは個人的には大きな飛躍で、とても嬉しい出来事です。

同書では単純なアルゴリズムや、機械学習モデルの方が、バイアスやノイズの影響の多い人間の判断より優れていることが多いと紹介されています。

例えば裁判の判決について大規模に調べた結果では、昼食後の方が寛大な判決を下しやすいだとか、裁判官が何人か集まっても1つの事件について意見が一致することがほとんどないとか(有罪という人もいれば無罪という人もいる)、保険会社での調査では専門家の保険の査定額の見積もりの格差は中央値で55%もあったとかそんな調子でした。

さらに衝撃的なのは結局人間の判断にはノイズとバイアスが大きすぎるために、人間の判断はAIどころか単純なルールベースの判断にも劣るということです。

本書の例では公判で被告の保釈を認めるかどうか(逃亡可能性の予測:認めたことによって逃亡や再犯のリスクがある)を人間が判断するか、単純なルールが判断するか、多くの予測変数を使うモデルを比較したという例がでてきます。

単純なルールとは被告の年齢と過去の公判不出頭の回数の2つだけを使ったものです。そんな二つの変数で正確に予測できるものかと私は思うのですが、正確かどうかはともかく人間の裁判官のほぼ全員を上回ったとのことです。

今後さまざまな意思決定や判断をAIに頼るようになっていくでしょう。人間がAIを信用し、さまざまな意思決定をAIに任せられるかもしれない時代が始まったというのは、ChatGPTが調べ物ができるとか、文書が書けるとか以外の大きなポイントだと感じています。