なぜAPS-Cクロップするとダイナミックレンジが狭くなるのか?

上記のページで様々なカメラで計測されたダイナミックレンジが見れる。

が、長いこと疑問だったのが、

「APS-Cクロップするだけでダイナミックレンジが変化するのおかしくね?」

というもの。

そもそも"ダイナミックレンジ"とは何か?

よく言われるのが以下の説明です。

ダイナミックレンジとは、デジタルカメラが画像として再現できる、最も暗い部分から最も明るい部分の幅の広さのことを言います。ダイナミックレンジは肉眼よりも狭いのが普通ですので、ダイナミックレンジが広いほど白飛びや黒つぶれを抑えた、広い階調の写真を撮ることができます。

https://kakakumag.com/camera/?id=19519

夕日を背景に人を撮るとシルエットになったり、逆に空が真っ白になったりする。

それはダイナミックレンジが足りてない故に起きることなんですね。

(その狭い幅で創意工夫をするのが写真の醍醐味でもあると思いますが。)

センサーサイズとダイナミックレンジの関係性

これもよく言われるのが以下の説明です。

センサーが大きいと、階調表現もより豊か

https://www.sony.jp/msc/owner/recommend/alens/sensor_apsc_ff/

階調表現 = ダイナミックレンジ と思ってください。

センサーは大きければ大きいほどダイナミックレンジも広くなると。

果たして本当にそうか?

これは間違っています。

ここでの本質は「センサーサイズ」ではなく、「1画素あたりの大きさ」です。

ダイナミックレンジは「1画素あたりどれだけ受光できる容量があるか」

できまります。

さらにいうと受光した後の回路がどうなっているかとかでも変わりますが、

一旦そこは無視します。

同じセンサーでダイナミックレンジが変わる?

本題です。

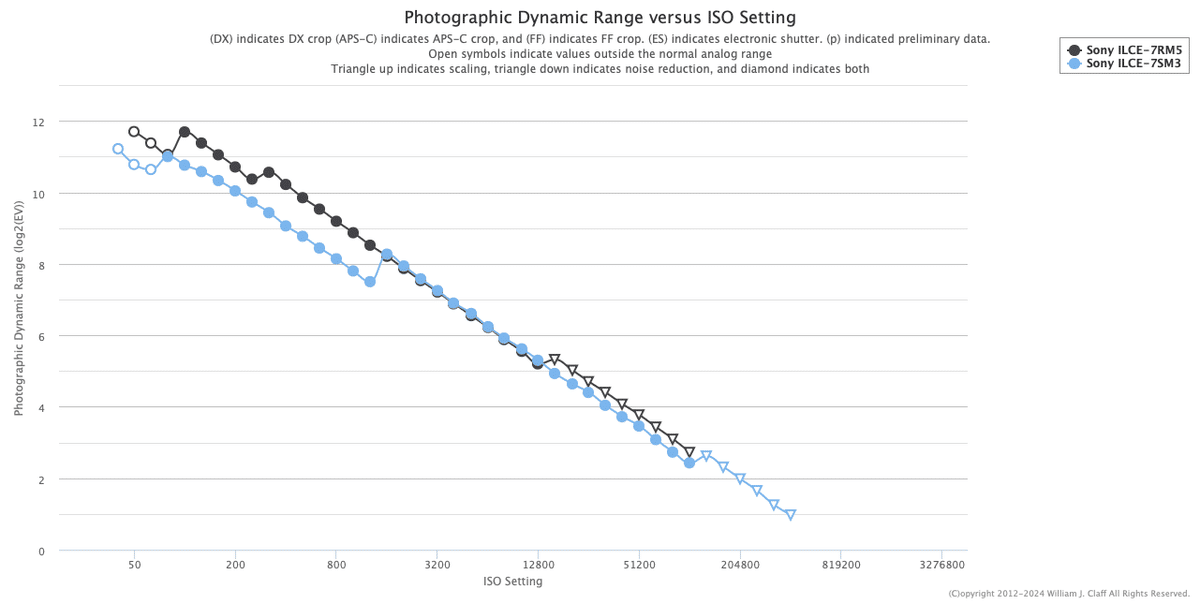

最初に紹介したα7R VのFF撮影とAPS-C撮影での比較をします。

縦軸がダイナミックレンジ、横軸はISO感度です。

https://www.photonstophotos.net/Charts/PDR.htm

明らかにAPS-Cだとダイナミックレンジが狭くなっています。

ダイナミックレンジが「1画素あたりどれだけ受光できる容量があるか」

で決まるなら、

同じセンサーで撮った写真をAPS-Cクロップするだけでダイナミックレンジが変わるのはおかしくないか?

別に1画素の大きさが変わったわけじゃないし、

搭載されてる回路が変わるわけでもない。

なのになんでダイナミックレンジが狭くなるんだ?

完璧な答えがわかったわけではありませんが、

調べてみてそれらしいものを見つけました。

ダウンサンプリング

どうやらこのテストは、

撮影した画像を一律800万画素に落として比較しているようです。

The a7 III more or less matches the base ISO dynamic range of the a7R III, when both are viewed at common size (we've normalized all our graphs to 8MP).

この画質を落とす処理は、画素を捨てるのではなく、

平均化のような処理が行われるているのかと思います。

それにより、APS-C撮影よりFF撮影のが画像サイズは大きいので、

平均化の際により多くの画素をまとめあげることでダイナミックレンジに影響していそうです。

イメージとしてはこんな感じ。(数字は大雑把なものなのであまり気にせず。)

FF撮影 = 画素が多い:

4つの画素を1つの画素として扱う -> 1つが白飛びしても他3つで補完される

APS-C撮影 = 画素が少ない:

2つの画素を1つの画素として扱う -> 1つが白飛びしても他1つで補完されるこれならFF撮影の方がダイナミックレンジが広くなる説明がつきそうです。

まとめ

FF撮影とAPS-C撮影の2枚をダウンサンプリングせずに

ピクセル等倍で見たら同じダイナミックレンジになるはずです。

だって同じセンサーだもん。

ただし実際ピクセル等倍で画像をみるなんて編集時以外にはないと思います。

だからこのテストも同じサイズに落としての比較をしているのかなと。

これは同じ疑問を持たれていた以下のスレッドへの回答を見つけて気づきました。

ただこのスレッドを見ても、

「APS-CはFFよりカメラの中に入る光が減る」という意見もありました。

センサーサイズによる写りの違いって色々な情報が飛び交ってて難しいですね。

おまけ

低画素カメラはダイナミックレンジが広いのか?

1画素あたりの大きさ[cm^2/個]は「センサー面積[cm^2] / 画素数[個]」で計算できます。

つまり同じセンサーサイズでも画素数が少ないカメラなら1画素が大きくなり、

ダイナミックレンジも広くなるということだ!

これもまた間違ってます。

最初に紹介したページで以下の2台を比べてみましょう。

- α7R V 約6250万画素

- α7S III 約1290万画素

どちらもフルフレームセンサーなので、1画素あたりの大きさは異なります。

先ほどの理屈ならα7S IIIの方がダイナミックレンジが広いはずです。

https://www.photonstophotos.net/Charts/PDR.htm

結果はISO 1600までならα7R Vのが優勢。ISO 1600以降は同じ。

となりました。予想と違いますね。

こうなる理由は先ほどのダウンサンプリングや

Dual Gain ISO (Dual Native ISOではない)等が考えられますが、

結論としては「低画素だからってダイナミックレンジが広いとは限らない」

ということです。難しすぎる。

自分が今までインターネット上で調べてわかった知識なので

間違っている箇所もあると思います。

もし詳しい方いたら情報ください。