Gemini-Exp-1114@2024-11-14リリースをGoogle AI Studioで実験してみた。

2024年11月14日にGPT-4o/o1超えと言われているGemini-Exp-1114というのがリリースされたので数字と文字の認識率について実験してみました。

以前やった「請求書PDFから特定項目の取り出し100本斬り[AI比較レポート] Claude vs ChatGPT vs perplexity」と同じPDFを使ってみた。この時ChatGPT と perplexityは間違いだらけだったんだよね。

Google GeminiとGoogle AI Studioの違いと各modelの違いについて

🧊Google Gemini

AIモデル: テキスト、画像、音声、動画などを理解し、処理し、生成するマルチモーダルAIモデル。

用途: Google 製品やサービスの機能強化、新たなAI機能の提供など。

ユーザーインターフェース: 直接的なユーザーインターフェースは存在しない。Google 製品やサービスを通して間接的に利用する。

🧊Google AI Studio

プラットフォーム: AIモデルを試したり、プロンプトを作成してアプリケーション開発に利用したりするための開発者向けプラットフォーム。

機能:

Gemini モデルを含む様々なAIモデルへのアクセス

プロンプト作成、調整、テストツール

API を利用したアプリケーション開発

用途: 独自のAIアプリケーション開発、プロトタイプ作成、研究開発など。

ユーザーインターフェース: ウェブベースのインターフェースを提供。

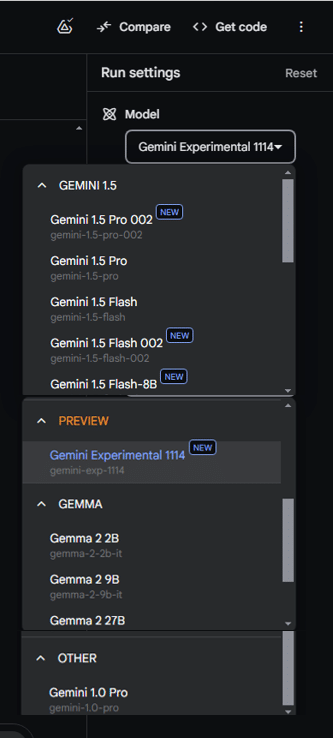

🧊各modelの違いについてGeminiに聞いてみた回答

それぞれのモデルの違いについて説明します。まず、大きく分けてGeminiモデルとGemmaモデルの2つのグループがあります。

Geminiモデルは、Googleが開発したマルチモーダル大規模言語モデルで、テキストだけでなく画像、音声、動画などの情報も処理できるのが特徴です。

Gemmaモデルは、Geminiモデルを基に軽量化されたモデルで、主にテキスト処理に特化しています。

Geminiモデル

Gemini 1.0 Pro

Geminiモデルの初期バージョンです。

テキスト生成、翻訳、要約など、幅広いタスクに対応できます。

マルチモーダル機能も備えています。

Gemini 1.5 Pro

Gemini 1.0 Proの改良版です。

処理能力とパフォーマンスが向上しています。

長いコンテキストウィンドウ(最大100万トークン)を処理できるのが最大の特徴です。

これにより、非常に長い文章や複数のドキュメントを一度に処理し、複雑なタスクを実行できます。

Gemini 1.5 Pro 002

Gemini 1.5 Proのアップデート版です。

細かいバグ修正や性能改善が行われています。

基本的な機能はGemini 1.5 Proと同じですが、より安定した動作が期待できます。

Gemini 1.5 Flash

Gemini 1.5 Proよりも軽量で高速なモデルです。

レイテンシーが低く、リアルタイムな応答が求められるアプリケーションに適しています。

コスト効率も高いため、大量の処理が必要な場合に有効です。

コンテキストウィンドウはGemini 1.5 Proより短くなります。

Gemini 1.5 Flash 002

Gemini 1.5 Flashのアップデート版です。

Gemini 1.5 Pro 002と同様に、バグ修正や性能改善が行われています。

Gemini 1.5 Flashの高速性とコスト効率を維持しつつ、安定性が向上しています。

Gemini 1.5 Flash 8B

Gemini 1.5 Flashシリーズの一つで、パラメータ数が80億のモデルです。

8Bはパラメータ数を指し、他のFlashモデルと比べてサイズが小さいことを示します。

軽量でありながら、高いパフォーマンスを発揮します。

特定のタスクに最適化されている場合があります。

Gemini Experimental 1114

実験的なGeminiモデルです。

新しい機能やアルゴリズムがテストされています。

将来の正式リリースに向けて開発中のモデルと考えられます。

性能や安定性は保証されていません。

Gemmaモデル

Gemma 2B

Gemmaモデルの中で最も軽量なモデルです。

パラメータ数が20億と少なく、動作が非常に高速です。

モバイルデバイスや組み込みシステムなど、リソースが限られた環境での使用に適しています。

テキスト生成や分類などの基本的なタスクに使用できます。

Gemma 2.9B

Gemma 2Bよりもパラメータ数が多いモデルです。

性能と精度の向上が期待できます。

より複雑なタスクにも対応可能です。

リソースと性能のバランスが取れたモデルと言えます。

Gemma 2.27B

Gemmaモデルの中で最も大きなモデルです。

高い精度と性能を誇ります。

より高度な自然言語処理タスクに対応できます。

リソースが豊富な環境での使用に適しています。

まとめ

これらのモデルは、それぞれ異なる特徴と用途を持っています。タスクの要件や利用可能なリソースに応じて、最適なモデルを選択することが重要です。

長いコンテキストを処理したい場合は、Gemini 1.5 Pro が適しています。

リアルタイム性とコスト効率を重視する場合は、Gemini 1.5 Flash が良いでしょう。

モバイルデバイスなどで軽量モデルを使いたい場合は、Gemma 2B が適しています。

高い精度と性能を求める場合は、Gemini 1.5 Pro や Gemma 2.27B が選択肢となります。

また、実験的なモデルである Gemini Experimental 1114 は、最新技術を試す際に役立ちますが、安定性や性能は保証されないことに留意してください。

このように、各モデルの特徴を理解し、目的に合ったモデルを選択することで、効率的にタスクを進めることができます。

実験内容

請求書10件分のPDFを1ファイルにバインドして結合。請求書ある各項目を読み取り表形式で出力。下記エクセル内にある3つのmodelにて出力テストを行った。プロンプトや請求書の内容については前回記事参照