LLMの限界が露呈!Apple研究が明かすAI推論の脆さ

最近発表されたAppleのAI研究によると、現在の大規模言語モデル(LLM)には、形式的な論理推論の証拠がないことが示されています。代わりに、その行動は「高度なパターンマッチング」として説明されます。しかしそのパターンは非常に脆く、名前を少し変えるだけで結果が10%も変わる場合があると報告されています。これはつまり、モデルが「推論」しているのではなく、ただ文字列のパターンを見つけているに過ぎないのではないか、という疑問を投げかけるものです。

Appleの研究論文:https://arxiv.org/pdf/2410.05229

本記事では、Appleの研究者Mehrdad Farajtabar氏のツイートから得た洞察をもとに、LLMの推論能力についての最新の発見を紹介します。

1/ Can Large Language Models (LLMs) truly reason? Or are they just sophisticated pattern matchers? In our latest preprint, we explore this key question through a large-scale study of both open-source like Llama, Phi, Gemma, and Mistral and leading closed models, including the… pic.twitter.com/yli5q3fKIT

— Mehrdad Farajtabar (@MFarajtabar) October 10, 2024

驚くべき進歩、しかしそれは本物の推論か?

GPT-3がリリースされた当初、数学的推論を試すGSM8Kテストでのスコアはわずか35%でした。しかし、わずか3年でパラメータが3B(30億)程度の小さなモデルでも85%を超え、大型モデルでは95%以上に到達しています。しかし、その性能の向上が本当の「推論」の進化なのかは不明です。

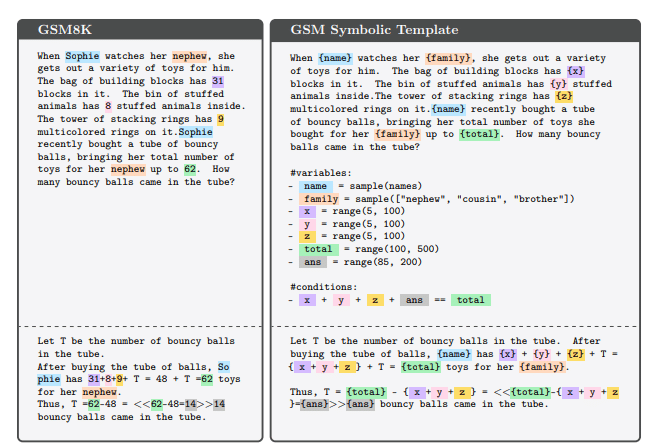

Appleの研究チームは、GSM8Kから派生した「GSM-Symbolic」を使って、LLMの限界を調査しました。GSM-Symbolicではシンボリックなテンプレートを作成し、多数の実験用インスタンスを生成することが可能です。これにより、モデルの数学的推論の能力をより正確に評価できます。

成績の変動とLLMの脆弱性

Appleの研究によると、GSM8Kにおける現在のスコアは信頼性が低いとのことです。同じモデルであっても、例えばLlama 8Bでは70%から80%、Phi-3では75%から90%というように、大きな性能のばらつきが見られました。また、多くのモデルにおいて、GSM-Symbolicでの平均的な性能はGSM8Kよりも低いことが確認されました。

特に注目すべきなのは、LLMが人名や物の名前などの固有名詞の変更に非常に敏感であることです。名前を変えるだけでスコアが約10%変動することもあるという結果は、モデルが実際に論理的に問題を理解しているわけではない可能性を示唆しています。

難易度の変化に対する性能

また、GSM-Symbolicのバリエーションを利用してモデルの挙動をさらに調査しました。質問の難易度を調整することで、モデルの性能がどのように変わるかを確認する実験です。具体的には、一つの節を削除したGSM-M1、一つの節を追加したGSM-P1、さらにもう一つ追加したGSM-P2といったバリエーションを試しました。

結果として、質問の難易度が上がるにつれて性能が低下し、ばらつきが増加することが確認されました。これは、難しい問題に対してモデルの信頼性がさらに低くなることを示しています。

「No-Op」実験と大きな性能低下

研究チームは、GSM_NoOpという新しい実験も行いました。この実験では、一見すると関連しているが実際には推論には寄与しない節を追加し、モデルがそれにどのように反応するかを観察しました。その結果、すべてのモデルで大幅な性能低下が見られ、特にo1モデルでも同様の傾向が確認されました。

これは、モデルが数学的概念を本当に理解しているのかという疑問をさらに深める結果となりました。

質問の難易度と「今」と「昨年」の理解の欠如

研究チームはさらに、質問の難易度を調整した実験を通じて、LLMが基本的な概念の理解に欠けることを明らかにしました。例えば、「昨年」と「今」という表現の違いを理解することに難があるという点です。モデルは訓練データ内のパターンに従う傾向が強く、インフレーションに関するトレーニングデータのパターンに基づいて誤った解答を示すこともあります。

スケールアップだけでは解決できない?

データやモデル、計算資源を増やすことで根本的な問題を解決できるのかという疑問も提示されています。OpenAIの最新モデルであるo1シリーズは性能の向上が見られるものの、依然として微小な性能変動が見られました。研究チームは、これらの変動の原因がモデルの訓練データに起因するパターンにある可能性を指摘しています。

実世界での適用に向けて

LLMの真の推論能力を理解することは、AIの安全性、整合性、教育、医療、意思決定システムといった精度と一貫性が求められる分野での応用において極めて重要です。Appleの研究は、現在のLLMの限界を浮き彫りにし、信頼できるエージェントの構築にはまだ多くの課題があることを示しています。

結論

ビジネスリーダー、特にCTOやCIOにとって、この研究結果は大きな示唆をもたらします。現在の大規模言語モデルは非常に進歩した技術である一方で、その「推論能力」には大きな限界があることが示されています。これにより、LLMを活用している企業は、その適用領域や期待する役割について現実的な視点を持つ必要があります。

具体的には、LLMは依然として精度と一貫性が不可欠なシステム、特にビジネスクリティカルな領域での意思決定や安全性が問われる分野での適用には注意が必要です。AIを用いた自動化やサポートシステムの導入を検討している場合、LLMの限界を理解した上で、適切なガバナンスや検証プロセスを構築することが求められます。また、パターンマッチングに強みを持つLLMの特性をうまく利用し、データの前処理や予測、特定の繰り返しタスクへの応用など、モデルの強みを最大限に引き出す方向での戦略が有効です。

さらに、将来的な技術開発の方向性についても重要な教訓が得られます。LLMの性能向上にはスケールアップだけでは限界があることが明らかであり、新しいアプローチやアルゴリズムの開発が不可欠です。ビジネスリーダーとしては、AI技術の進展を注視しながら、新たな技術や手法を積極的に取り入れる柔軟性が求められます。

結論として、Appleの研究チームは、Llama、Phi、Gemma、Mistralといったオープンソースモデルから、OpenAIのGPT-4oやo1シリーズといったクローズドなリーダーモデルまで、形式的な推論の証拠は見られず、その行動は高度なパターンマッチングで説明されるとしています。これが意味するのは、LLMの真の理解や推論を実現するには、現在のアプローチとは異なる新たな方向性が必要であるということです。そして、ビジネスでAIを効果的に活用するためには、これらの限界を理解し、適切に対処することが求められます。