特定用途に特化したLLMの設計と応用例

ChatGPTが示す広範な言語処理能力により、多岐にわたるタスクでその可能性が広く認識されていますが、特定の産業ニーズに応えるためには、より専門化されたアプローチが求められます。このニーズに応えるKili Technologyは、AIプロジェクト用の高品質なトレーニングデータセットを構築するためのデータラベリングプラットフォームを提供しています。彼らのプラットフォームは、非構造化データを精緻化されたデータセットに変換し、AIのトレーニングを効果的にサポートすることで、ドメイン特化型の大規模言語モデル(LLM)の開発を加速します。今日の記事では、特定業界向けにカスタマイズされたLLMの具体的な事例とその構築方法に焦点を当て、どのようにKili Technologyがこれを可能にしているかを掘り下げます。

参考:

https://kili-technology.com/

ドメイン特化型LLMとは何か?

ドメイン特化型LLMは、組織のガイドラインに従って定義されたタスクを実行するために訓練またはファインチューニングされた一般モデルです。一般的な目的の言語モデルと異なり、ドメイン特化型LLMは現実世界のアプリケーションで明確に定義された目的を果たします。これには、製品データ、企業ポリシー、業界用語に対する深い理解が必要です。

ドメイン特化型LLMを構築する理由

ドメイン特化型LLMは、そのスケーラビリティと会話的振る舞いで評価されています。これにより、一般的な言語モデルと対話することで、人間のようなレスポンスを得ることができます。しかし、基礎モデルは完璧ではなく、特定の文脈を理解できないため、法的文書や科学論文など特定の専門知識が必要な場面での使用には向いていません。

ドメイン特化型LLMの事例

特定の産業ニーズに特化したドメイン特化型大規模言語モデル(LLM)のリストです:

Alli Finance LLM by Allganize

日本および韓国の金融業界向けに開発されたモデルで、金融サービスの効率を向上させます。

IBM's AI Foundation Models for Climate Change

IBMが提供する、気候変動対策を支援するAI基盤モデル。

IBM and NASA's AI Foundation Model for Weather and Climate

気象と気候に関するデータを処理するために、IBMとNASAが共同で開発したモデル。

Biomedical Foundation Models by IBM Research

生物医学的応用のためにIBMが開発した基礎モデル。

Med-PaLM by Google Research

医療問題に対する高精度な回答を提供するためにGoogleが開発した医療大規模言語モデル。

KAI-GPT by Kasisto

銀行業務に特化し、会話型AIを提供するために開発された業界初のモデル。

ChatLAW

中国の法律領域で訓練されたオープンソースの法律言語モデル。

FinGPT by AI4Finance-Foundation

財務感情分析で顕著なパフォーマンスを示す、金融データで事前トレーニングされたモデル。

ClimateBert

気候関連テキスト専用に事前トレーニングされた言語モデル。

BloombergGPT

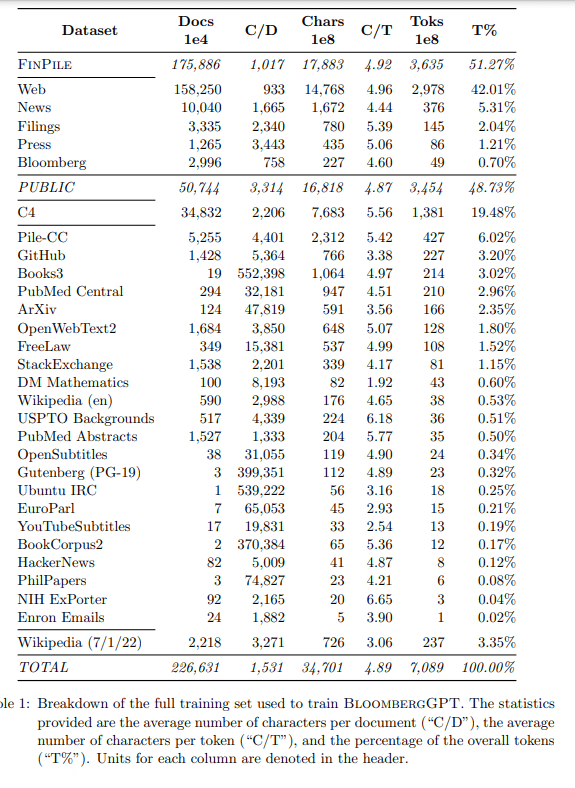

Bloombergが金融業界のさまざまなNLPタスクに対応するために、ゼロから構築した50億パラメータの大規模言語モデル。

構築方法: ドメイン特化型LLM

ゼロからのモデル構築

方法: 業界特有の知識を持つ未ラベルデータを用いて自己教師ありで学習。モデルは、次のトークン予測やマスクされたトークンの復元を通じて訓練されます。

例: BloombergGPTは数十年分の金融データを使用しており、約270万ドルのコストと53日間のトレーニング期間、AWS上のNVIDIA GPUを使用しています。

重要性: この方法はコスト、時間、計算リソースが大規模に必要であり、高品質なデータのキュレーションが成功の鍵です。

ドメイン特化型ニーズに合わせたファインチューニング

方法: 事前訓練済みの汎用モデル(例: GPTやLLaMa)を特定のドメインのアノテートされたデータセットで微調整することにより、精度を高めながら特定のタスクを実行可能にします。

利点: 完全な新規訓練と比べて、より少ないリソースで効果的に特定の問題に対応することが可能です。

トランスファーラーニング

概要: 既存の事前訓練済みモデルの知識を新しいタスクやドメインに適用する技術。データリソースが限られている場合に特に有効。

例: GoogleのMedPaLMは医療分野に特化したトランスファーラーニングを使用して訓練されています。

情報検索強化生成(RAG)

方法: 事前訓練済みモデルと情報検索システムを統合して、リアルタイム情報や業界特有のコンテキストに応じたパフォーマンスを向上させます。

適用例: 金融機関が市場のリアルタイムトレンドを追跡し報告するためのドメイン特化型モデルに使用されます。

ベストプラクティス

小さく始める

推奨: 最初は特定の用途に限定し、例えば顧客サービスを向上させる製品認識チャットボットから始めること。初期成功を確認した後、より大規模な用途に拡張を図る。

スケーリングの法則を理解する

研究: OpenAIが2020年に行った研究により、計算能力、データセットのサイズ、モデルのパラメータ数とパフォーマンスの関連性が明らかにされています。大きなモデルが同様のデータセットでより優れたパフォーマンスを発揮することが多いことが確認されています。

データ品質を優先する

必要性: トレーニングデータは現実世界の多様性を公正に反映する必要があり、これが欠けるとバイアスの問題や一般化の失敗につながります。

データセキュリティとプライバシーを強化する

対策: データ侵害のリスクを低減するために、データの暗号化やその他のセキュリティ対策を講じることが重要です。

モデルのパフォーマンスを監視および評価する

必要性: モデルがデプロイされた後は、そのパフォーマンスを継続的に監視し、必要に応じて追加のデータやトレーニング、ハイパーパラメータの調整を行うことで、モデルの関連性と有効性を保持します。

最後に

ドメイン特化型LLMは、知識特化型タスクに適しており、一般的な言語モデルの限界を克服しています。これらのモデルは、金融、医療、環境などの業界において、業務効率の向上、顧客体験の向上、新たな財務機会の創出に貢献しています。今後も、これらのモデルは業界特化型アプローチの重要性を高め、さまざまなセクターにおいて革新的な変化をもたらすことでしょう。

関連記事