新たなマルチモーダル大言語モデル「Ferret-UI」が開くモバイルUI理解の新境地

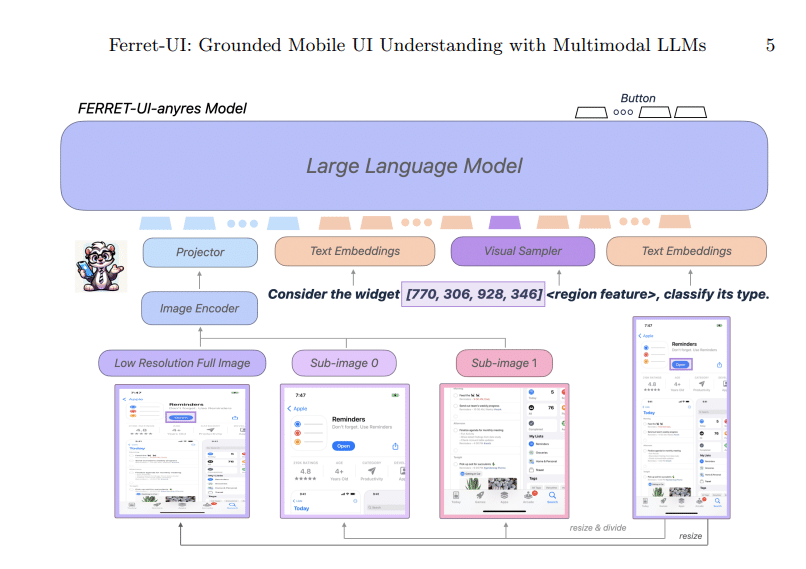

Appleが新たに開発したFerret-UIは、モバイルアプリケーションのユーザーインターフェース(UI)を理解するために特化したマルチモーダル大言語モデル(MLLM)です。このモデルは、UIの視覚的要素を詳細に理解し、自然言語の指示に基づいて操作を行う能力を持っています。特に、UIが持つ特有の課題に対処するために「任意の解像度」技術を取り入れ、細部まで鮮明に捉えることが可能です。

モバイルアプリケーションUIの進化への貢献

スマートフォンの普及に伴い、日常生活におけるモバイルアプリケーションの役割はますます重要になっています。アプリ内での情報検索、予約、エンターテインメントの探求など、個人の目標達成をサポートするツールとしての機能を担っています。この背景のもと、Appleが開発した新しいマルチモーダル大言語モデル(MLLM)、Ferret-UIは、モバイルUIの理解を深め、これらのプロセスを自動化することでユーザーの操作を容易にする可能性を秘めています。

論文:

主な特徴と革新性

マルチモーダル理解の強化:

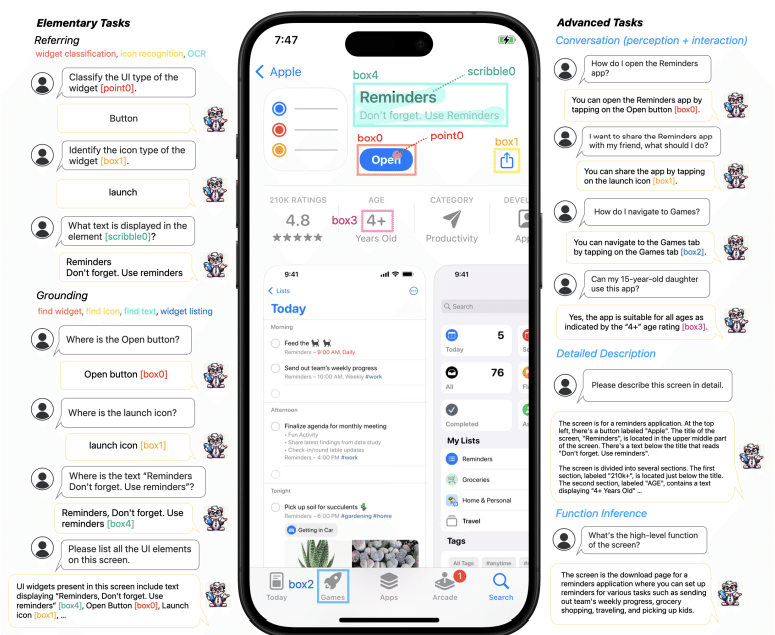

視覚と言語の統合: Ferret-UIは、画像認識と自然言語処理を組み合わせることで、UIの全体的な理解と特定の要素に焦点を当てる能力を実現しています。

高度な指示応答性: 自然言語での指示に基づいてUI内で具体的なアクションを実行できる能力を持ち、より複雑なUI操作を自動化します。

「任意の解像度」技術の導入:

詳細の拡大: UI画面を横または縦に分割し、各サブイメージを高解像度で独立してエンコードすることで、アイコンやテキストなどの小さな要素も正確に識別できます。

適応性の向上: さまざまなスクリーンサイズや形状に柔軟に対応し、UIの各種要素を正確に捉えることができます。

広範囲なトレーニングと評価:

多様なタスクの実装: 基本的なアイコン認識から詳細な対話まで、幅広いUIタスクに対応する訓練データを使用しています。

包括的なベンチマーク: 全てのタスクを網羅するテストベンチマークを開発し、他のモデルと比較して優れたパフォーマンスを示しています。

応用範囲と将来性

Ferret-UIは、アクセシビリティの向上、マルチステップUIナビゲーション、アプリテスト、ユーザビリティスタディなど、さまざまな分野での応用が期待されます。特に、音声アシスタントとの統合により、Siriを介してアプリケーションのUIを自動操作する機能がiOSに導入される可能性があります。これにより、ユーザーはより少ない労力で情報へアクセスしたり、特定のアクションを実行したりすることが可能になるでしょう。

最後に

Ferret-UIの導入により、モバイルUIの自動理解と操作が大きく進化することが期待されます。今後のアップデートで、さらに多くのアプリケーションでの実装が進むことで、ユーザー体験はより直感的でスムーズなものになるでしょう。また、この技術がSiriなどの音声アシスタントと統合されることで、全く新しいインタラクションの形が生まれる可能性もあります。

Ferret-UIは、UI理解の分野において、具体的な進歩を示す重要なステップです。この研究がもたらす影響は、技術だけでなく、ユーザーインターフェースデザインの基本的な考え方にも影響を与えることでしょう。